Análisis Técnico de la Infraestructura Digital Fiable en el Contexto Actual de Tecnologías de la Información

En el panorama actual de las tecnologías de la información (TI), la infraestructura digital fiable se posiciona como un pilar fundamental para el funcionamiento eficiente y seguro de las organizaciones. Esta infraestructura abarca desde los centros de datos hasta las redes de comunicación y los sistemas de almacenamiento en la nube, todos interconectados en un ecosistema que debe resistir amenazas cibernéticas, fallos operativos y demandas crecientes de escalabilidad. El presente artículo examina los componentes técnicos clave, las mejores prácticas para su implementación y las implicaciones operativas en entornos profesionales, basándose en principios establecidos por estándares internacionales como ISO/IEC 27001 para la gestión de la seguridad de la información y NIST SP 800-53 para controles de seguridad en sistemas federales.

Componentes Esenciales de una Infraestructura Digital Fiable

Una infraestructura digital fiable se define por su capacidad para mantener la disponibilidad, integridad y confidencialidad de los datos y servicios en todo momento. En primer lugar, los centros de datos representan el núcleo de esta infraestructura. Estos instalaciones deben cumplir con estándares de redundancia como el Tier III o Tier IV del Uptime Institute, que garantizan una disponibilidad del 99,982% o superior, minimizando tiempos de inactividad mediante sistemas de alimentación ininterrumpida (UPS), generadores de respaldo y refrigeración redundante. Técnicamente, esto implica el uso de arquitecturas de conmutación por error (failover) que detectan fallos en milisegundos y redirigen el tráfico a servidores secundarios sin interrupción perceptible.

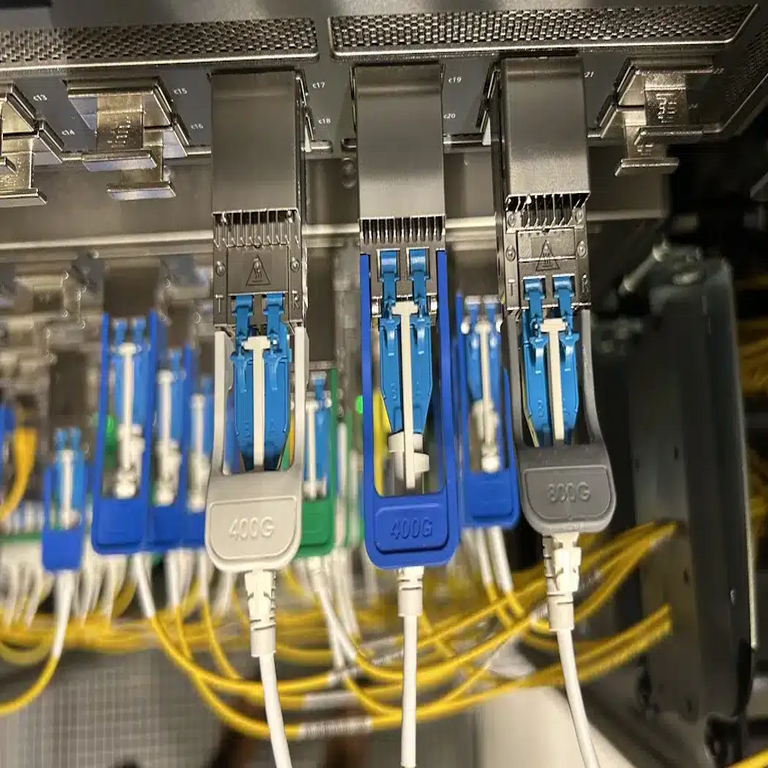

En el ámbito de las redes, la fiabilidad se logra mediante protocolos como BGP (Border Gateway Protocol) para el enrutamiento interdominio y MPLS (Multiprotocol Label Switching) para el tráfico segmentado. Estas tecnologías permiten una gestión dinámica del flujo de datos, evitando congestiones y ataques de denegación de servicio distribuida (DDoS) mediante filtros de tráfico en tiempo real. Además, la implementación de SDN (Software-Defined Networking) introduce una capa de abstracción que separa el plano de control del plano de datos, facilitando la orquestación automatizada y la respuesta rápida a incidentes. Según informes del Gartner, las organizaciones que adoptan SDN reportan una reducción del 40% en los tiempos de resolución de problemas de red.

El almacenamiento de datos es otro componente crítico. Soluciones como el almacenamiento definido por software (SDS) y las arquitecturas de datos distribuidos, basadas en sistemas como Hadoop o Ceph, aseguran la redundancia geográfica y la tolerancia a fallos. Estos sistemas emplean algoritmos de codificación de erasure para distribuir datos en fragmentos, permitiendo la recuperación incluso con la pérdida de múltiples nodos. En términos de rendimiento, métricas como IOPS (operaciones de entrada/salida por segundo) y latencia submilimétrica son esenciales para evaluar la fiabilidad en entornos de alto volumen, como los de inteligencia artificial donde se procesan terabytes de datos en tiempo real.

Tecnologías Emergentes y su Rol en la Fiabilidad

La integración de inteligencia artificial (IA) en la infraestructura digital eleva significativamente su fiabilidad. Algoritmos de machine learning, como los modelos de detección de anomalías basados en redes neuronales recurrentes (RNN), analizan patrones de tráfico para predecir y mitigar amenazas antes de que se materialicen. Por ejemplo, plataformas como IBM Watson o Azure AI incorporan estas capacidades para monitoreo predictivo, reduciendo el tiempo medio de detección (MTTD) de incidentes de horas a minutos. En el contexto de blockchain, esta tecnología asegura la integridad de transacciones distribuidas mediante consenso proof-of-stake (PoS), que es más eficiente energéticamente que el proof-of-work (PoW) tradicional, y se aplica en infraestructuras híbridas para auditar accesos a datos sensibles.

La computación en la nube, particularmente los modelos híbridos y multi-nube, representa un avance clave. Proveedores como AWS, Google Cloud y Microsoft Azure ofrecen servicios de alta disponibilidad con SLAs (Service Level Agreements) que garantizan al menos un 99,99% de uptime. Técnicamente, esto se soporta en arquitecturas serverless, donde funciones como AWS Lambda escalan automáticamente sin gestión de servidores subyacentes, optimizando recursos y reduciendo vulnerabilidades asociadas a configuraciones manuales. Sin embargo, la fiabilidad en la nube exige la implementación de estrategias de zero-trust, donde cada acceso se verifica independientemente, utilizando protocolos como OAuth 2.0 y JWT (JSON Web Tokens) para autenticación.

En el ámbito de la ciberseguridad, herramientas como firewalls de nueva generación (NGFW) y sistemas de detección de intrusiones (IDS/IPS) son indispensables. Estos dispositivos emplean firmas de detección basadas en heurísticas y análisis de comportamiento para contrarrestar amenazas avanzadas persistentes (APT). Estándares como CIS Controls proporcionan marcos para su despliegue, enfatizando la segmentación de redes mediante microsegmentación, que limita la propagación lateral de malware en entornos virtualizados con hipervisores como VMware ESXi o KVM.

Implicaciones Operativas y Regulatorias

Desde una perspectiva operativa, una infraestructura digital fiable impacta directamente en la continuidad del negocio. La adopción de marcos como COBIT 2019 permite alinear las TI con objetivos empresariales, midiendo métricas como el RTO (Recovery Time Objective) y RPO (Recovery Point Objective) para planes de recuperación ante desastres (DRP). En escenarios de alta criticidad, como en el sector financiero, regulaciones como GDPR en Europa o PCI-DSS para pagos exigen auditorías regulares y cifrado end-to-end con algoritmos AES-256, asegurando la protección de datos en reposo y en tránsito.

Las implicaciones regulatorias se extienden a la soberanía de datos, donde normativas como la Ley de Protección de Datos Personales en Latinoamérica obligan a las organizaciones a mantener infraestructuras locales para evitar fugas transfronterizas. Esto conlleva desafíos técnicos, como la implementación de VPNs con cifrado IPsec y la federación de identidades mediante SAML 2.0, para cumplir con requisitos de residencia de datos sin comprometer la escalabilidad global.

En términos de riesgos, las vulnerabilidades en la cadena de suministro representan una amenaza creciente. Ataques como SolarWinds demuestran cómo componentes de terceros pueden comprometer infraestructuras enteras, destacando la necesidad de SBOM (Software Bill of Materials) para rastrear dependencias y aplicar parches oportunos. La mitigación involucra herramientas de escaneo de vulnerabilidades como Nessus o OpenVAS, que identifican debilidades en configuraciones de software y hardware, alineándose con el principio de defensa en profundidad.

Riesgos Asociados y Estrategias de Mitigación

Los riesgos principales en infraestructuras digitales incluyen fallos de hardware, errores humanos y ciberataques sofisticados. Para los fallos de hardware, la redundancia N+1 asegura que un componente de respaldo esté siempre disponible, mientras que el monitoreo proactivo con herramientas como Nagios o Zabbix detecta degradaciones tempranas mediante umbrales de rendimiento. En cuanto a errores humanos, la capacitación en mejores prácticas de DevSecOps integra seguridad en el ciclo de vida del desarrollo, utilizando CI/CD pipelines con escaneos automáticos en herramientas como Jenkins y SonarQube.

Los ciberataques, particularmente ransomware, exigen respuestas basadas en EDR (Endpoint Detection and Response) solutions como CrowdStrike o Microsoft Defender, que emplean IA para correlacionar eventos en endpoints y servidores. Una estrategia integral incluye simulacros de incidentes regulares, alineados con el marco NIST Cybersecurity Framework, que divide la gestión en cinco funciones: identificar, proteger, detectar, responder y recuperar. Estadísticas de Verizon’s DBIR 2023 indican que el 82% de las brechas involucran el factor humano, subrayando la importancia de la conciencia de seguridad mediante phishing simulations y políticas de acceso privilegiado (PAM).

Otros riesgos emergentes involucran la dependencia de IoT (Internet of Things), donde dispositivos con protocolos obsoletos como MQTT sin TLS representan vectores de entrada. La mitigación pasa por edge computing, procesando datos localmente para reducir latencia y exposición, y empleando contenedores seguros con Docker y Kubernetes para orquestar despliegues aislados.

Beneficios y Casos de Estudio Técnicos

Los beneficios de una infraestructura digital fiable son multifacéticos. En primer lugar, mejora la eficiencia operativa al automatizar procesos con orquestadores como Ansible o Terraform, reduciendo costos de mantenimiento en hasta un 30% según estudios de McKinsey. En el ámbito de la IA, infraestructuras fiables habilitan el entrenamiento de modelos a escala con GPUs distribuidas en clústeres HPC (High-Performance Computing), acelerando innovaciones en campos como el procesamiento de lenguaje natural (NLP) con transformers como BERT.

Un caso de estudio relevante es el de la migración de una entidad bancaria latinoamericana a una arquitectura multi-nube, donde se implementó Kubernetes para la orquestación de microservicios, resultando en una mejora del 50% en la escalabilidad y una reducción del 25% en tiempos de inactividad. Técnicamente, esto involucró la integración de service mesh como Istio para el manejo de tráfico entre servicios, asegurando resiliencia mediante circuit breakers y retries automáticos.

En el sector salud, infraestructuras fiables soportan telemedicina con estándares HL7 FHIR para interoperabilidad, cifrando comunicaciones con TLS 1.3 y almacenando datos en bases NoSQL como MongoDB con replicación sharding para alta disponibilidad. Estos ejemplos ilustran cómo la fiabilidad no solo mitiga riesgos, sino que también impulsa la innovación, permitiendo la adopción de 5G para redes de baja latencia en aplicaciones críticas.

Mejores Prácticas para la Implementación

Para implementar una infraestructura digital fiable, se recomienda comenzar con una evaluación de madurez utilizando marcos como CMMI (Capability Maturity Model Integration). Esto implica mapear activos actuales contra amenazas potenciales, priorizando inversiones en áreas de alto impacto. La automatización es clave: scripts en Python con bibliotecas como Paramiko para gestión remota de dispositivos, o APIs de REST para integración con sistemas de monitoreo centralizados.

La gobernanza de datos, alineada con DAMA-DMBOK, asegura la calidad y accesibilidad, empleando catálogos de datos como Collibra para metadatos. En entornos de blockchain, la integración con Hyperledger Fabric permite transacciones inmutables, ideales para auditorías regulatorias. Finalmente, la sostenibilidad emerge como un factor, con infraestructuras verdes que optimizan consumo energético mediante virtualización y consolidación de servidores, cumpliendo con directrices ISO 14001.

En resumen, la infraestructura digital fiable no es un lujo, sino una necesidad imperativa en el ecosistema TI actual. Su diseño meticuloso, respaldado por tecnologías avanzadas y prácticas probadas, asegura no solo la protección contra riesgos, sino también la habilitación de oportunidades estratégicas para las organizaciones. Para más información, visita la Fuente original.