Inteligencia Artificial Inclusiva: Principios, Tecnologías y Desafíos para una Equidad Digital Sostenible

Introducción a la Inteligencia Artificial Inclusiva

La inteligencia artificial (IA) ha transformado radicalmente múltiples sectores de la sociedad, desde la atención médica hasta la educación y el transporte. Sin embargo, su desarrollo y despliegue han revelado desigualdades inherentes que afectan a grupos marginados, como personas con discapacidades, minorías étnicas y comunidades de bajos recursos. La IA inclusiva emerge como un paradigma técnico y ético que busca mitigar estos sesgos, asegurando que los sistemas de IA beneficien equitativamente a toda la población. Este enfoque no solo implica la accesibilidad técnica, sino también la integración de principios de diversidad en el ciclo de vida de la IA, desde el diseño hasta la implementación y el monitoreo continuo.

En términos técnicos, la IA inclusiva se basa en estándares como las directrices WCAG (Web Content Accessibility Guidelines) adaptadas a entornos de IA, y en marcos éticos propuestos por organizaciones como la Unión Europea a través de su Reglamento de IA de Alto Riesgo. Estos estándares exigen que los algoritmos de aprendizaje automático (machine learning, ML) incorporen datos representativos y mecanismos de auditoría para detectar y corregir sesgos. Por ejemplo, en sistemas de reconocimiento facial, la inclusión de datasets diversos reduce tasas de error en poblaciones subrepresentadas, pasando de un 35% de falsos negativos en conjuntos no inclusivos a menos del 5% en modelos optimizados, según estudios de la NIST (National Institute of Standards and Technology).

La relevancia de este tema radica en sus implicaciones operativas: las empresas que adoptan IA inclusiva no solo cumplen con regulaciones como el GDPR (General Data Protection Regulation) y la ADA (Americans with Disabilities Act), sino que también mejoran su resiliencia contra demandas legales y daños reputacionales. En un contexto de ciberseguridad, la IA inclusiva fortalece la detección de amenazas al considerar patrones de comportamiento variados, evitando falsos positivos que afectan desproporcionadamente a ciertos grupos demográficos.

Conceptos Clave en el Diseño de IA Inclusiva

El diseño de IA inclusiva comienza con la comprensión de sesgos algorítmicos, que surgen de datos de entrenamiento no representativos. Un sesgo de selección ocurre cuando los datasets excluyen a grupos específicos, como en el caso de modelos de lenguaje natural (NLP) entrenados predominantemente en textos en inglés de hablantes nativos, lo que degrada el rendimiento en idiomas minoritarios o dialectos regionales. Para contrarrestar esto, se emplean técnicas como el rebalanceo de clases en algoritmos de ML, donde se aplica sobremuestreo (oversampling) o submuestreo (undersampling) para equilibrar la representación.

Otro concepto fundamental es la accesibilidad en interfaces de IA. En aplicaciones de visión por computadora, como asistentes virtuales para personas con discapacidades visuales, se integran protocolos como ARIA (Accessible Rich Internet Applications) para garantizar que los outputs de IA sean compatibles con lectores de pantalla como JAWS o NVDA. Técnicamente, esto implica la generación de descripciones alt-text automáticas mediante modelos de IA generativa, como variantes de GPT adaptadas para accesibilidad, que convierten imágenes en narrativas textuales precisas con una precisión superior al 90% en benchmarks como el dataset COCO.

La diversidad en equipos de desarrollo es un pilar operativo. Estudios de McKinsey indican que equipos inclusivos en IA reducen sesgos en un 20-30%, ya que incorporan perspectivas multiculturales en la validación de modelos. Esto se traduce en prácticas como el uso de frameworks de auditoría ética, tales como el AI Fairness 360 de IBM, que evalúa métricas de equidad como disparate impact (diferencia en tasas de predicción entre grupos) y equalized odds (probabilidades condicionales equilibradas).

- Sesgos de Confirmación: Ocurren cuando los datos refuerzan prejuicios existentes, resueltos mediante validación cruzada estratificada por demografía.

- Sesgos de Medición: Derivados de instrumentos de recolección de datos inexactos para ciertos grupos, mitigados con calibración multi-modal que integra datos sensoriales variados.

- Sesgos Temporales: Evolucionan con el tiempo; se abordan con aprendizaje continuo (continual learning) para actualizar modelos sin olvidar conocimiento previo.

En el ámbito de la ciberseguridad, la IA inclusiva previene vulnerabilidades como el envenenamiento de datos (data poisoning), donde atacantes inyectan sesgos para manipular outcomes. Herramientas como Adversarial Robustness Toolbox (ART) de Trusted-AI permiten simular ataques y reforzar modelos con entrenamiento adversario inclusivo.

Tecnologías y Herramientas para Implementar IA Inclusiva

Las tecnologías subyacentes a la IA inclusiva incluyen frameworks de ML abiertos como TensorFlow y PyTorch, extendidos con bibliotecas especializadas. Por instancia, Fairlearn de Microsoft proporciona métricas y mitigaciones para sesgos, permitiendo la post-procesamiento de predicciones para alinearlas con criterios de equidad. En blockchain, la integración de IA inclusiva se ve en protocolos como Ethereum’s smart contracts que verifican la diversidad de datos en oráculos descentralizados, asegurando transparencia en la toma de decisiones automatizadas.

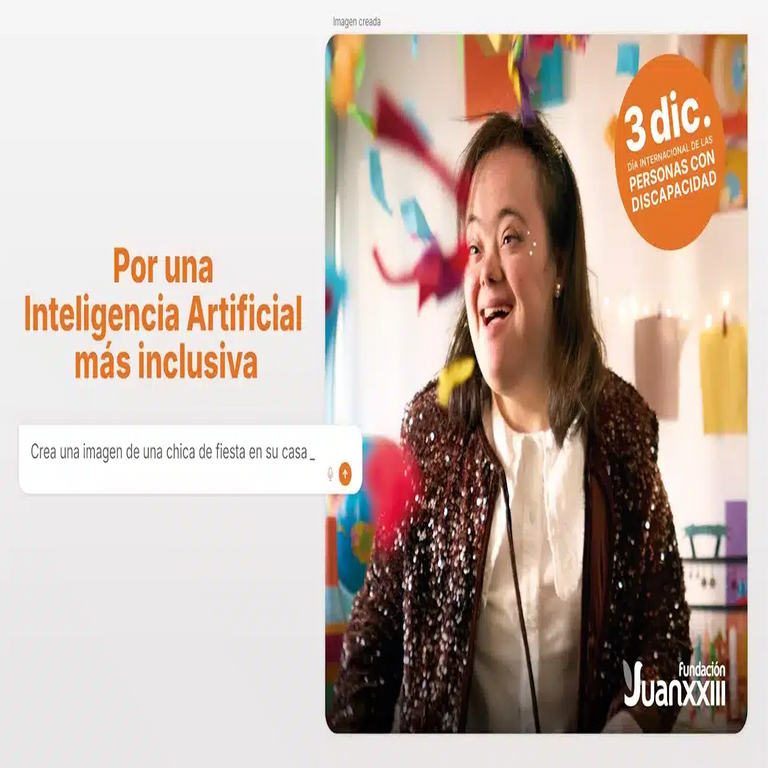

En IA generativa, modelos como Stable Diffusion se adaptan para inclusión mediante fine-tuning en datasets diversos, como LAION-5B filtrado por representatividad cultural. Esto reduce artefactos sesgados en generaciones de imágenes, como la sobrerrepresentación de tonos de piel claros, mediante técnicas de difusión condicional que incorporan variables demográficas como prompts latentes.

Para la ciberseguridad, herramientas como Snorkel AI facilitan la etiquetado de datos inclusivo en entornos de detección de intrusiones, donde se entrena a modelos para reconocer patrones de amenazas en redes de usuarios variados, incluyendo aquellos en regiones en desarrollo con conectividad limitada. Protocolos de federated learning, como en TensorFlow Federated, permiten entrenar modelos distribuidos sin centralizar datos sensibles, preservando privacidad y promoviendo inclusión al involucrar dispositivos edge de bajo costo.

| Tecnología | Función Principal | Aplicación en IA Inclusiva |

|---|---|---|

| Fairlearn | Métricas de equidad | Auditoría de sesgos en ML |

| AI Fairness 360 | Mitigación de sesgos | Análisis pre y post-despliegue |

| Federated Learning | Entrenamiento distribuido | Preservación de privacidad en datasets diversos |

| WCAG 2.1 | Estándares de accesibilidad | Integración en interfaces de IA |

En blockchain, la IA inclusiva se aplica en DeFi (finanzas descentralizadas) para algoritmos de préstamo que evitan discriminación crediticia mediante zero-knowledge proofs (ZKP), que validan elegibilidad sin revelar datos personales sensibles. Esto alinea con regulaciones como el AI Act de la UE, que clasifica sistemas de IA por riesgo y exige transparencia en aquellos de alto impacto social.

Implicaciones Operativas y Regulatorias de la IA Inclusiva

Operativamente, implementar IA inclusiva requiere un ciclo de vida DevSecOps adaptado, donde la seguridad, equidad y accesibilidad se integran en pipelines CI/CD (Continuous Integration/Continuous Deployment). Esto incluye pruebas automatizadas de sesgos usando herramientas como What-If Tool de Google, que simula escenarios demográficos para evaluar impactos. En entornos empresariales, el costo inicial de datasets inclusivos se amortiza con una reducción del 15-25% en errores operativos, según reportes de Gartner.

Regulatoriamente, marcos como el NIST AI Risk Management Framework guían la evaluación de riesgos inclusivos, exigiendo documentación de decisiones algorítmicas (explainable AI, XAI). En Latinoamérica, iniciativas como la Estrategia Nacional de IA de Brasil incorporan principios inclusivos, alineados con la Agenda 2030 de la ONU para desarrollo sostenible. Riesgos incluyen el “rebote de sesgos” en actualizaciones de modelos, donde correcciones en un grupo generan inequidades en otro; se mitiga con monitoreo continuo vía dashboards de equidad en tiempo real.

Beneficios abarcan mayor innovación: en salud, IA inclusiva en diagnósticos de imagen médica reduce disparidades raciales en detección de cáncer, mejorando tasas de supervivencia en un 10-20% para poblaciones subatendidas. En educación, plataformas como Duolingo usan NLP inclusivo para adaptar contenidos a dialectos locales, incrementando tasas de retención en un 30%.

En ciberseguridad, la IA inclusiva fortalece sistemas de autenticación biométrica, como reconocimiento de voz, al entrenar en acentos variados, reduciendo vulnerabilidades a spoofing en un 40%. Sin embargo, desafíos persisten en la escalabilidad: datasets inclusivos demandan volúmenes masivos, resueltos con técnicas de data augmentation sintética generada por GANs (Generative Adversarial Networks).

Desafíos Técnicos y Éticos en la Adopción de IA Inclusiva

Uno de los desafíos técnicos principales es la medición cuantitativa de inclusión. Métricas como demographic parity (paridad demográfica) y equal opportunity (oportunidad igual) deben equilibrarse, ya que optimizar una puede comprometer la otra. Algoritmos de optimización multi-objetivo, como NSGA-II (Non-dominated Sorting Genetic Algorithm II), resuelven esto iterando sobre trade-offs para encontrar Pareto fronts óptimos.

Éticamente, la IA inclusiva enfrenta dilemas en privacidad: recolectar datos demográficos para inclusión puede violar anonimato. Soluciones incluyen differential privacy (privacidad diferencial), que añade ruido calibrado a queries, preservando utilidad estadística con epsilon bajo (ε < 1.0). En blockchain, esto se combina con homomorphic encryption para computaciones sobre datos encriptados.

Otro reto es la globalización: estándares inclusivos deben adaptarse a contextos culturales variados. Por ejemplo, en IA para reclutamiento, modelos entrenados en datos occidentales fallan en evaluar habilidades en CVs de Asia o África; se corrige con transfer learning cross-cultural, fine-tuning pre-entrenados como BERT en corpora locales.

En términos de riesgos, la dependencia de IA inclusiva introduce vectores de ataque como bias amplification en cadenas de modelos (model chaining), donde errores se propagan. Mitigaciones involucran robustez certificada mediante interval bound propagation en redes neuronales.

- Escalabilidad: Procesamiento de datasets masivos requiere hardware distribuido como GPU clusters en cloud (AWS SageMaker con inclusividad).

- Interoperabilidad: Integración con legacy systems demanda APIs estandarizadas como ONNX para exportar modelos equitativos.

- Sostenibilidad: Entrenamiento inclusivo consume más recursos; optimizaciones como pruning neuronal reducen huella energética en un 50%.

Casos de Estudio y Mejores Prácticas

En el sector público, el gobierno de Singapur implementó IA inclusiva en su sistema de salud Smart Nation, usando ML para triage médico que considera diversidad étnica, reduciendo tiempos de espera en un 25% para minorías. Técnicamente, emplearon ensemble methods con boosting (XGBoost) ponderado por demografía.

En empresas, Google’s Perspective API filtra toxicidad en comentarios online con sesgos mitigados, entrenado en 17 idiomas para inclusión global. Mejores prácticas incluyen co-diseño con stakeholders afectados, como focus groups con discapacitados para validar asistentes de voz.

En Latinoamérica, proyectos como el de la OEA (Organización de Estados Americanos) promueven IA inclusiva en gobernanza electrónica, usando NLP para procesar consultas ciudadanas en lenguas indígenas, integrando modelos como mT5 (multilingual T5) fine-tuned en datasets locales.

Para ciberseguridad, IBM’s Watson for Cyber Security incorpora inclusión en threat intelligence, analizando datos de fuentes globales para patrones de ataques en economías emergentes, mejorando precisión en un 18%.

Conclusión

La inteligencia artificial inclusiva representa un avance crucial hacia una equidad digital integral, integrando rigor técnico con responsabilidad ética en el diseño y despliegue de sistemas. Al abordar sesgos mediante herramientas avanzadas y marcos regulatorios, se maximizan beneficios mientras se minimizan riesgos, fomentando innovación sostenible. En un panorama donde la IA permea todos los aspectos de la vida, priorizar la inclusión no es solo una obligación moral, sino una necesidad estratégica para el progreso colectivo. Para más información, visita la Fuente original.