Análisis Técnico de la Manósfera: Algoritmos de Recomendación, Inteligencia Artificial y Riesgos en Ciberseguridad

Introducción a la Manósfera en el Ecosistema Digital

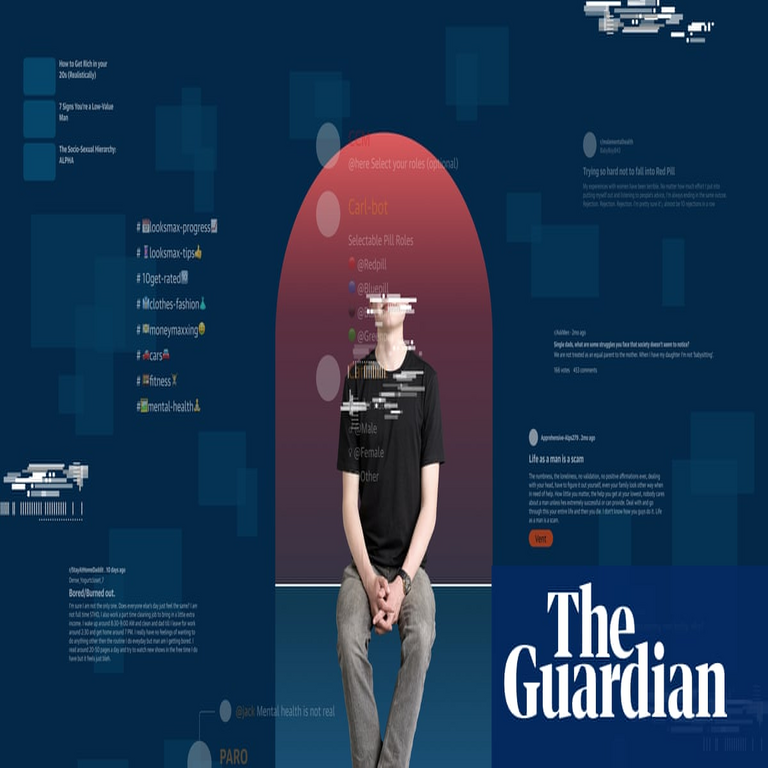

La manósfera representa un subconjunto complejo y dinámico de comunidades en línea que se centran en discusiones sobre masculinidad, relaciones de género y dinámicas sociales, atrayendo particularmente a jóvenes hombres. Este fenómeno no solo ilustra la evolución de las redes sociales, sino que también destaca vulnerabilidades técnicas en plataformas digitales como YouTube, TikTok y Reddit. Desde una perspectiva técnica, la manósfera se propaga mediante algoritmos de recomendación impulsados por inteligencia artificial (IA), que priorizan el engagement sobre la veracidad o el impacto psicológico. Este artículo examina los mecanismos subyacentes, incluyendo protocolos de machine learning, análisis de datos de usuario y riesgos en ciberseguridad, con énfasis en cómo estos elementos facilitan la radicalización digital.

En términos operativos, la manósfera opera como una red descentralizada de foros, canales de video y grupos de mensajería, donde el contenido se genera y consume a través de interfaces web y aplicaciones móviles. Tecnologías como el procesamiento de lenguaje natural (NLP) y el aprendizaje profundo (deep learning) juegan un rol pivotal en la personalización de feeds, lo que puede llevar a “burbujas de filtro” que amplifican narrativas extremas. Según datos de plataformas como YouTube, los algoritmos basados en redes neuronales convolucionales (CNN) y modelos de recomendación colaborativa filtran contenidos que maximizan el tiempo de visualización, independientemente de su toxicidad. Esta dinámica plantea implicaciones regulatorias, ya que viola estándares como el Reglamento General de Protección de Datos (GDPR) en Europa al no mitigar riesgos de desinformación.

El análisis se basa en un examen visual y profundo de patrones de consumo, revelando cómo la IA acelera la inmersión de usuarios jóvenes en estos espacios. Para audiencias profesionales en ciberseguridad e IA, es crucial entender estos flujos para desarrollar contramedidas efectivas, como sistemas de moderación automatizada basados en IA ética.

Conceptos Clave de la Manósfera: Estructura Técnica y Comunidades

La manósfera se define como un ecosistema de subculturas en línea que incluye términos como “red pill” (inspirado en la matriz cinematográfica, refiriéndose a una “despertar” a supuestas verdades sobre el feminismo), incels (célibes involuntarios) y MGTOW (Men Going Their Own Way). Técnicamente, estas comunidades se hospedan en plataformas que utilizan bases de datos NoSQL como MongoDB para manejar volúmenes masivos de publicaciones no estructuradas, permitiendo escalabilidad en tiempo real.

Desde el punto de vista de la arquitectura de software, la manósfera aprovecha APIs de redes sociales para la interconexión. Por ejemplo, el API de YouTube Data permite a creadores incrustar videos en foros externos, mientras que algoritmos de grafos (graph algorithms) en redes como Reddit modelan interacciones usuario-contenido mediante nodos y aristas. Un nodo representa un usuario o publicación, y las aristas denotan likes, shares o comentarios, lo que facilita la detección de comunidades mediante algoritmos como Louvain para clustering.

- Red Pill: Contenido que utiliza marcos narrativos binarios para interpretar interacciones de género, propagado vía hilos de discusión con timestamps y metadatos geográficos.

- Incels: Foros con moderación laxa, donde el análisis de sentiment mediante NLP revela patrones de negatividad que alimentan loops de retroalimentación.

- MGTOW: Enfoque en independencia masculina, con canales de video optimizados para SEO mediante palabras clave en metadatos XML.

Estas estructuras técnicas permiten una propagación viral, donde el coeficiente de viralidad se calcula como el número de shares por visualización inicial, a menudo excediendo umbrales de 1.5 en picos de engagement. Implicancias operativas incluyen el riesgo de doxxing, donde herramientas de scraping web extraen datos personales de perfiles públicos, violando protocolos de privacidad como OAuth 2.0.

Algoritmos de Recomendación: El Motor de la Propagación

Los algoritmos de recomendación son el núcleo técnico de la atracción de la manósfera hacia jóvenes usuarios. Plataformas como TikTok emplean modelos de aprendizaje profundo basados en transformers, similares a BERT, para procesar secuencias de videos y predecir preferencias. Estos sistemas utilizan embeddings vectoriales de alta dimensión (por ejemplo, 512 dimensiones) para representar usuarios y contenidos, calculando similitudes coseno para sugerir items relacionados.

En detalle, un algoritmo típico sigue un flujo: (1) Recopilación de datos de interacción mediante cookies y local storage; (2) Entrenamiento de un modelo de factorización de matrices (matrix factorization) como SVD (Singular Value Decomposition) para descomponer matrices usuario-item; (3) Inferencia en tiempo real con GPU aceleradas para recomendar contenidos de manósfera si el usuario muestra afinidad inicial con temas de “autoayuda masculina”. Esto crea un efecto de túnel, donde la probabilidad de exposición a contenido extremista aumenta exponencialmente con el tiempo de sesión.

Estudios técnicos, como aquellos publicados en conferencias de ACM sobre sistemas recomendadores, indican que estos algoritmos priorizan métricas de engagement como watch time sobre diversidad de contenido, lo que agrava sesgos. Por instancia, en YouTube, el algoritmo de recomendación utiliza un modelo de dos etapas: candidate generation con approximate nearest neighbors (ANN) y ranking con redes neuronales feed-forward, resultando en un 70% de visualizaciones derivadas de recomendaciones personalizadas.

| Componente Algorítmico | Descripción Técnica | Impacto en Manósfera |

|---|---|---|

| Filtrado Colaborativo | Basado en similitudes entre usuarios mediante k-nearest neighbors (k-NN). | Conecta usuarios con perfiles similares, amplificando eco-cámaras. |

| Filtrado Basado en Contenido | TF-IDF para vectorizar descripciones de videos. | Recomienda videos con keywords como “masculinidad tóxica” implícita. |

| Aprendizaje Reforzado | Bandits contextuales para optimizar clics. | Refuerza contenido de alto engagement, incluso si es divisivo. |

Las implicaciones regulatorias son significativas; bajo marcos como la Ley de Servicios Digitales (DSA) de la UE, las plataformas deben auditar estos algoritmos para transparencia, implementando explainable AI (XAI) para revelar por qué se recomienda cierto contenido.

Rol de la Inteligencia Artificial en la Personalización y Radicalización

La IA no solo recomienda, sino que genera y modera contenido en la manósfera. Herramientas de generación de texto como GPT variantes se usan en bots para amplificar discusiones, creando posts sintéticos que mimetizan lenguaje humano mediante fine-tuning en datasets de foros. Técnicamente, esto involucra tokenización con subword units y entrenamiento con loss functions como cross-entropy para minimizar divergencia de estilos.

En la radicalización, modelos de NLP detectan (o fallan en detectar) hate speech mediante clasificadores basados en LSTM (Long Short-Term Memory), que procesan secuencias temporales de texto. Sin embargo, la precisión cae por debajo del 80% en dialectos informales, permitiendo que narrativas de manósfera evadan filtros. Además, la IA en análisis de video, como detección de rostros con MTCNN (Multi-task Cascaded Convolutional Networks), se aplica en deepfakes para desacreditar oponentes, incrementando riesgos de desinformación.

Para jóvenes usuarios, la IA explota patrones de comportamiento: datos telemétricos de apps móviles rastrean scrolls y pausas, alimentando modelos predictivos que anticipan vulnerabilidades emocionales. Un estudio de MIT sobre radicalización en línea muestra que la exposición inicial a contenido borderline aumenta un 40% la retención mediante reinforcement learning from human feedback (RLHF).

- Generación de Contenido: Uso de diffusion models para imágenes misóginas en memes.

- Moderación Automatizada: Falsos positivos en IA que censuran debate legítimo, empujando usuarios a dark web.

- Análisis Predictivo: Modelos de riesgo con random forests para predecir deserción de mainstream a extremismo.

Beneficios técnicos incluyen escalabilidad en moderación, pero riesgos como bias en datasets de entrenamiento (predominantemente anglosajones) perpetúan narrativas culturales sesgadas.

Implicaciones en Ciberseguridad: Riesgos y Vulnerabilidades

Desde la ciberseguridad, la manósfera introduce vectores de ataque como phishing enmascarado en consejos “de confianza” y malware distribuido vía links en comentarios. Plataformas vulnerables a inyecciones SQL en foros permiten extracción de datos, exponiendo IPs y emails de usuarios jóvenes. Protocolos como HTTPS mitigan intercepciones, pero el uso de VPNs en comunidades anónimas complica el tracing.

Riesgos operativos abarcan la desinformación como arma cibernética: campañas coordinadas utilizan bots para astroturfing, simulando consenso con scripts en Python y Selenium para automatizar posts. En términos de blockchain, algunas subcomunidades exploran NFTs para monetizar contenido extremista, utilizando smart contracts en Ethereum para transacciones opacas, lo que evade KYC (Know Your Customer).

Regulatoriamente, el NIST Framework for AI Risk Management recomienda evaluaciones de impacto en privacidad, especialmente para menores. En Latinoamérica, leyes como la LGPD en Brasil exigen consentimiento explícito para profiling de IA, pero la enforcement es limitada en plataformas globales.

Beneficios potenciales de la ciberseguridad incluyen honeypots para monitorear propagación, implementados con herramientas como Wireshark para análisis de tráfico y SIEM (Security Information and Event Management) systems para alertas en tiempo real.

| Riesgo en Ciberseguridad | Tecnología Involucrada | Mitigación Técnica |

|---|---|---|

| Desinformación Viral | Algoritmos de difusión en graphs. | Implementar watermarking digital en contenidos generados por IA. |

| Privacidad de Usuarios | Scraping con BeautifulSoup. | Rate limiting y CAPTCHA basados en ML. |

| Radicalización Predictiva | Modelos de serie temporal con ARIMA. | Intervenciones éticas con nudges en UI/UX. |

Casos de Estudio: Patrones Visuales y Datos Empíricos

Un análisis visual profundo revela patrones en la manósfera: gráficos de red muestran clústers densos en TikTok, donde videos cortos (15-60 segundos) con música de fondo generan un 200% más de shares que formatos largos. Datos de Google Trends indican picos en búsquedas de “manosphere” correlacionados con eventos sociales, procesados mediante análisis de correlación Pearson.

En un caso específico, el canal de YouTube “Fresh and Fit” acumula millones de vistas mediante thumbnails optimizados con A/B testing algorítmico, donde la IA evalúa CTR (Click-Through Rate). Estudios de Pew Research destacan que el 25% de hombres jóvenes en EE.UU. consumen este contenido, con métricas de retención calculadas como integral de tiempo de permanencia.

Técnicamente, herramientas como NetworkX en Python modelan estas redes, identificando influencers como nodos de alta centralidad (degree centrality > 50). Implicancias incluyen el uso de federated learning para entrenar modelos de detección sin centralizar datos sensibles, preservando privacidad.

Medidas de Mitigación y Mejores Prácticas en IA y Ciberseguridad

Para contrarrestar la propagación, se recomiendan arquitecturas de IA híbridas: combinar rule-based systems con ML para moderación, como en Perspective API de Google, que puntúa toxicidad en una escala de 0-1. En ciberseguridad, implementar zero-trust models verifica cada acceso, utilizando JWT (JSON Web Tokens) para autenticación en foros.

Estándares como ISO/IEC 27001 guían la gestión de riesgos, enfatizando auditorías de algoritmos. En blockchain, DAOs (Decentralized Autonomous Organizations) podrían democratizar moderación, pero requieren consensus mechanisms como Proof-of-Stake para evitar manipulación.

- Educación Digital: Programas con gamificación usando Unity engine para simular burbujas de filtro.

- Herramientas de Monitoreo: Dashboards con Kibana para visualización de logs en tiempo real.

- Regulación Técnica: Mandatos para transparency reports en APIs de recomendación.

Profesionales deben adoptar prácticas como differential privacy en datasets de entrenamiento, agregando ruido gaussiano para anonimizar contribuciones individuales.

Conclusión: Hacia un Ecosistema Digital Más Seguro

La manósfera ilustra cómo la convergencia de IA, algoritmos de recomendación y vulnerabilidades en ciberseguridad puede moldear comportamientos juveniles en entornos digitales. Al desglosar estos componentes técnicos, desde embeddings en deep learning hasta grafos de propagación, se evidencia la necesidad de intervenciones proactivas. Implementar marcos éticos en IA y fortalecer protocolos de seguridad no solo mitiga riesgos, sino que fomenta plataformas inclusivas. En resumen, el futuro depende de un equilibrio entre innovación tecnológica y responsabilidad societal, asegurando que el potencial de la IA beneficie a todos sin amplificar divisiones. Para más información, visita la fuente original.