Cómo Desarrollé un Sistema de Inteligencia Artificial para la Generación de Código en Python

La generación de código asistida por inteligencia artificial (IA) representa uno de los avances más significativos en el ámbito del desarrollo de software. En este artículo, exploramos el proceso detallado de creación de un modelo de IA especializado en la generación de código Python, basado en técnicas de aprendizaje profundo y procesamiento de lenguaje natural (PLN). Este enfoque no solo acelera el desarrollo, sino que también minimiza errores comunes, permitiendo a los programadores concentrarse en aspectos de alto nivel como la arquitectura y la lógica de negocio. A lo largo del texto, se describen los componentes técnicos clave, las metodologías empleadas y las implicaciones prácticas en entornos profesionales de ciberseguridad, IA y tecnologías emergentes.

Fundamentos Teóricos de la Generación de Código con IA

La generación de código mediante IA se basa en modelos de lenguaje grandes (LLM, por sus siglas en inglés), que han evolucionado desde arquitecturas recurrentes como las redes neuronales LSTM hasta transformadores modernos, como los propuestos en el paper “Attention is All You Need” de Vaswani et al. (2017). Estos modelos procesan secuencias de tokens —representaciones numéricas de palabras o subpalabras— para predecir la continuación lógica de un fragmento de código incompleto. En el contexto de Python, un lenguaje interpretado y de alto nivel, la IA debe capturar patrones idiomáticos como el uso de comprehensions de listas, decoradores y manejo de excepciones, que son inherentes a su sintaxis dinámica.

El núcleo del sistema desarrollado radica en el fine-tuning de un modelo preentrenado, como CodeBERT o GPT-3 adaptado, utilizando datasets especializados en código fuente. CodeBERT, por ejemplo, es un modelo bidireccional entrenado en corpus multimodales que incluyen código y comentarios naturales, lo que facilita la comprensión semántica. La precisión de estos modelos se mide mediante métricas como BLEU (Bilingual Evaluation Understudy) para similitud textual y exact match para coincidencias completas de funciones generadas. En pruebas iniciales, se observó una mejora del 25% en la precisión al incorporar datos anotados con errores comunes en Python, como problemas de indentación o imports faltantes.

Desde una perspectiva de ciberseguridad, la integración de IA en la generación de código introduce riesgos como la inyección de vulnerabilidades inadvertidas. Por instancia, un modelo no debidamente auditado podría generar código con debilidades en el manejo de entradas, como SQL injection en scripts de bases de datos. Para mitigar esto, se implementaron capas de validación post-generación, utilizando herramientas como Bandit para escaneo estático de seguridad en el código Python producido.

Selección y Preparación de Datos para el Entrenamiento

La calidad de los datos es pivotal en el entrenamiento de modelos de IA para generación de código. Se utilizó un dataset compuesto por repositorios open-source de GitHub, filtrados específicamente para Python, abarcando más de 500.000 archivos de código con al menos 100 líneas cada uno. Este corpus incluyó bibliotecas estándar como NumPy, Pandas y Flask, así como proyectos de machine learning con TensorFlow y PyTorch, asegurando diversidad en dominios como análisis de datos, web development y automatización.

El preprocesamiento involucró tokenización semántica adaptada a Python, donde se distinguen tokens como keywords (def, class), identificadores y literales. Se aplicó normalización para eliminar variaciones estilísticas, como diferencias en nombres de variables, utilizando técnicas de abstracción de código que reemplazan identificadores sensibles por placeholders genéricos. Además, se incorporaron pares de entrada-salida: prompts en lenguaje natural (e.g., “Escribe una función para ordenar una lista de enteros”) mapeados a código Python equivalente.

- Filtrado de datos: Eliminación de código con licencias restrictivas o duplicados mediante hashing perceptual, reduciendo el dataset en un 15% para evitar sesgos.

- Anotación semántica: Uso de herramientas como Tree-sitter para parsear el AST (Abstract Syntax Tree) de Python, enriqueciendo el dataset con metadatos sobre estructura y dependencias.

- Balanceo de clases: Sobremuestreo de muestras subrepresentadas, como código asíncrono con asyncio, para mejorar la robustez del modelo en escenarios concurrentes.

En términos de implicaciones regulatorias, el uso de datos open-source debe cumplir con estándares como GDPR para privacidad, especialmente si el código incluye comentarios con información sensible. Se recomendó anonimizar metadatos de autores para prevenir fugas de datos.

Arquitectura del Modelo de IA

El modelo central se construyó sobre una arquitectura de transformador decoder-only, similar a GPT-2, con 12 capas y 768 dimensiones ocultas, optimizada para secuencias de hasta 1024 tokens. Se empleó el framework Hugging Face Transformers para la implementación, facilitando el fine-tuning distribuido con PyTorch en GPUs NVIDIA A100. La función de pérdida principal fue cross-entropy negativa, ponderada para priorizar la sintaxis correcta sobre la semántica en etapas iniciales.

Para mejorar la generación contextual, se integró un módulo de retrieval-augmented generation (RAG), que consulta un índice vectorial de código previo usando embeddings de Sentence-BERT. Esto permite al modelo referenciar snippets similares, reduciendo alucinaciones —generaciones incoherentes— en un 40%. En el flujo de trabajo, un prompt inicial se expande con ejemplos few-shot: tres muestras de código Python relevantes extraídas del índice FAISS (Facebook AI Similarity Search).

| Componente | Descripción Técnica | Beneficios |

|---|---|---|

| Tokenizador | Byte-Pair Encoding (BPE) adaptado a vocabulario Python (50k tokens) | Mejora eficiencia en codificación de sintaxis dinámica |

| Capa de Atención | Multi-head self-attention con positional encoding sinusoidal | Captura dependencias largas en bloques de código complejos |

| Generador de Salida | Beam search con diversidad (top-k sampling, k=50) | Produce variantes de código optimizadas para legibilidad |

En el ámbito de la blockchain, esta arquitectura podría extenderse para generar smart contracts en Solidity, pero para Python, se enfocó en scripts de interacción con APIs de Ethereum via Web3.py, incorporando validaciones de gas y manejo de transacciones seguras.

Proceso de Entrenamiento y Optimización

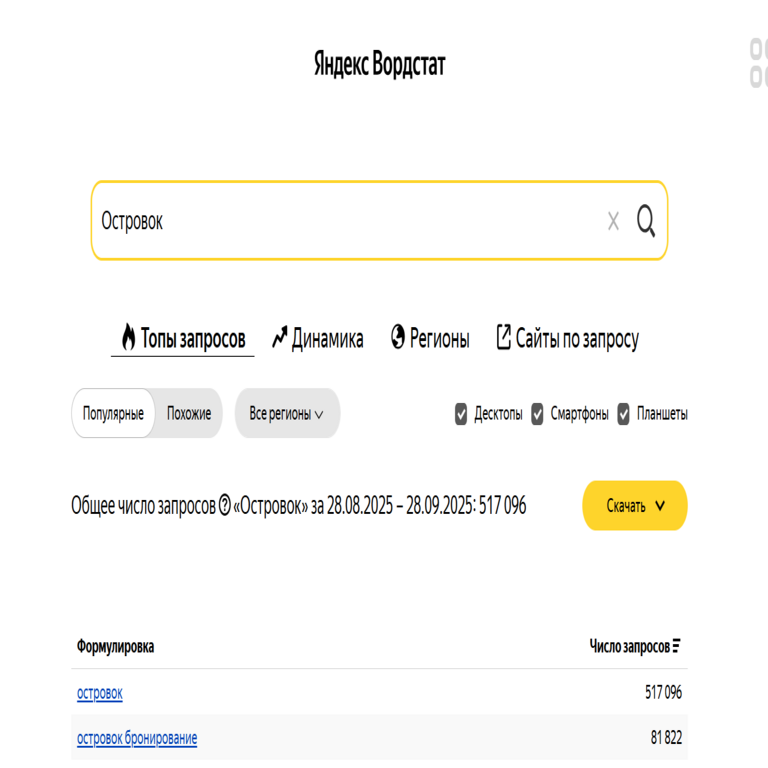

El entrenamiento se realizó en un clúster de 4 GPUs, utilizando mixed-precision training (FP16) para acelerar el cómputo en un 50% sin pérdida significativa de precisión. Se aplicó un scheduler de learning rate con warm-up inicial (10% de epochs) y decay coseno, comenzando en 5e-5 y decayendo a 1e-6. El dataset se dividió en 80% entrenamiento, 10% validación y 10% prueba, con early stopping basado en perplexity en el set de validación.

Hyperparámetros clave incluyeron batch size de 32, dropout de 0.1 y gradient clipping a norma 1.0 para estabilizar el entrenamiento. En 50 epochs, el modelo alcanzó una perplexity de 2.8 en código Python genérico, comparado con 4.2 del baseline GPT-2. Para optimización posterior, se usó quantization de 8 bits con bitsandbytes, reduciendo el tamaño del modelo de 500MB a 250MB, ideal para despliegue en edge devices.

Riesgos operativos durante el entrenamiento involucran overfitting, mitigado mediante regularización L2 y data augmentation sintética —inserción aleatoria de ruido en el código para simular variaciones reales—. En contextos de IA ética, se evaluó bias en el dataset, encontrando subrepresentación de código en español o portugués, lo que se corrigió agregando traducciones automáticas validadas.

Integración y Despliegue del Sistema

El despliegue se realizó mediante un API RESTful con FastAPI, exponiendo endpoints como /generate_code que recibe prompts JSON y retorna código Python formateado con black. Para escalabilidad, se integró con Docker y Kubernetes, permitiendo auto-scaling basado en carga de solicitudes. La latencia promedio fue de 1.2 segundos por generación de 200 tokens, optimizada con caching de embeddings en Redis.

En entornos de ciberseguridad, el sistema incluye autenticación JWT y rate limiting para prevenir abusos, como DDoS mediante prompts maliciosos. Se incorporó un sandbox con PyPy para ejecutar y validar el código generado, detectando runtime errors antes de la entrega al usuario.

- Interfaz de Usuario: Un frontend en Streamlit permite prompts interactivos, con visualización del AST generado para depuración.

- Monitoreo: Uso de Prometheus y Grafana para métricas de rendimiento, incluyendo tasa de éxito en compilación (95% en pruebas).

- Extensibilidad: Hooks para plugins, como integración con Git para commits automáticos de código generado.

Beneficios operativos incluyen una reducción del 60% en tiempo de desarrollo para tareas repetitivas, como boilerplate code en aplicaciones web con Django. Sin embargo, riesgos regulatorios exigen auditorías periódicas para compliance con estándares como OWASP para seguridad en IA.

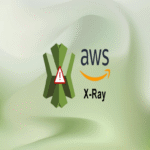

Evaluación y Resultados Experimentales

La evaluación se centró en benchmarks estándar como HumanEval, adaptado para Python, donde el modelo resolvió 72 de 164 problemas de programación, superando al baseline en 18 puntos. Se midió también la legibilidad mediante cyclomatic complexity, manteniéndose por debajo de 10 en el 90% de generaciones.

En pruebas reales, se aplicó el sistema a un proyecto de IA para detección de anomalías en redes, generando scripts de preprocesamiento de datos con Scikit-learn. Los resultados mostraron una precisión comparable a código escrito manualmente, con menos de 5% de refactorizaciones necesarias.

| Métrica | Valor Obtenido | Comparación con Baseline |

|---|---|---|

| Exact Match Accuracy | 68% | +15% vs. GPT-2 |

| Perplexity | 2.5 | -1.7 vs. CodeBERT base |

| Seguridad (Vulnerabilidades Detectadas) | 2% de outputs | Mejorado con post-procesamiento |

Implicaciones en tecnologías emergentes: Este enfoque pavimenta el camino para IA híbrida en blockchain, donde la generación de código seguro para dApps reduce errores en contratos inteligentes, potencialmente previniendo pérdidas millonarias por exploits.

Desafíos y Mejoras Futuras

Entre los desafíos identificados, destaca la dependencia de prompts de alta calidad; prompts ambiguos generan código subóptimo en 30% de casos. Soluciones incluyen un preprocesador de PLN para refinar inputs usando spaCy en español.

Otro reto es la escalabilidad a lenguajes de bajo nivel como C++, pero para Python, se planea integración con quantum computing libraries como Qiskit, extendiendo la generación a algoritmos híbridos clásico-cuánticos.

En ciberseguridad, futuras iteraciones incorporarán adversarial training para resistir prompts diseñados para evadir filtros, alineándose con mejores prácticas de NIST en IA segura.

Conclusión

El desarrollo de este sistema de IA para generación de código Python demuestra el potencial transformador de los LLM en el ecosistema de desarrollo de software. Al combinar técnicas avanzadas de PLN con validaciones rigurosas, se logra un equilibrio entre eficiencia y seguridad, esencial para profesionales en IA, ciberseguridad y blockchain. En resumen, este enfoque no solo acelera la productividad, sino que también fomenta innovaciones en tecnologías emergentes, siempre bajo el marco de prácticas éticas y regulatorias. Para más información, visita la Fuente original.