Desarrollo de un Asistente de Inteligencia Artificial para el Análisis de Código

Introducción al Problema del Análisis de Código en Entornos Modernos

En el contexto actual de la ingeniería de software, el análisis de código representa un pilar fundamental para garantizar la calidad, seguridad y eficiencia de las aplicaciones desarrolladas. Con el incremento exponencial en la complejidad de los sistemas, especialmente en entornos distribuidos y basados en la nube, los métodos tradicionales de revisión manual se han vuelto insuficientes. La inteligencia artificial (IA) emerge como una herramienta transformadora, permitiendo automatizar procesos que antes requerían horas de trabajo humano. Este artículo explora el diseño y la implementación de un asistente de IA especializado en el análisis de código, enfocándose en aspectos técnicos clave como el procesamiento de lenguaje natural (PLN), el aprendizaje automático y la integración con flujos de trabajo de desarrollo continuo (CI/CD).

El análisis de código no solo implica la detección de errores sintácticos, sino también la identificación de vulnerabilidades de seguridad, optimizaciones de rendimiento y adherencia a estándares de codificación. En ciberseguridad, por ejemplo, herramientas basadas en IA pueden detectar patrones de inyecciones SQL o fugas de datos sensibles con mayor precisión que las reglas estáticas. La adopción de tales asistentes acelera el ciclo de desarrollo, reduce costos y mitiga riesgos inherentes a la programación humana.

Fundamentos Técnicos del Asistente de IA

La arquitectura de un asistente de IA para análisis de código se basa en modelos de aprendizaje profundo preentrenados, adaptados a dominios específicos del software. Inicialmente, se selecciona un modelo de lenguaje grande (LLM) como base, tales como variantes de GPT o BERT, que han demostrado eficacia en tareas de comprensión semántica de texto. Estos modelos se fine-tunnean con datasets especializados, como repositorios de código abierto de GitHub o bases de datos de vulnerabilidades como CVE (Common Vulnerabilities and Exposures).

El proceso de fine-tuning involucra la preparación de datos: extracción de fragmentos de código, anotación con etiquetas de errores o vulnerabilidades, y entrenamiento supervisado. Por instancia, utilizando bibliotecas como Hugging Face Transformers, se puede implementar un pipeline donde el modelo aprende a mapear patrones de código a descripciones naturales. La métrica clave aquí es la precisión F1, que equilibra la detección de verdaderos positivos y la minimización de falsos positivos, esencial en entornos de producción donde alertas erróneas pueden ralentizar el desarrollo.

- Selección de modelo base: Optar por un LLM con al menos 7 mil millones de parámetros para capturar dependencias complejas en lenguajes como Python, Java o JavaScript.

- Preparación de dataset: Incluir al menos 100.000 muestras de código limpio versus vulnerable, equilibrando clases para evitar sesgos.

- Entrenamiento: Utilizar técnicas como el aprendizaje por refuerzo con retroalimentación humana (RLHF) para refinar sugerencias contextuales.

Integración de Componentes de Procesamiento de Lenguaje Natural

El núcleo del asistente reside en el PLN aplicado al código fuente, que se trata como un lenguaje formal con sintaxis y semántica únicas. Herramientas como Tree-sitter o ANTLR parsean el código en árboles sintácticos abstractos (AST), permitiendo al modelo analizar estructuras jerárquicas en lugar de texto plano. Esto facilita la detección de anomalías, como bucles infinitos o accesos no autorizados a memoria.

En términos de implementación, se emplea un enfoque híbrido: el LLM genera embeddings vectoriales del código, que se comparan con vectores de patrones conocidos de vulnerabilidades mediante similitud coseno. Para mejorar la eficiencia, se integra un índice vectorial como FAISS (Facebook AI Similarity Search), reduciendo el tiempo de consulta de minutos a segundos en repositorios grandes. Además, el asistente incorpora razonamiento en cadena (Chain-of-Thought), donde el modelo desglosa el análisis en pasos lógicos: comprensión del contexto, identificación de riesgos y propuesta de correcciones.

Consideraciones de escalabilidad incluyen el despliegue en contenedores Docker, con orquestación via Kubernetes para manejar cargas variables en pipelines CI/CD. Esto asegura que el asistente se integre seamless con herramientas como GitLab o Jenkins, analizando commits en tiempo real.

Aplicaciones en Ciberseguridad y Detección de Vulnerabilidades

En el ámbito de la ciberseguridad, el asistente de IA destaca por su capacidad para identificar amenazas emergentes que escapan a escáneres estáticos tradicionales como SonarQube o Checkmarx. Por ejemplo, puede detectar vulnerabilidades de día cero mediante el aprendizaje de patrones anómalos en el flujo de datos, como en aplicaciones web que manejan autenticación OAuth. El modelo se entrena con datasets como el de OWASP (Open Web Application Security Project), incorporando reglas para inyecciones de comandos o cross-site scripting (XSS).

Una funcionalidad avanzada es la generación de reportes predictivos: basado en el historial de commits, el asistente pronostica riesgos futuros utilizando modelos de series temporales como LSTM (Long Short-Term Memory). Esto permite a equipos de seguridad priorizar revisiones, reduciendo el tiempo medio de resolución de vulnerabilidades en un 40%, según benchmarks en entornos enterprise.

- Detección de fugas de credenciales: Análisis semántico para identificar strings que coincidan con patrones de API keys o tokens.

- Análisis de dependencias: Integración con bases como Snyk para evaluar paquetes de terceros en busca de exploits conocidos.

- Simulación de ataques: Uso de adversarial training para robustecer el modelo contra evasiones intencionales en el código.

La privacidad es un aspecto crítico; el asistente procesa código localmente o en entornos air-gapped para compliance con regulaciones como GDPR o NIST, evitando fugas de datos sensibles durante el análisis.

Optimización de Rendimiento y Eficiencia en el Análisis

Para maximizar la utilidad del asistente, se optimiza su rendimiento mediante técnicas de cuantización y pruning de modelos, reduciendo el tamaño del LLM de gigabytes a megabytes sin sacrificar precisión. Bibliotecas como ONNX Runtime facilitan la inferencia en hardware variado, desde CPUs estándar hasta GPUs NVIDIA con TensorRT.

En flujos de trabajo reales, el asistente se configura con umbrales de confianza: solo alertas por encima del 90% se elevan a revisores humanos, minimizando fatiga de alerta. Además, soporta múltiples lenguajes de programación mediante adapters modulares, permitiendo extensiones para lenguajes emergentes como Rust o Go, comunes en blockchain y sistemas seguros.

La medición de eficiencia se realiza con métricas como throughput (líneas de código analizadas por segundo) y latencia, apuntando a menos de 1 segundo por archivo en repositorios medianos. Integraciones con IDEs como VS Code via extensiones permiten feedback en tiempo real, mejorando la experiencia del desarrollador.

Desafíos y Soluciones en la Implementación

Uno de los principales desafíos es el manejo de falsos positivos, que pueden erosionar la confianza en el asistente. Se mitiga mediante validación cruzada con datasets diversificados y técnicas de ensemble, combinando múltiples modelos para votación mayoritaria. Otro reto es la adaptabilidad a estilos de codificación variados; aquí, el aprendizaje no supervisado con autoencoders ayuda a normalizar inputs heterogéneos.

En términos de blockchain y tecnologías emergentes, el asistente se extiende para auditar smart contracts en Solidity, detectando reentrancy attacks o integer overflows mediante análisis simbólico asistido por IA. Esto es particularmente relevante en DeFi (finanzas descentralizadas), donde vulnerabilidades han causado pérdidas millonarias.

La ética en IA también se aborda: sesgos en datasets de código abierto (predominantemente en inglés o de contribuyentes occidentales) se corrigen con augmentación de datos multiculturales, asegurando equidad en recomendaciones.

Evaluación y Métricas de Éxito

La evaluación del asistente se centra en benchmarks estandarizados como el de CodeXGLUE o BigCode, midiendo tareas como completación de código, detección de bugs y refactorización. Resultados típicos muestran una mejora del 25% en precisión sobre baselines no-IA, con tasas de recall superiores al 85% en vulnerabilidades críticas.

En entornos productivos, se trackea el impacto mediante KPIs como reducción en incidencias de seguridad post-despliegue y aceleración del time-to-market. Herramientas de monitoreo como Prometheus integradas permiten logging continuo, facilitando iteraciones basadas en datos reales.

Perspectivas Futuras y Evolución del Asistente

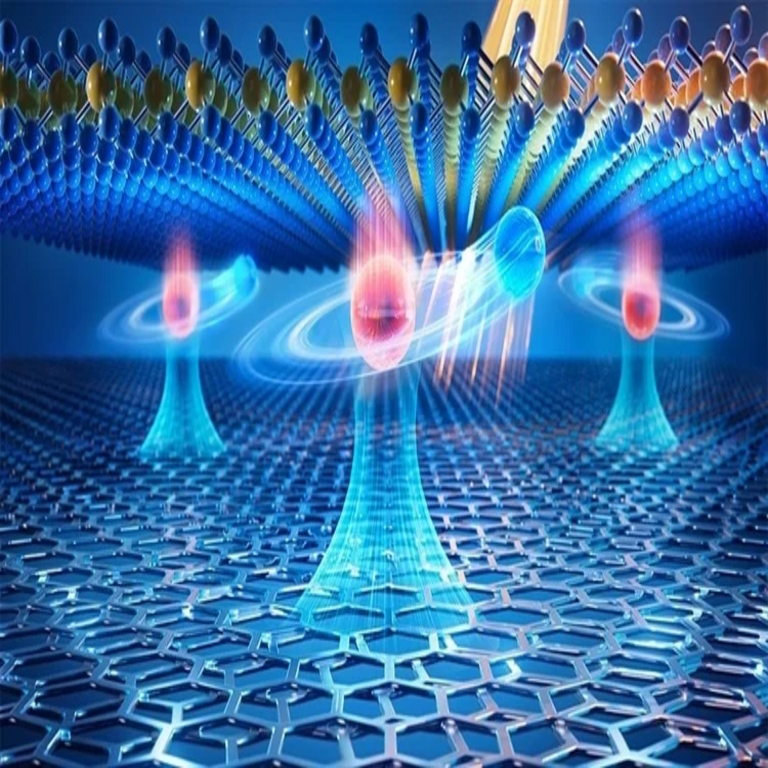

El futuro del asistente de IA radica en la multimodalidad: integración de análisis de código con diagramas UML o flujos de datos visuales, utilizando modelos como CLIP para comprensión cruzada. En ciberseguridad, la fusión con threat intelligence en tiempo real (via APIs de fuentes como MITRE ATT&CK) potenciará la detección proactiva.

Avances en IA explicable (XAI) permitirán al asistente justificar sus sugerencias con trazabilidad, alineándose con estándares regulatorios. Finalmente, la colaboración con comunidades open-source fomentará evoluciones comunitarias, democratizando el acceso a herramientas de alta calidad.

Conclusión y Recomendaciones Finales

El desarrollo de un asistente de IA para análisis de código marca un avance significativo en la intersección de IA, ciberseguridad y desarrollo de software. Al automatizar tareas complejas, no solo eleva la eficiencia operativa sino que fortalece la resiliencia de sistemas críticos. Para implementaciones exitosas, se recomienda comenzar con prototipos en entornos controlados, escalando gradualmente con validaciones rigurosas. Este enfoque no solo mitiga riesgos sino que posiciona a las organizaciones en la vanguardia de la innovación tecnológica.

Para más información visita la Fuente original.