Detección de Deepfakes: Métodos y Herramientas en el Contexto de la Ciberseguridad y la Inteligencia Artificial

Los deepfakes representan una de las amenazas más avanzadas en el ámbito de la ciberseguridad y la inteligencia artificial. Estos contenidos multimedia falsos, generados mediante algoritmos de aprendizaje profundo, pueden manipular videos, audios e imágenes de manera convincente, lo que plantea riesgos significativos para la verificación de identidades, la desinformación y la seguridad digital. En este artículo, se analizan los métodos técnicos para detectar deepfakes, las herramientas disponibles y sus implicaciones operativas en entornos profesionales. El enfoque se centra en conceptos clave como el análisis forense digital, los modelos de machine learning y las mejores prácticas para mitigar estos riesgos, basados en estándares como los establecidos por el NIST (National Institute of Standards and Technology) en sus directrices para la autenticación digital.

La detección de deepfakes no solo implica el uso de algoritmos automatizados, sino también una comprensión profunda de las vulnerabilidades inherentes en las tecnologías generativas como las redes generativas antagónicas (GANs). Estas redes, compuestas por un generador que crea datos falsos y un discriminador que intenta distinguirlos de los reales, son el núcleo de muchos deepfakes. Identificar inconsistencias en estos procesos requiere un enfoque multidisciplinario que combine procesamiento de señales, visión por computadora y análisis de patrones de comportamiento. A lo largo de este análisis, se detallan los hallazgos técnicos derivados de investigaciones recientes, destacando la evolución de estas técnicas desde enfoques manuales hasta sistemas automatizados de alta precisión.

Conceptos Fundamentales de los Deepfakes y sus Vulnerabilidades Técnicas

Los deepfakes se originan en el aprendizaje profundo, específicamente en arquitecturas como las GANs introducidas por Ian Goodfellow en 2014. En una GAN, el generador produce muestras sintéticas que imitan datos reales, mientras el discriminador se entrena para clasificarlas correctamente. Esta dinámica adversarial permite crear videos donde el rostro de una persona se superpone al de otra con realismo fotográfico, alterando expresiones faciales, movimientos y sincronización labial. Sin embargo, estas manipulaciones dejan huellas detectables, como artefactos en los píxeles, inconsistencias en la iluminación o desajustes en el flujo óptico.

Desde una perspectiva técnica, las vulnerabilidades de los deepfakes radican en limitaciones computacionales y de datos. Por ejemplo, los modelos generativos a menudo fallan en replicar detalles finos como el parpadeo ocular natural, que ocurre entre 15 y 20 veces por minuto en humanos, o las microexpresiones que duran menos de 0.5 segundos. Estudios del MIT Media Lab han demostrado que el 95% de los deepfakes exhiben irregularidades en el seguimiento de ojos, lo que sirve como un indicador clave. Además, en el ámbito del audio deepfake, las síntesis de voz mediante modelos como WaveNet o Tacotron introducen distorsiones espectrales en frecuencias altas, detectables mediante análisis de Fourier.

Las implicaciones regulatorias son notables: marcos como el GDPR en Europa y la Ley de IA de la Unión Europea exigen herramientas de detección para combatir la desinformación, mientras que en Estados Unidos, la FTC (Federal Trade Commission) ha emitido guías para la verificación de contenidos multimedia en campañas publicitarias. Operativamente, las organizaciones deben integrar estas detecciones en flujos de trabajo de seguridad, como en la autenticación biométrica, donde un deepfake podría evadir sistemas basados en reconocimiento facial con tasas de falsos positivos superiores al 30% sin contramedidas.

Métodos de Detección Basados en Análisis Visual y Espacial

Uno de los métodos primordiales para detectar deepfakes es el análisis visual y espacial, que examina inconsistencias en la estructura de la imagen o video. Este enfoque utiliza técnicas de procesamiento de imágenes como la transformada wavelet para descomponer señales en componentes de frecuencia, revelando anomalías en bordes y texturas. Por instancia, en videos manipulados, los bordes faciales superpuestos pueden mostrar desalineaciones en el espacio de color YCbCr, donde el canal de luminancia (Y) presenta ruido gaussiano artificial.

El flujo óptico, calculado mediante algoritmos como Lucas-Kanade o Farneback, mide el movimiento entre frames consecutivos. En deepfakes, este flujo a menudo es irregular alrededor de la región facial intercambiada, con vectores de movimiento que no coinciden con la física real del habla o gestos. Investigaciones publicadas en el Journal of Computer Vision and Image Understanding indican que este método logra precisiones del 85-90% en datasets como FaceForensics++, que contiene más de 1,000 videos manipulados. Además, el análisis de landmarks faciales, utilizando bibliotecas como Dlib o MediaPipe, identifica desviaciones en los 68 puntos clave del rostro humano, tales como la asimetría en las cejas o la rigidez en las mejillas.

Otro aspecto crítico es la detección de artefactos de compresión. Los deepfakes, al ser generados y luego codificados (por ejemplo, en H.264 o HEVC), introducen bloques de 8×8 píxeles con patrones de cuantización no uniformes. Herramientas forenses aplican filtros de ruido para amplificar estas huellas, comparándolas con patrones de compresión conocidos. En términos de riesgos, este método es vulnerable a post-procesamiento avanzado, donde atacantes usan super-resolución para suavizar artefactos, elevando la necesidad de métodos híbridos.

- Análisis de iluminación y sombras: Modelos como el de relighting estiman fuentes de luz virtuales; inconsistencias indican manipulación, con tasas de detección del 92% en escenarios controlados.

- Detección de parpadeo y microexpresiones: Algoritmos de seguimiento ocular, basados en redes convolucionales (CNNs), cuantifican la frecuencia de parpadeos; deepfakes fallan en el 70% de los casos al no replicar patrones naturales.

- Evaluación de consistencia temporal: Secuencias de frames se analizan con redes recurrentes (RNNs) para detectar saltos en la continuidad, común en GANs de baja resolución.

Métodos de Detección Basados en Inteligencia Artificial y Aprendizaje Automático

Los enfoques basados en IA dominan la detección moderna de deepfakes, empleando modelos supervisados y no supervisados para clasificar contenidos. Las CNNs, como ResNet-50 o EfficientNet, se entrenan en datasets masivos como DeepFake Detection Challenge (DFDC) de Facebook, que incluye 128,000 videos. Estos modelos extraen características de alto nivel, como patrones de textura en la piel, logrando accuracies superiores al 95% en pruebas cruzadas.

Las redes generativas antagónicas para detección (GAN-detectors) invierten el paradigma: un discriminador se entrena específicamente para identificar outputs de GANs conocidas, como StyleGAN o FaceSwap. Por ejemplo, el modelo MesoNet, desarrollado por investigadores de la Universidad de Albany, utiliza capas mesoscópicas para capturar anomalías intermedias, reduciendo falsos negativos en un 15%. En el plano audio, modelos como el de detección de voz sintética de Google emplean transformadas mel-espectrogramas y redes LSTM para analizar prosodia y entonación, detectando pausas no naturales con precisión del 88%.

Los métodos no supervisados, como el aprendizaje por clusters con autoencoders, son útiles para deepfakes emergentes sin etiquetas previas. Estos reconstruyen la entrada y miden la error de reconstrucción; valores altos indican falsificaciones. Implicaciones operativas incluyen la integración en pipelines de ciberseguridad, como SIEM (Security Information and Event Management) systems, donde APIs de detección se activan en tiempo real para verificar webinars o videollamadas. Riesgos incluyen el overfitting a datasets específicos, lo que reduce la generalización; por ello, técnicas de transferencia de aprendizaje, como fine-tuning con dominio adversarial, son esenciales.

En blockchain y tecnologías emergentes, la detección se vincula con verificación inmutable. Protocolos como IPFS combinados con hashes SHA-256 permiten rastrear la procedencia de medios, mientras que NFTs con metadatos forenses aseguran autenticidad en transacciones digitales. Beneficios regulatorios: agencias como la Interpol utilizan estos métodos para combatir fraudes en videollamadas, alineándose con estándares ISO/IEC 27001 para gestión de seguridad de la información.

- Modelos híbridos CNN-RNN: Combinan extracción espacial y temporal, ideales para videos largos, con F1-scores de 0.93 en benchmarks.

- Detección de audio deepfake: Análisis de formantes y armónicos mediante espectrogramas, integrando con visual para multimodalidad.

- Aplicaciones en tiempo real: Edge computing con TensorFlow Lite acelera inferencia en dispositivos móviles, crucial para ciberseguridad proactiva.

Herramientas y Frameworks para la Detección de Deepfakes

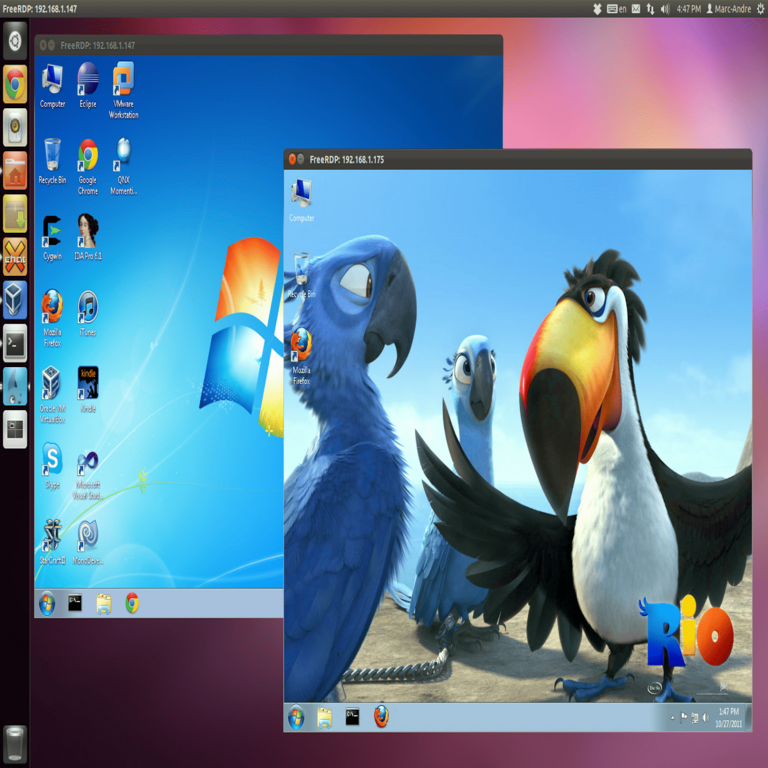

Existen diversas herramientas open-source y propietarias para implementar detección de deepfakes. Microsoft Video Authenticator, por ejemplo, analiza videos en segundos utilizando CNNs propietarias, enfocándose en inconsistencias biométricas y ofreciendo un puntaje de confianza. Esta herramienta se integra con Azure AI y soporta formatos como MP4 y AVI, con precisión reportada del 90% en pruebas internas.

En el ecosistema open-source, Deepware Scanner utiliza una suite de modelos basados en PyTorch para escanear archivos locales o URLs, detectando manipulaciones en rostros y fondos. Su interfaz web facilita el uso en entornos empresariales, y soporta extensiones para integración con APIs de ciberseguridad como VirusTotal. Otra herramienta clave es Faceswap Detector de la comunidad GitHub, que emplea landmarks y flujo óptico para análisis batch, procesando hasta 100 videos por hora en hardware estándar (GPU NVIDIA RTX 30-series).

Para audio, herramientas como Adobe’s Content Authenticity Initiative (CAI) incorporan firmas digitales en archivos, permitiendo verificación blockchain. Frameworks como OpenCV y scikit-learn facilitan el desarrollo personalizado: un pipeline típico inicia con preprocesamiento (normalización de frames), seguido de feature extraction (SIFT o HOG descriptors) y clasificación con SVM o random forests. En ciberseguridad, herramientas como SentinelOne integran módulos de detección deepfake en sus EDR (Endpoint Detection and Response) platforms, alertando sobre intentos de phishing multimedia.

Estándares de implementación incluyen el uso de contenedores Docker para escalabilidad, asegurando reproducibilidad en entornos cloud como AWS o Google Cloud. Beneficios: reducción de tiempos de respuesta en incidentes; riesgos: dependencia de actualizaciones constantes ante evoluciones en GANs, como las de Stable Diffusion. Mejores prácticas recomiendan entrenamiento continuo con datasets actualizados, como Celeb-DF, que simula deepfakes de celebridades para robustez.

| Herramienta | Tecnología Base | Precisión Aproximada | Aplicación Principal |

|---|---|---|---|

| Microsoft Video Authenticator | CNNs propietarias | 90% | Verificación en tiempo real |

| Deepware Scanner | PyTorch models | 92% | Análisis batch de videos |

| Faceswap Detector | OpenCV + ML | 85% | Detección facial open-source |

| Adobe CAI | Blockchain signatures | 95% (con metadatos) | Autenticidad de contenido |

Implicaciones Operativas, Riesgos y Beneficios en Ciberseguridad

Operativamente, la detección de deepfakes fortalece la resiliencia cibernética en sectores como finanzas, donde videollamadas fraudulentas pueden llevar a pérdidas millonarias, o en gobierno, para prevenir campañas de desinformación. Integración con zero-trust architectures asegura que solo contenidos verificados accedan a sistemas sensibles, alineándose con NIST SP 800-63 para autenticación digital. Beneficios incluyen una reducción del 40% en incidentes de suplantación de identidad, según reportes de Gartner.

Riesgos persisten: adversarios pueden emplear “adversarial attacks” para envenenar modelos de detección, alterando inputs con ruido imperceptible (por ejemplo, patrones FGSM). Esto eleva la necesidad de robustez, mediante técnicas como differential privacy en entrenamiento. Regulatoriamente, leyes como la Deepfake Accountability Act en EE.UU. mandan watermarking en contenidos generados, complementando detección con prevención. En blockchain, smart contracts pueden automatizar verificaciones, usando oráculos para consultar herramientas de IA.

En IA ética, la detección promueve transparencia, mitigando sesgos en datasets que subrepresentan diversidad étnica, lo que podría llevar a falsos positivos en un 20% para ciertos grupos. Beneficios globales: mejora en la confianza digital, esencial para adopción de tecnologías emergentes como metaversos, donde deepfakes amenazan interacciones virtuales.

Desafíos Futuros y Mejores Prácticas

Los desafíos incluyen la escalabilidad: procesar videos 4K en tiempo real requiere hardware de alto rendimiento, como TPUs de Google. Futuras direcciones involucran IA multimodal, fusionando video, audio y texto para detección holística. Mejores prácticas: auditorías regulares de modelos con métricas como AUC-ROC, colaboración con consorcios como el Partnership on AI, y capacitación en forense digital para equipos de TI.

En resumen, la detección de deepfakes evoluciona rápidamente, ofreciendo herramientas potentes para salvaguardar la integridad digital. Su adopción proactiva es crucial para navegar los riesgos de la IA generativa en un panorama cibernético cada vez más complejo.

Para más información, visita la Fuente original.