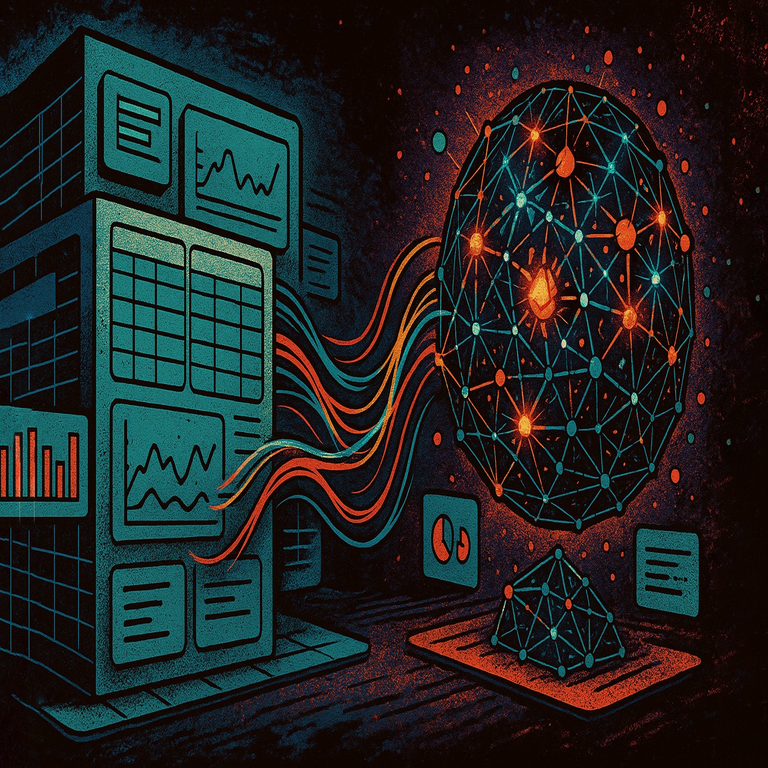

Guía Completa para Convertirse en Especialista en Machine Learning: Roadmap 2024

Introducción al Machine Learning en el Contexto Actual de la Tecnología

El machine learning (ML), como subcampo de la inteligencia artificial (IA), ha experimentado un crecimiento exponencial en los últimos años, impulsado por avances en hardware, datos masivos y algoritmos más eficientes. En 2024, el ML no solo es una herramienta para optimizar procesos industriales, sino un pilar fundamental en sectores como la ciberseguridad, la salud, las finanzas y el comercio electrónico. Un especialista en ML debe dominar conceptos matemáticos, programación avanzada y aplicaciones prácticas para desarrollar modelos que tomen decisiones autónomas basadas en datos. Este roadmap detalla los pasos necesarios para adquirir estas competencias, desde los fundamentos hasta las prácticas avanzadas, con énfasis en tecnologías emergentes y mejores prácticas del sector.

Según informes de organizaciones como Gartner y McKinsey, la demanda de profesionales en ML supera la oferta en un 50% anual, lo que hace de esta carrera una opción estratégica. Sin embargo, el camino requiere dedicación sistemática, combinando teoría y práctica. Este artículo explora las etapas clave, herramientas esenciales y desafíos operativos, proporcionando una hoja de ruta clara para aspirantes a especialistas.

Fundamentos Matemáticos y Estadísticos Esenciales

Antes de sumergirse en algoritmos de ML, es imperativo construir una base sólida en matemáticas y estadística. El álgebra lineal es el núcleo, ya que sustenta operaciones como la multiplicación de matrices en redes neuronales. Conceptos como vectores, matrices, determinantes y valores propios son cruciales para entender transformaciones lineales en modelos como la regresión lineal o el principal component analysis (PCA).

El cálculo diferencial e integral permite analizar funciones de pérdida y optimización mediante gradientes. Por ejemplo, el descenso de gradiente, un algoritmo fundamental en el entrenamiento de modelos, se basa en derivadas parciales para minimizar errores. En estadística, la inferencia bayesiana y la distribución de probabilidad (normal, binomial, Poisson) son vitales para manejar incertidumbre en predicciones. La probabilidad condicional y el teorema de Bayes se aplican directamente en modelos probabilísticos como las máquinas de vectores soporte (SVM) o las redes bayesianas.

Para profundizar, se recomienda estudiar textos como “Linear Algebra and Its Applications” de Gilbert Strang o “Pattern Recognition and Machine Learning” de Christopher Bishop. En términos prácticos, herramientas como MATLAB o Python con bibliotecas como NumPy y SciPy facilitan la implementación de estos conceptos. Un especialista debe ser capaz de derivar ecuaciones desde cero, ya que en escenarios reales, como la detección de fraudes en ciberseguridad, los datos no siempre siguen distribuciones ideales.

Las implicaciones regulatorias incluyen el cumplimiento de estándares como GDPR en Europa, donde los modelos de ML deben garantizar transparencia en sus cálculos matemáticos para evitar sesgos. Riesgos como la sobreajuste (overfitting) pueden llevar a decisiones erróneas, por lo que técnicas como la validación cruzada son obligatorias.

Programación y Entornos de Desarrollo para ML

Python se ha consolidado como el lenguaje principal para ML debido a su sintaxis clara y ecosistema rico. Bibliotecas como Pandas para manipulación de datos, Matplotlib y Seaborn para visualización, y Scikit-learn para algoritmos supervisados e no supervisados son indispensables. Un ejemplo práctico es el uso de Pandas para limpiar datasets con valores faltantes mediante imputación media o mediana, seguido de normalización con Scikit-learn para preparar datos en un pipeline de ML.

Para entornos de desarrollo, Jupyter Notebooks permiten experimentación interactiva, mientras que entornos como Google Colab o Kaggle ofrecen recursos gratuitos con GPUs para entrenamiento de modelos grandes. En producción, Docker y Kubernetes facilitan el despliegue escalable de modelos ML, integrándose con microservicios en arquitecturas cloud como AWS SageMaker o Azure ML Studio.

En ciberseguridad, Python se usa en herramientas como TensorFlow para detectar anomalías en redes, donde scripts personalizados analizan logs en tiempo real. Beneficios incluyen la reproducibilidad de experimentos mediante seeds aleatorios y versionado con Git. Desafíos operativos surgen en la integración con sistemas legacy, requiriendo conocimiento de APIs RESTful y bases de datos SQL/NoSQL como PostgreSQL o MongoDB.

Se estima que un principiante debe dedicar al menos 200 horas a programación aplicada a ML, practicando con datasets públicos del UCI Machine Learning Repository o Kaggle Competitions para internalizar flujos de trabajo end-to-end.

Algoritmos de Machine Learning: De Supervisado a No Supervisado

Los algoritmos supervisados, como la regresión logística para clasificación binaria o árboles de decisión para problemas multitarea, requieren datos etiquetados. En 2024, ensembles como Random Forest y Gradient Boosting (implementados en XGBoost o LightGBM) dominan por su robustez contra overfitting, con métricas como precisión, recall y F1-score para evaluación. Por instancia, en IA para blockchain, estos algoritmos predicen transacciones fraudulentas analizando patrones en ledgers distribuidos.

En aprendizaje no supervisado, el clustering con K-Means o DBSCAN agrupa datos sin etiquetas, útil en segmentación de clientes o detección de outliers en ciberseguridad. Técnicas de reducción dimensional como PCA o t-SNE visualizan datos de alta dimensión, esenciales para big data. El aprendizaje semi-supervisado, combinando ambos, es relevante en escenarios con datos limitados, como en IA médica donde etiquetar imágenes es costoso.

Avances recientes incluyen transformers en modelos como BERT para procesamiento de lenguaje natural (NLP), extendiéndose a visión por computadora con Vision Transformers (ViT). En términos de eficiencia, algoritmos federados permiten entrenamiento distribuido sin compartir datos crudos, alineándose con regulaciones de privacidad como HIPAA en salud.

Riesgos incluyen sesgos inherentes en datos de entrenamiento, mitigados por técnicas de fairness como reweighting o adversarial debiasing. Beneficios operativos abarcan automatización de tareas repetitivas, reduciendo costos en un 30-50% según estudios de Deloitte.

Deep Learning y Redes Neuronales Avanzadas

El deep learning (DL) extiende el ML mediante redes neuronales profundas, con capas ocultas que capturan representaciones jerárquicas. Frameworks como TensorFlow y PyTorch son estándar; PyTorch destaca por su dinamismo en investigación, permitiendo autograd para backpropagation automática.

En convolucionales (CNN), filtros 2D procesan imágenes para tareas como reconocimiento facial en sistemas de seguridad. Recurrentes (RNN) y LSTMs manejan secuencias temporales, aplicadas en predicción de series en finanzas o detección de intrusiones en redes. Transformers, con mecanismos de atención self-attention, revolucionan NLP y multimodalidad, como en modelos como GPT o CLIP para IA generativa.

En 2024, el enfoque está en eficiencia: quantization y pruning reducen el tamaño de modelos para edge computing en dispositivos IoT. En ciberseguridad, GANs (Generative Adversarial Networks) generan datos sintéticos para simular ataques, mejorando defensas. Implicaciones incluyen el consumo energético; modelos como EfficientNet optimizan FLOPs para sostenibilidad.

Práctica involucra datasets como MNIST para CNN básicas o ImageNet para transfer learning, donde se fine-tunea un modelo preentrenado. Desafíos regulatorios exigen explicabilidad, resuelta con técnicas como SHAP o LIME para interpretar predicciones black-box.

Herramientas y Frameworks Especializados en ML

Más allá de Python, Hugging Face Transformers acelera el desarrollo de NLP con modelos preentrenados. Para MLOps, MLflow gestiona ciclos de vida de modelos, desde experiment tracking hasta despliegue. Kubeflow integra Kubernetes con pipelines ML, facilitando orquestación en clusters.

En cloud, Google Cloud AI Platform ofrece AutoML para no expertos, mientras Vertex AI soporta custom training. En blockchain, bibliotecas como Web3.py combinadas con ML predicen volatilidad en criptoactivos. Herramientas de visualización como TensorBoard monitorean métricas en tiempo real.

Beneficios incluyen escalabilidad; un pipeline con Apache Airflow automatiza ETL (Extract, Transform, Load) para datos streaming de Kafka. Riesgos operativos abarcan dependencias de versiones, resueltas con entornos virtuales como Conda.

Proyectos Prácticos y Portafolio para Especialistas en ML

Construir un portafolio es clave para empleabilidad. Proyectos iniciales incluyen predicción de precios de viviendas con regresión lineal en Boston Housing dataset, evolucionando a sistemas de recomendación con collaborative filtering en MovieLens.

En IA aplicada, desarrollar un detector de deepfakes usando CNN en datasets como FaceForensics++ aborda ciberseguridad. Para blockchain, un modelo de ML que analiza transacciones en Ethereum para identificar patrones de wash trading. En salud, segmentación de tumores en MRI con U-Net.

Documentar proyectos en GitHub con READMEs detallados, incluyendo métricas y desafíos superados, es esencial. Participar en hackathons o Kaggle eleva el perfil, demostrando habilidades en colaboración y resolución de problemas reales.

Implicaciones incluyen ética: proyectos deben considerar impacto social, como evitar sesgos raciales en reconocimiento facial. Beneficios carrera: portafolios fuertes incrementan oportunidades en un 70%, per LinkedIn data.

Aspectos Avanzados: IA Generativa y Ética en ML

La IA generativa, con modelos como Stable Diffusion para imágenes o DALL-E, transforma industrias creativas y técnicas. En ciberseguridad, genera escenarios de threat modeling. Ética en ML aborda fairness, accountability y transparency (FAT), con frameworks como AIF360 de IBM para auditing.

Regulaciones como la AI Act de la UE clasifican modelos por riesgo, requiriendo evaluaciones para high-risk applications. En blockchain, ML ético asegura privacidad en zero-knowledge proofs.

Avances incluyen federated learning para privacidad, y explainable AI (XAI) para compliance. Desafíos: adversarial attacks, mitigados con robust training.

Carrera Profesional y Certificaciones en Machine Learning

Roles incluyen Data Scientist, ML Engineer y AI Researcher. Salarios promedio en Latinoamérica superan los 80.000 USD anuales para seniors. Certificaciones como Google Professional ML Engineer o AWS Certified ML validan competencias.

Educación: bootcamps como OTUS o Coursera specializations aceleran aprendizaje. Networking en conferencias como NeurIPS o locales como PyData fomenta oportunidades.

En 2024, hybrid skills en ML y ciberseguridad, como anomaly detection en SIEM systems, son demandadas. Trayectoria típica: junior (1-2 años), mid-level (3-5), senior (5+), con foco en lifelong learning.

Conclusión: Hacia un Futuro Impulsado por el Machine Learning

Convertirse en especialista en ML requiere un enfoque disciplinado, integrando teoría, práctica y ética. Este roadmap 2024 proporciona las herramientas para navegar este campo dinámico, desde fundamentos matemáticos hasta despliegues avanzados. Al dominar estas áreas, los profesionales no solo impulsan innovación en IA, ciberseguridad y blockchain, sino que contribuyen a soluciones responsables y escalables. Para más información, visita la fuente original.