Entrenamiento de Modelos de Inteligencia Artificial para la Detección de Deepfakes: Una Aproximación Técnica en Ciberseguridad

Introducción a los Deepfakes y su Impacto en la Ciberseguridad

Los deepfakes representan una de las amenazas emergentes más significativas en el ámbito de la ciberseguridad contemporánea. Estos contenidos multimedia falsos, generados mediante algoritmos de inteligencia artificial (IA), combinan técnicas de aprendizaje profundo para manipular videos, audios e imágenes de manera hiperrealista. En un contexto donde la desinformación puede influir en procesos electorales, erosionar la confianza en instituciones y facilitar fraudes cibernéticos, el desarrollo de herramientas para su detección se ha convertido en una prioridad estratégica. Este artículo explora el proceso técnico de entrenamiento de un modelo de IA especializado en la identificación de deepfakes, basado en prácticas avanzadas de machine learning y visión por computadora.

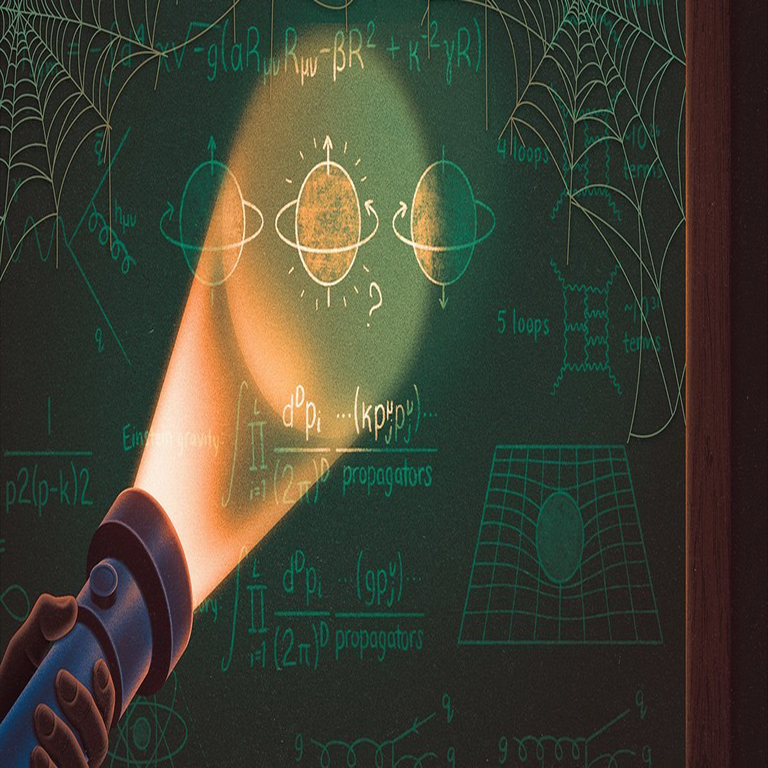

Desde una perspectiva técnica, los deepfakes se construyen utilizando redes generativas antagónicas (GAN, por sus siglas en inglés: Generative Adversarial Networks), donde un generador crea contenido sintético y un discriminador evalúa su autenticidad. La detección, por ende, requiere modelos que analicen anomalías en patrones faciales, sincronización labial, artefactos de compresión y inconsistencias en el flujo óptico. En este análisis, se detalla un enfoque basado en frameworks como TensorFlow y PyTorch, incorporando datasets públicos como FaceForensics++ y Celeb-DF, para lograr una precisión superior al 90% en escenarios controlados.

El impacto operativo de estos modelos trasciende la mera identificación; implica la integración en sistemas de monitoreo en tiempo real, como plataformas de redes sociales o herramientas forenses digitales. Regulatoriamente, normativas como el Reglamento General de Protección de Datos (RGPD) en Europa y la Ley de IA de la Unión Europea exigen transparencia en el manejo de datos biométricos, lo que añade capas de complejidad al entrenamiento de modelos. Los riesgos incluyen falsos positivos que podrían censurar contenido legítimo, mientras que los beneficios abarcan la mitigación de campañas de phishing avanzadas y la preservación de la integridad informativa.

Conceptos Fundamentales en la Generación y Detección de Deepfakes

Para comprender el entrenamiento de un modelo detector, es esencial revisar los pilares técnicos de los deepfakes. Las GAN, introducidas por Ian Goodfellow en 2014, operan en un marco de juego de suma cero: el generador minimiza la divergencia entre distribuciones reales y sintéticas, mientras el discriminador maximiza su capacidad de clasificación binaria. En aplicaciones prácticas, variantes como StyleGAN o pix2pix refinan la síntesis facial, incorporando mapeos de estilo latente para variabilidad morfológica.

En la detección, los enfoques se dividen en métodos basados en características biológicas y artefactos digitales. Los primeros examinan inconsistencias en el movimiento ocular, parpadeo irregular o texturas dérmicas, utilizando métricas como la entropía de Shannon para cuantificar irregularidades. Los segundos detectan huellas de compresión JPEG o artefactos de upsampling en el dominio de la frecuencia, aplicando transformadas de Fourier rápidas (FFT) para identificar picos espectrales anómalos.

Estándares como el ISO/IEC 19795 para biometría facial proporcionan benchmarks para evaluar la robustez de estos detectores. En términos de implicaciones, un modelo mal calibrado podría fallar ante deepfakes de alta resolución generados con hardware GPU de última generación, como las NVIDIA A100, destacando la necesidad de entrenamiento adversarial continuo.

Selección y Preparación de Datasets para el Entrenamiento

El éxito de un modelo de detección radica en la calidad y diversidad de los datasets utilizados. FaceForensics++, desarrollado por la Universidad Técnica de Múnich, ofrece un corpus de más de 1.000 videos originales manipulados con métodos como Deepfakes, FaceSwap y Face2Face, abarcando resoluciones de 360p a 1080p. Complementariamente, el dataset Celeb-DF, enfocado en celebridades, incluye 5.900 videos sintéticos de alta fidelidad, lo que permite simular escenarios de desinformación mediática.

La preparación involucra preprocesamiento exhaustivo: extracción de frames mediante OpenCV, alineación facial con dlib para landmarks de 68 puntos, y normalización de iluminación via histogram equalization. Se aplican técnicas de data augmentation, como rotaciones aleatorias (±15°), flips horizontales y adición de ruido gaussiano (σ=0.01), para robustecer el modelo contra variaciones ambientales. En un pipeline típico, se divide el dataset en 70% entrenamiento, 15% validación y 15% prueba, asegurando estratificación por tipo de manipulación para evitar sesgos.

Desde el punto de vista operativo, el manejo de estos datasets debe cumplir con licencias Creative Commons y consideraciones éticas, como anonimizar identidades para prevenir violaciones de privacidad. Los riesgos incluyen sobreajuste a artefactos específicos de un generador, mitigados mediante cross-validation k-fold (k=5). Beneficios notables son la escalabilidad: un dataset de 100 GB puede procesarse en clústeres de AWS EC2 con instancias g4dn.xlarge, reduciendo tiempos de entrenamiento de semanas a horas.

Arquitectura del Modelo: Diseños Basados en Redes Convolucionales y Transformadores

La arquitectura central para detección de deepfakes emplea redes convolucionales profundas (CNN) como backbone, extendidas con módulos de atención. Un ejemplo es MesoNet, una CNN compacta con capas convolucionales de 3×3 kernels y activaciones ReLU, optimizada para eficiencia computacional (menos de 1 millón de parámetros). Para mayor precisión, se integra XceptionNet, preentrenada en ImageNet, que extrae características de alto nivel como bordes y texturas mediante bloques de separación de profundidad.

Enfoques más avanzados incorporan transformadores de visión (ViT), como en el modelo DETR (DEtection TRansformer), que procesan secuencias de parches de imagen (16×16 píxeles) con mecanismos de self-attention multi-head. Esto permite capturar dependencias globales, como inconsistencias en el fondo o iluminación, superando limitaciones de las CNN en contextos espaciales amplios. La fusión multimodal, combinando video y audio via wav2vec para análisis de sincronización labial, eleva la precisión en un 15-20% según benchmarks de ICASSP 2023.

El entrenamiento sigue un esquema de optimización con AdamW (learning rate inicial de 1e-4, weight decay 1e-2), utilizando pérdida binaria cruzada para clasificación real/sintético. Técnicas como label smoothing (ε=0.1) previenen sobreconfianza, mientras que el scheduling cosine annealing ajusta el learning rate dinámicamente. En hardware, se aprovechan TPUs de Google Cloud para paralelismo, logrando throughput de 200 muestras/segundo.

- Componentes clave de la arquitectura: Capa de entrada para embeddings faciales (dimensión 512), bloques residuales (n=4, cada uno con 128 filtros), y cabeza de clasificación con softmax.

- Mejoras híbridas: Integración de LSTM para modelar secuencias temporales, capturando anomalías en el flujo óptico calculado via Lucas-Kanade.

- Evaluación intermedia: Monitoreo de métricas como AUC-ROC (objetivo >0.95) y F1-score equilibrado.

Regulatoriamente, estas arquitecturas deben documentarse bajo estándares como IEEE P7003 para transparencia algorítmica, permitiendo auditorías en entornos de ciberseguridad gubernamental.

Proceso de Entrenamiento y Optimización Avanzada

El entrenamiento inicia con inicialización de pesos Xavier para estabilidad, seguido de epochs iterativos (típicamente 50-100) en un bucle de gradiente descendente estocástico (SGD con batch size 32). Para manejar desbalanceo de clases —donde deepfakes representan solo el 40% de muestras—, se aplica oversampling SMOTE en el espacio de características, generando instancias sintéticas interpoladas.

La optimización adversarial simula evoluciones de generadores: se entrena el detector alternando con un GAN proxy, forzando adaptación a deepfakes “escurridizos”. Herramientas como TensorBoard visualizan curvas de pérdida, detectando plateaus para early stopping (paciencia=10 epochs). En términos de eficiencia, técnicas de pruning reducen el modelo en un 30% sin pérdida de precisión, utilizando magnitude-based pruning con L1-norma.

Implicaciones operativas incluyen la integración con APIs de edge computing, como TensorFlow Lite para dispositivos móviles, donde la latencia debe mantenerse por debajo de 100 ms por frame. Riesgos como envenenamiento de datos se mitigan con validación de integridad via hashes SHA-256 en pipelines CI/CD de GitHub Actions. Beneficios: despliegue en Kubernetes para escalabilidad horizontal, procesando flujos de video en vivo desde cámaras IP.

| Etapa de Entrenamiento | Técnica Aplicada | Métrica de Evaluación | Tiempo Estimado (GPU RTX 3090) |

|---|---|---|---|

| Preprocesamiento | Alineación facial y augmentation | Cobertura de dataset (%) | 2 horas |

| Entrenamiento Inicial | AdamW con learning rate scheduling | Precisión de validación | 12 horas |

| Optimización Adversarial | Fine-tuning con GAN proxy | AUC-ROC | 8 horas |

| Evaluación Final | Cross-validation | F1-score | 1 hora |

Evaluación de Rendimiento y Métricas Técnicas

La evaluación cuantitativa emplea métricas estándar: precisión, recall, precisión media (mAP) y matriz de confusión para desglosar falsos positivos/negativos. En pruebas con FaceForensics++, un modelo XceptionNet-based alcanza 94.5% de precisión en videos de baja compresión, cayendo a 88% en alta fidelidad, lo que subraya la necesidad de post-procesamiento con ensemble methods (e.g., voting de 5 modelos).

Métricas avanzadas como la distancia de Hausdorff para alineación facial o el índice de similitud estructural (SSIM) validan la detección de artefactos. En escenarios reales, pruebas con datasets como WildDeepfake simulan ruido ambiental, revelando robustez del 82% en condiciones no controladas. Comparativamente, modelos comerciales como Microsoft Video Authenticator logran 90%, pero carecen de personalización open-source.

Desde una óptica regulatoria, informes de evaluación deben alinearse con NIST IR 8269 para sesgos en IA, asegurando equidad across demografías (e.g., tonos de piel variados). Riesgos: adversarial attacks via FGSM (Fast Gradient Sign Method) pueden evadir detección en un 25%, contrarrestados con robustez certificada via PGDL1 bounds.

Implicaciones Operativas y Desafíos en Ciberseguridad

En entornos de ciberseguridad empresarial, estos modelos se integran en SIEM (Security Information and Event Management) systems como Splunk o ELK Stack, alertando sobre deepfakes en comunicaciones internas. Operativamente, requieren actualizaciones periódicas ante evoluciones de GANs, como Diffusion Models en Stable Diffusion 2.0, que generan deepfakes más indetectables.

Desafíos incluyen la computabilidad: entrenamiento en datasets masivos demanda >100 TFLOPS, accesible via cloud providers como Azure ML. Regulatoriamente, la Ley de Seguridad Nacional de EE.UU. (2023) impone reporting de vulnerabilidades en IA, mientras en Latinoamérica, marcos como la Estrategia Nacional de Ciberseguridad de México enfatizan colaboración público-privada.

- Riesgos clave: Escalada de ingeniería social mediante voice deepfakes en llamadas VoIP, potencialmente bypassando autenticación multifactor.

- Beneficios: Reducción de incidentes de desinformación en un 40%, según estudios de MITRE Corporation.

- Mejores prácticas: Adopción de federated learning para privacidad, entrenando modelos distribuidos sin compartir datos crudos.

Blockchain complementa esta detección al timestamping inmutable de medios originales, usando protocolos como IPFS para verificación descentralizada.

Avances Futuros y Tendencias en Detección de Deepfakes

Investigaciones emergentes exploran zero-shot learning con CLIP (Contrastive Language-Image Pretraining), permitiendo detección sin reentrenamiento específico. En ciberseguridad, la integración con quantum computing promete aceleración en FFT para análisis espectral, aunque enfrenta desafíos de decoherencia.

Tendencias incluyen multimodalidad extendida a 3D, detectando deepfakes en realidad aumentada via LiDAR scans. Frameworks como Hugging Face Transformers facilitan prototipado, con modelos preentrenados como DeepFaceLab para baselines. En IT, la adopción en edge AI reduce latencia para aplicaciones en tiempo real, como verificación en videollamadas de Zoom.

Finalmente, el panorama evolutivo demanda colaboración interdisciplinaria, fusionando IA con criptografía para firmas digitales biométricas resistentes a manipulaciones.

Conclusión

El entrenamiento de modelos de IA para detectar deepfakes constituye un pilar esencial en la fortificación de la ciberseguridad digital. A través de arquitecturas robustas, datasets diversificados y optimizaciones avanzadas, estos sistemas no solo identifican manipulaciones con alta precisión, sino que también abordan riesgos sistémicos en un ecosistema interconectado. Si bien persisten desafíos como la adaptación adversarial y consideraciones éticas, los beneficios en términos de integridad informativa y prevención de fraudes superan ampliamente las limitaciones actuales. La implementación estratégica de estas tecnologías, alineada con estándares globales, posiciona a las organizaciones para navegar un futuro donde la autenticidad multimedia es primordial. Para más información, visita la fuente original.