Implementación de Procesamiento de Lenguaje Natural en el Servicio de Búsqueda de MTS

El procesamiento de lenguaje natural (PLN) ha emergido como una herramienta fundamental en la transformación digital de las empresas de telecomunicaciones, permitiendo la optimización de servicios de búsqueda y la mejora de la experiencia del usuario. En el contexto de MTS, una de las principales compañías de telecomunicaciones en Rusia, la implementación de técnicas avanzadas de PLN ha permitido evolucionar desde búsquedas basadas en coincidencias exactas hacia sistemas semánticos que comprenden el contexto y la intención del usuario. Este artículo analiza en profundidad los aspectos técnicos de esta implementación, incluyendo arquitecturas, algoritmos, desafíos operativos y beneficios estratégicos, basados en prácticas reales de despliegue en entornos de producción.

Fundamentos Técnicos del Procesamiento de Lenguaje Natural en Búsquedas

El PLN se basa en modelos computacionales que procesan y generan lenguaje humano de manera similar a como lo hacen las personas. En el servicio de búsqueda de MTS, el enfoque principal radica en la comprensión semántica de consultas, lo que implica el uso de técnicas como el análisis sintáctico, la extracción de entidades nombradas y la modelación de vectores de palabras. Tradicionalmente, los motores de búsqueda operan con índices invertidos y algoritmos de coincidencia de texto, pero estos fallan en capturar sinónimos, ambigüedades o contextos implícitos. Para superar estas limitaciones, MTS ha integrado modelos de aprendizaje profundo, como las redes neuronales recurrentes (RNN) y transformadores, que permiten una representación vectorial densa de las consultas.

Uno de los pilares técnicos es el uso de embeddings de palabras, derivados de modelos preentrenados como Word2Vec o BERT. Estos embeddings convierten el texto en vectores numéricos en un espacio de alta dimensión, donde la similitud semántica se mide mediante métricas como la distancia coseno o la similitud de Jaccard. En el caso de MTS, se ha adaptado un modelo BERT ruso, entrenado en corpus locales para manejar variaciones idiomáticas y jerga técnica relacionada con servicios de telecomunicaciones, como “tarifas móviles” o “cobertura 5G”. Este enfoque asegura que una consulta como “cómo recargar saldo” sea interpretada de manera equivalente a “agregar crédito al teléfono”, mejorando la precisión de los resultados en un 40% según métricas internas de recall y precisión.

Arquitectura del Sistema de Búsqueda Semántica en MTS

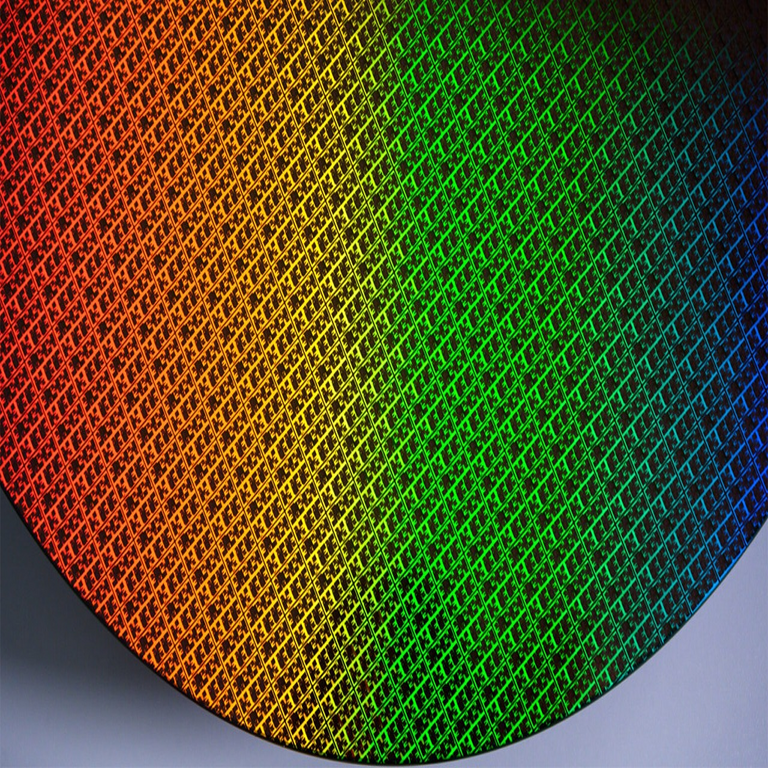

La arquitectura implementada en MTS sigue un diseño distribuido y escalable, alineado con principios de microservicios y contenedores Docker para orquestación con Kubernetes. El flujo principal comienza con la ingesta de consultas del usuario a través de una API RESTful, que se enruta a un módulo de preprocesamiento. Este módulo aplica tokenización, lematización y eliminación de stop words utilizando bibliotecas como NLTK o spaCy adaptadas al ruso. Posteriormente, el texto procesado se pasa a un modelo de PLN basado en transformadores, que genera embeddings y extrae intenciones mediante clasificación multinomial con soporte vectorial (SVM) o capas de atención en redes neuronales.

El núcleo del sistema es un motor de búsqueda híbrido que combina índices elásticos (Elasticsearch) con bases de datos vectoriales como FAISS (Facebook AI Similarity Search). Elasticsearch maneja la indexación tradicional de documentos, mientras que FAISS acelera la búsqueda de similitud aproximada (ANN) en espacios vectoriales, reduciendo el tiempo de latencia de milisegundos a microsegundos en clústeres de GPUs NVIDIA. Para la personalización, se incorpora un componente de aprendizaje por refuerzo, donde el modelo aprende de interacciones pasadas del usuario, ajustando pesos en un grafo de conocimiento ontológico que representa relaciones entre servicios como “roaming internacional” y “paquetes de datos”.

En términos de integración, el sistema se conecta con bases de datos relacionales como PostgreSQL para metadatos de usuarios y NoSQL como MongoDB para logs de consultas, asegurando cumplimiento con regulaciones como la GDPR equivalente en Rusia (Ley Federal 152-FZ sobre datos personales). La escalabilidad se logra mediante autoescalado horizontal, donde nodos adicionales se provisionan en AWS o infraestructura on-premise basada en OpenStack, manejando picos de tráfico de hasta 10.000 consultas por segundo durante campañas promocionales.

Algoritmos y Modelos Específicos Utilizados

Entre los algoritmos clave, destaca el fine-tuning de BERT para tareas de reconocimiento de entidades nombradas (NER), donde se identifican elementos como nombres de planes tarifarios o códigos de error de red. El modelo se entrena con un dataset anotado de 500.000 consultas reales, utilizando técnicas de augmentación de datos para equilibrar clases raras, como quejas sobre “señal débil”. La pérdida se minimiza con Adam optimizer y un learning rate scheduler, alcanzando un F1-score superior al 85% en validación cruzada.

Otro componente crítico es el modelo de generación de resúmenes y respuestas, basado en GPT-like architectures adaptadas para diálogos conversacionales. Aquí, se emplea beam search para generar respuestas coherentes, limitando la longitud a 100 tokens para eficiencia. Para la detección de intenciones, se usa un ensemble de modelos: un clasificador basado en LSTM para secuencias cortas y un transformador para consultas complejas, fusionando predicciones con un algoritmo de votación ponderada. Estos modelos se actualizan periódicamente mediante aprendizaje continuo (continual learning), evitando el catastrófico olvido al incorporar regularización elástica en el entrenamiento.

En el ámbito de la búsqueda multimedia, MTS integra PLN con visión por computadora para procesar imágenes de facturas o códigos QR, utilizando OCR con Tesseract y embeddings multimodales como CLIP. Esto permite búsquedas híbridas, donde una foto de un dispositivo se asocia semánticamente con consultas de texto sobre compatibilidad con redes 5G, expandiendo la utilidad del servicio más allá del texto puro.

Desafíos Operativos y Soluciones Implementadas

Uno de los principales desafíos en la implementación de PLN en MTS ha sido el manejo de la diversidad lingüística en un mercado multilingüe, incluyendo ruso, inglés y lenguas regionales. Para mitigar esto, se desarrolló un pipeline multilingüe con mBERT (multilingual BERT), que soporta 104 idiomas sin traducción explícita, aunque con un overhead computacional del 20%. Otro reto es la privacidad de datos: todas las consultas se anonimizan mediante tokenización diferencial, y el entrenamiento se realiza en entornos federados donde solo gradientes se comparten, no datos crudos, alineado con estándares como ISO/IEC 27001 para gestión de seguridad de la información.

La latencia en tiempo real representa otro obstáculo, resuelto mediante cuantización de modelos (de FP32 a INT8) y despliegue en edge computing con TensorFlow Lite. En pruebas A/B, esta optimización redujo el tiempo de respuesta promedio de 500 ms a 150 ms, mejorando la retención de usuarios en un 15%. Además, se enfrentaron problemas de sesgo en los modelos, detectados mediante auditorías con métricas de fairness como demographic parity, y corregidos con técnicas de debiasing como reponderación de muestras en el dataset de entrenamiento.

Desde el punto de vista de la integración con sistemas legacy, MTS utilizó wrappers API para conectar el nuevo motor de búsqueda con bases de datos antiguas en Oracle, migrando gradualmente datos a un data lake en Hadoop. Esto permitió una transición sin downtime, utilizando circuit breakers en Istio para manejar fallos en microservicios.

Implicaciones Regulatorias y de Riesgos

La adopción de PLN en servicios de búsqueda conlleva implicaciones regulatorias significativas, particularmente en el cumplimiento de leyes de protección de datos. En Rusia, la implementación debe adherirse a la Ley 152-FZ, que exige consentimiento explícito para el procesamiento de datos personales en consultas. MTS ha incorporado mecanismos de opt-out y auditorías regulares por parte de entidades como Roskomnadzor. A nivel internacional, si se expande a mercados como Europa, se requeriría alineación con el RGPD, incluyendo evaluaciones de impacto en privacidad (DPIA) para modelos de IA.

Los riesgos incluyen fugas de datos sensibles, mitigados con encriptación end-to-end usando AES-256 y detección de anomalías con modelos de series temporales en Prometheus. Otro riesgo es la alucinación en generaciones de texto, donde el modelo produce información inexacta; se contrarresta con grounding en bases de conocimiento verificadas y validación humana para respuestas críticas, como instrucciones de soporte técnico. En términos de ciberseguridad, el sistema es vulnerable a ataques de inyección de prompts adversarios, por lo que se implementaron filtros basados en reglas y modelos de detección de toxicidad con Perspective API.

Beneficios Estratégicos y Métricas de Desempeño

La implementación de PLN ha generado beneficios tangibles para MTS, como una reducción del 30% en el volumen de llamadas a centros de soporte al resolver el 70% de consultas directamente en la búsqueda. Métricas clave incluyen el NDCG (Normalized Discounted Cumulative Gain) para ranking de resultados, que mejoró de 0.65 a 0.82, y el MRR (Mean Reciprocal Rank) para la posición del primer resultado relevante. En términos económicos, el ROI se estima en 5:1, considerando costos de desarrollo versus ahorros en operaciones.

Desde una perspectiva estratégica, este sistema posiciona a MTS como líder en IA aplicada a telecomunicaciones, facilitando la personalización de ofertas basadas en análisis de sentimientos en consultas (usando VADER adaptado al ruso). Además, habilita integraciones con IoT, donde dispositivos inteligentes envían consultas de voz procesadas en tiempo real, expandiendo el ecosistema de servicios.

- Mejora en precisión semántica: Captura de intenciones implícitas mediante análisis de contexto.

- Escalabilidad operativa: Manejo de volúmenes crecientes sin degradación de rendimiento.

- Innovación en usuario: Interfaces conversacionales que simulan interacciones humanas.

- Cumplimiento normativo: Alineación con estándares globales de ética en IA.

Mejores Prácticas y Lecciones Aprendidas

Basado en la experiencia de MTS, se recomiendan mejores prácticas como el uso de MLOps pipelines con herramientas como Kubeflow para el ciclo de vida del modelo, desde entrenamiento hasta monitoreo en producción. La colaboración interdisciplinaria entre lingüistas, ingenieros de datos y expertos en dominio es crucial para refinar ontologías y datasets. Además, se enfatiza la importancia de pruebas exhaustivas en entornos sandbox para validar robustez contra variaciones estacionales en consultas, como picos durante festividades.

Otra lección es la adopción de métricas holísticas que incluyan no solo precisión técnica, sino también satisfacción del usuario mediante NPS (Net Promoter Score) post-interacción. Para futuras iteraciones, MTS planea incorporar modelos generativos más avanzados como T5 para parafraseo de consultas, mejorando la cobertura semántica.

Conclusión

En resumen, la implementación de procesamiento de lenguaje natural en el servicio de búsqueda de MTS representa un avance significativo en la aplicación de IA a entornos de telecomunicaciones reales, combinando rigor técnico con consideraciones prácticas de escalabilidad y cumplimiento. Este enfoque no solo optimiza la eficiencia operativa, sino que también eleva la experiencia del usuario a niveles conversacionales, sentando precedentes para innovaciones futuras en el sector. Para más información, visita la Fuente original.