Implementación de un Clúster de Kubernetes en Proveedores de VPS: Una Guía Técnica Detallada

Introducción a Kubernetes y su Relevancia en Entornos de VPS

Kubernetes, comúnmente abreviado como K8s, representa un sistema de orquestación de contenedores de código abierto que facilita la automatización del despliegue, escalado y gestión de aplicaciones en contenedores. Desarrollado originalmente por Google y ahora mantenido por la Cloud Native Computing Foundation (CNCF), Kubernetes ha evolucionado para convertirse en un estándar de facto en la industria de la computación en la nube. En el contexto de proveedores de servicios de VPS (Virtual Private Server), la implementación de un clúster de Kubernetes ofrece ventajas significativas, como la flexibilidad en la asignación de recursos, costos predecibles y control granular sobre la infraestructura subyacente.

Los VPS proporcionan servidores virtuales dedicados en un entorno multiinquilino, lo que permite a las organizaciones desplegar clústeres de Kubernetes sin la complejidad de infraestructuras on-premise o la dependencia total de proveedores de nube pública. Sin embargo, esta implementación requiere una comprensión profunda de conceptos como la red, el almacenamiento persistente y la seguridad. Este artículo explora los aspectos técnicos clave para configurar un clúster de Kubernetes en un VPS, enfocándose en protocolos como Container Network Interface (CNI), el uso de herramientas como kubeadm y consideraciones de ciberseguridad inherentes a entornos virtualizados.

Desde una perspectiva técnica, Kubernetes opera mediante un plano de control (control plane) que incluye componentes como el API server, el scheduler y el controller manager, junto con nodos worker que ejecutan los pods. En VPS, estos componentes se distribuyen a través de instancias virtuales, lo que demanda una configuración precisa para garantizar alta disponibilidad y resiliencia. Según datos de la CNCF, más del 70% de las organizaciones que adoptan Kubernetes lo integran con infraestructuras híbridas, incluyendo VPS, para optimizar costos operativos.

Requisitos Previos para la Implementación

Antes de proceder con la implementación, es esencial verificar los requisitos de hardware y software. Un clúster mínimo de Kubernetes requiere al menos tres nodos VPS: uno para el master (control plane) y dos para workers, aunque se recomienda un mínimo de cinco para producción. Cada VPS debe disponer de al menos 2 GB de RAM, 2 vCPUs y 20 GB de almacenamiento SSD, con un sistema operativo compatible como Ubuntu 20.04 LTS o CentOS 8.

En términos de software, se necesita Docker o containerd como runtime de contenedores, versión 1.20 o superior de Kubernetes, y herramientas como kubeadm para la inicialización del clúster. Además, los VPS deben configurarse con firewalls que permitan tráfico en puertos específicos: 6443 para el API server, 10250 para kubelet y rangos de puertos para servicios como 30000-32767 en modo NodePort. La red subyacente debe soportar IPv4 y preferentemente IPv6, con un ancho de banda mínimo de 1 Gbps para evitar latencias en la comunicación entre nodos.

- Sistema operativo: Distribución Linux estable, con kernel 4.15 o superior para soporte de cgroups v2.

- Redes: Acceso a internet para descargar imágenes de contenedores desde registries como Docker Hub o Quay.io.

- Almacenamiento: Soporte para volúmenes persistentes, idealmente mediante proveedores de VPS que integren con CSI (Container Storage Interface) drivers.

- Seguridad inicial: Claves SSH para acceso sin contraseña entre nodos y deshabilitación de swap para cumplir con las mejores prácticas de Kubernetes.

Estos requisitos aseguran que el clúster pueda manejar cargas de trabajo distribuidas, minimizando riesgos de fallos en el plano de control. En entornos de VPS, es crucial seleccionar proveedores que ofrezcan aislamiento de hipervisores, como KVM o Xen, para mitigar vulnerabilidades de multiinquilinación.

Pasos Detallados para la Configuración del Clúster

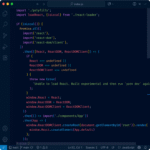

La implementación comienza con la preparación de los nodos. En el nodo master, actualice el sistema e instale dependencias esenciales mediante comandos como apt update && apt install -y docker.io kubelet kubeadm kubectl en Ubuntu. Deshabilite el swap con swapoff -a y edite /etc/fstab para persistir esta configuración. Inicialice el clúster usando kubeadm: kubeadm init --pod-network-cidr=10.244.0.0/16, donde el CIDR especifica la red de pods para el plugin Flannel o Calico.

Una vez inicializado, obtenga el token de unión para los nodos worker: kubeadm join <IP-master>:6443 --token <token> --discovery-token-ca-cert-hash sha256:<hash>. En los workers, ejecute este comando para unirse al clúster. Para la red, instale un CNI plugin; por ejemplo, Flannel se despliega con kubectl apply -f https://raw.githubusercontent.com/flannel-io/flannel/master/Documentation/kube-flannel.yml. Este plugin proporciona superposición de red L2 sobre L3, facilitando la comunicación entre pods en diferentes nodos VPS.

La configuración de etcd, el almacén distribuido de Kubernetes, es crítica. En clústeres pequeños, etcd se ejecuta en el master, pero para alta disponibilidad, distribúyalo en múltiples nodos usando stacked topology. Asegúrese de que etcd escuche en interfaces seguras y use certificados TLS generados por kubeadm. Monitoree el estado con kubectl get nodes y kubectl get pods --all-namespaces para verificar la salud del clúster.

En cuanto al almacenamiento, integre un provisioner como NFS o Longhorn para volúmenes persistentes. Longhorn, por instancia, ofrece replicación síncrona y snapshots, compatible con CSI, lo que permite a las aplicaciones stateful como bases de datos PostgreSQL mantener datos duraderos en VPS. Configure clases de almacenamiento con kind: StorageClass en YAML manifests, especificando parámetros como replicación y tamaño mínimo.

Para escalabilidad, habilite el Horizontal Pod Autoscaler (HPA) mediante métricas de la API de Kubernetes. Instale Metrics Server con kubectl apply -f https://github.com/kubernetes-sigs/metrics-server/releases/latest/download/components.yaml, y defina autoscalers basados en CPU utilization thresholds, como 50% para pods de aplicaciones web.

Consideraciones de Seguridad en Clústeres de Kubernetes sobre VPS

La ciberseguridad es paramount en implementaciones de Kubernetes, especialmente en VPS donde el aislamiento no es tan robusto como en nubes dedicadas. Implemente RBAC (Role-Based Access Control) para limitar permisos: cree roles con apiGroups: [""] resources: ["pods"] verbs: ["get", "list"] y asigne bindings a usuarios o service accounts. Use Network Policies con Calico para restringir tráfico entre pods, definiendo reglas como podSelector: matchLabels: app: frontend para denegar accesos no autorizados.

Proteja el API server con autenticación mutua TLS y habilite Pod Security Policies (PSP) o Pod Security Admission (PSA) en versiones recientes para enforzar políticas como no-root containers y read-only root filesystems. En VPS, configure firewalls como UFW o firewalld para exponer solo puertos necesarios, y use herramientas como Falco para detección de anomalías en runtime, alertando sobre accesos privilegiados o mounts inesperados.

Para secretos, evite hardcoding con Secrets objects en etcd, cifrados con envelope encryption usando KMS providers si el VPS soporta integración con servicios como Vault. Realice auditorías regulares con kube-bench, basado en el benchmark CIS Kubernetes, para validar compliance. En entornos multiinquilino de VPS, implemente namespaces para aislamiento lógico y monitoree con Prometheus y Grafana para detectar patrones de ataque como DDoS o escaladas de privilegios.

- Autenticación: Integre con OAuth providers como Keycloak para acceso federado.

- Encriptación: Use mTLS para todo el tráfico interno y exponga servicios con Ingress controllers como NGINX, configurados con certificados Let’s Encrypt.

- Actualizaciones: Aplique parches de seguridad mediante rolling updates, minimizando downtime con

strategy: type: RollingUpdate maxUnavailable: 25%.

Estas medidas mitigan riesgos como el image vulnerability scanning, recomendando herramientas como Trivy para escanear imágenes antes del despliegue. En VPS, la segmentación de red VLAN o SDN (Software-Defined Networking) del proveedor reduce la superficie de ataque.

Monitoreo y Mantenimiento del Clúster

El monitoreo es esencial para la operatividad continua. Despliegue Prometheus como operador en el clúster, configurando scrape configs para métricas de kubelet y etcd. Integre Alertmanager para notificaciones vía Slack o email en umbrales como CPU > 80%. Grafana proporciona dashboards visuales para métricas como latencia de pods y throughput de red.

Para logging, use EFK stack (Elasticsearch, Fluentd, Kibana) o Loki para agregación centralizada. Fluentd como daemonset recolecta logs de contenedores, indexándolos en Elasticsearch para queries avanzadas. En VPS, configure persistencia de logs en volúmenes externos para evitar pérdida de datos durante reinicios.

El mantenimiento incluye backups regulares de etcd con etcdctl snapshot save y pruebas de disaster recovery mediante chaos engineering con herramientas como Chaos Mesh. Escala el clúster dinámicamente agregando nodos con kubeadm join y ajustando taints/tolerations para workloads específicos.

| Componente | Herramienta de Monitoreo | Métricas Clave |

|---|---|---|

| Plano de Control | Prometheus | API server requests/sec, etcd latency |

| Nodos Worker | Node Exporter | CPU/Memory usage, disk I/O |

| Red | Calico Operator | Packet drops, bandwidth utilization |

Esta tabla resume componentes críticos y sus métricas, facilitando una supervisión proactiva. En producción, integre con SIEM systems para correlacionar eventos de seguridad.

Implicaciones Operativas y Mejores Prácticas

Operativamente, un clúster de Kubernetes en VPS reduce la latencia geográfica al desplegar en data centers cercanos, pero introduce desafíos como la gestión de IP flotantes para alta disponibilidad. Use load balancers del proveedor VPS para distribuir tráfico al Ingress, configurado con annotations como nginx.ingress.kubernetes.io/ssl-redirect: "true".

Desde el punto de vista regulatorio, cumpla con estándares como GDPR o HIPAA mediante políticas de data residency en VPS localizados. Los beneficios incluyen costos 30-50% inferiores a nubes públicas para cargas moderadas, según benchmarks de CNCF, pero requieren expertise en DevOps para CI/CD pipelines con ArgoCD o Flux.

Mejores prácticas incluyen la adopción de GitOps para declaraciones de infraestructura, testing con kind o minikube en entornos de desarrollo, y migración gradual desde Docker Compose. En ciberseguridad, realice pentests regulares enfocados en supply chain attacks, como compromisos en registries.

Conclusiones y Recomendaciones Finales

La implementación de un clúster de Kubernetes en proveedores de VPS democratiza el acceso a orquestación de contenedores, ofreciendo escalabilidad y resiliencia a organizaciones de todos tamaños. Al seguir los pasos detallados, desde la inicialización con kubeadm hasta la integración de seguridad y monitoreo, se logra un entorno robusto que soporta aplicaciones modernas. Sin embargo, el éxito depende de una planificación meticulosa, considerando limitaciones de VPS como recursos compartidos y la necesidad de actualizaciones manuales.

Para maximizar beneficios, evalúe proveedores como DigitalOcean o Linode que ofrecen Kubernetes managed, pero para control total, la aproximación DIY descrita es ideal. En resumen, Kubernetes transforma la gestión de infraestructuras en VPS, impulsando innovación en IA y blockchain mediante despliegues eficientes y seguros. Para más información, visita la fuente original.