Desarrollo de un Asistente de Inteligencia Artificial Basado en la API de Grok: Análisis Técnico y Aplicaciones en Ciberseguridad

Introducción al Ecosistema de la API de Grok

La inteligencia artificial generativa ha transformado el panorama tecnológico, permitiendo la creación de asistentes virtuales que procesan lenguaje natural con alta eficiencia. En este contexto, la API de Grok, desarrollada por xAI, emerge como una herramienta poderosa para integrar capacidades de IA en aplicaciones personalizadas. Este artículo analiza el proceso de desarrollo de un asistente IA inicial utilizando esta API, enfocándose en aspectos técnicos clave como la autenticación, el procesamiento de consultas, la gestión de tokens y las implicaciones en ciberseguridad. Basado en experiencias prácticas de implementación, se exploran los conceptos fundamentales para profesionales en tecnologías emergentes.

La API de Grok se basa en modelos de lenguaje grandes (LLM) optimizados para respuestas contextuales y creativas, similar a otros frameworks como GPT de OpenAI, pero con énfasis en la integración fluida con ecosistemas de xAI. Para iniciar el desarrollo, es esencial comprender la arquitectura subyacente: un endpoint RESTful que maneja solicitudes HTTP POST con payloads en formato JSON, incluyendo parámetros como el prompt del usuario, el modelo seleccionado (por ejemplo, grok-1) y límites de temperatura para controlar la variabilidad de las respuestas.

Configuración Inicial y Autenticación en la API

El primer paso en la creación de un asistente IA involucra la obtención de credenciales de acceso. La API requiere una clave API generada a través del portal de desarrolladores de xAI, que actúa como token de autenticación Bearer en los headers de las solicitudes HTTP. Esta clave debe manejarse de manera segura, utilizando variables de entorno en entornos de desarrollo para evitar exposiciones en código fuente, alineándose con mejores prácticas de seguridad como las recomendadas por OWASP para el manejo de secretos.

Una vez configurada, la autenticación se implementa mediante bibliotecas como requests en Python. Un ejemplo básico de solicitud implica el siguiente flujo:

- Importar la biblioteca y definir la URL base:

https://api.x.ai/v1/chat/completions. - Construir el header con

Authorization: Bearer {API_KEY}. - Definir el payload JSON con claves como

model,messages(un array de objetos con rol y contenido) ymax_tokenspara limitar la longitud de la respuesta. - Enviar la solicitud y procesar la respuesta JSON, extrayendo el campo

choices[0].message.content.

Esta estructura asegura interoperabilidad con estándares web, facilitando la escalabilidad. En términos de rendimiento, las solicitudes típicas tardan entre 200 ms y 2 segundos, dependiendo del tamaño del prompt y la carga del servidor, lo que resalta la importancia de implementar mecanismos de reintentos con backoff exponencial para manejar errores transitorios como rate limiting (por ejemplo, 100 solicitudes por minuto en tiers gratuitos).

Procesamiento de Consultas y Gestión de Contextos

El núcleo del asistente radica en el manejo de conversaciones multi-turno. La API de Grok soporta contextos persistentes mediante el mantenimiento de un historial de mensajes en el array messages, donde cada entrada alterna entre roles “user” y “assistant”. Esto permite al modelo recordar interacciones previas, mejorando la coherencia en diálogos extendidos. Sin embargo, el contexto está limitado por el ventana de tokens del modelo, típicamente 8.192 tokens para grok-1, lo que requiere estrategias de truncado o summarización para sesiones largas.

Desde una perspectiva técnica, el conteo de tokens se realiza implícitamente por el servidor, pero para optimización local, se pueden emplear bibliotecas como tiktoken (adaptada para Grok) para predecir costos. Cada token representa aproximadamente 4 caracteres en inglés, influyendo en el pricing: alrededor de $0.0005 por 1.000 tokens de entrada en planes estándar. En aplicaciones de ciberseguridad, esta capacidad se aplica en chatbots para análisis de logs, donde el asistente interpreta patrones de tráfico sospechoso, clasificando anomalías basadas en descripciones textuales.

Adicionalmente, parámetros como temperature (0 para respuestas determinísticas, 1 para creativas) y top_p (muestreo nucleus) permiten fine-tuning del comportamiento. En escenarios de IA ética, se recomienda valores bajos para tareas críticas, reduciendo alucinaciones donde el modelo genera información inexacta.

Integración con Frameworks y Herramientas de Desarrollo

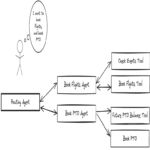

Para extender la funcionalidad, la API se integra fácilmente con frameworks como LangChain o LlamaIndex, que abstraen la gestión de cadenas de prompts y retrieval-augmented generation (RAG). En un asistente básico, LangChain facilita la creación de agentes que combinan la API de Grok con herramientas externas, como búsquedas web vía APIs de Google o bases de datos vectoriales para almacenamiento de conocimiento.

Consideremos una implementación en Python con Streamlit para una interfaz web simple:

- Instalar dependencias:

pip install streamlit requests langchain. - Definir una función para invocar la API, encapsulando la lógica de autenticación y manejo de errores.

- En el script principal, crear un chat interface que appendee mensajes al historial y refresque la UI en tiempo real.

- Implementar persistencia usando session_state de Streamlit para mantener el contexto entre interacciones.

Esta aproximación no solo acelera el prototipado sino que incorpora validaciones de entrada, como sanitización de prompts para prevenir inyecciones de prompt que podrían explotar vulnerabilidades en el modelo, un riesgo clave en ciberseguridad de IA.

Implicaciones en Ciberseguridad y Mejores Prácticas

El desarrollo de asistentes IA introduce vectores de ataque únicos. La exposición de la clave API en código cliente-side representa un riesgo de filtración, mitigado mediante proxies backend o servicios como AWS Secrets Manager. Además, los prompts adversarios pueden manipular el modelo para revelar datos sensibles, contraviniendo regulaciones como GDPR o la Ley de IA de la UE, que exigen transparencia en procesamiento de datos personales.

En términos de privacidad, la API de Grok procesa datos en servidores de xAI, lo que implica revisión de términos de servicio para compliance con estándares como ISO 27001. Para mitigar riesgos, se aplican técnicas como differential privacy en prompts agregados o fine-tuning local si se accede a modelos open-source derivados. Un análisis de amenazas típico incluye:

- Inyecciones de Prompt: Ataques donde usuarios maliciosos insertan instrucciones para bypass filtros, resuelto con validación regex y capas de moderación pre-API.

- Rate Limiting y DoS: Explotación de límites para denegar servicio, contrarrestado con caching de respuestas comunes usando Redis.

- Filtración de Datos: El modelo podría inferir información de contextos previos, requiriendo anonimización en historiales.

En blockchain y tecnologías distribuidas, la integración de Grok API con smart contracts (vía oráculos) habilita asistentes para auditorías automatizadas de transacciones, detectando fraudes en redes como Ethereum mediante análisis semántico de eventos logueados.

Aplicaciones Prácticas en Inteligencia Artificial y Tecnologías Emergentes

Más allá del asistente básico, la API de Grok se aplica en dominios como la ciberseguridad proactiva. Por ejemplo, en sistemas de detección de intrusiones (IDS), el asistente procesa alertas de herramientas como Snort o Suricata, generando resúmenes accionables y recomendaciones basadas en bases de conocimiento actualizadas. Esto reduce el tiempo de respuesta de analistas, alineándose con marcos como NIST Cybersecurity Framework.

En IA, se explora el uso en generación de código seguro: el asistente puede revisar snippets para vulnerabilidades comunes (OWASP Top 10), sugiriendo parches. Un caso de estudio involucra la integración con GitHub Actions para CI/CD, donde hooks pre-commit invocan la API para escanear commits en busca de patrones riesgosos, como hard-coded secrets.

Respecto a blockchain, la API facilita oráculos IA para DeFi, prediciendo volatilidades de precios mediante prompts que analizan datos on-chain. Protocolos como Chainlink podrían extenderse con Grok para consultas naturales en dApps, mejorando la usabilidad sin comprometer la inmutabilidad.

En noticias de IT, recientes avances en Grok API incluyen soporte para vision models, permitiendo procesamiento de imágenes en asistentes multimodales. Esto abre puertas a aplicaciones en forensics digital, donde se analizan capturas de malware para identificar firmas visuales.

Optimización de Rendimiento y Escalabilidad

Para deployments a escala, se considera la latencia y costos. Implementar colas de mensajes con Celery en backend distribuye cargas, mientras que monitoring con Prometheus rastrea métricas como tokens consumidos por sesión. En entornos cloud, AWS Lambda o Google Cloud Functions hostean endpoints proxy, escalando automáticamente.

Una tabla comparativa de parámetros clave ilustra optimizaciones:

| Parámetro | Valor Típico | Impacto en Rendimiento | Mejor Práctica en Ciberseguridad |

|---|---|---|---|

| max_tokens | 1024 | Limita longitud, reduce latencia | Evita respuestas excesivas que diluyan foco en alertas |

| temperature | 0.7 | Equilibra creatividad y precisión | Valores bajos para análisis factuales |

| frequency_penalty | 0.0 | Controla repeticiones | Previene loops en diálogos de troubleshooting |

Estas configuraciones aseguran eficiencia, con pruebas de carga recomendando al menos 95% de solicitudes bajo 1 segundo.

Desafíos Éticos y Regulatorios

El uso de IA generativa plantea dilemas éticos, como sesgos inherentes en datos de entrenamiento. Para Grok, xAI enfatiza alineación con valores humanos, pero desarrolladores deben auditar outputs para fairness, usando métricas como BLEU o ROUGE adaptadas a español. Regulatoriamente, en Latinoamérica, leyes como la LGPD en Brasil exigen consentimiento explícito para procesamiento IA, impactando diseños de asistentes que manejan datos sensibles.

En ciberseguridad, el riesgo de deepfakes generados vía prompts extensos requiere filtros integrados, alineados con estándares como MITRE ATLAS para amenazas adversarias en IA.

Conclusión: Hacia Futuros Avances en Asistentes IA Seguros

El desarrollo de un asistente basado en la API de Grok demuestra la accesibilidad de la IA avanzada para profesionales, con énfasis en integración técnica robusta y consideraciones de seguridad. Al abordar desafíos como autenticación segura y manejo de prompts adversarios, se pavimenta el camino para aplicaciones innovadoras en ciberseguridad, blockchain e IT. Finalmente, la evolución continua de esta API promete mayor eficiencia y ética, impulsando adopción en entornos empresariales. Para más información, visita la Fuente original.