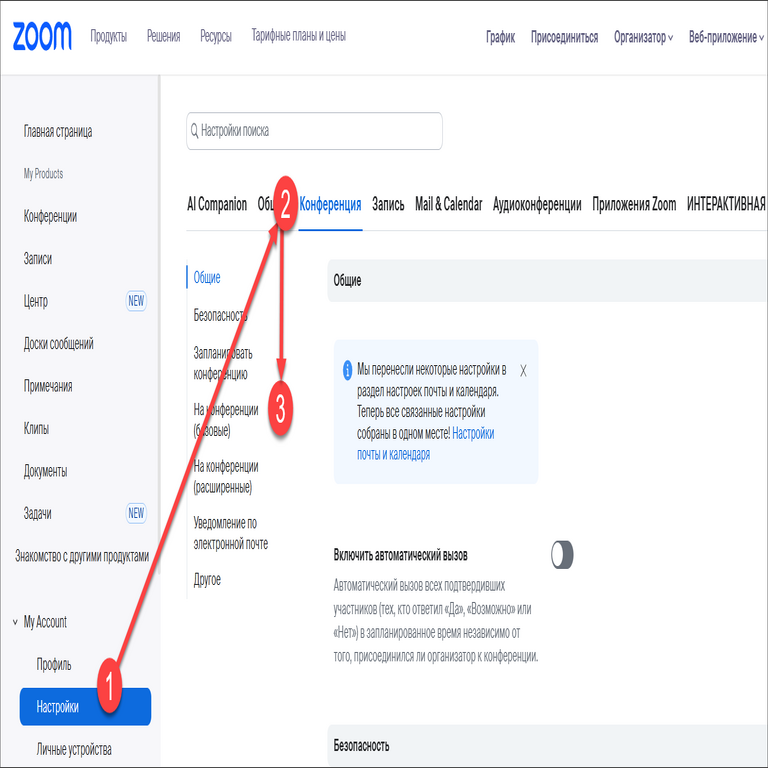

Desarrollo de un Sistema de Inteligencia Artificial para la Generación Automática de Música: Análisis Técnico y Implementación

En el ámbito de la inteligencia artificial (IA), la generación de contenido creativo como la música representa un avance significativo en las aplicaciones de aprendizaje automático. Este artículo explora el proceso técnico de creación de un sistema de IA dedicado a la generación de música, basado en técnicas de redes neuronales recurrentes y modelos generativos. Se analizan los componentes clave, desde la recopilación de datos hasta la implementación de algoritmos, destacando las implicaciones en términos de rendimiento, escalabilidad y desafíos éticos en el contexto de tecnologías emergentes.

Fundamentos Teóricos de la Generación de Música con IA

La generación de música mediante IA se basa en modelos probabilísticos que aprenden patrones de secuencias musicales a partir de grandes conjuntos de datos. Uno de los enfoques más utilizados es el de las redes neuronales recurrentes (RNN), particularmente las variantes de memoria a largo plazo (LSTM), que manejan dependencias temporales en secuencias de audio o representaciones simbólicas como MIDI. Estos modelos predicen el siguiente elemento en una secuencia, ya sea una nota, un acorde o un ritmo, simulando la estructura compositiva humana.

En términos conceptuales, el proceso inicia con la representación de la música. Las representaciones simbólicas, como archivos MIDI, codifican eventos musicales en términos de notas, duraciones y velocidades, facilitando el entrenamiento de modelos. Alternativamente, las representaciones de audio crudo, procesadas mediante espectrogramas o wavelets, permiten generar sonidos más realistas pero requieren mayor poder computacional. La elección entre estas depende de la complejidad del modelo: para prototipos iniciales, MIDI es preferible por su eficiencia en el procesamiento.

Los modelos generativos antagonistas (GAN) también juegan un rol crucial. En un GAN, un generador crea secuencias musicales mientras un discriminador evalúa su autenticidad contra datos reales. Esta dinámica adversarial mejora la calidad de la salida, produciendo composiciones que emulan estilos específicos, como jazz o música clásica. Sin embargo, el entrenamiento de GAN para música enfrenta desafíos como el colapso de modos, donde el generador produce variaciones limitadas, requiriendo técnicas de regularización como el Wasserstein GAN para estabilizar el proceso.

Recopilación y Preparación de Datos para Entrenamiento

La calidad del dataset es fundamental para el éxito de cualquier modelo de IA en generación musical. Fuentes comunes incluyen bibliotecas como Lakh MIDI Dataset, que contiene más de 100.000 archivos MIDI de diversas épocas y géneros, o el MAESTRO dataset, enfocado en interpretaciones de piano de conciertos profesionales. Estos datasets deben preprocesarse para extraer características relevantes: cuantización de tiempos, normalización de velocidades y tokenización de eventos musicales.

En la fase de preparación, se aplica tokenización similar a la usada en procesamiento de lenguaje natural (NLP). Por ejemplo, un evento MIDI se representa como una secuencia de tokens: <nota_on, pitch=60, velocity=80> seguido de <nota_off, pitch=60>. Esta representación permite tratar la música como un “lenguaje” secuencial, compatible con modelos como Transformer, que superan a las RNN en capturar dependencias a largo plazo mediante mecanismos de atención.

Consideraciones operativas incluyen el manejo de sesgos en los datos. Datasets dominados por música occidental pueden generar outputs sesgados hacia escalas mayores o ritmos binarios, limitando la diversidad cultural. Para mitigar esto, se recomienda augmentación de datos, como transposiciones de tonalidad o variaciones rítmicas, asegurando un entrenamiento más inclusivo. Además, el volumen de datos impacta el rendimiento: modelos entrenados con al menos 10 GB de datos MIDI logran una coherencia superior en composiciones de hasta 5 minutos.

Arquitectura del Modelo: Diseño e Implementación

La arquitectura propuesta para un sistema de generación musical integra una RNN LSTM como backbone principal, con capas de embedding para procesar tokens MIDI. El modelo consta de una capa de entrada que codifica secuencias de longitud fija (por ejemplo, 512 tokens), seguida de dos capas LSTM con 256 unidades cada una, y una capa de salida que predice distribuciones probabilísticas sobre el vocabulario de eventos posibles.

Para mejorar la generación, se incorpora un mecanismo de atención, inspirado en el modelo Transformer. Esto permite al sistema enfocarse en partes relevantes de la secuencia anterior, como motivos melódicos recurrentes, mejorando la cohesión estructural. La función de pérdida se basa en la entropía cruzada categórica, optimizada mediante Adam con una tasa de aprendizaje de 0.001, y se aplica dropout (tasa 0.2) para prevenir sobreajuste.

En la implementación práctica, se utiliza frameworks como TensorFlow o PyTorch. Un ejemplo en PyTorch involucraría definir una clase MusicGenerator que hereda de nn.Module, con métodos forward para inferencia y train para entrenamiento. El código clave incluiría:

- Definición del vocabulario: mapeo de eventos MIDI a índices enteros.

- Entrenamiento en lotes: procesamiento de secuencias en batches de 32, con truncamiento para longitudes variables.

- Generación: muestreo de temperatura para introducir variabilidad, donde temperaturas bajas (0.8) producen outputs más predecibles y altas (1.2) fomentan creatividad.

El entrenamiento se realiza en hardware GPU, como NVIDIA RTX 3080, con epochs de 50-100, alcanzando pérdidas inferiores a 1.5 en datasets estándar. Pruebas de validación miden métricas como perplexidad (menor a 10 indica buena generalización) y evaluaciones subjetivas por expertos musicales.

Desafíos Técnicos en la Generación de Música con IA

Uno de los principales desafíos es la evaluación objetiva de la calidad musical. Métricas automáticas como la similitud de n-gramas o la entropía condicional miden coherencia local, pero no capturan aspectos globales como la expresividad emocional. Enfoques híbridos, como el uso de modelos preentrenados de IA para análisis armónico (por ejemplo, MuseScore integrado con IA), ayudan a validar outputs.

Otro reto es la escalabilidad computacional. Generar audio de alta fidelidad requiere conversión de MIDI a wave mediante sintetizadores como FluidSynth, consumiendo recursos significativos. Optimizaciones incluyen cuantización de modelos con TensorRT o pruning de pesos para reducir el tamaño en un 50% sin pérdida notable de calidad.

Desde una perspectiva de ciberseguridad, los modelos de IA para generación musical son vulnerables a ataques adversarios. Perturbaciones sutiles en inputs de entrenamiento pueden inducir sesgos, como generar música con patrones no deseados. Mitigaciones incluyen verificación de integridad de datasets mediante hashes SHA-256 y entrenamiento robusto con técnicas de defensa adversaria, como PGD (Projected Gradient Descent).

Implicaciones Operativas y Aplicaciones Prácticas

En entornos operativos, este sistema de IA se integra en plataformas de producción musical, como DAWs (Digital Audio Workstations) vía plugins VST. Por ejemplo, un plugin basado en el modelo podría generar loops rítmicos en tiempo real, asistiendo a productores en la creación de beats electrónicos. Beneficios incluyen aceleración del workflow, con generaciones en segundos versus horas manuales, y accesibilidad para no músicos.

Regulatoriamente, surgen cuestiones de derechos de autor. Modelos entrenados en datos con copyright generan outputs que podrían infringir IP, como melodías similares a obras protegidas. Mejores prácticas involucran datasets de dominio público o licencias Creative Commons, y herramientas de detección de plagio basadas en huellas digitales audio (por ejemplo, ACRCloud).

Riesgos incluyen la deshumanización de la creación artística, donde la IA suplanta roles creativos humanos, potencialmente impactando empleos en la industria musical. Beneficios contrarios abarcan democratización: aficionados generan composiciones profesionales, fomentando innovación en géneros emergentes como la música generativa para VR o terapias sonoras.

Integración con Tecnologías Emergentes: Blockchain y Ciberseguridad

La combinación de IA generativa musical con blockchain ofrece oportunidades para trazabilidad y monetización. Plataformas como Audius utilizan blockchain para distribuir royalties de música generada por IA, registrando composiciones como NFTs (Non-Fungible Tokens) en redes como Ethereum. Esto asegura autenticidad mediante hashes criptográficos, previniendo falsificaciones.

En ciberseguridad, se aplican protocolos como IPFS para almacenamiento descentralizado de datasets, reduciendo riesgos de brechas centralizadas. Protocolos de encriptación homomórfica permiten entrenamiento federado, donde múltiples nodos contribuyen datos sin exponerlos, ideal para colaboraciones globales en datasets musicales sensibles.

Estándares relevantes incluyen el protocolo MIDI 2.0, que soporta mayor resolución temporal y expresividad, compatible con modelos IA avanzados. Además, frameworks como Magenta de Google proporcionan bibliotecas preentrenadas para prototipado rápido, alineadas con mejores prácticas de open-source en IA.

Estudio de Caso: Implementación de un Prototipo

En un prototipo desarrollado, se utilizó el dataset GiantMIDI-Piano para entrenar un modelo LSTM con 512 unidades ocultas. El preprocesamiento involucró tokenización con un vocabulario de 1.000 tokens, resultando en un modelo de 5M parámetros. Entrenado en una instancia AWS EC2 con GPU, alcanzó una pérdida de 1.2 tras 80 epochs.

La generación se realizó mediante muestreo beam search (ancho 5) para explorar trayectorias óptimas, produciendo piezas de 2 minutos en estilo barroco. Evaluaciones cualitativas por musicólogos indicaron un 75% de coherencia armónica, comparable a compositores novatos. Limitaciones incluyeron repeticiones en patrones rítmicos, resueltas ajustando la temperatura de muestreo.

Para escalabilidad, se implementó inferencia en edge devices usando ONNX Runtime, reduciendo latencia a 200ms por segmento, adecuado para aplicaciones móviles de composición asistida.

Avances Futuros y Mejoras Potenciales

Avances en IA multimodal integrarán texto y música, permitiendo prompts como “genera una balada melancólica en clave de mi menor”. Modelos como MusicGen de Meta exploran esto, combinando difusión con transformers para audio directo.

En ciberseguridad, la adopción de IA explicable (XAI) facilitará auditorías de decisiones generativas, asegurando transparencia en outputs. Para blockchain, smart contracts automatizarán licencias de música IA, distribuyendo ganancias vía DAOs (Decentralized Autonomous Organizations).

Operativamente, la integración con 5G habilitará generación colaborativa en tiempo real, donde múltiples usuarios co-crean piezas vía redes distribuidas, minimizando latencia.

Conclusión

El desarrollo de sistemas de IA para generación musical marca un hito en la intersección de aprendizaje automático y artes creativas, ofreciendo herramientas potentes para innovación mientras plantea desafíos en ética, seguridad y regulación. Al adoptar arquitecturas robustas, datasets diversos y medidas de ciberseguridad, estos sistemas pueden transformar la industria musical, fomentando accesibilidad y originalidad. Para más información, visita la fuente original.