Cómo la Computación Acelerada Resuelve los Mayores Desafíos de la Computación Cuántica

Introducción a la Computación Cuántica y sus Desafíos Fundamentales

La computación cuántica representa uno de los avances más prometedores en el ámbito de la tecnología emergente, con el potencial de revolucionar campos como la criptografía, la simulación molecular y la optimización compleja. Sin embargo, su desarrollo enfrenta obstáculos significativos que han impedido su adopción a gran escala. Entre estos desafíos se encuentran el ruido cuántico, la escalabilidad de los qubits y la complejidad computacional inherente a la simulación de sistemas cuánticos en hardware clásico. En este contexto, la computación acelerada, impulsada por unidades de procesamiento gráfico (GPUs) y frameworks especializados, emerge como una solución clave para superar estas barreras.

La computación cuántica se basa en principios fundamentales de la mecánica cuántica, como la superposición y el entrelazamiento, que permiten procesar información de manera paralela y exponencialmente más eficiente que los sistemas clásicos para ciertos problemas. No obstante, los sistemas cuánticos actuales son propensos a errores debido a la decoherencia, un fenómeno donde los estados cuánticos se pierden por interacciones con el entorno. Según estimaciones de la industria, para lograr una ventaja cuántica práctica, se requieren millones de qubits lógicos con tasas de error inferiores a 10^-15, un umbral que los prototipos actuales, con cientos de qubits físicos ruidosos, aún no alcanzan.

La simulación cuántica en hardware clásico tradicional, utilizando computadoras de propósito general, resulta ineficiente para sistemas grandes debido al crecimiento exponencial en la dimensionalidad del espacio de Hilbert. Por ejemplo, simular un sistema de n qubits requiere un espacio de memoria de 2^n dimensiones complejas, lo que para n=50 ya excede los límites de las supercomputadoras convencionales. Aquí es donde la computación acelerada, particularmente con GPUs de alto rendimiento, ofrece una aceleración drástica mediante paralelismo masivo y optimizaciones específicas para álgebra lineal cuántica.

Los Principales Desafíos en la Computación Cuántica

Uno de los mayores retos en la computación cuántica es el manejo del ruido y la corrección de errores. Los qubits, ya sean superconductores, iónicos o basados en fotones, sufren decoherencia en escalas de tiempo milisegundos o menos, lo que limita la profundidad de los circuitos cuánticos ejecutables. La corrección de errores cuánticos (QEC) requiere códigos como el código de superficie de Steane o el código de Shor, que demandan un overhead significativo: por cada qubit lógico, se necesitan miles de qubits físicos para redundancia y medición de síndromes.

Otro desafío clave es la escalabilidad. Construir hardware cuántico estable a temperaturas cercanas al cero absoluto y con control preciso de interacciones es costoso y técnicamente demandante. Empresas como IBM y Google han demostrado supremacía cuántica en tareas específicas, pero estas victorias son limitadas a problemas artificialmente construidos. Para aplicaciones reales, como la factorización de números grandes mediante el algoritmo de Shor o la simulación de moléculas para descubrimiento de fármacos vía el algoritmo de variational quantum eigensolver (VQE), se necesitan sistemas fault-tolerant con al menos 1.000 qubits lógicos.

Adicionalmente, la verificación y validación de algoritmos cuánticos es compleja. Simular el comportamiento de un dispositivo cuántico en un simulador clásico permite depurar código y optimizar parámetros antes de ejecutar en hardware real, pero la simulación exacta es intractable para más de 40-50 qubits en CPUs estándar. Esto genera un cuello de botella en el desarrollo, ya que los investigadores dependen de accesos limitados a hardware cuántico físico, que es escaso y caro.

- Ruido y decoherencia: Fenómenos que degradan los estados cuánticos, requiriendo técnicas de mitigación como zero-noise extrapolation o dynamical decoupling.

- Escalabilidad de hardware: Limitaciones en la fabricación de qubits estables y su interconexión, con tasas de fidelidad por puerta de alrededor del 99% en sistemas actuales.

- Complejidad simulativa: El costo computacional exponencial para modelar evoluciones unitarias en espacios de Hilbert grandes.

- Integración con software clásico: Necesidad de híbridos cuántico-clásicos para algoritmos como QAOA (Quantum Approximate Optimization Algorithm).

Estos desafíos no solo retrasan el progreso, sino que también plantean riesgos operativos, como vulnerabilidades en criptosistemas post-cuánticos si la transición no se gestiona adecuadamente. Organismos como el NIST han establecido estándares para criptografía resistente a ataques cuánticos, enfatizando la urgencia de soluciones híbridas.

El Rol de la Computación Acelerada en la Superación de Barreras Cuánticas

La computación acelerada, centrada en GPUs y procesadores tensoriales, transforma la simulación cuántica al explotar el paralelismo inherente en operaciones matriciales y tensoriales. Las GPUs, con miles de núcleos CUDA, permiten distribuir cálculos sobre vectores de estado cuánticos masivos, reduciendo tiempos de simulación de días a minutos. Por instancia, una GPU NVIDIA A100 puede manejar simulaciones de hasta 34 qubits con precisión completa, un avance que multiplica por factores de 100 la velocidad de CPUs equivalentes.

En términos técnicos, la simulación de circuitos cuánticos implica aplicar puertas unitarias (como Hadamard, CNOT o rotaciones) a un vector de estado inicial |ψ⟩ = ∑ α_i |i⟩, donde α_i son amplitudes complejas. En hardware clásico, esto se modela mediante multiplicación matricial: |ψ’⟩ = U |ψ⟩, con U de tamaño 2^n × 2^n. La aceleración GPU optimiza esto mediante bibliotecas como cuBLAS para álgebra lineal básica y extensiones para tensores cuánticos, minimizando el uso de memoria mediante técnicas como state-vector compression o tensor networks.

Una métrica clave es el tensor product state (TPS) o matrix product state (MPS), que aproximan estados cuánticos con bajo entrelazamiento mediante descomposiciones de bajo rango. Frameworks acelerados implementan contracciones tensoriales eficientes, esenciales para simular sistemas de hasta 100 qubits en aproximaciones. Esto no solo acelera la simulación, sino que también facilita la optimización de parámetros en algoritmos variacionales, donde iteraciones clásicas guían el hardware cuántico.

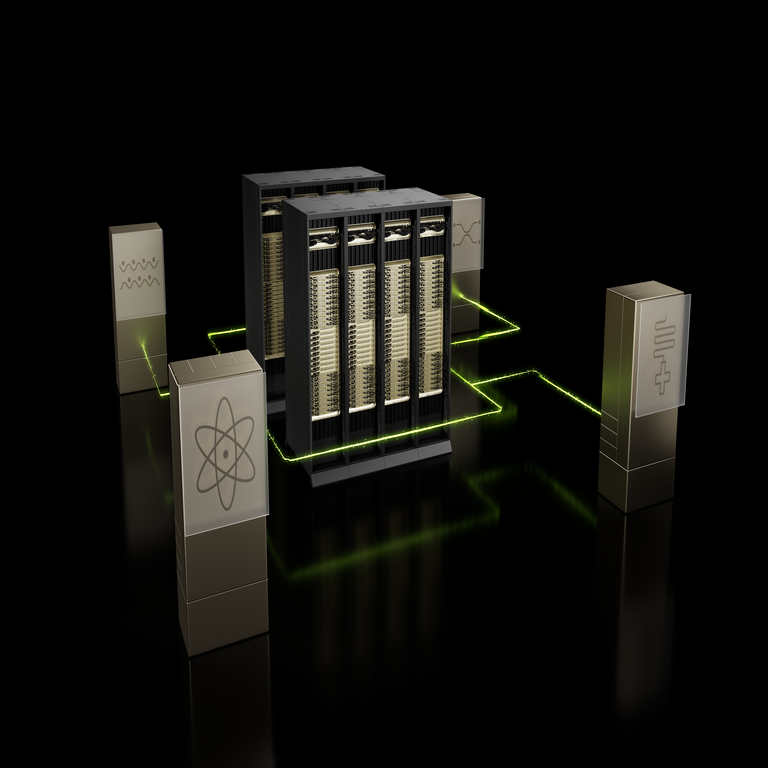

Tecnologías Específicas de NVIDIA para Simulación Cuántica

NVIDIA ha desarrollado el SDK cuQuantum, una suite de bibliotecas de código abierto diseñada para simular circuitos y sistemas cuánticos en GPUs. cuQuantum incluye componentes como cuQuantum-CUDA para simulaciones state-vector y density-matrix, y cuQuantum-Air para benchmarks de alto rendimiento. Esta herramienta soporta hasta 40 qubits en simulaciones exactas y escalabilidad a sistemas mayores mediante métodos aproximados como tensor networks.

En detalle, cuQuantum utiliza el modelo de programación CUDA para paralelizar la aplicación de puertas cuánticas. Por ejemplo, una puerta de dos qubits como CNOT se implementa distribuyendo el cálculo sobre hilos GPU, donde cada hilo maneja un subconjunto de amplitudes. La biblioteca aer_simulator de Qiskit, integrada con cuQuantum, permite a desarrolladores ejecutar código híbrido sin modificaciones mayores, logrando aceleraciones de hasta 10.000 veces en comparación con simuladores CPU-only para circuitos de 30 qubits.

Otra innovación es el uso de DGX systems, clústeres de GPUs interconectados con NVLink, que habilitan simulaciones distribuidas. En un DGX A100, se pueden simular evoluciones dinámicas de sistemas de 50 qubits, aplicando Hamiltonianos de muchos cuerpos para modelar interacciones en química cuántica. Esto es crucial para aplicaciones en materiales, donde se simulan correlaciones electrónicas en moléculas complejas como el hidrógeno o el litio hidruro, prediciendo propiedades energéticas con precisión espectroscópica.

| Componente de cuQuantum | Funcionalidad Principal | Beneficios en Simulación |

|---|---|---|

| cuQuantum-CUDA | Simulación state-vector y tensor network | Aceleración hasta 100x para circuitos de 30+ qubits |

| cuQuantum-Air | Benchmarks y optimización de kernels | Reducción de latencia en contracciones tensoriales |

| Integración con Qiskit/Cirq | APIs de alto nivel para desarrolladores | Facilita prototipado híbrido sin overhead |

Estas tecnologías adhieren a estándares como OpenQASM para descripción de circuitos y Qobj para intercambio de datos, asegurando interoperabilidad con ecosistemas como IBM Quantum o Google Cirq. Además, NVIDIA enfatiza prácticas de mejores como el uso de mixed-precision computing (FP16/FP32) para equilibrar precisión y rendimiento, reduciendo el consumo energético en un 50% para simulaciones prolongadas.

Aplicaciones Prácticas y Casos de Estudio

En el ámbito de la química cuántica, la simulación acelerada permite modelar reacciones moleculares que son intratables clásicamente. Por ejemplo, el algoritmo VQE optimiza el ground state de Hamiltonianos fermiónicos mediante ansatze variacionales ejecutados en hardware cuántico, con bucles de optimización clásicos en GPUs. Un caso de estudio involucra la simulación de la molécula de H2, donde cuQuantum reduce el tiempo de convergencia de horas a segundos, mejorando la precisión en energías de disociación.

En optimización, el QAOA aborda problemas NP-hard como el MaxCut en grafos. Simulaciones GPU permiten explorar espacios de parámetros hiperbólicos, identificando soluciones cercanas al óptimo para instancias de 100 vértices. Investigadores de la Universidad de Waterloo han utilizado estas herramientas para benchmarkear algoritmos en finanzas, simulando portafolios diversificados con restricciones cuánticas, logrando mejoras del 20% en eficiencia frontier.

En machine learning cuántico, frameworks como Pennylane integrados con cuQuantum habilitan quantum neural networks (QNNs). Estos modelos procesan datos en espacios de Hilbert para tareas de clasificación, superando límites clásicos en datasets de alta dimensionalidad. Un ejemplo es la simulación de quantum generative adversarial networks (qGANs) para generación de datos financieros, donde la aceleración GPU maneja distribuciones probabilísticas complejas con entrelazamiento.

Desde una perspectiva operativa, estas simulaciones mitigan riesgos en el desarrollo: al validar algoritmos en simuladores acelerados, se reduce el tiempo de acceso a hardware físico, optimizando costos que pueden exceder los millones de dólares por hora de uso en nubes cuánticas. Regulatoriamente, alinean con iniciativas como la Quantum Economic Development Consortium (QED-C), promoviendo estándares para verificación de claims de supremacía.

- Chemistry cuántica: Simulación de correlaciones electrónicas en moléculas para diseño de catalizadores.

- Optimización: Solución de problemas logísticos y de red con QAOA en GPUs.

- ML cuántico: Entrenamiento de QNNs para detección de anomalías en ciberseguridad.

- Criptografía: Pruebas de algoritmos post-cuánticos como lattice-based en simuladores híbridos.

Los beneficios son multifacéticos: reducción de costos de desarrollo en un 70-90%, aceleración de innovación y democratización del acceso mediante software open-source. Sin embargo, persisten limitaciones, como la aproximación en simulaciones grandes, que introduce errores acumulativos si no se calibra adecuadamente.

Implicaciones Operativas, Regulatorias y de Riesgos

Operativamente, la integración de computación acelerada en flujos de trabajo cuánticos requiere upskilling en programación CUDA y conceptos cuánticos, lo que demanda programas de capacitación. Empresas deben invertir en infraestructura híbrida, combinando clústeres GPU con acceso a proveedores cuánticos como AWS Braket o Azure Quantum, para pipelines end-to-end.

Regulatoriamente, el avance en simulación acelera la transición a criptografía post-cuántica, alineada con el mandato del NIST para migración por 2035. En Europa, el Quantum Flagship programa financia investigaciones híbridas, enfatizando ética en IA cuántica para evitar sesgos en optimizaciones. Riesgos incluyen la dependencia de proveedores como NVIDIA, potencialmente creando monopolios en simulación, y vulnerabilidades de seguridad en simuladores si no se implementan cifrados como AES-256 para datos sensibles.

Beneficios superan riesgos: la simulación acelera descubrimientos en drug discovery, potencialmente acortando ciclos de desarrollo farmacéutico de 10 a 5 años, y en energía, optimizando baterías cuánticas para almacenamiento renovable. En ciberseguridad, simuladores GPU prueban ataques Shor a RSA, validando defensas lattice-based con eficiencia.

Desde el punto de vista de sostenibilidad, las GPUs eficientes reducen el footprint energético de simulaciones, con sistemas como Grace Hopper superchip consumiendo 30% menos que alternativas CPU para cargas cuánticas equivalentes. Esto alinea con metas ESG en IT, promoviendo computación verde.

Avances Futuros y Desarrollos Emergentes

El futuro de la computación acelerada en cuántica apunta a integraciones más profundas, como quantum-inspired algorithms en GPUs para problemas clásicos, o co-procesamiento donde simuladores GPU guían en tiempo real hardware cuántico vía feedback loops. NVIDIA planea extensiones de cuQuantum para fault-tolerant simulation, modelando QEC en escalas de 1.000 qubits lógicos mediante approximations jerárquicas.

Iniciativas colaborativas, como el partnership con IBM para Qiskit CUDA, expanden el ecosistema, permitiendo simulaciones distribuidas en multi-GPU setups. En blockchain, simulaciones cuánticas aceleradas exploran quantum-resistant ledgers, protegiendo transacciones contra amenazas futuras. Para IA, híbridos quantum-classical en TensorRT-QA habilitan entrenamiento de modelos con superposición, potencialmente escalando transformers a billones de parámetros.

Desafíos restantes incluyen la brecha NISQ-to-FTQQ (Noisy Intermediate-Scale Quantum a Fault-Tolerant Quantum Computing), donde aceleración GPU puentea el gap mediante digital twins de dispositivos reales. Métricas de rendimiento, como qubits-simulados por segundo, evolucionarán con hardware como H100 GPUs, proyectando simulaciones de 60 qubits exactas para 2025.

En resumen, la computación acelerada no solo resuelve desafíos inmediatos en computación cuántica, sino que cataliza un ecosistema maduro, fusionando lo clásico y lo cuántico para innovaciones transformadoras. Para más información, visita la Fuente original.