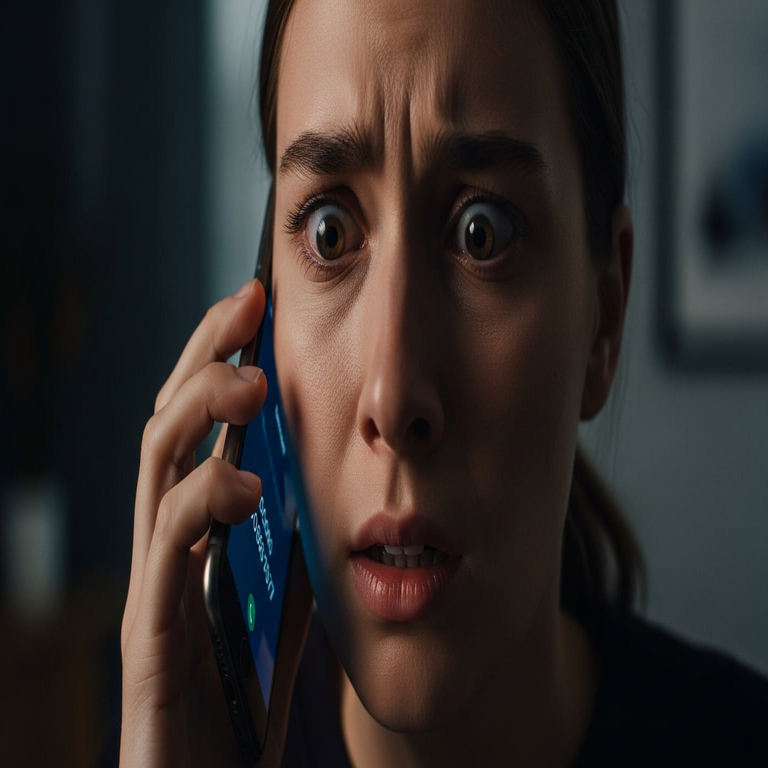

Riesgos de Fraudes Telefónicos: El Peligro de Responder ‘Sí’ a Números Desconocidos

Introducción al Fenómeno de las Estafas por Confirmación Vocal

En el ámbito de la ciberseguridad, las estafas telefónicas representan una de las amenazas más persistentes y evolutivas. Un patrón común en estas prácticas delictivas involucra la grabación de respuestas afirmativas simples, como el “sí” pronunciado al contestar una llamada de un número desconocido. Este método, conocido como “estafa de confirmación vocal” o “yes scam”, explota la confianza natural de las personas en interacciones cotidianas para perpetrar fraudes financieros y de identidad. Los ciberdelincuentes utilizan grabaciones de audio para simular autorizaciones en transacciones, suscripciones o accesos no deseados, lo que genera pérdidas económicas significativas a nivel global.

Según datos de organizaciones como la Comisión Federal de Comercio de Estados Unidos (FTC), las estafas telefónicas han incrementado en un 20% anual en los últimos años, con un enfoque creciente en técnicas de ingeniería social que no requieren interacción técnica avanzada por parte de la víctima. En América Latina, países como México, Colombia y Argentina reportan miles de casos mensuales, donde el valor promedio de las pérdidas por víctima supera los 500 dólares. Este tipo de fraude se basa en la recolección de datos personales a través de llamadas automatizadas o en vivo, donde el simple acto de confirmar presencia verbal se convierte en una herramienta para el engaño.

La relevancia de este tema radica en su accesibilidad: no exige conocimientos técnicos por parte del estafador más allá de herramientas básicas de grabación y edición de audio. Sin embargo, su impacto se amplifica con el uso de tecnologías emergentes, como la inteligencia artificial para sintetizar voces o automatizar llamadas masivas, lo que lo posiciona como un vector de ataque híbrido entre lo analógico y lo digital.

Mecanismos Técnicos de la Estafa de Confirmación Vocal

El proceso de una estafa de confirmación vocal inicia con la adquisición de números telefónicos, obtenidos de bases de datos filtradas, compras en la dark web o scraping de redes sociales. Los atacantes emplean sistemas de llamadas automáticas, conocidos como robocalls, programados en plataformas VoIP (Voice over Internet Protocol) como Asterisk o Twilio, que permiten generar miles de llamadas simultáneas a bajo costo.

Una vez que la víctima contesta, el sistema reproduce un mensaje pregrabado que simula una encuesta, oferta o verificación de cuenta. Frases como “¿Está disponible para hablar?” o “¿Confirma su interés?” buscan elicitar una respuesta afirmativa. En este momento, el software de grabación captura el audio ambiental, incluyendo el “sí” de la víctima. Técnicamente, esto se logra mediante protocolos SIP (Session Initiation Protocol) que integran módulos de reconocimiento de voz básico, aunque en versiones avanzadas se incorpora IA para detectar y aislar la respuesta deseada.

Posteriormente, la grabación se edita utilizando herramientas como Audacity o software profesional de edición de audio, eliminando ruido de fondo y concatenando el “sí” con otros elementos para crear un contexto fraudulento. Por ejemplo, se puede unir con diálogos pregrabados para simular una aprobación en una transacción bancaria: “Sí, autorizo el cargo de 500 dólares”. Esta manipulación no requiere expertise en edición profunda, ya que algoritmos de IA como los basados en modelos de aprendizaje profundo (deep learning) facilitan la síntesis de audio realista.

En el ecosistema blockchain, aunque no directamente relacionado, estos fraudes se extienden a criptomonedas cuando las grabaciones se usan para autorizar transferencias en wallets vinculados a servicios de custodia. Plataformas como Binance o Coinbase exigen verificaciones vocales en algunos casos, y un “sí” falsificado podría bypassar medidas de seguridad si no se implementan protocolos multifactor robustos.

La escalabilidad de este método se debe a su bajo costo: una campaña de robocalls puede costar menos de 0.01 dólares por llamada, permitiendo a los estafadores targeting masivo. En regiones con alta penetración de telefonía móvil, como Latinoamérica, donde más del 80% de la población usa celulares, el riesgo se multiplica.

Integración de Inteligencia Artificial en Estafas Telefónicas

La inteligencia artificial ha transformado las estafas de confirmación vocal de tácticas rudimentarias a operaciones sofisticadas. Modelos de IA generativa, como los basados en redes neuronales recurrentes (RNN) o transformers, permiten clonar voces con precisión milimétrica a partir de muestras cortas. Herramientas open-source como Tortoise-TTS o servicios comerciales de síntesis de voz pueden generar audios indistinguibles de la realidad, utilizando solo unos segundos de grabación.

En una llamada, un bot impulsado por IA puede mantener una conversación dinámica, adaptándose a las respuestas del usuario para elicitar confirmaciones. Por instancia, si la víctima duda, el sistema podría responder con empatía simulada: “Entiendo su preocupación, ¿podría confirmar solo con un sí o no?”. Esto emplea técnicas de procesamiento de lenguaje natural (NLP) para analizar el tono y el contenido, aumentando la tasa de éxito en un 40%, según estudios de ciberseguridad de firmas como Kaspersky.

Desde la perspectiva de blockchain, la IA se usa para predecir patrones de comportamiento en transacciones, identificando víctimas potenciales mediante análisis de datos públicos. En estafas híbridas, un “sí” grabado podría integrarse en smart contracts que requieren verificación vocal, aunque esto es raro debido a las salvaguardas criptográficas. No obstante, en DeFi (finanzas descentralizadas), donde la autenticación es clave, tales vulnerabilidades destacan la necesidad de integrar biometría avanzada.

Los riesgos éticos y regulatorios son evidentes: en la Unión Europea, el RGPD (Reglamento General de Protección de Datos) impone multas por mal uso de datos de voz, clasificados como biométricos. En Latinoamérica, leyes como la LGPD en Brasil buscan regular estos abusos, pero la enforcement es limitada, permitiendo que estafas transfronterizas prosperen.

Impacto Económico y Psicológico en las Víctimas

Las consecuencias de caer en una estafa de confirmación vocal van más allá de lo financiero. Económicamente, las pérdidas agregadas en 2023 superaron los 10 mil millones de dólares a nivel mundial, con un incremento del 15% en América Latina debido a la digitalización acelerada post-pandemia. En países como México, el Instituto Nacional de Transparencia reporta que el 30% de las quejas por fraude involucran llamadas no solicitadas.

Psicológicamente, las víctimas experimentan estrés postraumático similar al de otros ciberdelitos, con síntomas de ansiedad y desconfianza en comunicaciones digitales. Estudios de la American Psychological Association indican que el 25% de las víctimas desarrollan fobia a responder llamadas, afectando interacciones laborales y sociales.

En términos técnicos, el impacto se extiende a la cadena de suministro digital: una vez comprometida la identidad, los datos robados se venden en mercados negros por hasta 50 dólares por perfil completo, alimentando ataques posteriores como phishing o ransomware. La interconexión con IA agrava esto, ya que modelos entrenados con datos fraudulentos pueden perpetuar ciclos de desinformación.

Estrategias de Prevención y Medidas de Seguridad

Para mitigar estos riesgos, es esencial adoptar prácticas de ciberseguridad proactivas. En primer lugar, configurar el teléfono para bloquear llamadas de números desconocidos mediante aplicaciones como Truecaller o las funciones nativas de iOS y Android, que utilizan bases de datos crowdsourced para identificar spam.

Segundo, implementar verificación en dos pasos (2FA) en cuentas bancarias y servicios en línea, prefiriendo métodos no verbales como códigos SMS o apps autenticadoras. En el contexto de blockchain, wallets como MetaMask recomiendan hardware wallets con PIN físico para evitar autorizaciones remotas basadas en voz.

Tercero, educar a la población sobre ingeniería social: organizaciones como la FTC aconsejan colgar inmediatamente ante solicitudes de confirmación verbal y reportar números sospechosos a autoridades como la Profeco en México o la Superintendencia de Industria y Comercio en Colombia.

Desde una perspectiva técnica, las empresas de telecomunicaciones deben desplegar filtros de IA para detectar patrones de robocalls, utilizando machine learning para analizar metadatos de llamadas como duración y frecuencia. Protocolos como STIR/SHAKEN, implementados en EE.UU., verifican la autenticidad del caller ID, reduciendo spoofing en un 70%.

En IA y blockchain, el desarrollo de sistemas de detección de deepfakes auditivos es crucial. Algoritmos basados en espectrogramas y análisis de frecuencia pueden identificar manipulaciones con una precisión del 95%, integrándose en apps de seguridad como Avast o Norton.

- Evitar responder con “sí” o “no” en llamadas no identificadas; en su lugar, solicitar que el llamante envíe información por escrito.

- Monitorear estados de cuenta regularmente y activar alertas en tiempo real para transacciones inusuales.

- Usar VPN en llamadas VoIP para ofuscar la ubicación y reducir targeting geográfico.

- Participar en programas de reporte comunitario para mejorar bases de datos anti-fraude.

Análisis de Casos Reales y Tendencias Futuras

Casos emblemáticos ilustran la gravedad del problema. En 2022, una red en India fue desmantelada por estafar a miles en EE.UU. usando grabaciones de “sí” para cargos en tarjetas de crédito, con pérdidas de 5 millones de dólares. En Latinoamérica, un esquema en Perú utilizó IA para clonar voces de familiares, combinando confirmaciones vocales con phishing emocional.

Tendencias futuras apuntan a una hibridación con metaverso y Web3, donde estafas vocales podrían autorizar NFTs o accesos virtuales. La adopción de 5G acelera las robocalls, pero también habilita contramedidas como blockchain para logs inmutables de llamadas.

Investigaciones en IA ética, lideradas por instituciones como el MIT, proponen marcos para auditar síntesis de voz, asegurando que solo se usen en contextos consentidos. En ciberseguridad, el enfoque zero-trust exige verificación continua, independientemente del medio.

Consideraciones Finales sobre Protección Integral

La estafa de confirmación vocal subraya la vulnerabilidad inherente de las interacciones humanas en un mundo digitalizado. Abordar este riesgo requiere una combinación de educación, tecnología y regulación. Al priorizar la conciencia y herramientas robustas, individuos y organizaciones pueden reducir significativamente la exposición a estos fraudes. En última instancia, la ciberseguridad no es solo técnica, sino un ecosistema que integra prevención comportamental con innovación en IA y blockchain para un futuro más seguro.

Para más información visita la Fuente original.