Implicaciones de la Integración de ChatGPT en el Bienestar Adolescente y Control Parental

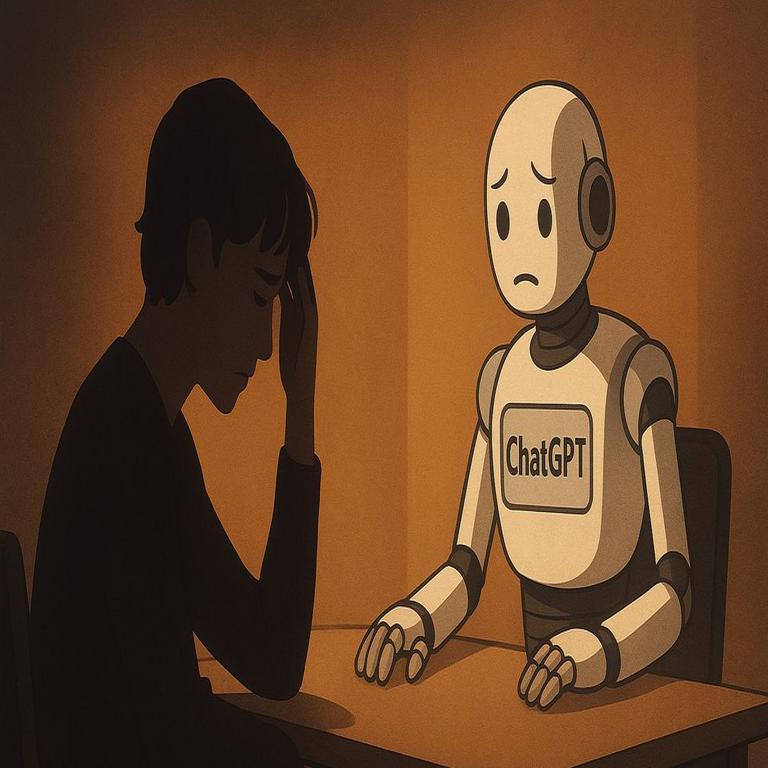

El reciente caso de un suicidio adolescente relacionado con el uso de ChatGPT, desarrollado por OpenAI, ha suscitado un intenso debate sobre la responsabilidad de las plataformas tecnológicas en la salud mental de los jóvenes. Este artículo explora las implicaciones técnicas y éticas de la inteligencia artificial (IA) en el contexto del bienestar adolescente, así como las medidas que se están considerando para mejorar el control parental y la seguridad en línea.

Contexto del Suceso

La tragedia ha puesto de manifiesto los riesgos asociados con el uso incontrolado de herramientas basadas en IA. Los adolescentes, al estar en una etapa crítica de desarrollo emocional y cognitivo, pueden ser particularmente vulnerables a interacciones negativas con sistemas automatizados. La facilidad con que pueden acceder a estas herramientas sin supervisión adecuada plantea serias preocupaciones.

Medidas Propuestas por OpenAI

A raíz del incidente, OpenAI ha anunciado una serie de medidas destinadas a fortalecer la seguridad y el control parental sobre su tecnología:

- Implementación de Controles Parentales: Se propone introducir funciones que permitan a los padres monitorear y limitar el acceso a ciertos contenidos o interacciones dentro del sistema.

- Boton de Emergencia: Una característica que permitiría a los usuarios alertar rápidamente a un adulto o a servicios de emergencia si se detectan situaciones críticas durante la interacción con la IA.

- Ajustes Personalizados: La opción para personalizar las respuestas del modelo según las preferencias y necesidades específicas del usuario, lo cual podría incluir restricciones temáticas o enfoques más sensibles hacia temas delicados.

Implicaciones Técnicas

Desde una perspectiva técnica, implementar estas medidas representa un desafío significativo. Los controles parentales requieren un diseño cuidadoso para no afectar negativamente la experiencia general del usuario ni limitar innecesariamente las capacidades del sistema. Además, es crucial garantizar que cualquier mecanismo introducido sea eficaz sin comprometer la privacidad o seguridad del usuario.

La implementación de un botón de emergencia también plantea cuestiones técnicas relacionadas con:

- Sensibilidad Contextual: Determinar cuándo activar este botón puede ser complejo; es necesario desarrollar algoritmos que reconozcan patrones preocupantes sin generar falsas alarmas.

- Circuitos de Respuesta Rápida: El sistema deberá estar vinculado a protocolos establecidos para garantizar una respuesta efectiva ante situaciones críticas.

Cultura Digital y Responsabilidad Ética

No obstante las medidas técnicas propuestas, también surge una cuestión ética: ¿qué responsabilidad tienen las empresas tecnológicas respecto al bienestar emocional y psicológico de sus usuarios? La incorporación responsable de IA debe considerar no solo los aspectos técnicos sino también su impacto social. Es fundamental fomentar una cultura digital que priorice la salud mental junto con el avance tecnológico.

Cierre

A medida que avanzamos hacia un futuro donde la inteligencia artificial será cada vez más integrada en nuestras vidas cotidianas, resulta imprescindible establecer marcos regulatorios claros que garanticen tanto el desarrollo seguro como responsable de estas tecnologías. Las empresas deben asumir un papel activo en proteger a sus usuarios más vulnerables, mientras que los padres deben ser educados sobre cómo utilizar estas herramientas adecuadamente. Para más información visita Fuente original.