Desarrollo de un Asistente de Inteligencia Artificial para el Desarrollo de Software: Análisis Técnico y Aplicaciones Prácticas

Introducción al Concepto de Asistentes de IA en el Entorno de Desarrollo

En el panorama actual de la ingeniería de software, la integración de la inteligencia artificial (IA) ha transformado radicalmente los procesos de desarrollo. Los asistentes de IA, impulsados por modelos de lenguaje grandes (LLM, por sus siglas en inglés), representan una evolución significativa en las herramientas de productividad para programadores. Estos sistemas no solo automatizan tareas repetitivas, sino que también facilitan la generación de código, la depuración y la optimización de arquitecturas de software. El análisis de este artículo se centra en la creación de un asistente de IA personalizado para el desarrollo de software, destacando los componentes técnicos involucrados y sus implicaciones en entornos profesionales.

Desde una perspectiva técnica, un asistente de IA para desarrollo de software se basa en el procesamiento del lenguaje natural (PLN) combinado con conocimiento específico del dominio de programación. Tecnologías como los transformers, introducidos en el modelo BERT y evolucionados en GPT, permiten que estos asistentes interpreten consultas en lenguaje natural y generen respuestas en forma de código ejecutable. En este contexto, el artículo examina la implementación de un sistema que integra APIs de LLM con entornos de desarrollo integrados (IDE), como Visual Studio Code o IntelliJ, para ofrecer soporte contextual en tiempo real.

Los beneficios operativos incluyen una reducción en el tiempo de codificación estimada en un 30-50%, según estudios de productividad en entornos ágiles. Sin embargo, también surgen riesgos como la dependencia excesiva en la IA, que podría erosionar habilidades fundamentales de programación, y vulnerabilidades de seguridad en la generación de código automatizado, tales como inyecciones de código malicioso inadvertidas.

Fundamentos Técnicos de los Modelos de Lenguaje Grandes en el Desarrollo de Software

Los LLM forman el núcleo de cualquier asistente de IA para programación. Estos modelos, entrenados en vastos conjuntos de datos que incluyen repositorios de código abierto como GitHub, utilizan arquitecturas de redes neuronales profundas para predecir secuencias de tokens. En términos técnicos, un LLM como GPT-4 opera mediante un mecanismo de atención auto-regresiva, donde cada token generado se basa en el contexto previo, permitiendo la síntesis de funciones completas a partir de descripciones vagas.

Para implementar un asistente, se requiere una integración con frameworks como LangChain o Hugging Face Transformers. LangChain, por ejemplo, facilita la cadena de prompts (prompt chaining), donde una consulta inicial se descompone en sub-tareas: análisis de requisitos, generación de pseudocódigo y refinamiento iterativo. La precisión de estos modelos se mide mediante métricas como BLEU para similitud de código o ROUGE para evaluación de resúmenes, aunque en contextos de programación, se prefieren benchmarks específicos como HumanEval, que evalúa la funcionalidad de código generado en lenguajes como Python o JavaScript.

En el ámbito de la ciberseguridad, es crucial considerar la privacidad de los datos. Al enviar fragmentos de código a APIs de LLM, se exponen potencialmente secretos como claves API o datos sensibles. Soluciones como el procesamiento local con modelos open-source (e.g., CodeLlama) mitigan estos riesgos, utilizando hardware como GPUs NVIDIA para inferencia en edge computing, reduciendo la latencia a menos de 500 ms por consulta.

Arquitectura del Asistente de IA: Componentes y Integración

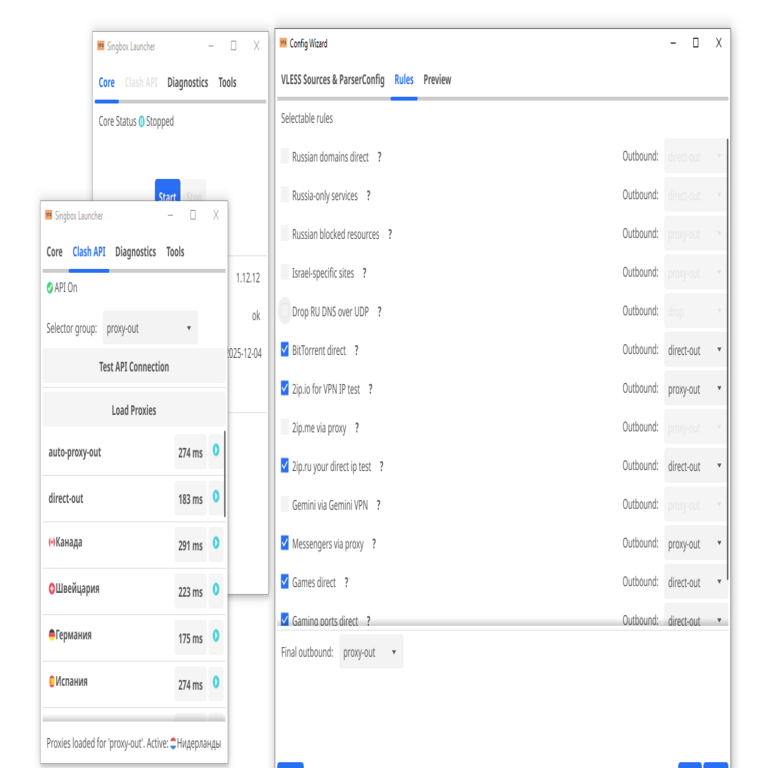

La arquitectura de un asistente de IA para desarrollo de software típicamente se divide en capas: interfaz de usuario, motor de procesamiento y backend de conocimiento. La interfaz, a menudo un plugin para IDE, captura el contexto del editor —como el lenguaje de programación activo y el estado del proyecto— mediante APIs como la de Language Server Protocol (LSP).

El motor de procesamiento emplea un pipeline de PLN: tokenización con bibliotecas como spaCy o NLTK, seguida de embedding semántico usando modelos como Sentence-BERT para mapear consultas a vectores en un espacio de alta dimensión. Posteriormente, el LLM genera código, que se valida automáticamente mediante linters (e.g., ESLint para JavaScript) y pruebas unitarias generadas dinámicamente con herramientas como Pytest.

En cuanto al backend, bases de datos vectoriales como Pinecone o FAISS almacenan embeddings de documentación técnica y patrones de código históricos, permitiendo retrieval-augmented generation (RAG). Esta técnica mejora la relevancia al inyectar conocimiento externo en el prompt, evitando alucinaciones comunes en LLM, donde el modelo inventa hechos inexistentes. Por ejemplo, en un proyecto blockchain, el asistente podría recuperar estándares como ERC-20 para generar contratos inteligentes en Solidity de manera precisa.

La integración con tecnologías emergentes amplía las capacidades. En IA, la combinación con agentes autónomos —usando frameworks como Auto-GPT— permite que el asistente ejecute flujos de trabajo completos, como la migración de código legado a microservicios en Kubernetes. En blockchain, se exploran aplicaciones para auditoría de smart contracts, detectando vulnerabilidades como reentrancy attacks mediante análisis estático asistido por IA.

Implementación Práctica: Pasos Técnicos y Mejores Prácticas

El desarrollo de un asistente comienza con la selección de un LLM base. Modelos open-source como Mistral o Llama 2 ofrecen un equilibrio entre rendimiento y costo, con fine-tuning en datasets específicos de programación (e.g., The Stack dataset de Hugging Face). El fine-tuning implica ajustar pesos neuronales mediante gradiente descendente estocástico, utilizando técnicas como LoRA (Low-Rank Adaptation) para eficiencia computacional, reduciendo el uso de memoria en un 90% comparado con full fine-tuning.

Una vez entrenado, el modelo se despliega en un servidor con contenedores Docker, orquestados por Kubernetes para escalabilidad. La API RESTful expone endpoints como /generate_code, que recibe JSON con {prompt: “Escribe una función para validar emails en Python”, context: “Proyecto en Flask”} y retorna código formateado. Para seguridad, se implementa autenticación OAuth 2.0 y rate limiting con Redis para prevenir abusos.

En la integración con IDE, extensiones como GitHub Copilot utilizan WebSockets para comunicación en tiempo real, sugiriendo completaciones inline. Mejores prácticas incluyen el versioning del código generado con Git, y revisiones humanas obligatorias para cambios críticos, alineadas con estándares como ISO/IEC 25010 para calidad de software.

Consideraciones regulatorias emergen en entornos corporativos. En la Unión Europea, el Reglamento de IA clasifica estos asistentes como de “alto riesgo” si impactan en decisiones críticas, requiriendo transparencia en el entrenamiento y auditorías periódicas. En Latinoamérica, normativas como la LGPD en Brasil exigen manejo ético de datos, promoviendo el uso de federated learning para entrenar modelos sin centralizar datos sensibles.

Riesgos y Mitigaciones en el Uso de Asistentes de IA para Programación

A pesar de sus ventajas, los asistentes de IA introducen riesgos significativos. En ciberseguridad, la generación de código vulnerable es un concern principal; por instancia, un LLM podría sugerir consultas SQL sin parametrización, exponiendo a inyecciones SQL. Mitigaciones incluyen escaneo estático con herramientas como SonarQube integrado en el pipeline de IA, y entrenamiento adversarial para robustecer el modelo contra prompts maliciosos.

Otro riesgo es la sesgo en el entrenamiento: datasets dominados por código en inglés pueden generar soluciones subóptimas para lenguajes locales o contextos culturales. Soluciones involucran diversificación de datos, incorporando repositorios en español y portugués de plataformas como GitLab.

Desde el punto de vista operativo, la latencia en entornos de baja conectividad puede interrumpir flujos de trabajo. Edge computing, con modelos cuantizados (e.g., a 4-bit precision usando BitsAndBytes), resuelve esto, manteniendo precisión por encima del 85% en benchmarks como BigCode.

En blockchain, los asistentes de IA facilitan el desarrollo de dApps, pero riesgos como oracle manipulation requieren validación cruzada con simuladores como Ganache. Beneficios incluyen aceleración en DeFi, donde la generación de protocolos AMM (Automated Market Makers) reduce tiempo de desarrollo de semanas a horas.

Aplicaciones Avanzadas y Casos de Estudio

En inteligencia artificial aplicada, estos asistentes se extienden a DevOps, automatizando CI/CD pipelines con herramientas como Jenkins. Un caso de estudio involucra la integración con Terraform para IaC (Infrastructure as Code), donde el asistente genera configuraciones HCL basadas en descripciones de alto nivel, optimizando recursos en AWS o Azure.

En ciberseguridad, aplicaciones incluyen la detección de anomalías en logs de código mediante modelos de series temporales como LSTM, integrados en el asistente para alertas proactivas. Un ejemplo práctico es el uso en pentesting, generando payloads éticos para pruebas de vulnerabilidades en APIs REST.

Para tecnologías emergentes, en Web3, el asistente puede asistir en la creación de NFTs con estándares ERC-721, incorporando metadatos IPFS para descentralización. En IA generativa, se combina con diffusion models para visualización de arquitecturas de software, produciendo diagramas UML a partir de código fuente.

Casos reales demuestran impacto: Empresas como Microsoft con GitHub Copilot reportan un 55% de aumento en productividad, mientras que startups en Latinoamérica utilizan versiones open-source para competir en mercados globales, alineadas con iniciativas como el Plan Nacional de IA en México.

Implicaciones Éticas y Futuras en el Ecosistema de Desarrollo

Éticamente, la adopción de asistentes de IA plantea preguntas sobre autoría de código y propiedad intelectual. Estándares como los de la IEEE recomiendan atribución clara al modelo de IA en commits de Git, evitando disputas legales. En términos de inclusión, es esencial accesibilidad para desarrolladores no nativos en inglés, mediante soporte multilingüe en LLM.

El futuro apunta a multimodalidad, donde asistentes procesan no solo texto sino imágenes de wireframes para generar frontend en React. Integraciones con quantum computing simularán optimizaciones complejas, aunque actualmente limitadas por hardware NISQ (Noisy Intermediate-Scale Quantum).

En resumen, los asistentes de IA para desarrollo de software representan un pilar en la transformación digital, equilibrando innovación con responsabilidad. Su implementación requiere un enfoque holístico, considerando aspectos técnicos, de seguridad y regulatorios para maximizar beneficios en entornos profesionales.

Para más información, visita la Fuente original.