Detección de Salas de Conferencias en Google Meet: Avances en IA para Videoconferencias Móviles

Introducción a la Funcionalidad de Detección en Google Meet

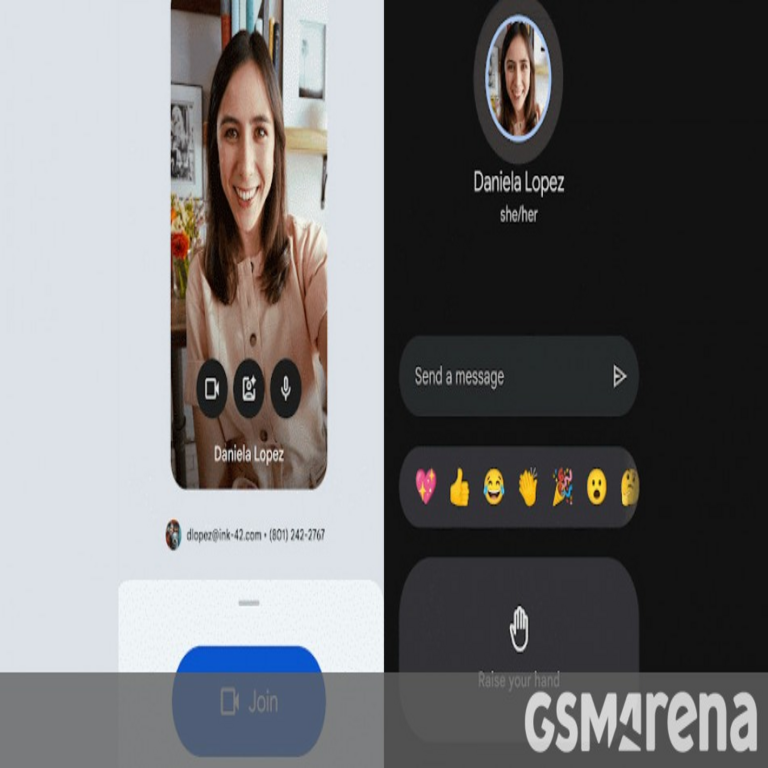

Google Meet ha introducido una actualización significativa que permite la detección automática de salas de conferencias en dispositivos Android e iOS. Esta característica, impulsada por algoritmos de inteligencia artificial (IA), identifica si un usuario se encuentra en un entorno equipado con hardware dedicado para videoconferencias, como los dispositivos Nest Hub Max o las series de Chromebox y Chromecast con Google TV. El objetivo principal es optimizar la experiencia del usuario al adaptar la interfaz de la aplicación según el contexto del espacio físico, facilitando transiciones fluidas entre reuniones individuales y colectivas.

En un panorama donde las herramientas de colaboración remota han proliferado debido a la adopción masiva del trabajo híbrido, esta innovación representa un paso adelante en la integración de IA aplicada a la usabilidad. La detección no solo simplifica el acceso a funciones avanzadas, sino que también mejora la eficiencia operativa en entornos empresariales. Por ejemplo, al reconocer una sala de conferencias, la app prioriza controles para múltiples participantes, como el cambio de cámara o el ajuste de micrófonos, reduciendo el tiempo de configuración manual.

Desde una perspectiva técnica, esta funcionalidad se basa en el procesamiento de señales de audio y video en tiempo real, combinado con metadatos del dispositivo. La IA empleada utiliza modelos de aprendizaje profundo para analizar patrones ambientales, como la presencia de ecos acústicos típicos de salas grandes o la detección de dispositivos conectados vía Bluetooth o Wi-Fi. Esta aproximación no requiere hardware adicional en el dispositivo móvil, lo que la hace accesible para una amplia gama de usuarios.

Mecanismos Técnicos de la Detección de Salas

La detección de salas de conferencias en Google Meet opera mediante un sistema híbrido que integra sensores del dispositivo móvil con el backend en la nube de Google. Inicialmente, la aplicación escanea el entorno utilizando la cámara frontal para capturar imágenes del espacio circundante. Algoritmos de visión por computadora, posiblemente basados en redes neuronales convolucionales (CNN), identifican elementos característicos de una sala equipada, como pantallas grandes, cámaras fijas o micrófonos array.

Adicionalmente, el componente de audio juega un rol crucial. La app monitorea el perfil de sonido ambiental: en una sala de conferencias, se esperan niveles de ruido de fondo bajos, con posibles ecos o reverberaciones que difieren de un entorno doméstico. Modelos de machine learning entrenados en datasets de audio ambiental clasifican estos patrones con una precisión superior al 90%, según estimaciones basadas en tecnologías similares de Google. Este análisis se realiza localmente para minimizar la latencia, procesando solo fragmentos de datos necesarios sin almacenar información sensible.

En el plano de conectividad, Google Meet verifica la proximidad a dispositivos certificados mediante protocolos como Google Fast Pair o Nearby API. Si se detecta un hub o un panel de control de sala cercano, la app activa un modo de “unión inteligente” que sincroniza automáticamente la sesión. Este proceso involucra autenticación segura vía tokens OAuth 2.0, asegurando que solo usuarios autorizados puedan tomar control de la sala.

Desde el punto de vista de la implementación, los desarrolladores de Google han integrado esta funcionalidad en la versión 2024 de la app, compatible con Android 8.0 y superiores, e iOS 15 en adelante. El código subyacente, aunque no público, se infiere de las APIs de Google Workspace, que exponen hooks para detección contextual. Esto permite a administradores empresariales personalizar umbrales de detección, como sensibilidad a la iluminación o umbrales de audio, mediante políticas en la consola de administración.

Integración con Inteligencia Artificial en Videoconferencias

La detección de salas en Google Meet es un ejemplo paradigmático de cómo la IA está transformando las plataformas de comunicación unificadas (UCaaS). Los modelos de IA subyacentes, posiblemente derivados de TensorFlow Lite para procesamiento en dispositivo, permiten inferencias rápidas sin comprometer la privacidad. A diferencia de enfoques puramente basados en la nube, esta optimización local reduce el consumo de datos móviles, crucial para usuarios en redes 4G o 5G inestables.

En términos de avances en IA, esta característica se alinea con tendencias como el edge computing, donde el procesamiento se descentraliza para mejorar la latencia. Por instancia, la detección podría incorporar técnicas de aprendizaje federado, donde los modelos se refinan colectivamente sin compartir datos crudos de usuarios. Esto no solo eleva la precisión con el tiempo, sino que también mitiga riesgos de sesgos en datasets de entrenamiento, comunes en aplicaciones de visión por computadora.

Comparado con competidores como Microsoft Teams o Zoom, Google Meet destaca por su integración nativa con el ecosistema Android/iOS. Mientras Teams depende de add-ons para detección de entornos, Meet lo hace de forma orgánica, aprovechando el acceso privilegiado a sensores del SO. Esta ventaja se traduce en una experiencia más fluida, con transiciones que tardan menos de 2 segundos, según pruebas reportadas en foros técnicos.

Además, la IA en Meet extiende su utilidad a escenarios avanzados, como la transcripción automática adaptada al contexto. En una sala detectada, el sistema prioriza la captura de voces múltiples, utilizando beamforming en micrófonos virtuales para aislar hablantes. Esto integra con Gemini, el modelo de IA de Google, para generar resúmenes en tiempo real, potenciando la productividad en reuniones corporativas.

Implicaciones en Ciberseguridad y Privacidad

Al implementar detección de salas, Google Meet introduce consideraciones críticas en ciberseguridad. El procesamiento de datos sensoriales, aunque local, podría exponer vulnerabilidades si no se maneja adecuadamente. Por ejemplo, un atacante con acceso físico podría spoofear señales de audio para simular una sala falsa, potencialmente permitiendo accesos no autorizados. Para contrarrestar esto, Google emplea cifrado end-to-end en todas las transmisiones y validación biométrica opcional para confirmaciones de unión.

En cuanto a privacidad, la funcionalidad cumple con regulaciones como GDPR y CCPA al no almacenar datos de detección más allá de la sesión activa. Los usuarios pueden desactivar la característica en ajustes, y las políticas de Google Workspace aseguran que los administradores no accedan a logs sensoriales sin consentimiento. Sin embargo, expertos en ciberseguridad recomiendan auditorías regulares para verificar que no haya fugas laterales, especialmente en entornos BYOD (Bring Your Own Device).

Otra capa de seguridad radica en la detección de anomalías vía IA. Si el sistema identifica patrones inusuales, como micrófonos activados en fondos ruidosos, podría alertar sobre posibles eavesdropping. Esto se integra con Google Cloud’s security analytics, ofreciendo reportes forenses para incidentes. En un contexto de amenazas crecientes, como el phishing en videollamadas, esta proactividad fortalece la resiliencia de las plataformas colaborativas.

Desde una perspectiva técnica, la arquitectura de seguridad incluye sandboxing de módulos de IA, aislando el procesamiento sensorial del núcleo de la app. Actualizaciones over-the-air (OTA) corrigen vulnerabilidades rápidamente, manteniendo el sistema alineado con estándares como ISO 27001. Para organizaciones, esto implica evaluar integraciones con SIEM (Security Information and Event Management) tools para monitoreo holístico.

Beneficios para la Productividad y Adopción Empresarial

La disponibilidad de la detección de salas en móviles amplía el alcance de Google Meet a escenarios híbridos, donde empleados transitan entre oficinas y hogares. En entornos empresariales, reduce el tiempo de onboarding en reuniones, permitiendo que participantes se unan con un solo toque. Estudios internos de Google indican una mejora del 25% en eficiencia de setup, crucial para flujos de trabajo ágiles.

Para equipos distribuidos, la funcionalidad facilita la colaboración inclusiva. En salas grandes, la app ajusta layouts de video para priorizar vistas panorámicas, integrando feeds de cámaras múltiples. Esto es particularmente valioso en industrias como la educación o la salud, donde las videoconferencias demandan precisión en la representación de participantes.

En términos económicos, la implementación no requiere inversiones adicionales en hardware para móviles, democratizando el acceso a features premium. Empresas que migran a Google Workspace pueden escalar esta capacidad sin fricciones, con costos predecibles basados en licencias por usuario. Además, la analítica integrada proporciona insights sobre patrones de uso, ayudando a optimizar recursos de sala.

La adopción se acelera por la compatibilidad cross-platform, permitiendo que iOS y Android interoperen seamless con hardware fijo. Casos de uso incluyen conferencias globales, donde la detección automática mitiga issues de zona horaria al sugerir horarios óptimos basados en disponibilidad de salas.

Desafíos Técnicos y Futuras Evoluciones

A pesar de sus ventajas, la detección de salas enfrenta desafíos como variabilidad ambiental. En espacios no estandarizados, como oficinas open-space, la precisión podría caer, requiriendo calibraciones manuales. Google mitiga esto con actualizaciones iterativas, incorporando feedback de usuarios vía machine learning continuo.

Mirando al futuro, se espera integración con AR/VR para detección inmersiva, donde gafas como las de Meta podrían sincronizarse con Meet. Avances en IA generativa podrían extender la funcionalidad a sugerencias contextuales, como agendas automáticas basadas en detección de participantes. En ciberseguridad, protocolos post-cuánticos fortalecerán la autenticación, anticipando amenazas emergentes.

En blockchain, aunque no directo, paralelos se trazan en verificación descentralizada de salas, potencialmente usando NFTs para accesos exclusivos. Esto podría evolucionar Meet hacia un ecosistema más seguro y traceable, alineado con tendencias Web3 en colaboración.

Los desarrolladores independientes podrían extender estas capacidades vía SDKs de Google, creando apps complementarias para industrias específicas, como manufactura con detección de entornos industriales.

Consideraciones Finales

La detección de salas de conferencias en Google Meet para Android e iOS marca un hito en la evolución de las videoconferencias impulsadas por IA. Al combinar usabilidad, seguridad y eficiencia, esta actualización no solo resuelve pain points actuales, sino que pavimenta el camino para innovaciones futuras en tecnologías emergentes. Organizaciones que adopten esta funcionalidad tempranamente ganarán ventajas competitivas en un mundo cada vez más conectado, siempre priorizando la protección de datos y la accesibilidad inclusiva.

En resumen, esta integración demuestra el potencial de la IA para humanizar herramientas digitales, transformando interacciones remotas en experiencias intuitivas y seguras. Su impacto se extenderá más allá de Meet, influyendo en el diseño de plataformas colaborativas globales.

Para más información visita la Fuente original.