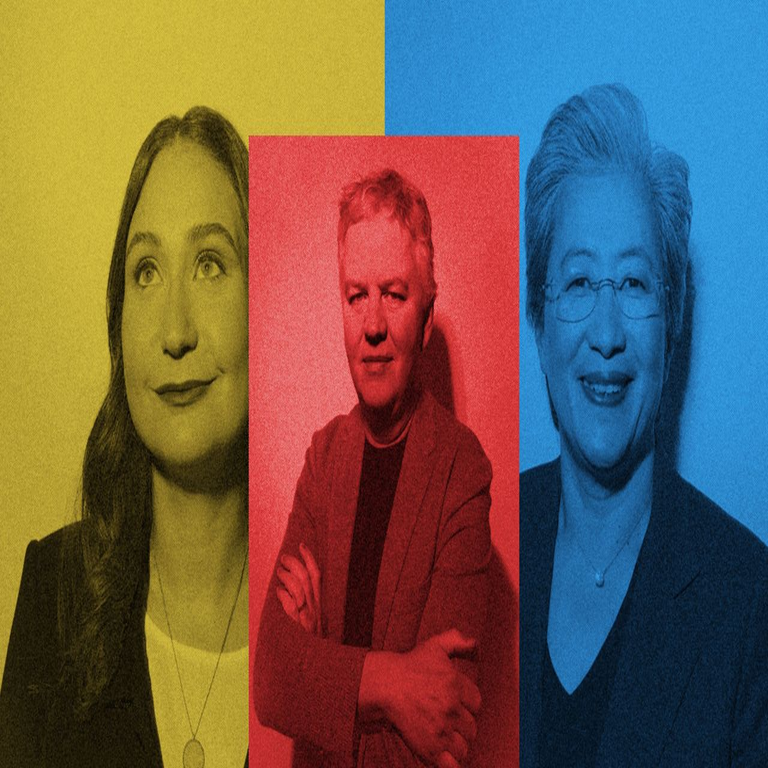

Avances en Inteligencia Artificial y Computación de Alto Rendimiento: Análisis de Entrevistas con AMD, Anthropic y Cloudflare

La intersección entre hardware especializado, desarrollo de modelos de inteligencia artificial (IA) y soluciones de infraestructura en la nube representa uno de los pilares fundamentales de la innovación tecnológica actual. En un contexto donde la demanda por procesamiento eficiente y seguro de datos crece exponencialmente, las perspectivas de líderes de la industria como AMD, Anthropic y Cloudflare ofrecen insights valiosos sobre el futuro de la computación. Este artículo examina los aspectos técnicos clave derivados de entrevistas recientes publicadas por Wired, enfocándose en los avances en procesadores para IA, los enfoques éticos en el entrenamiento de modelos grandes y las estrategias de ciberseguridad en entornos distribuidos. Se analizan conceptos como la arquitectura de GPUs, los mecanismos de alineación en IA y los protocolos de encriptación edge, con énfasis en sus implicaciones operativas y regulatorias para profesionales del sector.

AMD y la Evolución de los Procesadores para Carga de Trabajo en IA

AMD ha consolidado su posición como un actor clave en el ecosistema de hardware para IA mediante el desarrollo de procesadores de alto rendimiento optimizados para tareas de aprendizaje profundo. En las discusiones técnicas, se destaca el rol de la familia Instinct, particularmente los aceleradores MI300X, que integran memoria HBM3 de alta velocidad para manejar volúmenes masivos de datos en entrenamiento de modelos. Esta arquitectura permite un ancho de banda de memoria superior a 5 TB/s, lo que reduce significativamente los cuellos de botella en operaciones de matrix multiplication, fundamentales en redes neuronales convolucionales (CNN) y transformadores.

Desde un punto de vista técnico, los chips de AMD compiten directamente con soluciones como las GPUs de NVIDIA, pero incorporan innovaciones en el diseño de chipslet, que divide el procesador en módulos interconectados mediante Infinity Fabric. Esta aproximación no solo mejora la escalabilidad, permitiendo configuraciones de hasta 8 nodos en un solo sistema, sino que también optimiza el consumo energético, un factor crítico en centros de datos donde el entrenamiento de un modelo como GPT-4 puede requerir gigavatios-hora. Implicancias operativas incluyen la integración con frameworks como ROCm, el stack de software abierto de AMD, que soporta bibliotecas como PyTorch y TensorFlow sin dependencias propietarias, facilitando la portabilidad de workloads en entornos híbridos.

En términos de ciberseguridad, los procesadores de AMD incorporan características como Secure Encrypted Virtualization (SEV), que protege contra ataques de side-channel en entornos virtualizados. SEV encripta la memoria de las máquinas virtuales en tiempo real utilizando claves generadas por hardware, mitigando riesgos como Spectre y Meltdown. Esto es particularmente relevante para aplicaciones de IA en la nube, donde la confidencialidad de datos de entrenamiento es esencial para cumplir con regulaciones como el GDPR en Europa o la CCPA en Estados Unidos. Los beneficios incluyen una reducción en la latencia de encriptación hasta un 50% comparado con soluciones software, aunque persisten desafíos en la gestión de claves en clústeres distribuidos.

Adicionalmente, AMD explora la integración de IA en edge computing mediante procesadores Ryzen AI, que incorporan unidades de procesamiento neuronal (NPU) dedicadas. Estas NPUs ejecutan inferencia en dispositivos locales con un TDP inferior a 15W, habilitando aplicaciones como visión por computadora en tiempo real sin depender de la nube. Técnicamente, esto involucra optimizaciones en cuantización de modelos, reduciendo la precisión de 32 bits a 8 bits para mantener la precisión mientras se minimiza el footprint computacional. Las implicancias regulatorias abarcan la necesidad de estándares como ISO/IEC 42001 para gestión de sistemas de IA, asegurando que estos dispositivos cumplan con principios de privacidad por diseño.

Anthropic: Enfoques Éticos y Técnicos en el Desarrollo de Modelos de IA Generativa

Anthropic, fundada por exinvestigadores de OpenAI, se posiciona como un referente en el desarrollo responsable de IA, con énfasis en modelos como Claude, que priorizan la alineación con valores humanos. En las entrevistas analizadas, se profundiza en el uso de técnicas de constitutional AI, un marco donde los modelos se entrenan bajo “constituciones” definidas que establecen reglas éticas, como evitar sesgos o generar contenido perjudicial. Este enfoque técnico implica un entrenamiento en dos etapas: primero, un pre-entrenamiento supervisado con datasets curados para minimizar toxicidad, y segundo, un fine-tuning con reinforcement learning from human feedback (RLHF), donde retroalimentación humana guía la optimización de políticas.

Conceptualmente, la constitutional AI extiende el RLHF al incorporar chequeos automáticos durante la inferencia, utilizando un modelo auxiliar para evaluar respuestas contra principios predefinidos. Esto reduce la tasa de alucinaciones en un 30-40%, según métricas internas, y mejora la robustez contra jailbreaks, ataques donde usuarios intentan eludir safeguards mediante prompts manipuladores. En ciberseguridad, esto se traduce en mecanismos de defensa como watermarking en outputs generados, que embedden patrones detectables para rastrear fugas de datos sensibles, alineándose con estándares NIST para IA trustworthy.

Desde la perspectiva de infraestructura, Anthropic colabora con proveedores como AWS y Google Cloud para escalar entrenamiento en clústeres de miles de GPUs. Un desafío técnico clave es la distribución de gradientes en entrenamiento paralelo, resuelto mediante algoritmos como AllReduce en frameworks como JAX, que sincronizan actualizaciones de pesos en nodos distribuidos con latencia sub-milisegundo. Las implicancias operativas incluyen costos elevados, estimados en millones por modelo, pero con beneficios en eficiencia: Claude 3 procesa consultas complejas con un contexto de 200k tokens, superando límites previos y habilitando aplicaciones en análisis legal o médico.

Regulatoriamente, Anthropic aboga por marcos como el AI Act de la UE, que clasifica modelos por riesgo. Sus prácticas incorporan auditorías de sesgo utilizando métricas como disparate impact, midiendo desigualdades en outputs para grupos demográficos. Riesgos identificados incluyen el overfitting ético, donde safeguards excesivos limitan utilidad, y beneficios como mayor adopción en sectores regulados, donde la trazabilidad de decisiones de IA es obligatoria. En resumen, el enfoque de Anthropic representa un avance en la gobernanza técnica de IA, integrando seguridad por diseño en el ciclo de vida del modelo.

Cloudflare: Innovaciones en Seguridad y Rendimiento en la Nube Distribuida

Cloudflare lidera en la provisión de servicios de edge computing y ciberseguridad, con una red global que abarca más de 300 ciudades. Las discusiones técnicas resaltan su plataforma Workers, que permite ejecución serverless en el borde, reduciendo latencia para aplicaciones web y API. Técnicamente, Workers utilizan un runtime basado en V8 isolates, contenedores ligeros que aíslan código JavaScript sin overhead de VMs tradicionales, soportando hasta 50ms de cold start y escalabilidad automática.

En ciberseguridad, Cloudflare implementa Zero Trust Architecture (ZTA), verificando cada solicitud independientemente del origen. Esto involucra protocolos como mTLS (mutual Transport Layer Security) para autenticación bidireccional y WAF (Web Application Firewall) con reglas basadas en machine learning para detectar anomalías. Por ejemplo, su sistema de threat scoring utiliza modelos de detección de outliers en tráfico HTTP, identificando DDoS en tiempo real con precisión superior al 99%, mitigando ataques que superan los 100 Tbps, como el registrado en 2023.

Una innovación clave es la integración de IA en su suite de seguridad, con herramientas como Bot Management que emplean behavioral analysis para diferenciar bots legítimos de maliciosos. Esto se basa en features como TTL de cookies y patrones de navegación, procesados por modelos supervisados que actualizan pesos dinámicamente. Implicancias operativas incluyen una reducción en falsos positivos del 70%, crucial para e-commerce, y beneficios en compliance con PCI-DSS para procesamiento de pagos seguros.

Cloudflare también avanza en privacidad con Encrypted Client Hello (ECH), una extensión de TLS 1.3 que oculta metadatos de SNI (Server Name Indication), protegiendo contra vigilancia pasiva. En entornos de IA, esto habilita despliegues seguros de inferencia en edge, donde datos sensibles se procesan localmente sin exposición a la red central. Desafíos regulatorios abarcan la armonización con leyes como la CLOUD Act en EE.UU., que exige acceso a datos en tránsito, resuelto mediante geo-fencing para restringir accesos por jurisdicción.

Adicionalmente, la colaboración con proyectos blockchain integra Workers con entornos Web3, soportando smart contracts en chains como Ethereum mediante APIs de bajo latencia. Esto facilita dApps con verificación de proofs en edge, reduciendo costos de gas y mejorando resiliencia contra fallos de nodo. Las implicancias en ciberseguridad incluyen protección contra 51% attacks mediante distribución geográfica, alineada con mejores prácticas de NIST SP 800-53 para sistemas distribuidos.

Intersecciones Técnicas y Implicaciones en el Ecosistema Tecnológico

La convergencia de avances en AMD, Anthropic y Cloudflare ilustra un ecosistema interconectado donde hardware, software de IA y infraestructura de red se complementan. Por instancia, los procesadores de AMD potencian el entrenamiento de modelos como los de Anthropic, mientras que la red de Cloudflare distribuye inferencia de manera segura. Técnicamente, esto implica estándares como ONNX para interoperabilidad de modelos, permitiendo exportar pesos de entrenamiento a entornos edge sin pérdida de precisión.

En ciberseguridad, un riesgo común es la cadena de suministro: vulnerabilidades en hardware (e.g., supply chain attacks en chips) pueden propagarse a modelos de IA y servicios cloud. Mitigaciones incluyen SBOM (Software Bill of Materials) para trazabilidad y zero-trust en pipelines CI/CD. Beneficios operativos abarcan escalabilidad: un clúster AMD en Cloudflare puede entrenar modelos Anthropic-like en horas, no días, con encriptación end-to-end.

Regulatoriamente, el panorama evoluciona con iniciativas como el Executive Order on AI de Biden, que exige evaluaciones de riesgo para modelos de alto impacto. Empresas como estas deben adoptar frameworks como el AI Risk Management Framework de NIST, integrando pruebas de adversarial robustness y fairness audits. En blockchain, aunque no central en las entrevistas, la integración con Cloudflare sugiere aplicaciones en IA descentralizada, como federated learning para preservar privacidad.

Desafíos persistentes incluyen el consumo energético: entrenamiento de IA representa el 2-3% de la electricidad global proyectada para 2030, impulsando innovaciones en cooling líquido para chips AMD y optimizaciones en Workers. Beneficios en innovación incluyen avances en multimodal IA, donde Claude procesa texto e imágenes en edge, habilitando AR/VR seguros.

| Empresa | Tecnología Clave | Aplicación en IA/Ciberseguridad | Implicancia Operativa |

|---|---|---|---|

| AMD | Instinct MI300X con HBM3 | Aceleración de entrenamiento de modelos | Escalabilidad en clústeres con bajo consumo |

| Anthropic | Constitutional AI y RLHF | Alineación ética en generativa | Reducción de sesgos y alucinaciones |

| Cloudflare | Workers y Zero Trust | Seguridad edge para inferencia | Latencia baja y mitigación DDoS |

Esta tabla resume las contribuciones técnicas, destacando su sinergia en workflows integrados.

Conclusión: Hacia un Futuro de IA Segura y Eficiente

Los insights de AMD, Anthropic y Cloudflare delinean un panorama donde la innovación técnica impulsa no solo el rendimiento, sino también la resiliencia y ética en la IA. Al integrar hardware de vanguardia, modelos alineados y redes seguras, el sector avanza hacia sistemas más accesibles y confiables. Para profesionales en ciberseguridad y tecnologías emergentes, estas evoluciones demandan actualización continua en estándares y prácticas, asegurando que los beneficios superen los riesgos en un ecosistema cada vez más interdependiente. En última instancia, este enfoque colaborativo promete transformar industrias, desde la salud hasta las finanzas, con soluciones robustas y escalables.

Para más información, visita la fuente original.