El Caso del Robot Humanoide Boris: Análisis Técnico de un Engaño en la Robótica y la Inteligencia Artificial

En el ámbito de la robótica y la inteligencia artificial (IA), las presentaciones públicas de avances tecnológicos suelen generar expectativas elevadas entre la comunidad profesional y el público general. Sin embargo, el caso del robot humanoide Boris, anunciado por Rusia en 2018, representa un ejemplo paradigmático de cómo la desinformación puede socavar la credibilidad de los desarrollos en estas disciplinas. Este incidente no solo cuestiona la integridad de ciertas demostraciones tecnológicas, sino que también invita a un análisis profundo de los estándares técnicos, éticos y operativos en la robótica humanoide. A lo largo de este artículo, se examinarán los aspectos técnicos subyacentes, las implicaciones para la industria y las lecciones aprendidas para futuras innovaciones en IA y robótica.

Contexto Histórico del Incidente con Boris

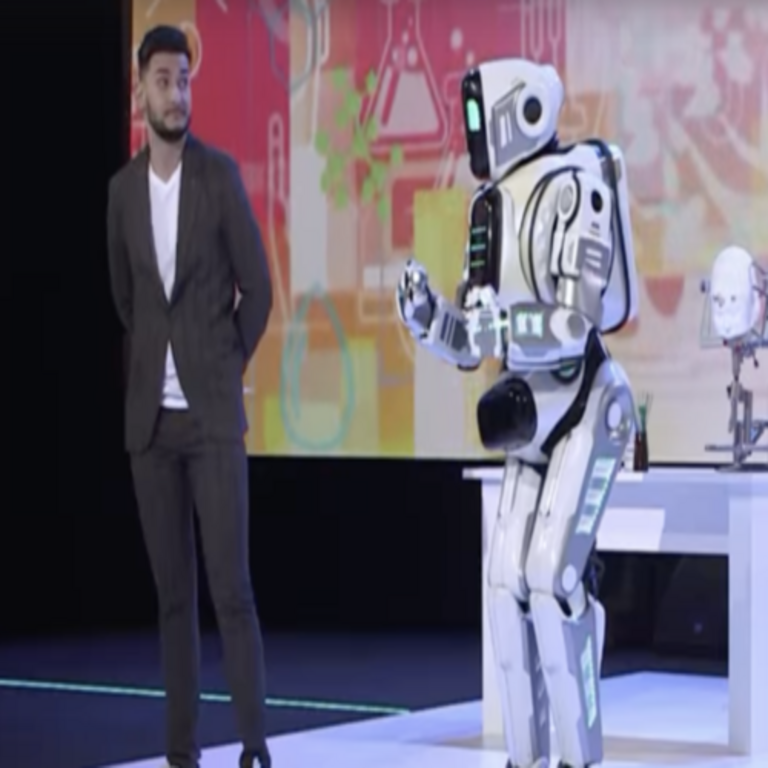

El año 2018 marcó un hito en la promoción de capacidades tecnológicas rusas cuando se presentó el robot humanoide Boris durante un foro internacional en Moscú. Desarrollado supuestamente por la empresa Promobot, el dispositivo fue descrito como un avance en robótica autónoma, capaz de interactuar con entornos humanos mediante gestos, movimientos y respuestas verbales. Boris se exhibió realizando acciones como caminar, saludar y responder preguntas, lo que generó cobertura mediática extensa y comparaciones con robots líderes como el ASIMO de Honda o el Atlas de Boston Dynamics.

Sin embargo, investigaciones posteriores revelaron que Boris no era un robot autónomo, sino un operador humano disfrazado dentro de un exoesqueleto. Esta revelación surgió de anomalías observadas en videos de la demostración, como movimientos rígidos y respuestas no sincronizadas con la latencia esperada de sistemas IA. Técnicamente, un robot humanoide real depende de una integración compleja de subsistemas: actuadores hidráulicos o eléctricos para movilidad, sensores LIDAR y cámaras para percepción ambiental, y algoritmos de machine learning para procesamiento cognitivo. En contraste, el disfraz utilizado en Boris carecía de estos componentes, limitándose a un mecanismo mecánico pasivo que simulaba articulación sin autonomía real.

Desde una perspectiva técnica, este engaño resalta la importancia de los protocolos de validación en presentaciones robóticas. Organismos como la IEEE (Institute of Electrical and Electronics Engineers) establecen estándares como el IEEE 1872 para ontologías de robótica, que exigen documentación detallada de capacidades y limitaciones. La ausencia de tales verificaciones en el caso de Boris subraya riesgos operativos, incluyendo la propagación de expectativas irreales que podrían desviar inversiones en investigación genuina.

Tecnologías Fundamentales en Robótica Humanoide

Para comprender el impacto del caso Boris, es esencial revisar las tecnologías subyacentes en la robótica humanoide auténtica. Un robot como Boris pretendía emular la biomecánica humana, lo que implica desafíos en cinemática, control dinámico y percepción sensorial. La cinemática inversa, por ejemplo, es un pilar matemático que resuelve la posición de articulaciones dadas coordenadas finales, utilizando ecuaciones como las de Denavit-Hartenberg para modelar cadenas cinemáticas. En robots reales, esto se implementa mediante controladores PID (Proporcional-Integral-Derivativo) para estabilizar movimientos, integrados con IA para aprendizaje por refuerzo, como en el framework ROS (Robot Operating System).

En términos de IA, los humanoides incorporan redes neuronales convolucionales (CNN) para visión por computadora, procesando datos de cámaras RGB-D para detección de objetos y navegación. El caso de Boris ilustra una falla en la simulación de estas capacidades: un operador humano no puede replicar la latencia sub-milisegundo de un sistema embebido con GPUs como NVIDIA Jetson, ni la robustez ante ruido ambiental que ofrece el filtrado Kalman en fusión sensorial. Comparativamente, el robot Pepper de SoftBank utiliza módulos de IA basados en NAOqi, permitiendo interacciones multimodales reales, mientras que Boris dependía de control manual, lo que limita su escalabilidad a entornos no controlados.

Adicionalmente, la energía y la durabilidad representan barreras técnicas. Robots humanoides genuinos, como el iCub del IIT (Istituto Italiano di Tecnologia), emplean baterías de litio-ion con gestión térmica avanzada para sesiones prolongadas, contrastando con el disfraz de Boris, que no enfrentaba demandas energéticas reales pero fallaba en pruebas de autonomía. Estas discrepancias técnicas no solo exponen el engaño, sino que destacan la necesidad de benchmarks estandarizados, como los propuestos por la RoboCup Federation, para evaluar rendimiento en tareas como manipulación y locomoción.

- Actuadores y Movilidad: En humanoides reales, servomotores brushless proporcionan torque preciso, con retroalimentación de encoders ópticos para control cerrado. Boris simulaba esto con mecanismos hidráulicos pasivos, incapaces de adaptarse dinámicamente.

- Percepción y Sensores: Sensores IMU (Unidades de Medición Inercial) y ToF (Time-of-Flight) permiten mapeo SLAM (Simultaneous Localization and Mapping). La falta de estos en Boris resultó en movimientos predecibles y no reactivos.

- Procesamiento IA: Algoritmos de deep learning, como los de TensorFlow o PyTorch, manejan toma de decisiones. El operador humano equivalía a un bucle de control manual, propenso a errores humanos.

Estas tecnologías no solo definen la viabilidad de un robot, sino que también influyen en aplicaciones prácticas, desde asistencia médica hasta exploración espacial, donde la fiabilidad es crítica.

Implicaciones Éticas y Regulatorias en la Industria Robótica

El engaño de Boris plantea interrogantes éticos profundos en la divulgación tecnológica. En ciberseguridad, análogos como demostraciones falsas de software de IA pueden erosionar la confianza, similar a vulnerabilidades en sistemas de autenticación biométrica. La Unión Europea, mediante el Reglamento de IA de 2024, clasifica aplicaciones de alto riesgo como la robótica humanoide, exigiendo evaluaciones de conformidad y transparencia en datos de entrenamiento. Rusia, aunque no adherida directamente, enfrenta presiones internacionales para alinear sus prácticas con estándares globales, evitando incidentes que fomenten percepciones de opacidad en innovación tecnológica.

Desde el punto de vista operativo, este caso resalta riesgos de desinformación en blockchain y IA, donde la verificación inmutable de avances podría mitigarse mediante registros distribuidos. Por ejemplo, plataformas como GitHub para código abierto o IPFS para documentación técnica permiten auditorías independientes, contrastando con la opacidad de la presentación de Boris. Beneficios potenciales incluyen una mayor inversión en R&D genuina, pero riesgos como la dilución de fondos públicos persisten si no se implementan mecanismos de verificación, tales como pruebas en entornos controlados bajo supervisión de entidades como NIST (National Institute of Standards and Technology).

En términos regulatorios, el incidente subraya la necesidad de marcos como el GDPR para datos en IA robótica, asegurando que demostraciones no manipulen percepciones públicas. Implicancias incluyen sanciones por fraude tecnológico, similares a las aplicadas en casos de deepfakes, y la promoción de certificaciones ISO 13482 para robots de servicio personal, que exigen pruebas de seguridad y autonomía.

Comparación con Avances Reales en Robótica Humanoide

Para contextualizar Boris, es instructivo comparar con desarrollos auténticos. El robot Sophia de Hanson Robotics, activado en 2016, integra IA conversacional basada en scripts GPT-like y reconocimiento facial con OpenCV, permitiendo interacciones fluidas en conferencias. A diferencia de Boris, Sophia ha sido sometido a escrutinio público, revelando limitaciones como dependencia de prompts predefinidos, pero manteniendo transparencia técnica.

Otro referente es el Atlas de Boston Dynamics, que desde 2013 ha evolucionado mediante control dinámico con modelos de física basada en simulación (Gazebo o MuJoCo), demostrando parkour y manipulación dinámica. Técnicamente, Atlas emplea controladores MPC (Model Predictive Control) para optimizar trayectorias en tiempo real, procesando datos de sensores a 100 Hz. El disfraz de Boris, en cambio, no podía manejar perturbaciones externas, como cambios en terreno, destacando la superioridad de sistemas autónomos en entornos variables.

En el panorama ruso, proyectos genuinos como el robot FEDOR (Final Examination before Overall Retirement), desplegado en 2019 para tareas espaciales, utilizan brazos robóticos con 7 grados de libertad y visión estéreo para ensamblaje. FEDOR integra ROS2 para orquestación, contrastando con la simplicidad de Boris y demostrando capacidades reales en microgravedad, probadas en la Estación Espacial Internacional.

| Aspecto Técnico | Boris (2018) | Atlas (Boston Dynamics) | FEDOR (Rusia) |

|---|---|---|---|

| Autonomía | Manual (operador humano) | Alta (IA con aprendizaje por refuerzo) | Media (teleoperación con IA asistida) |

| Sensores | Ninguno (simulación visual) | LIDAR, IMU, cámaras 360° | Cámaras estéreo, encoders |

| Control | Mecánico pasivo | MPC dinámico | ROS-based |

| Aplicaciones | Demostración promocional | Investigación industrial | Espacial y militar |

Esta tabla ilustra las brechas técnicas, enfatizando cómo avances reales priorizan integración de hardware y software sobre apariencias superficiales.

Lecciones Aprendidas y Futuro de la Robótica e IA

El caso Boris sirve como catalizador para mejoras en la industria. En ciberseguridad, integra consideraciones de verificación de integridad, como firmas digitales para firmware robótico, previniendo manipulaciones en demostraciones. Para IA, promueve el uso de explainable AI (XAI), donde modelos como LIME (Local Interpretable Model-agnostic Explanations) desglosan decisiones, asegurando transparencia ausente en Boris.

Operativamente, empresas deben adoptar pipelines de desarrollo ágiles con pruebas unitarias y simulaciones virtuales, utilizando herramientas como Unity Robotics Hub para validar comportamientos antes de presentaciones físicas. Beneficios incluyen una percepción pública más informada, fomentando colaboraciones internacionales en estándares como el IEEE P3333 para métricas de rendimiento en humanoides.

Riesgos persistentes abarcan la amplificación de narrativas nacionalistas en tecnología, donde engaños como Boris podrían escalar a desinformación en blockchain para certificados falsos de avances. Mitigaciones involucran auditorías independientes y foros como la World Robotics Conference para validación colectiva.

En el ámbito de tecnologías emergentes, este incidente acelera la integración de IA ética, con frameworks como el de la UNESCO para robótica responsable, enfatizando impacto social. Para profesionales en ciberseguridad e IA, representa un recordatorio de la intersección entre innovación y veracidad, impulsando protocolos robustos contra fraudes tecnológicos.

Avances Actuales y Perspectivas en Robótica Post-Boris

Desde 2018, la robótica humanoide ha progresado significativamente, influida indirectamente por escrutinios como el de Boris. Proyectos como el Optimus de Tesla, anunciado en 2021, buscan humanoides para manufactura, integrando IA de vehículos autónomos con redes neuronales transformer para planificación secuencial. Técnicamente, Optimus utiliza actuadores lineales eléctricos con un peso de 73 kg, optimizado para eficiencia energética mediante control predictivo, superando limitaciones de disfraces manuales.

En IA, avances en multimodalidad permiten humanoides como el Figure 01, que procesa lenguaje natural con GPT-4 y visión con CLIP, habilitando tareas conversacionales complejas. Estos sistemas emplean arquitecturas de grafos de conocimiento para razonamiento, contrastando con la simplicidad de Boris y demostrando escalabilidad en entornos reales.

En blockchain, aplicaciones emergentes como tokens no fungibles (NFT) para patentes robóticas aseguran trazabilidad de innovaciones, previniendo reclamos falsos. Protocolos como Ethereum permiten smart contracts para licencias de software robótico, integrando verificación descentralizada que podría haber expuesto el engaño de Boris tempranamente.

Regulatoriamente, la FDA en EE.UU. y equivalentes europeos exigen ensayos clínicos para humanoides en salud, incorporando métricas de fiabilidad post-incidentes como Boris. En Latinoamérica, iniciativas como las de Brasil en CONICET promueven colaboraciones para robótica ética, enfocadas en accesibilidad y transparencia.

Desde una lente de ciberseguridad, vulnerabilidades en humanoides incluyen ataques a sensores vía jamming de señales, mitigados por encriptación AES-256 y protocolos zero-trust. El caso Boris resalta la necesidad de ciber-resiliencia en presentaciones, donde simulaciones podrían ser hackeadas para alterar percepciones.

En resumen, el legado de Boris radica en su rol como advertencia técnica, impulsando una era de robótica más verificable y ética. Los profesionales deben priorizar documentación rigurosa y pruebas empíricas, asegurando que avances en IA y robótica beneficien a la sociedad sin compromisos en integridad.

Para más información, visita la fuente original.