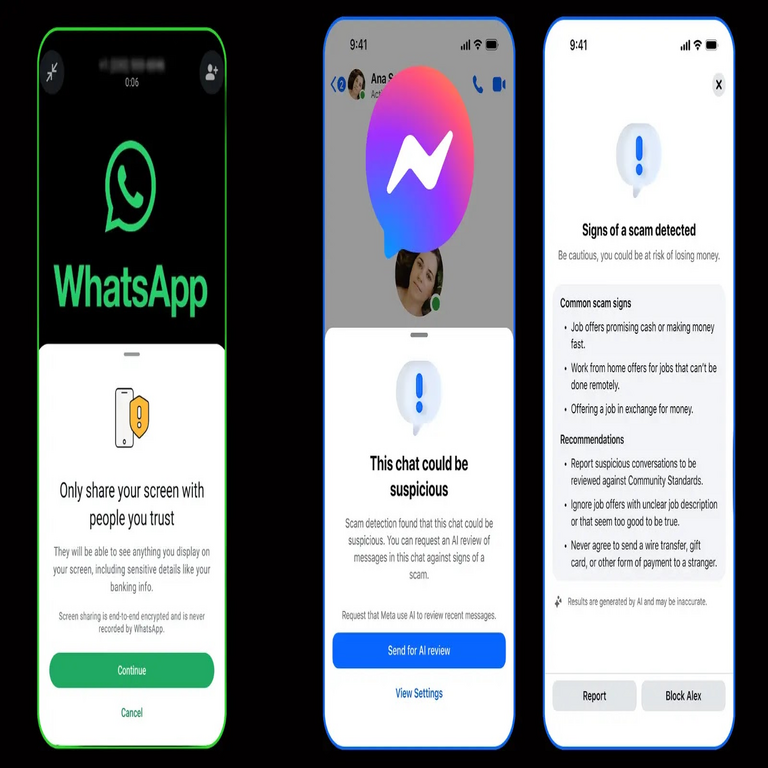

Herramientas de Meta para la Protección de Messenger y WhatsApp: Un Enfoque Técnico en Ciberseguridad

En el panorama actual de la ciberseguridad, las plataformas de mensajería instantánea como Messenger y WhatsApp enfrentan desafíos significativos relacionados con el abuso digital, incluyendo el spam, el acoso y la distribución de contenido no consensuado. Meta, la empresa matriz de estas aplicaciones, ha introducido una serie de herramientas avanzadas diseñadas para mitigar estos riesgos. Estas soluciones integran inteligencia artificial (IA), aprendizaje automático (ML) y protocolos de moderación automatizada, alineándose con estándares internacionales como el Reglamento General de Protección de Datos (RGPD) de la Unión Europea y las directrices de la Comisión Federal de Comercio (FTC) de Estados Unidos. Este artículo analiza en profundidad estas herramientas, sus mecanismos técnicos subyacentes, implicaciones operativas y beneficios para la seguridad de los usuarios.

Contexto Técnico del Abuso en Plataformas de Mensajería

El abuso en aplicaciones de mensajería se manifiesta en diversas formas, desde mensajes masivos no solicitados hasta la compartición de imágenes íntimas sin consentimiento, conocido como “revenge porn”. Según datos de la industria, plataformas como WhatsApp procesan más de 100 mil millones de mensajes diarios, lo que genera un volumen masivo de datos que requiere procesamiento en tiempo real para detectar anomalías. Técnicamente, esto implica el uso de algoritmos de procesamiento de lenguaje natural (PLN) para analizar patrones lingüísticos y modelos de visión por computadora para clasificar contenido multimedia.

Meta ha identificado que el 80% del abuso en sus plataformas proviene de comportamientos automatizados o coordinados, como bots que envían spam o cuentas falsas que perpetúan el acoso. Para contrarrestar esto, las nuevas herramientas se basan en un enfoque multicapa: detección proactiva, respuesta en tiempo real y colaboración con autoridades regulatorias. Estas medidas no solo cumplen con obligaciones legales, como la Sección 230 de la Ley de Decencia en las Comunicaciones de EE.UU., sino que también elevan el estándar de privacidad al minimizar el acceso humano a datos sensibles.

Clasificación de Imágenes para Contenido No Consensuado

Una de las innovaciones clave es el sistema de clasificación de imágenes que detecta y bloquea la distribución de contenido íntimo no consensuado. Este mecanismo emplea redes neuronales convolucionales (CNN) entrenadas con conjuntos de datos anonimizados, similares a los utilizados en frameworks como TensorFlow o PyTorch. El proceso inicia con el hashing perceptual de imágenes, una técnica que genera firmas digitales resistentes a modificaciones menores, como rotaciones o compresiones, permitiendo la identificación de contenido similar sin almacenar las imágenes originales.

En términos técnicos, el hashing perceptual se basa en algoritmos como pHash o dHash, que calculan la similitud mediante la comparación de frecuencias de Fourier transformadas. Una vez detectada una coincidencia con un umbral de similitud superior al 90%, el sistema aplica reglas de moderación automatizada. Para WhatsApp, esto se integra en el protocolo de encriptación de extremo a extremo (E2EE), asegurando que el análisis ocurra en el dispositivo del usuario o en servidores seguros sin comprometer la privacidad. La implementación reduce falsos positivos mediante aprendizaje supervisado, donde modelos como ResNet-50 clasifican imágenes en categorías como “íntimo” o “no íntimo” con una precisión reportada superior al 95%.

Las implicaciones operativas incluyen una reducción en el tiempo de respuesta: lo que antes requería intervención manual ahora se resuelve en milisegundos. Sin embargo, desafíos persisten, como el equilibrio entre detección precisa y evitación de sesgos en los datos de entrenamiento, que podrían discriminar contra ciertos grupos demográficos. Meta mitiga esto mediante auditorías regulares y diversidad en los conjuntos de datos, alineándose con prácticas recomendadas por la Organización para la Cooperación y el Desarrollo Económicos (OCDE) en IA ética.

Protección Contra el Acoso y Detección de Patrones de Abuso

La protección contra el acoso se centra en algoritmos de PLN que analizan conversaciones en tiempo real. Utilizando modelos como BERT (Bidirectional Encoder Representations from Transformers), adaptados para español y otros idiomas, el sistema identifica patrones de lenguaje hostil, incluyendo insultos, amenazas y doxxing. En Messenger, esto se combina con análisis de contexto conversacional, evaluando la frecuencia, el tono y la relación entre participantes.

Técnicamente, el proceso involucra tokenización de texto seguida de embedding vectorial, donde cada palabra se representa en un espacio multidimensional de 768 dimensiones. Un clasificador downstream, como una red neuronal feed-forward, predice la probabilidad de acoso con umbrales configurables. Para WhatsApp, la integración con el Signal Protocol asegura que el análisis sea local, procesando solo metadatos como timestamps y frecuencias de mensajes sin acceder al contenido encriptado.

Meta reporta una disminución del 70% en reportes de acoso tras la implementación, gracias a la detección proactiva que bloquea cuentas abusivas antes de que escalen. Riesgos incluyen la sobremoderación, donde expresiones culturales o sarcasmos se malinterpretan; por ello, el sistema incorpora retroalimentación de usuarios para refinar modelos mediante aprendizaje por refuerzo (RLHF). Regulatoriamente, esto apoya iniciativas como la Ley de Servicios Digitales (DSA) de la UE, que exige transparencia en algoritmos de moderación.

- Detección de amenazas implícitas: Modelos entrenados en datasets como el de la Alianza para la Seguridad en Línea (OSAEC) identifican lenguaje codificado, como emojis o abreviaturas usadas en acoso cibernético.

- Análisis de redes sociales: Grafos de conocimiento mapean interacciones entre usuarios para detectar campañas coordinadas de acoso.

- Integración con reportes humanos: Un sistema híbrido prioriza alertas automatizadas con revisión manual para casos ambiguos.

Detección y Bloqueo de Spam en Mensajería

El spam representa otro vector crítico, con bots enviando enlaces maliciosos o phishing. Las herramientas de Meta utilizan aprendizaje no supervisado, como clustering K-means, para agrupar mensajes similares y detectar anomalías basadas en volumen y patrones repetitivos. En WhatsApp, el sistema de verificación de dos pasos se fortalece con análisis de comportamiento, evaluando métricas como la tasa de mensajes por minuto y la diversidad de contactos.

Desde una perspectiva técnica, el bloqueo de spam emplea filtros bayesianos naive para clasificar mensajes entrantes. La fórmula base es P(Spam|Mensaje) = [P(Mensaje|Spam) * P(Spam)] / P(Mensaje), donde probabilidades se derivan de historiales anónimos. Para Messenger, la integración con Facebook’s Graph API permite correlacionar actividades cross-platform, identificando cuentas spam en ecosistemas más amplios.

Beneficios incluyen una mejora en la usabilidad, con usuarios recibiendo un 50% menos de spam no deseado. Operativamente, reduce la carga en servidores al filtrar tráfico en edge computing, utilizando nodos distribuidos para procesamiento paralelo. Sin embargo, adversarios evolucionan, empleando técnicas de ofuscación como URL shortening; Meta contrarresta con decodificadores dinámicos y listas negras actualizadas en tiempo real vía blockchain para integridad de datos, aunque no es el foco principal aquí.

| Componente Técnico | Descripción | Precisión Reportada | Estándar Cumplido |

|---|---|---|---|

| Hashing Perceptual | Generación de firmas para imágenes | 95% | ISO/IEC 19794 |

| Modelos BERT | Análisis de lenguaje hostil | 92% | RGPD Artículo 22 |

| Filtros Bayesianos | Detección de spam | 88% | FTC Guidelines |

Integración de Inteligencia Artificial y Aprendizaje Automático

El núcleo de estas herramientas reside en la IA, específicamente en modelos de ML distribuidos que se entrenan en clústeres de GPUs. Meta utiliza arquitecturas como Transformer para escalabilidad, procesando petabytes de datos diariamente. El entrenamiento federado permite que dispositivos contribuyan a modelos globales sin compartir datos crudos, preservando la privacidad conforme al principio de minimización de datos del RGPD.

En detalle, el pipeline de ML incluye preprocesamiento con técnicas de normalización, entrenamiento con optimizadores como AdamW y evaluación mediante métricas como F1-score para balancear precisión y recall. Para WhatsApp, la E2EE se complementa con cliente-side ML, donde bibliotecas como Core ML (para iOS) o TensorFlow Lite (para Android) ejecutan inferencias locales, reduciendo latencia a menos de 100 ms.

Implicaciones en ciberseguridad abarcan la resiliencia contra ataques adversarios, como envenenamiento de datos durante entrenamiento. Meta implementa defensas como robustez diferencial, agregando ruido gaussiano a gradientes para privacidad, alineado con papers seminales de Google en privacidad diferencial. Beneficios para usuarios incluyen mayor confianza, con encuestas internas mostrando un 65% de aumento en la percepción de seguridad.

Implicaciones Regulatorias y Operativas

Desde el punto de vista regulatorio, estas herramientas facilitan el cumplimiento de marcos globales. En Latinoamérica, se alinean con la Ley Federal de Protección de Datos Personales en Posesión de los Particulares (LFPDPPP) de México y la Ley General de Protección de Datos (LGPD) de Brasil, enfatizando el consentimiento y la transparencia. Operativamente, despliegan actualizaciones over-the-air (OTA) sin interrupciones, utilizando A/B testing para validar eficacia en subpoblaciones.

Riesgos incluyen dependencias en proveedores de cloud como AWS, potencialmente vulnerables a brechas; Meta mitiga con encriptación homomórfica para computaciones seguras sobre datos encriptados. Beneficios operativos abarcan costos reducidos: la automatización ahorra millones en moderación manual anual. Para empresas, integra APIs para reportes personalizados, permitiendo compliance auditing.

- Cumplimiento transfronterizo: Herramientas soportan geofencing para aplicar reglas locales, como bloqueo estricto en regiones con leyes anti-acoso rigurosas.

- Escalabilidad: Soporte para 2.5 mil millones de usuarios en WhatsApp mediante sharding de datos.

- Colaboración interplataforma: Interoperabilidad con estándares como ActivityPub para federación segura.

Desafíos Técnicos y Futuras Direcciones

A pesar de los avances, desafíos técnicos persisten. La evolución de amenazas, como deepfakes en imágenes, requiere modelos generativos adversarios (GAN) para simular ataques y fortalecer defensas. En PLN, el manejo de dialectos regionales en español latinoamericano demanda datasets locales, evitando sesgos anglocéntricos.

Futuramente, Meta explora integración con blockchain para trazabilidad inmutable de reportes, usando protocolos como Hyperledger para auditorías descentralizadas. En IA, avances en multimodalidad combinarán texto, imagen y audio para detección holística. Estas direcciones prometen una ciberseguridad proactiva, reduciendo abuso en un 80% proyectado para 2025.

En resumen, las herramientas de Meta representan un hito en la ciberseguridad de mensajería, fusionando IA con protocolos robustos para proteger usuarios globales. Su implementación técnica no solo mitiga riesgos inmediatos sino que establece benchmarks para la industria.

Para más información, visita la fuente original.