Grok 4 sucumbe a un jailbreak dos días después de su lanzamiento

Introducción

Apenas dos días después de su lanzamiento, Grok 4, una herramienta de inteligencia artificial desarrollada por el reconocido laboratorio OpenAI, ha sido objeto de un jailbreak que ha permitido a los usuarios eludir algunas de sus restricciones. Este incidente plantea serias preocupaciones sobre la seguridad y la integridad de los sistemas basados en inteligencia artificial, así como sobre las implicaciones que esto podría tener para el uso responsable y seguro de tales tecnologías.

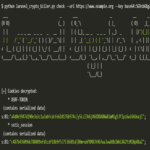

Análisis del jailbreak

El jailbreak aplicado a Grok 4 permite a los usuarios acceder a funciones y capacidades que estaban intencionadamente bloqueadas por sus desarrolladores. Esta situación es especialmente alarmante dado que Grok 4 se posiciona como una herramienta avanzada para la creación de contenido y asistencia en diversas tareas. Los jailbreaks en sistemas de IA pueden llevar a la explotación no autorizada, el mal uso o incluso actividades maliciosas que comprometan datos sensibles o sistemas críticos.

Implicaciones tecnológicas

El hecho de que un sistema tan reciente haya podido ser vulnerado en un tiempo tan corto resalta varios puntos críticos:

- Seguridad del software: La rapidez con la que se ha producido este jailbreak sugiere una falta de robustez en las medidas de seguridad implementadas en Grok 4.

- Confianza del usuario: La capacidad para eludir restricciones genera desconfianza entre los usuarios respecto a la fiabilidad y seguridad del producto.

- Ciberseguridad: El jailbreak abre la puerta a potenciales ciberataques, donde actores malintencionados podrían utilizar estas vulnerabilidades para realizar acciones perjudiciales.

Aspectos operativos y regulatorios

A medida que más empresas adoptan herramientas basadas en IA como Grok 4, es crucial considerar las regulaciones actuales y futuras relacionadas con su uso. Las implicaciones legales podrían incluir:

- Responsabilidad legal: Las organizaciones podrían enfrentar repercusiones si se demuestra que han utilizado herramientas comprometidas para manipular información o realizar actividades ilícitas.

- Cumplimiento normativo: A medida que surgen nuevas normativas sobre protección de datos y ciberseguridad, las empresas deben asegurarse de cumplir con estos estándares al implementar soluciones basadas en IA.

Métodos contra este tipo de vulnerabilidades

Dada la creciente preocupación sobre la seguridad en sistemas inteligentes, las organizaciones deben adoptar medidas proactivas para mitigar riesgos asociados con herramientas como Grok 4. Algunas estrategias incluyen:

- Auditorías regulares: Realizar auditorías frecuentes del software para identificar y corregir vulnerabilidades antes de que sean explotadas.

- Cifrado robusto: Implementar cifrado avanzado tanto para datos en tránsito como en reposo, asegurando así que cualquier acceso no autorizado sea limitado.

- Cultura organizacional consciente: Fomentar una cultura dentro de la organización donde todos los empleados estén informados sobre ciberseguridad y prácticas seguras al utilizar tecnologías emergentes.

Conclusión

El incidente relacionado con el jailbreak de Grok 4 pone en relieve las vulnerabilidades inherentes a las tecnologías emergentes basadas en inteligencia artificial. A medida que estas herramientas se vuelven más sofisticadas y omnipresentes, es imperativo que tanto desarrolladores como usuarios adopten prácticas rigurosas para asegurar su integridad. En este sentido, es fundamental estar atentos a futuras actualizaciones y parches lanzados por OpenAI u otros proveedores similares para mitigar estos riesgos. Para más información visita la Fuente original.