La Revolución de la Inteligencia Artificial en el Doblaje: Análisis Técnico y Desafíos Éticos

La industria del entretenimiento enfrenta una transformación profunda impulsada por la inteligencia artificial (IA), particularmente en el ámbito del doblaje audiovisual. Este proceso, tradicionalmente dependiente de actores especializados, se ve ahora amenazado por avances en síntesis de voz y clonación de audio generados por IA. El reciente fenómeno conocido como “la rebelión del doblaje”, reportado en medios especializados, resalta las tensiones entre innovación tecnológica y protección laboral. En este artículo, se examinan los fundamentos técnicos de estas herramientas de IA, sus aplicaciones en la producción de contenidos multimedia, los riesgos asociados en ciberseguridad y las implicaciones regulatorias, con un enfoque en estándares éticos y mejores prácticas para mitigar impactos negativos.

Fundamentos Técnicos de la Síntesis de Voz con Inteligencia Artificial

La síntesis de voz por texto (Text-to-Speech, TTS) ha evolucionado significativamente desde sus inicios en sistemas rule-based hasta modelos basados en aprendizaje profundo. En el contexto del doblaje, las tecnologías de IA utilizan redes neuronales convolucionales y recurrentes para generar audio natural y expresivo. Un ejemplo clave es el modelo WaveNet, desarrollado por DeepMind en 2016, que emplea una arquitectura de redes neuronales autoregresivas para predecir muestras de audio de manera secuencial. Este enfoque permite replicar no solo el timbre de una voz, sino también matices como entonación, pausas y énfasis emocional, esenciales para el doblaje sincronizado con video.

En aplicaciones prácticas, herramientas como Google Cloud Text-to-Speech o Amazon Polly integran variantes de WaveNet con procesamiento de lenguaje natural (NLP) para adaptar el audio a contextos idiomáticos específicos. Para el doblaje, se combinan con técnicas de clonación de voz, donde modelos como Tacotron 2 convierten texto en espectrogramas mel, posteriormente convertidos en ondas sonoras mediante vocoders como WaveGlow. Estos sistemas requieren datasets extensos de grabaciones humanas, entrenados con algoritmos de aprendizaje supervisado para minimizar distorsiones y lograr una fidelidad superior al 95% en pruebas de percepción humana, según benchmarks del IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP).

La integración de IA en flujos de trabajo de doblaje implica etapas como la transcripción automática del guion original, segmentación fonética y alineación labial mediante visión por computadora. Frameworks como Mozilla TTS o Coqui AI democratizan estas tecnologías, permitiendo a estudios independientes generar doblajes en múltiples idiomas con costos reducidos hasta en un 80% comparado con métodos tradicionales. Sin embargo, esta eficiencia técnica plantea desafíos en la preservación de la autenticidad cultural, ya que los modelos entrenados predominantemente en datos anglosajones pueden introducir sesgos en acentos latinos o indígenas.

Aplicaciones en la Industria del Entretenimiento y Casos de Estudio

En la producción de series y películas, la IA acelera el doblaje para plataformas de streaming como Netflix o Disney+. Un caso emblemático es el uso de ElevenLabs, una plataforma que clona voces de actores con solo minutos de audio de muestra, aplicada en proyectos como el doblaje de animaciones donde se requiere consistencia vocal a lo largo de episodios. Técnicamente, esto involucra extracción de características acústicas mediante análisis de espectro de frecuencia (MFCC, Mel-Frequency Cepstral Coefficients) y entrenamiento de modelos generativos antagónicos (GAN) para refinar la síntesis.

Otro ejemplo es el software Respeecher, utilizado en producciones de Hollywood para recrear voces de actores fallecidos, como en la película “The Mandalorian” de Star Wars, donde se clonó la voz de James Earl Jones. Este proceso emplea redes neuronales de largo corto plazo (LSTM) para capturar patrones prosódicos, asegurando sincronía con movimientos labiales mediante algoritmos de alineación temporal como el Dynamic Time Warping (DTW). En México y América Latina, estudios como New Art Dub han experimentado con IA para doblar telenovelas, reduciendo tiempos de producción de semanas a días, pero generando controversia entre sindicatos como la Asociación Nacional de Actores (ANDA).

Desde una perspectiva técnica, estos sistemas se benefician de hardware acelerado por GPU, como las tarjetas NVIDIA A100, que procesan inferencias en tiempo real. La escalabilidad se logra mediante contenedores Docker y orquestación con Kubernetes, permitiendo despliegues en la nube para colaboraciones globales. No obstante, la dependencia de datos propietarios plantea riesgos de violación de derechos de autor, regulados por marcos como la Directiva de Derechos de Autor de la Unión Europea (2019/790), que exige consentimiento explícito para el uso de grabaciones en entrenamiento de IA.

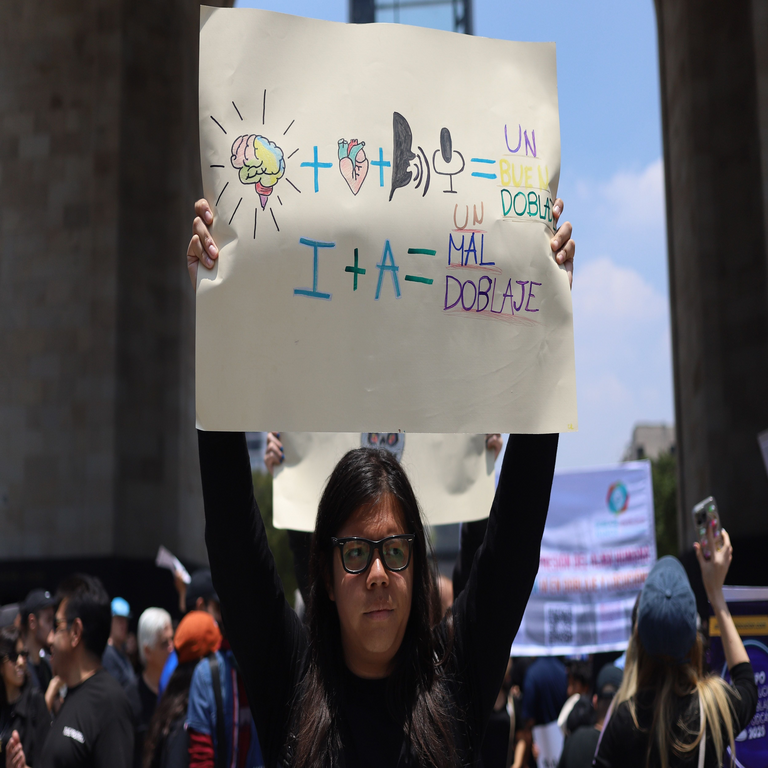

La Rebelión del Doblaje: Impactos Laborales y Sociales

La “rebelión del doblaje” surge como respuesta sindical a la automatización impulsada por IA, con protestas en México y España destacando la pérdida de empleos. Actores argumentan que la clonación de voz deshumaniza el arte del doblaje, eliminando la interpretación emocional que solo un profesional humano puede proporcionar. Técnicamente, mientras que la IA excelsa en eficiencia, falla en contextos culturales complejos; por ejemplo, modelos TTS luchan con modismos regionales o humor idiomático, requiriendo post-procesamiento humano que no siempre compensa la reducción de roles.

En términos operativos, la transición a IA implica reentrenamiento de plantillas, con sindicatos demandando cláusulas en contratos colectivos para limitar su uso. Un informe de la Organización Internacional del Trabajo (OIT, 2023) estima que hasta el 30% de puestos en doblaje podrían automatizarse en la próxima década, afectando economías creativas en Latinoamérica. Para mitigar esto, se proponen híbridos humano-IA, donde la máquina genera borradores y actores refinan, utilizando herramientas como Adobe Sensei para edición colaborativa.

Las implicaciones sociales incluyen desigualdades de género y etnia, ya que datasets de entrenamiento a menudo subrepresentan voces femeninas o minoritarias, perpetuando sesgos algorítmicos. Estudios del MIT Media Lab (2022) muestran que modelos TTS exhiben tasas de error 15% mayores en acentos no estándar, exacerbando brechas en accesibilidad para audiencias diversas.

Riesgos de Ciberseguridad Asociados a la Clonación de Voz

La proliferación de tecnologías de clonación de voz introduce vulnerabilidades significativas en ciberseguridad. Deepfakes de audio, generados por IA, facilitan fraudes como el “vishing” (phishing por voz), donde atacantes imitan voces de ejecutivos para autorizar transacciones. Según un reporte de la Agencia de Ciberseguridad de la Unión Europea (ENISA, 2023), el 70% de incidentes de suplantación de identidad involucran síntesis de voz, explotando debilidades en autenticación biométrica.

Técnicamente, estos ataques utilizan modelos open-source como Tortoise-TTS, que con solo 3-5 segundos de audio de muestra pueden crear imitaciones convincentes. La detección requiere análisis forense de audio, empleando métricas como la relación señal-ruido (SNR) o espectrogramas para identificar artefactos de síntesis, tales como irregularidades en la fase espectral. Herramientas como Deepware Scanner o Microsoft Video Authenticator integran IA para verificar autenticidad, basadas en redes de clasificación convolucionales (CNN) entrenadas en datasets como ASVspoof.

En el ámbito del doblaje, el robo de grabaciones de actores representa un vector de ataque; blockchain emerge como solución para protección de derechos, mediante NFTs que registran ownership de muestras vocales en ledgers distribuidos como Ethereum. Protocolos como IPFS aseguran almacenamiento descentralizado, previniendo manipulaciones no autorizadas. Mejores prácticas incluyen encriptación end-to-end con AES-256 y auditorías regulares de modelos IA para detectar backdoors introducidos durante entrenamiento.

Regulatoriamente, la Ley de IA de la Unión Europea (2024) clasifica sistemas de síntesis de voz de alto riesgo, exigiendo evaluaciones de impacto y transparencia en datasets. En Latinoamérica, México avanza en la Ley Federal de Protección de Datos Personales (actualizada 2023) para regular biometría vocal, mientras que Brasil’s LGPD aborda sesgos en IA. Estos marcos promueven auditorías independientes y sandboxes regulatorios para testing ético.

Implicaciones Éticas y Mejores Prácticas en el Despliegue de IA

Éticamente, el uso de IA en doblaje cuestiona el consentimiento y la autoría. Actores deben otorgar permisos explícitos para clonación, alineado con principios del GDPR (Reglamento General de Protección de Datos). Organizaciones como la SAG-AFTRA en EE.UU. han negociado acuerdos que limitan el uso perpetuo de voces digitales, requiriendo compensación por reutilización.

Mejores prácticas incluyen diversidad en datasets, utilizando técnicas de augmentation de datos para equilibrar representaciones. Frameworks éticos como los de la IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems guían el desarrollo, enfatizando accountability y explainability. En producción, se recomienda watermarking digital en audio generado por IA, incrustando firmas imperceptibles detectables por herramientas forenses.

Para mitigar riesgos laborales, se sugiere upskilling en IA para actores, capacitándolos en herramientas como Descript Overdub para control creativo. Colaboraciones público-privadas, como las impulsadas por la UNESCO en su Recomendación sobre Ética de la IA (2021), fomentan diálogos inclusivos entre tecnólogos, creadores y reguladores.

Desafíos Técnicos Avanzados y Futuras Direcciones

Avances emergentes incluyen IA multimodal que integra audio, video y texto, como modelos de difusión estables (Stable Diffusion para audio) para generar doblajes inmersivos en VR/AR. Desafíos persisten en latencia para doblaje en vivo, resueltos por edge computing en dispositivos IoT. En ciberseguridad, zero-knowledge proofs en blockchain verifican autenticidad sin revelar datos sensibles.

Investigaciones en curso, como el proyecto DARPA Media Forensics (MediFor), desarrollan benchmarks para robustez contra adversarios. En Latinoamérica, iniciativas como el Centro de Investigación en IA de la UNAM exploran adaptaciones culturales, entrenando modelos con corpora locales para preservar identidades lingüísticas.

Conclusión: Hacia un Equilibrio Sostenible entre Innovación y Humanidad

La inteligencia artificial redefine el doblaje como un campo híbrido donde eficiencia técnica coexiste con la creatividad humana. Si bien ofrece beneficios en accesibilidad y escalabilidad, exige marcos robustos para abordar riesgos éticos y de seguridad. Al priorizar transparencia, inclusión y regulación proactiva, la industria puede navegar esta rebelión hacia un futuro colaborativo. En resumen, el desafío radica en harnessar el potencial de la IA sin erosionar el valor irremplazable del talento humano.

Para más información, visita la fuente original.