Desarrollo de un Sistema de Inteligencia Artificial para la Generación de Código Basado en Lenguaje Natural

Introducción a la Generación de Código con IA

La inteligencia artificial (IA) ha transformado radicalmente el panorama del desarrollo de software, permitiendo la automatización de tareas complejas como la generación de código a partir de descripciones en lenguaje natural. Este enfoque no solo acelera el proceso de codificación, sino que también reduce errores humanos y democratiza el acceso a la programación para no expertos. En el contexto de la ciberseguridad y las tecnologías emergentes, esta capacidad adquiere relevancia al facilitar la creación rápida de herramientas defensivas, como scripts de detección de vulnerabilidades o algoritmos de encriptación personalizados.

El núcleo de estos sistemas radica en modelos de aprendizaje profundo, particularmente en arquitecturas de transformers, que procesan secuencias de texto para generar outputs coherentes. Tecnologías como GPT (Generative Pre-trained Transformer) han sido pioneras en este campo, demostrando cómo un modelo entrenado en vastos corpus de código y texto natural puede traducir instrucciones vagas en estructuras programáticas funcionales. Sin embargo, implementar un sistema así requiere un entendimiento profundo de los componentes subyacentes, desde el preprocesamiento de datos hasta la integración con entornos de desarrollo.

En términos operativos, estos sistemas operan bajo principios de procesamiento de lenguaje natural (PLN) combinado con generación de secuencias. Por ejemplo, un usuario podría ingresar: “Crea una función en Python que valide contraseñas seguras”, y el modelo generaría código que incorpore chequeos de longitud, complejidad y detección de patrones comunes. Las implicaciones en ciberseguridad son evidentes: acelera la respuesta a amenazas emergentes, pero también plantea riesgos si el código generado introduce vulnerabilidades inadvertidas, como inyecciones SQL o fugas de memoria.

Conceptos Clave en el Diseño de Modelos de IA para Generación de Código

Para construir un sistema efectivo, es esencial dominar los conceptos fundamentales de los modelos de lenguaje grandes (LLM, por sus siglas en inglés). Estos modelos se basan en la atención auto-regresiva, donde cada token generado predice el siguiente basado en el contexto previo. En el ámbito de la generación de código, se utilizan datasets especializados como CodeSearchNet o The Stack, que contienen miles de millones de líneas de código de repositorios públicos en GitHub.

Uno de los desafíos técnicos principales es el manejo de la sintaxis y semántica del lenguaje de programación objetivo. Por instancia, en Python, el modelo debe asegurar indentación correcta y manejo de excepciones, mientras que en JavaScript, debe considerar asincronía y promesas. Frameworks como Hugging Face Transformers facilitan esto al proporcionar pre-entrenados como CodeT5 o StarCoder, que han sido fine-tuneados específicamente para tareas de codificación.

Desde una perspectiva de ciberseguridad, es crucial incorporar validaciones post-generación. Herramientas como Bandit para Python o ESLint para JavaScript pueden escanear el código output para detectar patrones de riesgo, como el uso de eval() o exposición de variables sensibles. Además, el entrenamiento debe incluir datos limpios para mitigar sesgos que podrían llevar a prácticas inseguras, como contraseñas hardcodeadas.

Las implicaciones regulatorias emergen con estándares como GDPR o NIST SP 800-53, que exigen trazabilidad en el software generado por IA. En blockchain, por ejemplo, generar smart contracts en Solidity requiere verificación formal para prevenir exploits como reentrancy, un vector común en DeFi.

Arquitectura Técnica de un Sistema de Generación de Código

La arquitectura típica de un sistema de IA para generación de código se divide en capas: entrada, procesamiento, generación y validación. En la capa de entrada, se emplea tokenización adaptada a código, utilizando vocabularios que incluyen keywords de lenguajes de programación. Modelos como BPE (Byte Pair Encoding) segmentan el texto en subpalabras, permitiendo manejar tanto descripciones naturales como snippets de código existentes.

El procesamiento central involucra un encoder-decoder o un modelo decoder-only, como en GPT-3.5. Para mejorar la precisión, se aplica fine-tuning con técnicas de aprendizaje supervisado, donde pares de (instrucción, código) sirven como entrenamiento. En entornos de IA distribuida, se utilizan frameworks como TensorFlow o PyTorch con soporte para GPU/TPU, optimizando el entrenamiento mediante gradient descent y técnicas de regularización como dropout para prevenir overfitting.

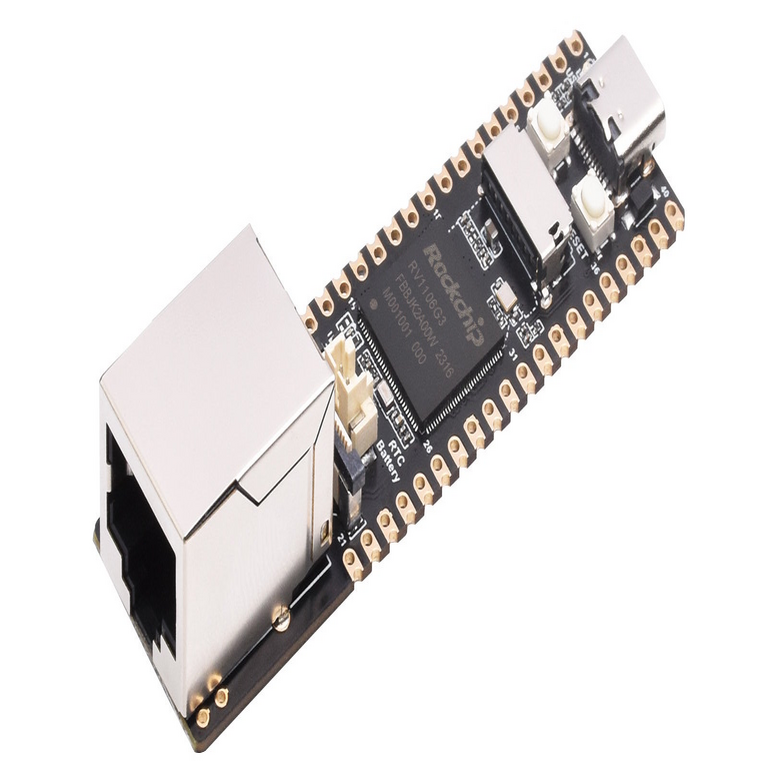

En la fase de generación, el modelo emplea beam search o sampling nucleus para explorar múltiples paths de código, seleccionando el más probable. Para aplicaciones en tecnologías emergentes, como IA en edge computing, se considera cuantización de modelos (e.g., de FP32 a INT8) para reducir latencia sin sacrificar calidad.

La validación es crítica: integración con linters, testers unitarios automáticos (usando pytest o Jest) y hasta ejecución en sandboxes para verificar funcionalidad. En ciberseguridad, esto incluye escaneos con OWASP ZAP para detectar vulnerabilidades web en el código generado.

- Componentes clave: Preprocesador de lenguaje natural, modelo de transformer, post-procesador de sintaxis, validador de seguridad.

- Herramientas recomendadas: Hugging Face para modelos, Git para versionado de outputs, Docker para entornos aislados.

- Estándares aplicables: ISO/IEC 27001 para gestión de seguridad en el pipeline de IA.

Implementación Práctica: Pasos para Desarrollar un Prototipo

Desarrollar un prototipo comienza con la selección de un modelo base. Supongamos que optamos por CodeLlama, un LLM open-source de Meta enfocado en código. El setup inicial implica instalar dependencias via pip: transformers, torch y datasets de Hugging Face.

El preprocesamiento involucra curar un dataset: recolectar prompts de usuarios reales de foros como Stack Overflow, pareados con soluciones verificadas. Se aplica limpieza para remover código malicioso, utilizando regex para filtrar patrones de malware. El entrenamiento se realiza en un clúster con múltiples nodos, empleando distributed data parallel (DDP) en PyTorch para escalabilidad.

Durante la inferencia, el sistema recibe un prompt, lo tokeniza y genera código en un bucle autoregresivo hasta un token de fin (e.g., </code>). Para mejorar la usabilidad, se integra una interfaz API con FastAPI, permitiendo requests HTTP con payloads JSON conteniendo la descripción y el lenguaje objetivo.

En blockchain, un ejemplo sería generar código para un token ERC-20: el prompt “Implementa un contrato inteligente en Solidity para un token fungible con minting controlado” produce un contrato que incluye funciones como transfer, approve y un modifier onlyOwner. La validación involucra herramientas como Slither para análisis estático de vulnerabilidades.

Riesgos operativos incluyen alucinaciones del modelo, donde genera código incorrecto o inseguro. Mitigaciones: prompting engineering con few-shot examples y human-in-the-loop para revisión crítica. Beneficios: en IT, reduce tiempo de desarrollo en un 40-60%, según estudios de GitHub Copilot.

Integración con Tecnologías Emergentes y Ciberseguridad

La integración de estos sistemas con blockchain amplifica su utilidad. En Web3, generar código para dApps requiere comprensión de EVM (Ethereum Virtual Machine) y patrones como proxy patterns para upgradability. Modelos fine-tuneados en Solidity datasets, como SolidiFI, corrigen bugs comunes como integer overflows.

En IA, la generación de código habilita meta-aprendizaje: modelos que generan otros modelos. Por ejemplo, crear scripts para fine-tuning de redes neuronales en TensorFlow, incorporando optimizaciones como pruning para eficiencia en dispositivos IoT.

Desde la ciberseguridad, estos sistemas apoyan threat hunting: generar queries para SIEM (Security Information and Event Management) como Splunk, o scripts para honeypots. Sin embargo, riesgos incluyen adversarial attacks, donde prompts maliciosos inducen código con backdoors. Defensas: watermarking en outputs y entrenamiento adversarial con datasets como AdvGLUE.

Regulatoriamente, en la UE, el AI Act clasifica estos sistemas como high-risk si impactan seguridad, exigiendo transparencia y auditorías. En Latinoamérica, marcos como la Ley de Protección de Datos en México enfatizan responsabilidad en IA generativa.

| Componente | Tecnología | Aplicación en Ciberseguridad |

|---|---|---|

| Modelo Base | CodeLlama | Generación de scripts de firewall |

| Validación | Bandit/OWASP | Detección de inyecciones |

| Integración | FastAPI/Docker | Despliegue en entornos seguros |

Desafíos y Mejores Prácticas en el Despliegue

Entre los desafíos, destaca la escalabilidad: modelos grandes como GPT-4 consumen recursos masivos, requiriendo cloud providers como AWS SageMaker o Google Cloud AI Platform. Optimizaciones incluyen distillation, donde un modelo teacher entrena un student más ligero.

Mejores prácticas: versionado con MLflow para rastrear experimentos, CI/CD pipelines con GitHub Actions para automatizar tests en código generado. En ciberseguridad, implementar zero-trust: autenticación en APIs y encriptación de prompts sensibles.

Ética es paramount: evitar generación de código para fines maliciosos, como ransomware, mediante filtros en prompts. Estudios muestran que con prompting adecuado, la precisión alcanza 80% en tareas simples, pero baja a 50% en complejas, subrayando la necesidad de iteración.

En noticias de IT recientes, herramientas como Amazon CodeWhisperer integran estos modelos en IDEs, mejorando productividad. Para blockchain, proyectos como Chainlink usan IA para oráculos que generan código verificable on-chain.

Casos de Estudio: Aplicaciones Reales

Un caso emblemático es GitHub Copilot, basado en Codex, que ha asistido en millones de líneas de código. En ciberseguridad, empresas como CrowdStrike usan IA similar para generar playbooks de respuesta a incidentes, reduciendo MTTR (Mean Time to Response).

En Latinoamérica, startups en México desarrollan sistemas para generar código en español, adaptando modelos a dialectos locales para accesibilidad. Otro ejemplo: en IA para salud, generar código para análisis de datos médicos compliant con HIPAA.

Beneficios cuantificables: según un informe de McKinsey, IA en desarrollo software podría agregar $2.6-4.4 trillones a la economía global para 2040, con énfasis en seguridad.

Conclusiones y Perspectivas Futuras

En resumen, el desarrollo de sistemas de IA para generación de código basado en lenguaje natural representa un avance pivotal en ciberseguridad, IA y tecnologías emergentes. Al combinar modelos avanzados con validaciones rigurosas, se logra un equilibrio entre eficiencia y seguridad, facilitando innovaciones en blockchain e IT. No obstante, el éxito depende de prácticas éticas y regulatorias sólidas para mitigar riesgos inherentes.

Las perspectivas futuras apuntan a multimodalidad: integrar visión para generar código desde diagramas UML, o voz para comandos hands-free. En ciberseguridad, IA autónoma podría predecir y parchear vulnerabilidades en tiempo real. Finalmente, la adopción responsable asegurará que estos sistemas potencien el ecosistema tecnológico sin comprometer la integridad.

Para más información, visita la Fuente original.