Entrenamiento de Modelos de Inteligencia Artificial para la Detección de Amenazas Cibernéticas

Introducción a la Integración de IA en la Ciberseguridad

La inteligencia artificial (IA) ha transformado diversos sectores, y la ciberseguridad no es la excepción. En un panorama donde las amenazas digitales evolucionan a ritmos acelerados, los sistemas tradicionales de defensa basados en reglas estáticas resultan insuficientes. Los modelos de IA, particularmente aquellos basados en aprendizaje automático (machine learning), permiten analizar patrones complejos en grandes volúmenes de datos, identificando anomalías que podrían indicar ataques cibernéticos. Este enfoque no solo acelera la detección, sino que también reduce la dependencia de intervenciones humanas, minimizando errores y fatiga operativa.

El entrenamiento de estos modelos implica recopilar datasets representativos de comportamientos normales y maliciosos en redes, endpoints y aplicaciones. Fuentes como logs de firewalls, tráfico de red y registros de eventos de seguridad sirven como base. Sin embargo, el desafío radica en la calidad y diversidad de estos datos, ya que sesgos o insuficiencias pueden llevar a falsos positivos o negativos, comprometiendo la efectividad del sistema.

En el contexto latinoamericano, donde las infraestructuras digitales varían ampliamente entre países, adaptar modelos de IA a realidades locales es crucial. Por ejemplo, en regiones con alta prevalencia de phishing en español o portugués, los datasets deben incluir muestras lingüísticas específicas para mejorar la precisión en la detección de ingeniería social.

Fundamentos del Aprendizaje Automático en Detección de Amenazas

El aprendizaje automático se divide en supervisado, no supervisado y por refuerzo, cada uno con aplicaciones específicas en ciberseguridad. En el supervisado, se utilizan etiquetas para entrenar el modelo, como clasificar correos electrónicos como spam o legítimos. Algoritmos como árboles de decisión o redes neuronales convolucionales (CNN) destacan en tareas de clasificación de malware, donde se analizan firmas binarias o comportamientos dinámicos.

Por otro lado, el aprendizaje no supervisado es ideal para detectar anomalías en entornos sin datos etiquetados previamente. Técnicas como el clustering K-means o autoencoders identifican desviaciones en el tráfico de red, útiles contra ataques zero-day que no siguen patrones conocidos. En escenarios de blockchain, integrados con IA, estos métodos pueden monitorear transacciones sospechosas en redes descentralizadas, previniendo fraudes como el lavado de dinero digital.

El aprendizaje por refuerzo, aunque menos común, simula entornos de decisión en tiempo real. Un agente IA aprende a responder a amenazas hipotéticas, optimizando acciones como bloquear IPs o aislar segmentos de red. Estudios recientes muestran que este enfoque reduce el tiempo de respuesta en un 40% en simulaciones de ataques DDoS.

- Supervisado: Alta precisión con datos etiquetados, pero requiere esfuerzo inicial en anotación.

- No supervisado: Flexible para datos desconocidos, aunque propenso a ruido en datasets grandes.

- Por refuerzo: Adaptativo a cambios dinámicos, ideal para entornos evolutivos como IoT.

Preparación de Datasets para Entrenamiento Efectivo

La fase de preparación de datos es crítica y consume hasta el 80% del tiempo en proyectos de IA. En ciberseguridad, los datasets deben provenir de fuentes confiables como el MITRE ATT&CK framework o bases de datos públicas como el Canadian Institute for Cybersecurity. Para entornos latinoamericanos, integrar datos de incidentes regionales, como los reportados por el INCIBE en España o equivalentes en México y Brasil, enriquece el modelo.

El preprocesamiento involucra limpieza de datos, normalización y balanceo de clases. Por ejemplo, técnicas de sobremuestreo como SMOTE (Synthetic Minority Over-sampling Technique) abordan desequilibrios donde las muestras maliciosas son minoritarias. En blockchain, datasets de transacciones de Ethereum o Bitcoin se procesan para extraer features como frecuencia de transferencias o patrones de gas, detectando anomalías en smart contracts.

La privacidad es un factor clave; regulaciones como la LGPD en Brasil o la LFPDPPP en México exigen anonimización. Herramientas como differential privacy agregan ruido controlado a los datos, preservando utilidad sin comprometer información sensible.

Una vez preparados, los datos se dividen en conjuntos de entrenamiento (70%), validación (15%) y prueba (15%). Métricas como precisión, recall y F1-score evalúan el rendimiento, priorizando el recall en ciberseguridad para minimizar falsos negativos.

Selección y Configuración de Modelos de IA

La elección del modelo depende del tipo de amenaza. Para detección de intrusiones en redes (NIDS), modelos como Random Forest o Gradient Boosting Machines (GBM) ofrecen robustez contra overfitting. En contraste, para análisis de imágenes en reconnaissance visual, como en ataques a cámaras de seguridad, las CNN como ResNet-50 superan a otros enfoques.

En IA aplicada a blockchain, modelos de grafos neuronales (GNN) analizan la topología de la red para detectar nodos maliciosos. Por ejemplo, en redes como Polkadot, un GNN puede identificar puentes cross-chain vulnerables a exploits.

La configuración incluye hiperparámetros como tasa de aprendizaje (learning rate) en 0.001 para optimizadores Adam, o número de épocas en 100 para convergencia estable. Frameworks como TensorFlow o PyTorch facilitan esta implementación, con soporte para GPU acceleration en datasets masivos.

Entrenamiento distribuido, usando técnicas como federated learning, permite colaborar entre organizaciones sin compartir datos crudos, ideal para consorcios en ciberseguridad regional.

- Random Forest: Eficiente para features categóricas en logs de eventos.

- CNN: Óptimo para procesamiento de secuencias temporales en tráfico de red.

- GNN: Esencial para estructuras no euclidianas en blockchain.

Evaluación y Optimización de Modelos Entrenados

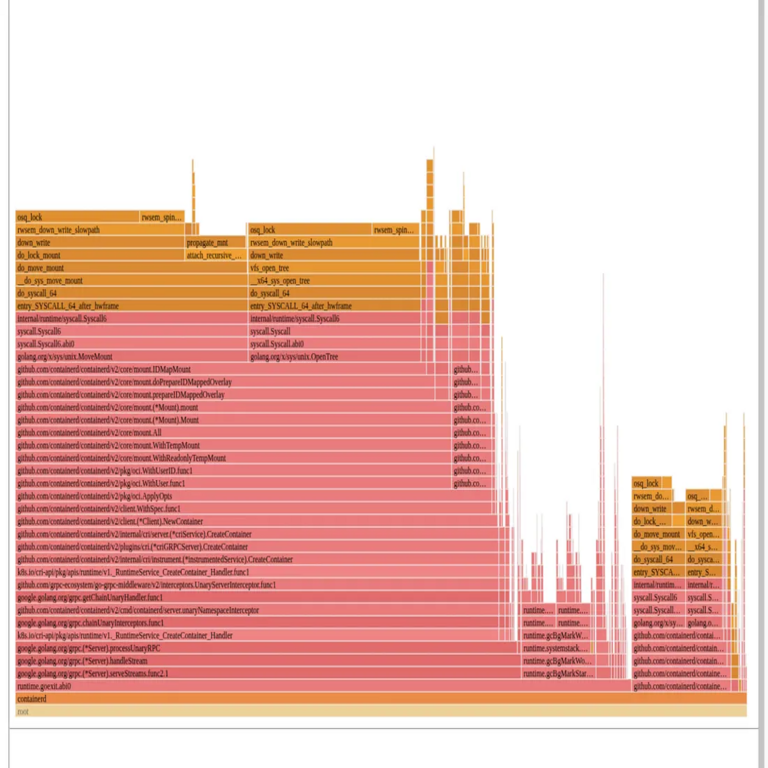

Post-entrenamiento, la evaluación usa curvas ROC y matrices de confusión para medir trade-offs entre precisión y falsos positivos. En ciberseguridad, un umbral bajo en falsos positivos es tolerable si reduce brechas significativas.

Optimización involucra técnicas como pruning en redes neuronales para reducir complejidad computacional, o ensemble methods combinando múltiples modelos para mayor robustez. En escenarios de IA explicable (XAI), herramientas como SHAP proporcionan interpretabilidad, crucial para auditores en regulaciones como GDPR adaptadas a Latinoamérica.

Pruebas en entornos reales, como honeypots o simuladores de ataques, validan el modelo. Por instancia, contra ransomware, un modelo entrenado detecta patrones de encriptación en un 95% de casos, según benchmarks recientes.

Actualizaciones continuas son necesarias; modelos de IA en ciberseguridad se reentrenan periódicamente con datos frescos para adaptarse a nuevas variantes de malware, como las impulsadas por IA adversarial.

Desafíos Éticos y Técnicos en el Entrenamiento de IA para Ciberseguridad

Uno de los principales desafíos es el adversarial training, donde atacantes envenenan datasets para evadir detección. Técnicas de robustez, como adversarial training con FGSM (Fast Gradient Sign Method), mitigan esto al exponer el modelo a perturbaciones intencionales.

Éticamente, el sesgo en datasets puede perpetuar desigualdades; por ejemplo, modelos entrenados en datos de EE.UU. fallan en contextos latinoamericanos con infraestructuras legacy. Diversificar fuentes y auditorías regulares abordan esto.

En blockchain, la inmutabilidad de datos complica el entrenamiento, pero oráculos como Chainlink permiten feeds seguros. La escalabilidad es otro reto; modelos grandes requieren recursos cloud, con costos que impactan a PYMES en la región.

Regulaciones emergentes, como la Ley de IA en la UE influenciando Latinoamérica, demandan transparencia en algoritmos, impulsando adopción de modelos open-source.

Aplicaciones Prácticas en Entornos Latinoamericanos

En México, instituciones como el INAI utilizan IA para monitorear brechas de datos, entrenando modelos en incidentes locales de phishing bancario. En Brasil, el Banco Central integra IA en sistemas de detección de fraudes en Pix, procesando millones de transacciones diarias.

Para blockchain, en Argentina y Colombia, startups emplean IA para auditar DeFi protocols, detectando vulnerabilidades en código Solidity mediante análisis semántico.

En IoT, común en agricultura inteligente de la región, modelos de edge computing detectan intrusiones en dispositivos remotos, reduciendo latencia en respuestas.

- Phishing: Modelos NLP como BERT adaptados a español neutro.

- Fraudes en pagos: Análisis de series temporales con LSTM.

- Auditoría blockchain: Verificación automatizada de contratos inteligentes.

Integración con Tecnologías Emergentes como Blockchain

La fusión de IA y blockchain crea sistemas de ciberseguridad descentralizados. En blockchain, IA entrena modelos on-chain para predecir ataques a validadores, usando proof-of-stake mechanisms.

Zero-knowledge proofs permiten entrenamientos privados, donde solo resultados se comparten, preservando confidencialidad en consorcios multi-nacionales.

Ejemplos incluyen plataformas como SingularityNET, donde agentes IA autónomos ofrecen servicios de seguridad en mercados descentralizados, accesibles para desarrolladores latinoamericanos.

Esta integración acelera la respuesta a amenazas globales, como ransomware en supply chains, con trazabilidad inmutable de incidentes.

Conclusiones y Perspectivas Futuras

El entrenamiento de modelos de IA representa un pilar fundamental en la evolución de la ciberseguridad, ofreciendo capacidades predictivas y adaptativas esenciales en un ecosistema digital en expansión. Al abordar desafíos como la calidad de datos y la ética, las organizaciones pueden desplegar sistemas resilientes que protejan infraestructuras críticas. En Latinoamérica, la adopción localizada de estas tecnologías promete fortalecer la soberanía digital, mitigando riesgos regionales específicos.

Prospectivamente, avances en IA cuántica y edge AI ampliarán horizontes, permitiendo detecciones en tiempo real sin compromisos en privacidad. La colaboración internacional, impulsada por blockchain, facilitará el intercambio de conocimiento, asegurando un futuro más seguro.

Para más información visita la Fuente original.