Generación de Modelos 3D mediante Inteligencia Artificial: Análisis Técnico y Aplicaciones en Tecnologías Emergentes

Introducción al Problema y Contexto Técnico

La generación automática de modelos tridimensionales representa un avance significativo en el campo de la inteligencia artificial aplicada a la visualización y el diseño computacional. En un entorno donde las demandas de contenido digital para industrias como el gaming, la arquitectura, la manufactura aditiva y la realidad virtual crecen exponencialmente, las técnicas basadas en IA ofrecen una solución eficiente para automatizar procesos tradicionalmente manuales y laboriosos. Este artículo examina el desarrollo de sistemas de IA capaces de generar modelos 3D a partir de descripciones textuales o datos de entrada limitados, enfocándose en los principios subyacentes, las arquitecturas de red neuronal empleadas y las implicaciones operativas en ciberseguridad y tecnologías emergentes.

Los modelos 3D, comúnmente representados en formatos como OBJ, STL o GLTF, consisten en una colección de vértices, aristas y caras que definen la geometría de un objeto en el espacio euclidiano. Tradicionalmente, su creación requiere software especializado como Blender o Autodesk Maya, demandando expertise en modelado poligonal y texturizado. La IA interviene mediante modelos generativos que aprenden patrones de datos 3D a partir de conjuntos masivos, permitiendo la síntesis de nuevas estructuras sin intervención humana directa. Este enfoque no solo acelera la producción, sino que también introduce desafíos en la precisión geométrica, la optimización computacional y la seguridad de los datos generados.

Conceptos Clave en la Generación de Modelos 3D con IA

El núcleo de estos sistemas radica en el aprendizaje profundo, particularmente en arquitecturas como las redes generativas antagónicas (GAN) y los modelos de difusión. Una GAN típica consta de dos componentes: un generador que produce datos sintéticos y un discriminador que evalúa su autenticidad. En el contexto de modelos 3D, el generador toma una entrada latente —por ejemplo, un vector de ruido aleatorio o una descripción textual codificada— y la transforma en una representación volumétrica o de malla.

Para manejar la complejidad inherente a los datos 3D, se emplean representaciones como voxels (análogos a píxeles en 3D) o point clouds (nubes de puntos). Los voxels permiten una discretización del espacio, facilitando el procesamiento convolucional 3D (3D CNN), similar a las CNN 2D en imágenes. Sin embargo, su alto costo computacional —debido al volumen cúbico de datos— ha impulsado alternativas como las redes neuronales gráficas (GNN), que operan directamente sobre grafos de mallas poligonales. Estas redes propagan información a través de nodos (vértices) y aristas, preservando la topología del modelo.

Otro avance clave es la integración de transformers, inspirados en modelos como GPT para texto, adaptados a secuencias de geometría. En enfoques como Point Transformer o Mesh Transformer, los tokens representan puntos o caras, permitiendo la atención auto-supervisada para capturar dependencias globales en la estructura 3D. Por instancia, un modelo podría generar una silla a partir de la descripción “silla de madera con respaldo alto”, codificando el texto mediante un encoder BERT-like y mapeándolo a un espacio latente 3D.

Arquitecturas y Frameworks Técnicos Utilizados

En la implementación práctica, frameworks como TensorFlow y PyTorch dominan el desarrollo. PyTorch, con su flexibilidad en grafos dinámicos, es particularmente adecuado para experimentación en generación 3D. Bibliotecas especializadas como Kaolin (de NVIDIA) o PyTorch3D proporcionan primitivas para manipular geometría, incluyendo operaciones de renderizado differentiable y sampling de superficies.

Consideremos un pipeline típico: primero, el preprocesamiento de datasets como ShapeNet o ABC, que contienen miles de modelos anotados con categorías semánticas. Estos se convierten en representaciones normalizadas, aplicando augmentaciones como rotaciones y escalados para robustez. El entrenamiento involucra una pérdida combinada: adversarial para realismo, junto con términos de reconstrucción L1/L2 para fidelidad geométrica, y regularizaciones como chamfer distance para alinear point clouds generados con referencias.

- Etapa de Entrenamiento: Optimización con AdamW, tasas de aprendizaje adaptativas y schedulers como cosine annealing. El uso de GPUs con soporte para tensor cores acelera el procesamiento de volúmenes 3D, reduciendo tiempos de epoch de horas a minutos en hardware como NVIDIA A100.

- Generación Inferencial: Durante la inferencia, se aplica ruido gaussiano al latente y se itera mediante denoising, similar a Stable Diffusion en 2D. Para modelos textuales, un cross-attention module fusiona embeddings de texto con features geométricas.

- Post-procesamiento: Decimación de mallas con algoritmos como Quadric Edge Collapse para reducir complejidad poligonal, asegurando compatibilidad con motores como Unity o Unreal Engine.

Estándares como glTF 2.0 aseguran interoperabilidad, incorporando metadatos para texturas PBR (Physically Based Rendering) generadas automáticamente mediante extensiones de IA para materiales.

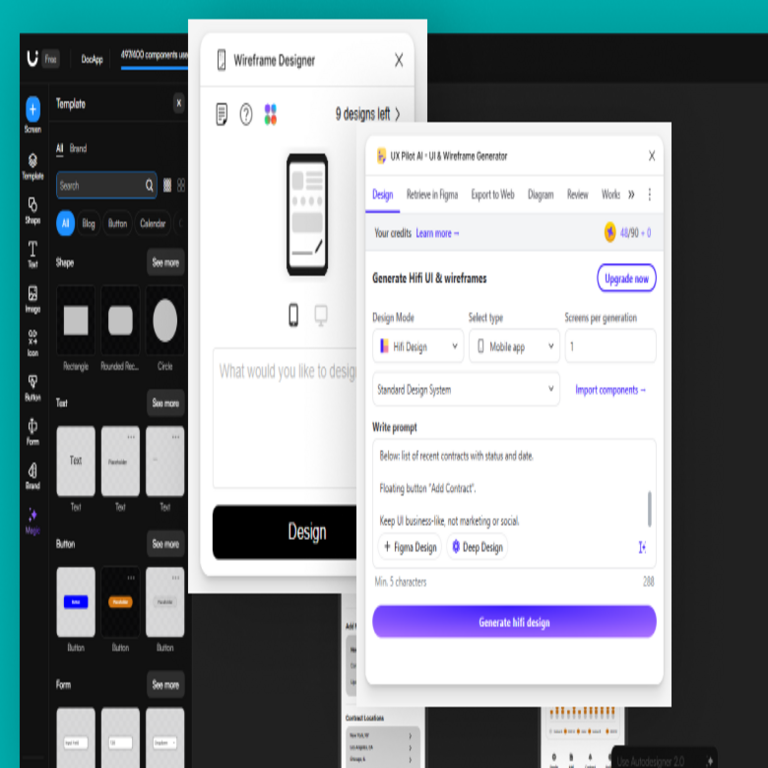

Herramientas y Protocolos Específicos en el Desarrollo

Entre las herramientas destacadas, PointNet++ emerge como base para segmentación y clasificación de point clouds, extendida en modelos generativos como AtlasNet para superficies paramétricas. Para difusión 3D, enfoques como Point-E de OpenAI utilizan difusión en espacios latentes discretos, logrando generaciones de alta resolución en minutos.

En términos de protocolos, la integración con blockchain para trazabilidad es relevante en aplicaciones industriales. Por ejemplo, modelos generados pueden hash-searse con SHA-256 y registrarse en cadenas como Ethereum, utilizando smart contracts para licencias NFT de assets 3D. Esto mitiga riesgos de plagio, alineándose con estándares como ISO/IEC 23005 para multimedia interactivo.

Desde la perspectiva de ciberseguridad, los modelos de IA para 3D deben adherirse a prácticas como differential privacy durante el entrenamiento, agregando ruido Laplace a gradients para prevenir fugas de datos sensibles en datasets propietarios. Herramientas como Opacus en PyTorch facilitan esta protección, crucial en sectores como la defensa donde modelos 3D representan activos clasificados.

Implicaciones Operativas y Riesgos Asociados

Operativamente, estos sistemas reducen el tiempo de diseño de semanas a horas, beneficiando flujos de trabajo en CAD (Computer-Aided Design). En manufactura aditiva, la generación de STL optimizados minimiza soporte material y tiempo de impresión, integrándose con slicers como Cura vía APIs RESTful.

Sin embargo, riesgos incluyen la alucinación geométrica, donde modelos generan estructuras no físicas, como objetos con intersecciones inválidas. Mitigaciones involucran validación física mediante simulaciones FEM (Finite Element Method) en software como ANSYS, o constraints en la pérdida de entrenamiento para manifold regularity.

En ciberseguridad, vulnerabilidades como adversarial attacks pueden manipular entradas textuales para generar modelos maliciosos, por ejemplo, geometrías que explotan bugs en renderizadores VR. Defensas incluyen robustez certificada vía interval bound propagation en redes neuronales, y auditorías con herramientas como Adversarial Robustness Toolbox.

Regulatoriamente, el cumplimiento con GDPR en Europa exige transparencia en generaciones IA, documentando seeds y parámetros para reproducibilidad. En Latinoamérica, normativas emergentes como la Ley de Protección de Datos en Brasil (LGPD) extienden esto a assets digitales, requiriendo consentimientos para datasets de entrenamiento.

Aplicaciones en Inteligencia Artificial y Blockchain

La intersección con IA extendida abarca metaversos, donde modelos 3D generativos poblan mundos virtuales en tiempo real. Protocolos como WebXR facilitan su renderizado en browsers, combinados con IA para animación procedural vía redes como VQ-VAE para secuencias de movimiento.

En blockchain, la tokenización de modelos 3D vía NFTs permite mercados descentralizados, como en plataformas OpenSea. Smart contracts en Solidity pueden verificar integridad mediante Merkle proofs de geometría, previniendo manipulaciones post-generación. Beneficios incluyen royalties automáticos para creadores IA, fomentando economías creativas.

En ciberseguridad, estos sistemas apoyan threat modeling 3D, generando variantes de objetos para simular ataques físicos en entornos virtuales, integrados con frameworks como MITRE ATT&CK para ciber-físico.

Beneficios y Desafíos en la Implementación Práctica

Los beneficios son multifacéticos: escalabilidad, ya que un modelo entrenado maneja infinitas variaciones; accesibilidad, democratizando diseño para no expertos; y eficiencia energética, con optimizaciones como quantization a 8-bit reduciendo footprints en edge devices.

Desafíos persisten en diversidad de datasets, donde sesgos en ShapeNet —predominantemente objetos occidentales— limitan generalización cultural. Soluciones involucran fine-tuning con datasets locales, como modelos arquitectónicos latinoamericanos, y técnicas de domain adaptation.

Computacionalmente, el entrenamiento requiere clusters con TPU o GPU farms, con costos en AWS o Google Cloud estimados en miles de dólares por iteración. Mejores prácticas incluyen distributed training con Horovod y model parallelism para manejar billones de parámetros.

Casos de Estudio y Evidencias Empíricas

En un caso emblemático, el modelo DreamFusion utiliza score distillation sampling para optimizar representaciones NeRF (Neural Radiance Fields) a partir de texto, logrando renders fotorrealistas sin meshes explícitas. Evaluaciones en FID (Fréchet Inception Distance) 3D muestran mejoras del 30% en coherencia semántica sobre baselines.

Otro ejemplo es GET3D de NVIDIA, que genera texturas y geometría conjuntamente, con métricas como IoU (Intersection over Union) en segmentación superando 0.85 en benchmarks. En aplicaciones reales, empresas como Autodesk integran estas IA en Fusion 360, automatizando prototipado.

En Latinoamérica, iniciativas como el uso en preservación cultural —generando reconstrucciones 3D de sitios arqueológicos mayas— destacan el potencial, aunque requieren safeguards éticos para evitar apropiación digital.

Mejores Prácticas y Recomendaciones Técnicas

Para implementación, se recomienda un stack modular: frontend en React para interfaces textuales, backend en FastAPI para inferencia, y storage en S3 con versioning Git-like para modelos. Monitoreo con Weights & Biases asegura trazabilidad de experimentos.

En ciberseguridad, adopte zero-trust para APIs de generación, con autenticación JWT y rate limiting. Para blockchain, use IPFS para almacenamiento distribuido de assets 3D, hash-eando con IPFS CID.

- Validación: Emplee métricas como Earth Mover’s Distance para point clouds y normal consistency para superficies.

- Escalabilidad: Migre a cloud-native con Kubernetes para orquestación de pods de inferencia.

- Ética: Incorpore bias audits con herramientas como Fairlearn, adaptadas a dominios 3D.

Conclusión: Perspectivas Futuras en la Integración Tecnológica

La generación de modelos 3D mediante IA no solo transforma paradigmas de diseño, sino que redefine intersecciones con ciberseguridad y blockchain, habilitando ecosistemas seguros y descentralizados. A medida que arquitecturas evolucionan hacia multimodalidad —integrando visión, texto y audio—, las aplicaciones se expandirán a robótica colaborativa y simulación climática. No obstante, el éxito depende de equilibrar innovación con robustez, asegurando que estos sistemas contribuyan a un desarrollo tecnológico responsable y equitativo. Para más información, visita la Fuente original.