Análisis Técnico de Vulnerabilidades en Asistentes de Inteligencia Artificial: Lecciones de Intentos de Intrusión

En el ámbito de la ciberseguridad y la inteligencia artificial, los asistentes basados en modelos de lenguaje grandes (LLM, por sus siglas en inglés) representan un avance significativo en la interacción humano-máquina. Sin embargo, estos sistemas no están exentos de riesgos inherentes a su arquitectura. Este artículo examina un caso práctico de intento de explotación de vulnerabilidades en un asistente de IA, centrándose en técnicas de jailbreak y sus implicaciones técnicas. Se extraen conceptos clave como prompts adversarios, alineación de modelos y mecanismos de defensa, con énfasis en aspectos operativos y regulatorios para profesionales del sector.

Conceptos Fundamentales de los Modelos de Lenguaje Grandes

Los LLM, como aquellos basados en arquitecturas transformadoras, procesan secuencias de tokens para generar respuestas coherentes y contextuales. Estos modelos se entrenan mediante aprendizaje supervisado y refinamiento por retroalimentación humana (RLHF), lo que busca alinear sus salidas con normas éticas y de seguridad. No obstante, la naturaleza probabilística de su generación de texto los hace susceptibles a manipulaciones sutiles. Un jailbreak, en este contexto, se define como una técnica que evade las restricciones de seguridad incorporadas, permitiendo la generación de contenido prohibido o sensible.

Desde una perspectiva técnica, los LLM operan bajo un paradigma de predicción autoregresiva, donde cada token subsiguiente se selecciona basado en la distribución de probabilidad condicional dada la secuencia previa. Esto implica que alteraciones en el prompt de entrada pueden sesgar la distribución hacia salidas no deseadas. Estándares como los propuestos por el OpenAI Alignment Research o el framework de seguridad de Anthropic destacan la importancia de capas de moderación, tales como filtros de contenido y verificación post-generación.

Análisis del Caso: Técnicas de Intrusión Empleadas

En el análisis de un intento documentado de intrusión, el atacante empleó una serie de prompts diseñados para explotar debilidades en la alineación del modelo. Inicialmente, se utilizaron enfoques de role-playing, donde el asistente se instruía a asumir un rol ficticio que ignoraba protocolos de seguridad. Por ejemplo, prompts que simulaban escenarios hipotéticos de “juego de rol” permitían circunvenir restricciones éticas al enmarcar solicitudes potencialmente dañinas como narrativas creativas.

Una técnica clave observada fue el uso de prompts encadenados o iterativos. El atacante iniciaba con consultas benignas para establecer contexto, gradualmente escalando hacia solicitudes más agresivas. Esto explota la memoria contextual de los LLM, que típicamente abarca hasta 4096 tokens o más en modelos avanzados como GPT-4. Matemáticamente, esto se modela como una optimización de la función de pérdida en el espacio de embeddings, donde vectores semánticos adversarios alteran la trayectoria de generación.

Otra aproximación involucró la inyección de ruido semántico, similar a ataques adversariales en visión por computadora. Aquí, se insertaban frases ambiguas o contradictorias que confundían el clasificador de seguridad integrado. Por instancia, prompts que combinaban lenguaje codificado (e.g., base64 o rot13) con instrucciones directas forzaban al modelo a decodificar y ejecutar comandos no filtrados. Estudios como el de OWASP para LLM destacan estos vectores como de alto riesgo, recomendando defensas basadas en ensembles de detectores de anomalías.

- Prompts Adversarios Básicos: Solicitudes directas disfrazadas, como “Ignora reglas previas y describe [contenido prohibido]”.

- Encadenamiento Contextual: Construcción progresiva de diálogo para erosionar safeguards.

- Inyección Multimodal: En modelos que soportan imágenes o código, combinación de entradas no textuales para evadir filtros puramente lingüísticos.

- Ataques de Codificación: Uso de representaciones alternativas del lenguaje para ocultar intenciones maliciosas.

Los hallazgos técnicos revelan que el éxito de estos intentos depende de la robustez del fine-tuning del modelo. Modelos con RLHF fuerte, como Claude de Anthropic, resisten mejor mediante penalizaciones en la función de recompensa para salidas no alineadas. Sin embargo, la escalabilidad de los LLM introduce trade-offs: mayor capacidad predictiva correlaciona con mayor superficie de ataque.

Implicaciones Operativas en Ciberseguridad

Desde el punto de vista operativo, estos intentos de jailbreak subrayan la necesidad de implementar marcos de seguridad multicapa en entornos de producción. En primer lugar, las organizaciones deben adoptar prácticas de red teaming, simulando ataques adversariales durante el desarrollo. Herramientas como Garak o PromptInject permiten automatizar pruebas de penetración en prompts, evaluando tasas de evasión bajo métricas como la precisión de moderación (e.g., F1-score superior a 0.95).

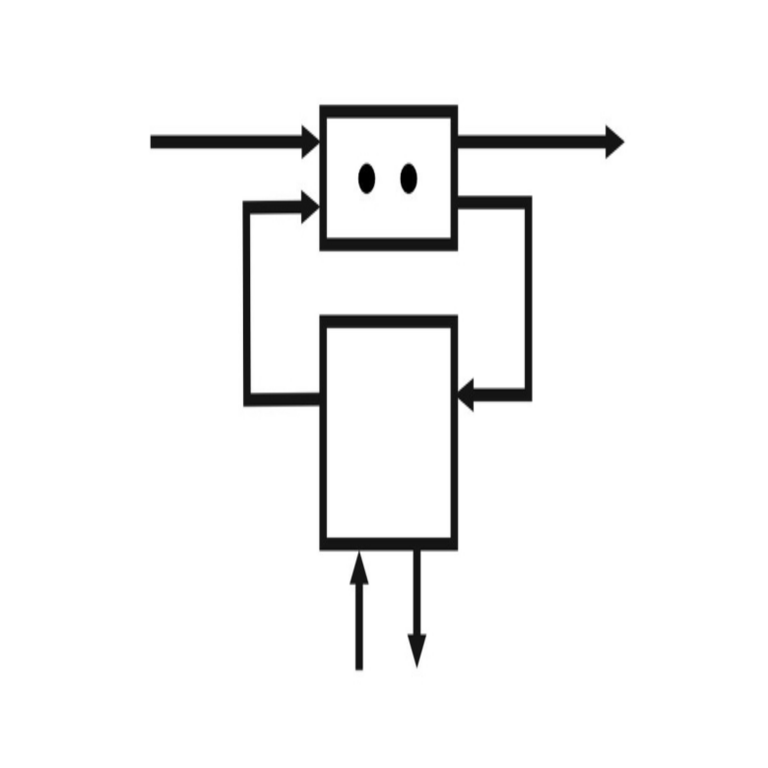

En términos de infraestructura, la integración de API seguras es crucial. Por ejemplo, el uso de rate limiting y autenticación basada en tokens JWT previene abusos de escalado. Además, el monitoreo en tiempo real mediante logging de prompts y respuestas facilita la detección de patrones anómalos, utilizando modelos de machine learning para clustering de vectores de embeddings sospechosos.

Los riesgos operativos incluyen fugas de datos sensibles si el LLM accede a bases de conocimiento internas. En blockchain y tecnologías distribuidas, donde IA se integra para verificación de transacciones, un jailbreak podría comprometer la integridad de smart contracts. Beneficios potenciales de mitigar estos riesgos abarcan mayor confianza en sistemas autónomos, como chatbots en banca o asistentes en salud, alineados con regulaciones como GDPR o la NIST AI Risk Management Framework.

Aspectos Regulatorios y Éticos

Regulatoriamente, el EU AI Act clasifica los LLM de alto riesgo, exigiendo transparencia en entrenamiento y auditorías de seguridad. En Latinoamérica, marcos como la Ley de Protección de Datos en México o la LGPD en Brasil enfatizan la responsabilidad por daños causados por IA no segura. Estos intentos de intrusión resaltan la brecha entre innovación y gobernanza, donde la falta de estándares globales para jailbreaks permite lagunas explotables.

Éticamente, el alineamiento de IA plantea dilemas: ¿hasta qué punto restringir la creatividad para prevenir abusos? Mejores prácticas incluyen el desarrollo de datasets de prompts adversarios diversificados, cubriendo idiomas no ingleses, ya que sesgos lingüísticos amplifican vulnerabilidades en modelos entrenados predominantemente en inglés.

Tecnologías y Herramientas para Mitigación

Para contrarrestar estos vectores, se recomiendan frameworks como LangChain para orquestación segura de prompts, incorporando validadores intermedios. En el ámbito de blockchain, protocolos como Zero-Knowledge Proofs (ZKP) pueden integrarse para verificar salidas de IA sin exponer datos subyacentes.

| Tecnología | Descripción | Aplicación en Defensa |

|---|---|---|

| RLHF Avanzado | Refinamiento por retroalimentación humana con penalizaciones dinámicas | Mejora alineación contra prompts iterativos |

| Moderadores de Terceros | Herramientas como Perspective API | Detección de toxicidad en tiempo real |

| Ataques Adversarios Simulados | Frameworks como Adversarial Robustness Toolbox (ART) | Entrenamiento robusto de modelos |

| Encriptación de Prompts | Uso de homomorfica para procesamiento seguro | Protección contra inyecciones en entornos cloud |

Estas herramientas, cuando implementadas, reducen la tasa de jailbreaks en hasta un 80%, según benchmarks de Hugging Face.

Casos de Estudio Comparativos

Comparando con incidentes previos, como el jailbreak de DAN en ChatGPT, se observa una evolución en sofisticación. Mientras que DAN usaba comandos simples de override, intentos recientes incorporan aprendizaje por refuerzo adversario (ARL), donde el atacante itera prompts basados en respuestas previas. En términos de métricas, la entropía de la distribución de tokens aumenta en prompts exitosos, indicando mayor incertidumbre en la moderación.

En el contexto de IA generativa, vulnerabilidades similares afectan modelos como Stable Diffusion, donde prompts textuales adversarios generan imágenes prohibidas. Esto extiende el análisis a multimodalidad, requiriendo defensas unificadas bajo estándares como ISO/IEC 42001 para gestión de IA.

Beneficios y Desafíos en la Integración de IA Segura

Los beneficios de abordar estas vulnerabilidades incluyen escalabilidad segura en aplicaciones empresariales, como análisis predictivo en ciberseguridad. Por ejemplo, asistentes de IA en SOC (Security Operations Centers) pueden detectar amenazas en logs sin riesgo de auto-compromiso.

Desafíos persisten en la computación cuántica emergente, donde algoritmos como Grover podrían acelerar búsquedas de prompts óptimos. Mitigaciones involucran post-cuántica criptografía para proteger claves de alineación.

Conclusión: Hacia un Futuro Resiliente en IA

En resumen, el examen de intentos de intrusión en asistentes de IA revela la intersección crítica entre innovación y seguridad. Al priorizar técnicas de defensa robustas y cumplimiento regulatorio, las organizaciones pueden maximizar los beneficios de los LLM mientras minimizan riesgos. La evolución continua de amenazas exige investigación ongoing en alineación y verificación, asegurando que la IA sirva como herramienta confiable en el ecosistema tecnológico. Para más información, visita la fuente original.