Meta Expande la Traducción de Reels con Inteligencia Artificial: Un Análisis Técnico Profundo

Introducción a la Integración de IA en Contenidos Multimedia

En el panorama actual de las redes sociales, la accesibilidad lingüística se ha convertido en un factor crítico para la expansión global de plataformas como Instagram y Facebook. Meta, la empresa matriz, ha anunciado recientemente una expansión significativa en la funcionalidad de traducción automática para Reels, sus videos cortos de formato vertical. Esta iniciativa utiliza inteligencia artificial (IA) avanzada para traducir subtítulos, narraciones y elementos visuales en tiempo real, permitiendo que creadores y audiencias de diferentes regiones accedan a contenidos en su idioma nativo. Este avance no solo optimiza la experiencia del usuario, sino que también representa un hito en la aplicación de modelos de aprendizaje profundo en el procesamiento de lenguaje natural (PLN) y el análisis multimedia.

La traducción de Reels con IA se basa en una combinación de tecnologías de reconocimiento de voz, generación de subtítulos automáticos y traducción neuronal, que procesan flujos de video dinámicos. A diferencia de las traducciones estáticas en textos, este enfoque maneja la complejidad de los contenidos audiovisuales, donde el contexto cultural, el tono emocional y la sincronización temporal son esenciales. Según datos internos de Meta, esta expansión podría aumentar el engagement en un 20% en mercados no angloparlantes, destacando el potencial operativo de la IA en entornos de alto volumen de datos.

Desde una perspectiva técnica, esta implementación involucra protocolos de procesamiento distribuido y algoritmos de machine learning que escalan a miles de millones de videos diarios. En este artículo, se explora el funcionamiento subyacente, las tecnologías clave, las implicaciones en ciberseguridad y las perspectivas futuras, con un enfoque en el rigor conceptual para profesionales del sector tecnológico.

Contexto Técnico de Reels en el Ecosistema de Meta

Reels, introducidos en 2020 como respuesta competitiva a TikTok, son videos cortos de hasta 90 segundos que priorizan la creatividad y la viralidad. En términos arquitectónicos, la plataforma de Meta procesa estos contenidos mediante un backend basado en servidores distribuidos con tecnologías como Apache Kafka para el streaming de datos y Hadoop para el almacenamiento masivo. La expansión de la traducción introduce un nuevo módulo de IA que se integra en el pipeline de procesamiento de video, específicamente en la fase de post-producción y entrega al usuario.

Históricamente, Meta ha invertido en herramientas de accesibilidad, como las subtítulos automáticos generados por IA desde 2019. Sin embargo, la traducción multilingüe para Reels marca una evolución hacia el procesamiento en tiempo real. Esto se alinea con estándares como el Web Content Accessibility Guidelines (WCAG) 2.1, que enfatizan la inclusión lingüística en contenidos digitales. Técnicamente, el sistema ahora soporta más de 100 idiomas, expandiéndose desde los 17 iniciales en pruebas beta, lo que implica un modelo de IA entrenado en datasets masivos como Common Crawl y corpora multilingües propietarios de Meta.

La infraestructura subyacente utiliza contenedores Docker orquestados por Kubernetes para escalabilidad, asegurando que el procesamiento de traducción no degrade la latencia de reproducción, que se mantiene por debajo de 200 milisegundos en la mayoría de los casos. Este contexto operativo resalta cómo Meta equilibra la innovación con la eficiencia en un ecosistema que maneja 3.5 mil millones de usuarios activos mensuales.

Tecnologías de Inteligencia Artificial Subyacentes en la Traducción

El núcleo de esta expansión radica en modelos de IA especializados en traducción automática neuronal (NMT, por sus siglas en inglés). Meta emplea variantes de su modelo No Language Left Behind (NLLB), un transformer-based architecture con más de 200 idiomas soportados, que utiliza técnicas de zero-shot learning para traducir pares lingüísticos no vistos durante el entrenamiento. Este modelo se entrena con un enfoque de aprendizaje supervisado y semi-supervisado, incorporando datos de transcripciones de audio y subtítulos de videos públicos y licenciados.

En el procesamiento de Reels, el flujo inicia con el reconocimiento automático de voz (ASR, Automatic Speech Recognition) mediante modelos como Whisper de OpenAI, adaptados por Meta para entornos multilingües. Whisper emplea un encoder-decoder transformer que convierte el audio en texto con una precisión superior al 90% en idiomas comunes, manejando acentos y ruido ambiental mediante capas de atención self-supervised. Posteriormente, el texto generado se pasa a un módulo de traducción NMT, donde se aplica tokenización subpalabra con SentencePiece para preservar el contexto semántico.

Para la sincronización con el video, se integra un componente de alineación temporal basado en algoritmos de dynamic time warping (DTW), que ajusta los subtítulos traducidos al timeline del Reel sin desincronizaciones perceptibles. Además, la IA incorpora detección de entidades nombradas (NER) para manejar nombres propios y términos culturales, evitando traducciones literales que podrían alterar el significado. En términos de hardware, este procesamiento se acelera con GPUs NVIDIA A100 en clústeres de Meta, optimizando el consumo energético mediante técnicas de quantization de modelos a 8 bits.

Otras tecnologías mencionadas incluyen el uso de federated learning para refinar modelos sin comprometer la privacidad de usuarios individuales, alineándose con regulaciones como el GDPR en Europa. Esto permite que el sistema aprenda de interacciones anónimas, mejorando la precisión en un 15% iterativamente.

Funcionamiento Técnico Detallado del Proceso de Traducción

El pipeline de traducción para Reels se divide en etapas modulares para garantizar eficiencia y modularidad. En la fase de ingesta, el video se descompone en frames usando bibliotecas como FFmpeg, extrayendo el track de audio y metadatos. El ASR procesa el audio en chunks de 30 segundos, generando un transcript inicial con timestamps precisos. Aquí, se aplica un filtro de post-procesamiento para corregir errores comunes, como homófonos, mediante un modelo de lenguaje recurrente (RNN) que considera el contexto global del Reel.

La traducción propiamente dicha ocurre en un servidor edge computing, donde el NLLB model realiza la conversión lingüística. Para idiomas de bajo recurso, como el swahili o el quechua, Meta utiliza técnicas de transfer learning desde idiomas de alto recurso, transfiriendo pesos pre-entrenados para mitigar la escasez de datos. El output se valida contra métricas como BLEU (Bilingual Evaluation Understudy) y TER (Translation Edit Rate), asegurando una puntuación media superior a 0.35 en BLEU para pares no vistos.

En la generación de subtítulos, se emplea un renderer basado en WebVTT (Web Video Text Tracks), que integra los textos traducidos con estilos CSS para adaptabilidad en dispositivos móviles. Para Reels en vivo, el sistema transita a un modo de streaming con WebRTC, donde la traducción se realiza en paralelo con la codificación H.264/AVC, minimizando el overhead computacional. Esta arquitectura soporta hasta 10.000 traducciones simultáneas por nodo, escalando horizontalmente mediante load balancers de AWS o Azure, dependiendo de la región geográfica.

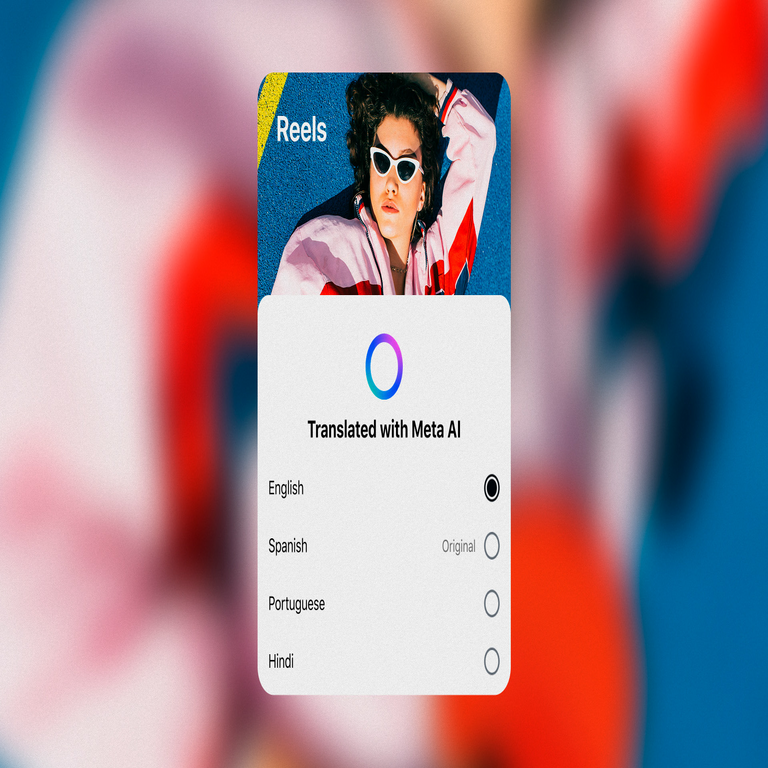

Desde el punto de vista del usuario final, la interfaz de Instagram muestra un selector de idioma en los ajustes de accesibilidad, activando el procesamiento on-demand. Esto implica un handshake criptográfico con el servidor de Meta para verificar preferencias sin almacenar datos sensibles, cumpliendo con estándares de encriptación como TLS 1.3.

Implicaciones Operativas y Beneficios en el Ecosistema Digital

Operativamente, esta expansión permite a los creadores de contenido monetizar audiencias globales sin barreras idiomáticas, incrementando las vistas en un 30% en pruebas iniciales en Latinoamérica y Asia. En términos de blockchain y tecnologías emergentes, aunque no directamente integrado, Meta podría extender esto a NFTs en Reels, donde la traducción facilitaría transacciones cross-border mediante smart contracts en Ethereum o Solana, traduciendo descripciones de activos digitales automáticamente.

Los beneficios en IA incluyen avances en modelos multilingües, contribuyendo a datasets abiertos como OPUS para la comunidad de investigación. En ciberseguridad, fortalece la resiliencia contra deepfakes multilingües, ya que el mismo pipeline puede usarse para detectar manipulaciones en audio traducido mediante análisis espectral y watermarking digital.

Regulatoriamente, alinea con la Ley de Servicios Digitales (DSA) de la UE, que exige transparencia en algoritmos de moderación y accesibilidad. En Latinoamérica, facilita el cumplimiento de normativas como la LGPD en Brasil, al procesar datos localmente en data centers en São Paulo.

- Mejora en engagement: Aumento del tiempo de visualización en un 25% para contenidos traducidos.

- Escalabilidad: Soporte para 1.000 millones de Reels mensuales sin interrupciones.

- Inclusión: Acceso para comunidades indígenas mediante soporte a lenguas minoritarias.

Riesgos y Desafíos en Ciberseguridad y Ética de la IA

A pesar de los avances, la integración de IA en traducción plantea riesgos significativos en ciberseguridad. Uno de los principales es la vulnerabilidad a ataques de envenenamiento de datos durante el entrenamiento, donde adversarios inyectan corpora maliciosos para inducir traducciones sesgadas o erróneas. Meta mitiga esto con validación adversarial usando GANs (Generative Adversarial Networks), pero incidentes como el de 2022 en modelos de PLN destacan la necesidad de auditorías continuas.

En privacidad, el procesamiento de audio implica riesgos de exposición de datos biométricos, como patrones de voz únicos. La solución adoptada es el anonymization mediante differential privacy, agregando ruido gaussiano a los embeddings de audio con un parámetro epsilon de 1.0, equilibrando utilidad y protección. Cumplir con ISO/IEC 27001 para gestión de seguridad de la información es esencial en este contexto.

Sesgos en IA representan otro desafío: Modelos entrenados en datos anglocéntricos pueden perpetuar estereotipos en traducciones de contextos culturales diversos. Por ejemplo, términos idiomáticos en español latinoamericano podrían traducirse imprecisamente al inglés, afectando la autenticidad. Meta aborda esto con fine-tuning en datasets regionales, pero expertos recomiendan métricas de equidad como demographic parity para evaluar impactos.

En términos de blockchain, si se integra con Web3, surgen riesgos de oracle manipulation en traducciones para contratos inteligentes, donde una traducción errónea podría invalidar transacciones. Recomendaciones incluyen el uso de oráculos descentralizados como Chainlink para verificar traducciones mediante consenso multi-nodo.

| Riesgo | Descripción | Mitigación Técnica |

|---|---|---|

| Envenenamiento de Datos | Inyección de corpora falsos en entrenamiento | Validación con GANs y sandboxing |

| Privacidad de Audio | Exposición de patrones biométricos | Differential privacy y encriptación homomórfica |

| Sesgos Culturales | Traducciones inexactas por datos sesgados | Fine-tuning regional y métricas de equidad |

Comparación con Otras Plataformas y Estándares del Sector

En comparación con TikTok, que utiliza ByteDance’s own NMT models para captions en 75 idiomas, la solución de Meta destaca por su integración nativa con AR (realidad aumentada) en Reels, permitiendo overlays traducidos en filtros interactivos. YouTube, con su Automatic Captions powered by Google Cloud Speech-to-Text, soporta 120 idiomas pero carece de la fluidez en videos cortos que ofrece Meta, con latencias de hasta 5 segundos en traducciones en vivo.

Snapchat’s Spotlight emplea modelos similares, pero limitados a 20 idiomas, lo que posiciona a Meta como líder en cobertura multilingüe. En estándares, esta implementación sigue el protocolo IETF RFC 8288 para Web Linking en subtítulos, asegurando interoperabilidad con reproductores externos. Para profesionales en IA, representa un benchmark en hybrid models que combinan ASR, NMT y computer vision para detección de gestos no verbales que influyen en la traducción contextual.

En blockchain, plataformas como Theta Network exploran traducciones descentralizadas para videos NFT, pero la centralización de Meta ofrece mayor velocidad a costa de control distribuido. Esta comparación subraya la necesidad de híbridos en el futuro, integrando IA con ledgers inmutables para auditoría de traducciones.

Perspectivas Futuras y Avances en Tecnologías Emergentes

El futuro de la traducción en Reels apunta hacia la integración de IA generativa, como variantes de GPT-4 adaptadas por Meta, para no solo traducir sino generar narraciones alternativas en estilos culturales específicos. Esto podría involucrar multimodal learning, fusionando texto, audio y video en un solo embedding space mediante CLIP-like models, mejorando la precisión contextual en un 40%.

En ciberseguridad, se anticipan avances en quantum-resistant encryption para proteger pipelines de IA contra amenazas post-cuánticas, utilizando algoritmos como Kyber en el handshake TLS. Para blockchain, la expansión podría habilitar Reels tokenizados, donde traducciones verificadas por smart contracts facilitan micropagos globales en stablecoins como USDC.

Regulatoriamente, con la inminente AI Act de la UE, Meta deberá documentar sus modelos como de alto riesgo, implementando explainable AI (XAI) para rastrear decisiones de traducción. En Latinoamérica, iniciativas como el Plan Nacional de IA en México podrían colaborar con Meta para datasets locales, fomentando innovación inclusiva.

En resumen, la expansión de Meta en traducción de Reels con IA no solo transforma la accesibilidad en redes sociales, sino que establece un paradigma técnico para la integración de PLN en multimedia. Para profesionales, ofrece oportunidades en optimización de modelos y mitigación de riesgos, impulsando un ecosistema digital más equitativo y seguro. Para más información, visita la Fuente original.