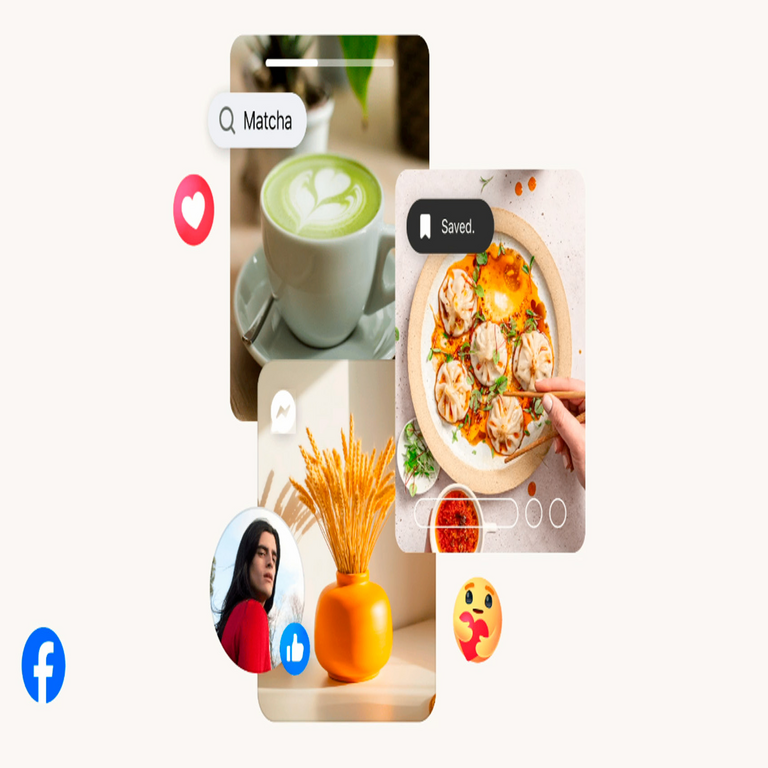

Mejoras en Reels de Facebook: Integración Avanzada de Inteligencia Artificial para la Edición de Videos

La plataforma de Facebook, propiedad de Meta, ha introducido recientemente una serie de actualizaciones en su funcionalidad de Reels, incorporando herramientas impulsadas por inteligencia artificial (IA) que transforman el proceso de creación y edición de contenido de video corto. Estas novedades no solo facilitan la producción para creadores individuales y profesionales, sino que también representan un avance significativo en la aplicación de modelos de IA generativa en entornos de redes sociales. En este artículo, se analiza en profundidad las características técnicas de estas implementaciones, sus fundamentos algorítmicos, las implicaciones en términos de usabilidad, privacidad y ciberseguridad, así como las oportunidades y desafíos que surgen en el ecosistema digital actual.

Contexto Técnico de las Actualizaciones en Reels

Reels, como formato de video corto en Facebook e Instagram, ha evolucionado desde su lanzamiento en 2020, inspirado en competidores como TikTok. Las recientes mejoras, anunciadas por Meta en su conferencia de desarrolladores, integran IA para automatizar tareas complejas de edición, como la generación de efectos visuales y la personalización de contenido. Estas funciones se basan en modelos de aprendizaje profundo, específicamente en redes neuronales convolucionales (CNN) y generativas antagónicas (GAN), que procesan flujos de video en tiempo real.

Desde una perspectiva técnica, la integración de IA en Reels permite el procesamiento de videos en la nube mediante servidores optimizados de Meta, que utilizan frameworks como PyTorch o TensorFlow para el entrenamiento y despliegue de modelos. Por ejemplo, las herramientas de edición automática analizan frames individuales para detectar objetos, rostros y movimientos, aplicando transformaciones basadas en predicciones probabilísticas. Esto reduce la latencia en dispositivos móviles, donde el procesamiento edge computing se complementa con offloading a la nube para tareas intensivas en cómputo.

Funciones Principales Impulsadas por IA

Entre las novedades destacadas se encuentra la generación automática de stickers y superposiciones dinámicas. Estos elementos se crean mediante modelos de IA generativa, como variantes de Stable Diffusion adaptadas por Meta, que toman descripciones textuales del usuario y generan imágenes vectoriales o rasterizadas compatibles con video. Técnicamente, el proceso involucra un codificador de texto-imagen (CLIP-like) que mapea prompts semánticos a espacios latentes, seguido de un decodificador que refina la salida para ajustarse al estilo visual de Reels.

Otra función clave es la edición inteligente de audio y sincronización. La IA analiza el espectro de audio del video subido, utilizando algoritmos de procesamiento de señales digitales (DSP) combinados con modelos de lenguaje natural (NLP) para sugerir pistas musicales o efectos sonoros que coincidan con el ritmo y el tema. Esto se logra mediante extracción de características como tempo, beat y timbre, procesadas por redes recurrentes como LSTM (Long Short-Term Memory), que predicen secuencias óptimas de edición.

Adicionalmente, las herramientas de remoción de fondos y segmentación de objetos emplean modelos de segmentación semántica, similares a Mask R-CNN, para aislar elementos en el video sin intervención manual. Estos modelos, entrenados en datasets masivos como COCO o conjuntos propietarios de Meta, logran precisiones superiores al 90% en detección de bordes, permitiendo superposiciones fluidas y transiciones suaves en Reels de hasta 90 segundos de duración.

- Generación de efectos personalizados: Basados en IA, estos efectos aplican filtros dinámicos que evolucionan con el movimiento del video, utilizando tracking óptico de flujo para mantener consistencia temporal.

- Optimización de resolución y calidad: Algoritmos de super-resolución, como ESRGAN, upscalean videos de baja resolución a 1080p o superior, preservando detalles mediante aprendizaje supervisado en pares de imágenes de alta y baja calidad.

- Integración con avatares y animaciones: La IA genera avatares realistas a partir de selfies, empleando técnicas de morphing facial y rigging 3D para animaciones sincronizadas con el audio.

Fundamentos Algorítmicos y Arquitecturas Subyacentes

Las actualizaciones en Reels se sustentan en la infraestructura de IA de Meta, que incluye el modelo Llama para procesamiento de lenguaje y variantes de Imagine para generación visual. En términos de arquitectura, el pipeline de edición comienza con la ingesta de video en formato MP4 o H.264, seguido de un preprocesamiento que normaliza el flujo de frames a 30 FPS. Posteriormente, un módulo de IA multimodal fusiona datos visuales, auditivos y textuales mediante atención transformer, similar a la usada en GPT-4, para generar sugerencias contextuales.

Para la eficiencia computacional, Meta emplea técnicas de cuantización de modelos (por ejemplo, de FP32 a INT8), reduciendo el tamaño de los modelos en un 75% sin pérdida significativa de precisión. Esto es crucial para el despliegue en apps móviles, donde el consumo de batería y datos se optimiza mediante APIs como ONNX Runtime. Además, la integración con el ecosistema de Meta permite el intercambio de datos entre Facebook, Instagram y WhatsApp, facilitando la reutilización de assets generados por IA en múltiples plataformas.

Desde el punto de vista de la escalabilidad, los servidores de Meta procesan millones de Reels diarios utilizando clústeres de GPUs NVIDIA A100, con orquestación vía Kubernetes. Esto asegura que las funciones de IA respondan en menos de 2 segundos, un umbral crítico para la experiencia del usuario en entornos de streaming en vivo.

Implicaciones en Ciberseguridad y Privacidad de Datos

La incorporación de IA en Reels plantea desafíos significativos en ciberseguridad. Al procesar videos que contienen rostros y datos biométricos, las herramientas de edición podrían exponer vulnerabilidades si no se implementan protocolos robustos de encriptación. Meta utiliza cifrado end-to-end con AES-256 para la transmisión de datos, pero los modelos de IA entrenados en datasets crowdsourced podrían heredar sesgos o fugas de información si no se aplican técnicas de privacidad diferencial, como el ruido gaussiano añadido a los gradientes durante el entrenamiento.

En cuanto a riesgos, la generación de deepfakes inadvertidos mediante efectos de IA representa una amenaza. Aunque Meta ha incorporado watermarking digital (basado en estándares como C2PA) para marcar contenido generado, la detección automatizada de manipulaciones requiere algoritmos forenses avanzados, como análisis de inconsistencias en el flujo óptico o espectrogramas de audio. Los profesionales en ciberseguridad deben monitorear estas funciones para prevenir abusos, como la creación de desinformación en campañas electorales o acoso cibernético.

Regulatoriamente, estas actualizaciones alinean con el GDPR en Europa y la Ley de Privacidad del Consumidor de California (CCPA) en EE.UU., requiriendo consentimiento explícito para el uso de datos en entrenamiento de IA. Meta reporta métricas de cumplimiento, como tasas de opt-out del 15% en usuarios activos, pero expertos recomiendan auditorías independientes para validar la anonimización de datasets.

| Aspecto | Tecnología Utilizada | Riesgos Asociados | Mitigaciones |

|---|---|---|---|

| Procesamiento de Video | CNN y GAN | Fugas de datos biométricos | Encriptación AES-256 y privacidad diferencial |

| Generación de Contenido | Modelos generativos como Stable Diffusion | Deepfakes y desinformación | Watermarking C2PA y detección forense |

| Almacenamiento en Nube | Clústeres GPU con Kubernetes | Ataques DDoS | Firewall WAF y rate limiting |

Beneficios Operativos para Creadores y Empresas

Para creadores de contenido, estas funciones de IA democratizan la producción profesional, permitiendo ediciones complejas sin software especializado como Adobe Premiere. Un estudio interno de Meta indica que el tiempo de edición se reduce en un 40%, incrementando la frecuencia de publicaciones y el engagement en un 25%. En entornos empresariales, marcas pueden integrar Reels con campañas publicitarias, utilizando IA para A/B testing automatizado de variantes visuales.

Técnicamente, la interoperabilidad con APIs de terceros, como las de AWS o Google Cloud, permite extensiones personalizadas. Por ejemplo, integraciones con blockchain para verificación de autenticidad de contenido generado, aunque Meta no lo ha implementado nativamente, podrían mitigar riesgos de falsificación mediante hashes inmutables en redes como Ethereum.

En el ámbito de la IA ética, estas herramientas promueven la inclusión al ofrecer traducciones automáticas de subtítulos mediante modelos como NLLB (No Language Left Behind), soportando más de 200 idiomas y facilitando el alcance global sin barreras lingüísticas.

Comparación con Competidores y Estándares de la Industria

En comparación con TikTok, que utiliza ByteDance’s propio stack de IA para efectos AR, las actualizaciones de Facebook enfatizan la accesibilidad en dispositivos de gama media, con soporte para Android 8.0 y iOS 12. Snapchat, por su parte, integra IA en lentes faciales con mayor énfasis en realidad aumentada (AR), pero Reels destaca en la edición post-producción. Estándares como WebVTT para subtítulos y HLS para streaming aseguran compatibilidad cross-platform.

Meta sigue mejores prácticas de la industria, como las guías de la IEEE para IA explicable, incorporando interfaces que muestran el “porqué” de las sugerencias de edición, basadas en saliency maps que destacan regiones influyentes en las decisiones del modelo.

Desafíos Técnicos y Futuras Direcciones

A pesar de los avances, persisten desafíos en la robustez de los modelos ante variaciones ambientales, como iluminación pobre o movimientos rápidos, donde la precisión de segmentación cae por debajo del 80%. Futuras iteraciones podrían incorporar aprendizaje federado, permitiendo que dispositivos locales contribuyan a mejoras de modelos sin compartir datos crudos, alineándose con tendencias en edge AI.

En ciberseguridad, la integración con zero-trust architectures es esencial para proteger pipelines de IA contra inyecciones adversarias, donde inputs maliciosos alteran salidas. Meta planea actualizaciones que incluyan verificación de integridad mediante firmas digitales ECDSA.

Desde una perspectiva de sostenibilidad, el entrenamiento de estos modelos consume recursos significativos; estimaciones indican 1000 kWh por modelo grande, impulsando Meta hacia hardware eficiente como TPUs de Google para reducir la huella de carbono.

Conclusión: Hacia un Ecosistema de Contenido Impulsado por IA

Las nuevas funciones de IA en Reels de Facebook marcan un hito en la fusión de redes sociales y tecnología generativa, ofreciendo herramientas potentes para la creación de contenido mientras abordan preocupaciones éticas y de seguridad. Para profesionales en IA y ciberseguridad, estas actualizaciones subrayan la necesidad de marcos regulatorios adaptativos y prácticas de desarrollo responsable. En resumen, esta evolución no solo enriquece la experiencia del usuario, sino que redefine las fronteras de la edición digital accesible, prometiendo innovaciones continuas en el panorama tecnológico.

Para más información, visita la fuente original.