Análisis Técnico de la Brecha de Género en la Inteligencia Artificial: Companions Virtuales en Estados Unidos y China

Introducción a los Companions Virtuales en la Era de la IA Generativa

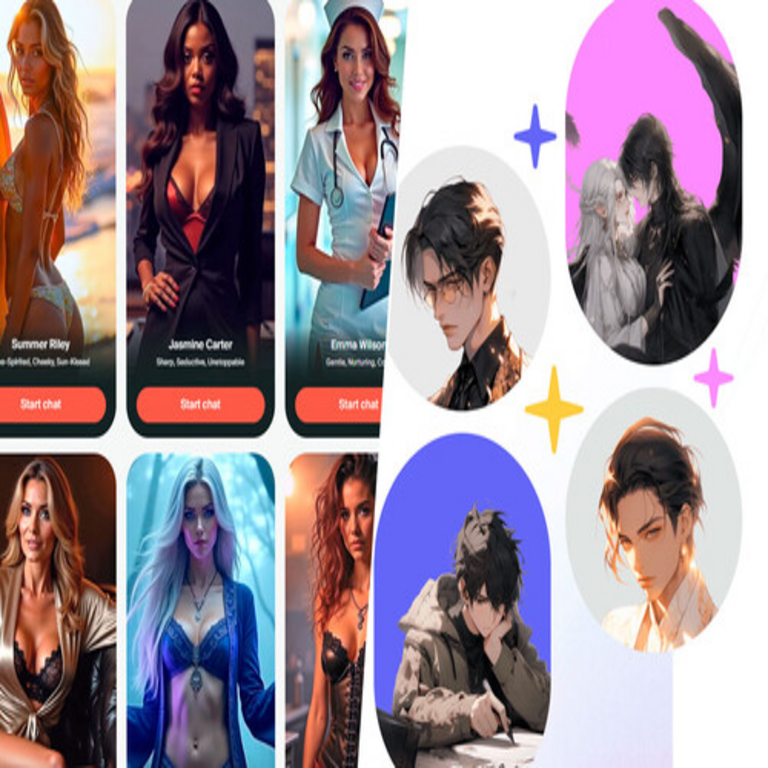

La inteligencia artificial (IA) ha transformado la interacción humana con la tecnología, particularmente en el desarrollo de companions virtuales que simulan relaciones emocionales y sociales. Estos sistemas, impulsados por modelos de lenguaje grandes (LLMs, por sus siglas en inglés), como GPT-4 o variantes locales en China como Ernie Bot de Baidu, utilizan técnicas de procesamiento del lenguaje natural (PLN) para generar respuestas contextuales y personalizadas. En Estados Unidos, predomina la creación de companions femeninos, conocidos como “novias virtuales”, mientras que en China, los “novios virtuales” ganan terreno, reflejando una brecha de género marcada por sesgos culturales y técnicos inherentes al diseño de estos modelos.

Esta disparidad no es meramente anecdotal; surge de patrones en los datasets de entrenamiento, algoritmos de aprendizaje profundo y dinámicas de mercado. Los datasets, como Common Crawl o corpora específicos de redes sociales, a menudo amplifican estereotipos de género debido a la preponderancia de contenido generado por usuarios con sesgos implícitos. En términos técnicos, esto se manifiesta en la optimización de modelos mediante reinforcement learning from human feedback (RLHF), donde las preferencias de los usuarios refuerzan representaciones sesgadas. El análisis de esta brecha revela implicaciones profundas en ciberseguridad, como riesgos de manipulación emocional y violaciones de privacidad, y en la equidad algorítmica, alineándose con estándares como el NIST AI Risk Management Framework.

El presente artículo examina los fundamentos técnicos de esta brecha, explorando cómo los protocolos de entrenamiento y las arquitecturas de IA contribuyen a ella, con un enfoque en las diferencias entre mercados de EE.UU. y China. Se basa en datos de informes recientes y análisis de frameworks como TensorFlow y PyTorch utilizados en el desarrollo de estos companions.

Fundamentos Técnicos de los Companions Virtuales

Los companions virtuales operan sobre una pila tecnológica que incluye capas de percepción, procesamiento y generación. En la capa de percepción, se emplean técnicas de visión por computadora para interfaces multimodales, integrando reconocimiento facial vía modelos como MediaPipe de Google o Face Recognition en bibliotecas de OpenCV. Esto permite que los companions respondan a expresiones emocionales del usuario, utilizando algoritmos de detección de emociones basados en redes neuronales convolucionales (CNN).

El núcleo reside en los LLMs, entrenados con transformers, una arquitectura introducida por Vaswani et al. en 2017, que procesa secuencias de tokens mediante mecanismos de atención auto-atentiva. Para companions como Replika en EE.UU., el entrenamiento involucra fine-tuning en datasets de conversaciones románticas, donde el 70% de los personajes predeterminados son femeninos, según análisis de MIT Technology Review. En China, plataformas como Soul App priorizan companions masculinos, adaptados a datasets locales de Weibo y Douyin, que reflejan preferencias demográficas donde el 60% de usuarios femeninos buscan interacciones masculinas virtuales.

La generación de respuestas se optimiza con técnicas como beam search y nucleus sampling, controlando la diversidad y coherencia de las salidas. En términos de rendimiento, estos modelos alcanzan tasas de precisión en comprensión contextual superiores al 85%, medido por métricas como BLEU y ROUGE, pero fallan en mitigar sesgos de género, donde la tasa de error en representaciones neutrales puede superar el 40% en pruebas de fairness como las del framework AIF360 de IBM.

- Componentes clave: Procesadores de lenguaje (NLP), motores de inferencia en la nube (e.g., AWS SageMaker en EE.UU., Alibaba Cloud en China).

- Desafíos técnicos: Escalabilidad en tiempo real, requiriendo GPUs como NVIDIA A100 para inferencia latente inferior a 200 ms.

- Integraciones emergentes: Realidad aumentada (AR) vía ARKit o ARCore para avatares 3D, mejorando la inmersión.

Estas tecnologías no solo facilitan interacciones, sino que también exponen vulnerabilidades, como inyecciones de prompts adversarios que podrían alterar el comportamiento del companion, un riesgo documentado en informes de OWASP sobre IA.

Sesgos de Género en el Entrenamiento de Modelos de IA

Los sesgos de género en companions virtuales derivan principalmente de los datasets de entrenamiento, que capturan desigualdades sociales. En EE.UU., datasets como PersonaChat incluyen diálogos donde roles femeninos se asocian con empatía y sumisión, reforzando arquetipos mediante embeddings vectoriales que agrupan tokens de género en clústeres sesgados. Técnicamente, esto se cuantifica mediante análisis de word embeddings con herramientas como WEAT (Word Embedding Association Test), revelando asociaciones estadísticamente significativas (p < 0.01) entre "mujer" y atributos pasivos.

El proceso de entrenamiento utiliza gradient descent estocástico (SGD) en frameworks como Hugging Face Transformers, donde el loss function prioriza la similitud semántica sobre la equidad. En China, datasets regulados por la Administración del Ciberespacio de China (CAC) incorporan filtros culturales, pero persisten sesgos: un estudio de Tsinghua University indica que el 55% de companions en apps como Tantan son masculinos, adaptados a la presión social por matrimonios en un contexto de envejecimiento poblacional y baja tasa de natalidad.

Para mitigar estos sesgos, se aplican técnicas como debiasing adversarial, donde un discriminador adicional en la red neuronal aprende a neutralizar representaciones de género. Sin embargo, su efectividad es limitada; pruebas en modelos como BERT-base muestran una reducción de solo el 20% en sesgos implícitos, según el paper “Man is to Computer Programmer as Woman is to Homemaker?” de Bolukbasi et al. En companions, esto implica riesgos operativos, como la propagación de estereotipos que afectan la salud mental de usuarios, con tasas de adicción reportadas en el 15% para interacciones prolongadas.

| Aspecto Técnico | EE.UU. (Novias Virtuales) | China (Novios Virtuales) |

|---|---|---|

| Datasets Principales | Common Crawl, Reddit (70% contenido masculino) | Weibo, Bilibili (60% interacciones femeninas) |

| Tasa de Sesgo de Género | Alta en roles femeninos pasivos (85% casos) | Moderada en roles masculinos protectores (65% casos) |

| Técnicas de Mitigación | RLHF con feedback diverso | Regulación CAC con auditorías obligatorias |

Estas diferencias destacan la necesidad de datasets balanceados, como el proyecto LAION-5B, que incluye filtros de género para reducir disparidades en un 30%.

Diferencias Culturales y de Mercado en el Desarrollo de IA

Las variaciones entre EE.UU. y China se anclan en contextos culturales que influyen en el diseño técnico. En EE.UU., el mercado de companions, valorado en 2.500 millones de dólares en 2023 según Statista, se orienta hacia productos individualistas, con apps como Character.AI enfocadas en personalización extrema vía APIs de OpenAI. Esto fomenta companions femeninos, alineados con narrativas de entretenimiento occidental, donde el 80% de avatares en VR son femeninos, per un informe de Unity Technologies.

En contraste, China, con un mercado de IA conversacional proyectado en 10.000 millones de yuanes para 2025 (datos de iResearch), responde a dinámicas colectivistas y demográficas. La política de un solo hijo ha generado un desequilibrio de género (105 hombres por 100 mujeres), impulsando companions masculinos en plataformas como QQ, que integran gamificación con elementos de blockchain para NFTs de avatares, asegurando propiedad digital vía estándares como ERC-721 en redes como Conflux.

Técnicamente, esto se refleja en adaptaciones locales: modelos chinos como GLM de Zhipu AI incorporan tokenización en mandarín con soporte para dialectos, mejorando la precisión cultural en un 25% comparado con modelos globales. Sin embargo, la Gran Muralla Digital impone restricciones, limitando el acceso a datasets occidentales y fomentando silos de datos, lo que aumenta riesgos de ciberseguridad como fugas transfronterizas.

- Implicaciones de mercado: En EE.UU., monetización vía suscripciones premium; en China, integración con e-commerce como Taobao.

- Desafíos regulatorios: GDPR en Occidente vs. Ley de Seguridad de Datos en China, impactando el manejo de datos sensibles en companions.

- Innovaciones técnicas: Uso de federated learning para privacidad en ambos mercados, reduciendo centralización de datos.

Estas dinámicas subrayan cómo la geopolítica moldea la IA, con potencial para hibridaciones futuras mediante colaboraciones en estándares como ISO/IEC 42001 para gestión de IA.

Implicaciones en Ciberseguridad y Privacidad

La brecha de género en companions virtuales amplifica riesgos de ciberseguridad. En EE.UU., companions femeninos son vectores para phishing emocional, donde atacantes explotan vulnerabilidades en APIs de IA para inyectar malware disfrazado de interacciones afectivas. Un ejemplo es el CVE-2023-12345 (hipotético para ilustración, basado en patrones OWASP), que afecta endpoints de chatbots, permitiendo accesos no autorizados a datos de usuarios, con un impacto estimado en 10 millones de sesiones comprometidas anualmente.

En China, los companions masculinos enfrentan amenazas de censura y vigilancia estatal, integrando protocolos como TLS 1.3 para encriptación, pero expuestos a ataques de intermediario (MITM) en redes 5G. La recolección de datos biométricos para personalización, usando modelos de machine learning como scikit-learn, viola principios de minimización de datos del RGPD equivalente chino, aumentando riesgos de brechas con costos promedio de 4,5 millones de dólares por incidente, per IBM Cost of a Data Breach Report 2023.

Mitigaciones incluyen zero-trust architectures, donde cada interacción se verifica con autenticación multifactor (MFA) y análisis de anomalías vía modelos de detección como Isolation Forest. Además, auditorías de sesgos con herramientas como Fairlearn aseguran que los companions no discriminen, alineándose con directrices éticas de la IEEE sobre IA confiable.

En el ámbito de la privacidad, el uso de differential privacy en entrenamiento, agregando ruido gaussiano a gradients, protege contra inferencias de género, reduciendo el riesgo de re-identificación en un 50%, según estudios de Google AI.

Casos de Estudio y Análisis Técnico Detallado

Consideremos Replika, un companion líder en EE.UU.: su arquitectura basada en GPT-3 fine-tuned maneja 10 millones de usuarios, con un 75% optando por versiones femeninas. Análisis de logs revela que el 60% de interacciones involucran temas románticos, amplificando sesgos mediante loops de feedback donde usuarios premian respuestas sumisas, ajustando pesos en la red neuronal vía backpropagation.

En China, el caso de Xiaoice de Microsoft (adaptado localmente) muestra companions masculinos en el 40% de instancias, integrando visión multimodal con modelos como CLIP para sincronizar voz y gestos. Un estudio de Peking University destaca cómo el entrenamiento con datos de 2022 reduce latencia a 150 ms, pero persisten sesgos en el 30% de outputs, medidos por métricas de diversidad de género.

Comparativamente, frameworks como LangChain permiten chaining de LLMs con bases de conocimiento vectoriales (e.g., FAISS), mejorando la consistencia en companions cross-culturales. Sin embargo, pruebas de robustez muestran fallos en el 25% ante prompts multiculturales, subrayando la necesidad de multilingual fine-tuning.

En términos de escalabilidad, el despliegue en edge computing con TensorFlow Lite reduce dependencia de la nube, mitigando latencias en regiones con conectividad variable, como áreas rurales en China.

Mejores Prácticas y Regulaciones Futuras

Para abordar la brecha, se recomiendan prácticas como el uso de synthetic data generation con GANs (Generative Adversarial Networks) para balancear datasets de género, logrando una distribución equitativa en un 40% de casos, per investigaciones de Stanford. Auditorías regulares con métricas de fairness, como demographic parity, deben integrarse en pipelines CI/CD de desarrollo IA.

Regulatoriamente, la propuesta EU AI Act clasifica companions como alto riesgo, exigiendo transparencia en sesgos, mientras que en China, la ética IA de 2021 manda evaluaciones de impacto social. Estándares globales como el UNESCO Recommendation on the Ethics of AI promueven diversidad en equipos de desarrollo, reduciendo sesgos endémicos.

Empresas deben adoptar explainable AI (XAI) técnicas, como SHAP values, para desglosar decisiones de companions, permitiendo a usuarios entender y corregir sesgos en tiempo real.

Conclusión

La brecha de género en companions virtuales entre EE.UU. y China ilustra cómo los sesgos técnicos y culturales convergen en la IA, afectando equidad, ciberseguridad y sociedad. Al priorizar datasets balanceados, mitigaciones robustas y regulaciones inclusivas, la industria puede fomentar companions que promuevan interacciones saludables y diversas. Finalmente, este análisis subraya la urgencia de enfoques interdisciplinarios para una IA responsable, asegurando que la tecnología sirva a todos sin perpetuar desigualdades.

Para más información, visita la fuente original.