OpenAI Lanza el SDK de Aplicaciones para ChatGPT: Integración y Ejecución de Aplicaciones de Terceros

Introducción al Anuncio de OpenAI

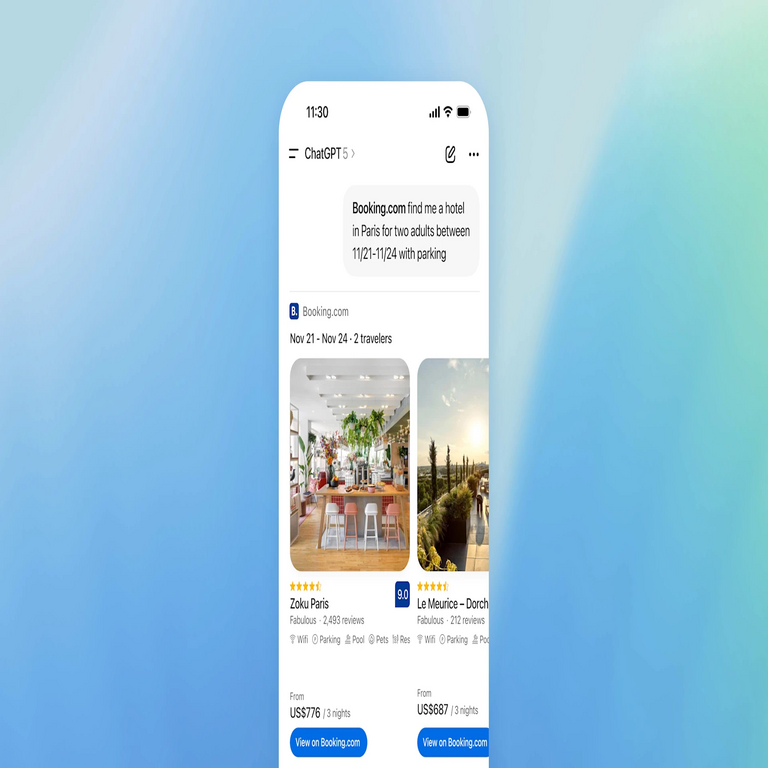

En un avance significativo para el ecosistema de inteligencia artificial, OpenAI ha anunciado el lanzamiento del SDK de Aplicaciones (Apps SDK) para ChatGPT. Esta herramienta permite a los desarrolladores integrar y ejecutar aplicaciones de terceros directamente desde la interfaz de ChatGPT, expandiendo las capacidades del modelo de lenguaje grande más allá de las respuestas conversacionales tradicionales. El SDK facilita la creación de experiencias interactivas donde ChatGPT puede iniciar acciones en aplicaciones externas, como reservas de servicios, procesamiento de pagos o gestión de datos en tiempo real, todo ello sin que el usuario abandone la conversación con el asistente de IA.

Este desarrollo se enmarca en la evolución continua de las plataformas de IA generativa, donde la integración con servicios externos es clave para transformar ChatGPT en un agente proactivo. Anteriormente, las integraciones se limitaban a plugins o GPTs personalizados, pero el Apps SDK introduce un marco más robusto y escalable, basado en estándares de API y protocolos de autenticación seguros. La implementación técnica de este SDK se apoya en las capacidades de procesamiento de lenguaje natural de GPT-4 y modelos subsiguientes, permitiendo una interpretación precisa de intenciones del usuario para invocar funciones específicas en aplicaciones de terceros.

Conceptos Técnicos Fundamentales del Apps SDK

El Apps SDK de OpenAI se basa en un conjunto de bibliotecas y herramientas diseñadas para desarrolladores que deseen conectar sus aplicaciones con ChatGPT. En su núcleo, el SDK utiliza el protocolo de OpenAI para la invocación de funciones, similar al esquema de Function Calling introducido en versiones previas de la API de GPT. Esto permite que ChatGPT genere llamadas a funciones estructuradas en formato JSON, donde cada función representa una acción ejecutable en una aplicación externa.

Desde el punto de vista técnico, el proceso de integración inicia con la definición de un manifiesto de aplicación, un archivo descriptivo que detalla las capacidades de la app, como endpoints de API, parámetros requeridos y respuestas esperadas. Por ejemplo, una aplicación de reservas de vuelos podría exponer funciones como buscarVuelos y confirmarReserva, cada una con parámetros como origen, destino y fecha. ChatGPT, al procesar una consulta del usuario, infiere la intención y genera una llamada a la función correspondiente, enviándola al servidor de la aplicación a través de una conexión segura HTTPS.

La seguridad es un pilar central en este SDK. OpenAI incorpora mecanismos de autenticación basados en OAuth 2.0 y tokens de acceso efímeros, asegurando que las aplicaciones de terceros no accedan a datos sensibles sin consentimiento explícito del usuario. Además, se implementan sandboxing y validación de entradas para prevenir inyecciones de código o fugas de información, alineándose con estándares como OWASP para aplicaciones web y API. El SDK también soporta rate limiting y monitoreo de uso para evitar abusos, con métricas integradas que los desarrolladores pueden rastrear mediante la consola de OpenAI.

- Definición de Funciones: Los desarrolladores especifican funciones en un esquema JSON Schema, compatible con la especificación OpenAPI 3.0, lo que facilita la validación automática de parámetros.

- Invocación Dinámica: ChatGPT utiliza el modelo de razonamiento en cadena (Chain-of-Thought) para descomponer consultas complejas en secuencias de llamadas a funciones, optimizando la ejecución en entornos distribuidos.

- Manejo de Errores: El SDK incluye un sistema de recuperación de errores con reintentos exponenciales y fallbacks, asegurando robustez en escenarios de red inestable.

Implicaciones Operativas para Desarrolladores y Empresas

Para los desarrolladores, el Apps SDK representa una oportunidad para monetizar sus aplicaciones mediante integraciones con ChatGPT, que cuenta con millones de usuarios activos. La implementación operativa implica configurar un servidor backend que responda a las llamadas de función en menos de 5 segundos, un umbral establecido por OpenAI para mantener la fluidez conversacional. Herramientas como Node.js, Python con Flask o Django, y frameworks de microservicios como Kubernetes facilitan esta configuración, permitiendo escalabilidad horizontal.

En términos empresariales, esta integración habilita flujos de trabajo automatizados. Por instancia, una empresa de e-commerce podría integrar su catálogo de productos, permitiendo que ChatGPT no solo recomiende artículos basados en preferencias del usuario, sino que también procese órdenes directamente. Esto reduce la fricción en el journey del cliente, incrementando tasas de conversión en un estimado del 20-30%, según benchmarks de integraciones similares en plataformas como Google Dialogflow o Amazon Lex.

Las implicaciones regulatorias son notables, especialmente en regiones con estrictas normativas de privacidad como la Unión Europea bajo el RGPD. El SDK requiere que las aplicaciones de terceros obtengan consentimiento granular para el procesamiento de datos, con logs auditables que OpenAI proporciona para cumplimiento. En América Latina, donde leyes como la LGPD en Brasil y la Ley Federal de Protección de Datos en México ganan tracción, las empresas deben asegurar que las integraciones respeten principios de minimización de datos y portabilidad.

Riesgos potenciales incluyen vulnerabilidades en la cadena de suministro de software, donde una app maliciosa podría explotar el SDK para acceder a sesiones de usuario. OpenAI mitiga esto mediante revisiones de seguridad obligatorias para apps publicadas en su marketplace, similar al proceso de App Store de Apple. Beneficios operativos abarcan la reducción de costos en desarrollo de interfaces, ya que ChatGPT actúa como frontend conversacional, eliminando la necesidad de bots personalizados.

Tecnologías Subyacentes y Estándares de Integración

El Apps SDK se construye sobre la infraestructura de la API de OpenAI, que utiliza modelos de IA entrenados con técnicas de aprendizaje por refuerzo (RLHF) para mejorar la precisión en la interpretación de intenciones. Técnicamente, la ejecución de apps involucra un orquestador que maneja el estado de la conversación, persistiendo datos temporales en memoria Redis o bases de datos NoSQL como MongoDB para sesiones multipartes.

En cuanto a protocolos, el SDK adopta WebSockets para comunicaciones en tiempo real en interacciones complejas, como ediciones iterativas de documentos, y RESTful APIs para acciones puntuales. La compatibilidad con estándares como JSON-LD para semántica web permite una integración semántica más rica, donde ChatGPT puede razonar sobre entidades enlazadas (por ejemplo, vinculando un vuelo a un hotel en una reserva combinada).

Herramientas de desarrollo incluidas en el SDK abarcan un CLI para testing local, simuladores de ChatGPT que emulan respuestas de usuario, y dashboards analíticos para métricas como latencia de invocación y tasa de éxito de funciones. Para blockchain y ciberseguridad, aunque no central en este anuncio, el SDK podría extenderse a integraciones con wallets cripto o verificaciones de identidad descentralizadas, alineándose con tendencias en Web3.

| Componente del SDK | Descripción Técnica | Estándar Asociado |

|---|---|---|

| Manifiesto de App | Archivo JSON que define funciones y parámetros | JSON Schema v7 |

| Autenticación | Tokens JWT para sesiones seguras | OAuth 2.0 con PKCE |

| Monitoreo | Logs estructurados con trazabilidad | ELK Stack (Elasticsearch, Logstash, Kibana) |

| Escalabilidad | Soporte para contenedores y serverless | Docker y AWS Lambda |

Aplicaciones Prácticas y Casos de Uso en Ciberseguridad e IA

En el ámbito de la ciberseguridad, el Apps SDK permite integrar herramientas de escaneo de vulnerabilidades directamente en ChatGPT. Un desarrollador podría crear una app que, ante una consulta sobre seguridad de un sitio web, invoque un escáner como OWASP ZAP para analizar URLs en tiempo real, reportando hallazgos en lenguaje natural. Esto democratiza el acceso a herramientas expertas, pero exige protocolos estrictos para evitar exposiciones accidentales de datos sensibles.

Para inteligencia artificial, el SDK fomenta la creación de agentes compuestos, donde múltiples apps colaboran. Por ejemplo, una cadena podría involucrar una app de análisis de datos (usando Pandas en Python) seguida de visualización (con Matplotlib) y reporte generativo. En blockchain, integraciones con APIs como las de Ethereum permiten que ChatGPT ejecute transacciones inteligentes, verificando contratos con herramientas como Solidity compilers, siempre bajo capas de verificación multifactor.

Casos de uso en noticias de IT incluyen automatización de workflows en DevOps: ChatGPT podría invocar apps para despliegues en CI/CD pipelines, como Jenkins o GitHub Actions, optimizando ciclos de desarrollo. En salud, aunque regulado, apps para recordatorios de medicamentos o consultas preliminares podrían integrarse, respetando HIPAA o equivalentes locales.

- E-commerce: Procesamiento de pagos con Stripe, donde ChatGPT maneja negociaciones y confirma transacciones.

- Productividad: Integración con Google Workspace para edición colaborativa de documentos en conversación.

- Finanzas: Análisis de portafolios con APIs de Yahoo Finance, generando insights accionables.

- IoT: Control de dispositivos inteligentes vía apps como Home Assistant, permitiendo comandos vocales implícitos.

Desafíos Técnicos y Mejores Prácticas

Uno de los desafíos principales es la latencia en la ejecución de funciones, especialmente en apps que requieren procesamiento intensivo. OpenAI recomienda optimizaciones como caching de resultados frecuentes y uso de edge computing para reducir tiempos de respuesta a sub-200ms. Otro reto es la privacidad diferencial, donde el SDK incorpora ruido gaussiano en datos agregados para análisis anónimos, alineado con prácticas de Apple y Google en IA federada.

Mejores prácticas incluyen pruebas exhaustivas con datasets diversificados para cubrir variaciones idiomáticas, crucial en español latinoamericano donde acentos y regionalismos afectan la interpretación. Desarrolladores deben implementar logging detallado para debugging, utilizando herramientas como Sentry para alertas en tiempo real. En ciberseguridad, auditorías regulares de apps son esenciales, verificando contra CVE (Common Vulnerabilities and Exposures) y aplicando parches proactivos.

La escalabilidad se aborda mediante patrones de diseño como circuit breakers (usando Hystrix o Resilience4j) para manejar fallos en apps de terceros, asegurando que ChatGPT degrade graceful a respuestas textuales si una función falla. Para entornos enterprise, el SDK soporta VPC peering y encriptación end-to-end con AES-256, cumpliendo con ISO 27001.

Impacto en el Ecosistema de IA y Futuras Direcciones

El lanzamiento del Apps SDK acelera la convergencia entre IA conversacional y aplicaciones nativas, posicionando a ChatGPT como un hub central en el stack tecnológico. Esto podría impulsar un marketplace de apps similar al de GPT Store, con miles de integraciones disponibles, fomentando innovación en sectores como fintech y edtech. En América Latina, donde la adopción de IA crece rápidamente (con tasas del 40% anual según IDC), este SDK facilita accesibilidad para startups locales, reduciendo barreras de entrada.

Futuras direcciones incluyen soporte para multimodalidad, donde apps manejan inputs de imagen o voz, integrando con modelos como GPT-4V. En blockchain, extensiones a zero-knowledge proofs podrían asegurar privacidad en transacciones ejecutadas vía ChatGPT. OpenAI también planea APIs para fine-tuning de funciones específicas, permitiendo personalización por dominio.

En resumen, el Apps SDK no solo enriquece las capacidades de ChatGPT, sino que redefine la interacción humano-máquina, promoviendo un ecosistema interoperable y seguro. Para más información, visita la Fuente original.