La Búsqueda de la Inteligencia Artificial General: Entre Promesas y la Conquista de la Economía de la Atención

En el panorama actual de la inteligencia artificial (IA), las grandes empresas tecnológicas como OpenAI, Google y Meta proclaman ambiciosos objetivos centrados en el desarrollo de la Inteligencia Artificial General (AGI, por sus siglas en inglés). Esta visión promete sistemas capaces de realizar cualquier tarea intelectual humana con autonomía y eficiencia superior. Sin embargo, un análisis más profundo revela que, más allá de estas declaraciones grandiosas, el enfoque real de estas compañías se orienta hacia la captación y monetización de la economía de la atención. Este artículo examina los aspectos técnicos subyacentes, las estrategias empresariales y las implicaciones operativas de esta dinámica, basándose en tendencias observadas en el sector.

Conceptos Fundamentales de la Inteligencia Artificial General

La AGI representa un paradigma avanzado en IA, distinto de la inteligencia artificial estrecha (ANI, por sus siglas en inglés) que domina el mercado actual. Mientras que la ANI se especializa en tareas específicas, como el reconocimiento de imágenes mediante redes neuronales convolucionales (CNN) o la traducción de idiomas con modelos de secuencia a secuencia basados en transformers, la AGI aspira a una generalización cognitiva similar a la humana. Técnicamente, esto implica la integración de módulos de aprendizaje profundo que abarquen razonamiento lógico, aprendizaje no supervisado, toma de decisiones en entornos inciertos y adaptación continua sin necesidad de reentrenamiento masivo.

Desde una perspectiva arquitectónica, los modelos actuales de IA generativa, como los Large Language Models (LLMs) de la familia GPT desarrollados por OpenAI, utilizan arquitecturas basadas en transformers. Estos modelos procesan secuencias de tokens mediante mecanismos de atención autoatentos, donde la complejidad computacional escala cuadráticamente con la longitud de la secuencia (O(n²)). Para avanzar hacia la AGI, se requerirían innovaciones como el aprendizaje por refuerzo jerárquico, que combina políticas de alto nivel con acciones de bajo nivel, o sistemas multimodales que integren visión, lenguaje y razonamiento simbólico. Sin embargo, los desafíos técnicos son significativos: el consumo energético de entrenar un LLM como GPT-4 supera los 1.000 MWh, equivalente al consumo anual de cientos de hogares, lo que plantea barreras escalabilidad y sostenibilidad.

En términos de entrenamiento, la AGI demandaría datasets masivos y diversos, superando los terabytes de texto y datos multimodales utilizados en modelos actuales. Protocolos como el fine-tuning supervisado y el alineamiento con preferencias humanas (RLHF, Reinforcement Learning from Human Feedback) son pasos intermedios, pero insuficientes para lograr generalización verdadera. Estudios recientes, como los publicados en conferencias como NeurIPS, destacan limitaciones en la comprensión causal de los LLMs, que a menudo generan respuestas plausibles pero no necesariamente correctas, revelando una brecha entre simulación y inteligencia genuina.

Avances Técnicos en IA Generativa y sus Limitaciones

Las empresas líderes han impulsado avances notables en IA generativa, que sirven como base para las narrativas de AGI. Por ejemplo, el modelo Gemini de Google integra capacidades multimodales, procesando texto, imágenes y audio mediante una arquitectura unificada de transformers. Esto permite aplicaciones como la generación de código a partir de descripciones naturales o la síntesis de videos a partir de prompts textuales. Técnicamente, Gemini emplea técnicas de escalado de leyes (scaling laws), donde el rendimiento mejora predictiblemente con el aumento de parámetros y datos, siguiendo ecuaciones empíricas como log(precisión) ∝ log(parámetros).

De manera similar, Meta ha liberado modelos como Llama 2, un LLM de código abierto con 70 mil millones de parámetros, entrenado en datasets filtrados para minimizar sesgos. Estos modelos utilizan optimizadores como AdamW con tasas de aprendizaje adaptativas y regularización L2 para prevenir el sobreajuste. No obstante, las limitaciones persisten: los LLMs exhiben alucinaciones, donde generan información falsa con alta confianza, debido a la ausencia de un módulo de verificación factual integrado. Investigaciones en mitigación, como la integración de retrieval-augmented generation (RAG), combinan LLMs con bases de conocimiento externas para mejorar la precisión, pero incrementan la latencia en un 20-50% en entornos de producción.

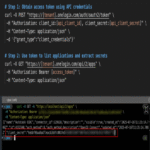

En el ámbito de la ciberseguridad, estos avances plantean riesgos operativos. La proliferación de IA generativa facilita ataques como el prompt injection, donde entradas maliciosas manipulan la salida del modelo, o la generación de deepfakes mediante GANs (Generative Adversarial Networks). Estándares como los propuestos por NIST en su marco de IA responsable enfatizan la necesidad de auditorías de sesgos y pruebas de robustez, pero la implementación es irregular. Por instancia, el entrenamiento de modelos en datos públicos expone vulnerabilidades a envenenamiento de datos, donde adversarios inyectan muestras maliciosas para alterar el comportamiento del modelo.

Estrategias Empresariales: De la AGI a la Monetización

Aunque las declaraciones públicas de ejecutivos como Sam Altman de OpenAI enfatizan la AGI como meta a corto plazo, los indicadores financieros revelan un enfoque en la economía de la atención. Esta economía, conceptualizada por Herbert Simon en 1971, postula que la atención es un recurso escaso en la era digital, monetizado mediante engagement prolongado. En IA, esto se traduce en interfaces conversacionales adictivas, como ChatGPT, que capturan horas de interacción diarias de usuarios, generando datos valiosos para refinamiento de modelos y publicidad dirigida.

Técnicamente, las plataformas de IA implementan métricas de engagement como el tiempo de sesión y la tasa de retención, optimizadas mediante algoritmos de recomendación basados en reinforcement learning. Por ejemplo, el sistema de OpenAI integra tracking de prompts y respuestas para iterar en el alineamiento del modelo, pero también para perfilar usuarios. Esto alinea con modelos de negocio similares a los de las redes sociales: Meta, con su modelo Llama, busca integrar IA en Facebook e Instagram para personalizar feeds, aumentando el tiempo de pantalla en un 15-20% según reportes internos.

Google, a través de Bard (ahora Gemini), compite incorporando IA en su ecosistema de búsqueda, donde el 10% de las consultas ya involucran generación de respuestas. Esto no solo retiene usuarios en el sitio, sino que reduce clics en enlaces externos, impactando la economía publicitaria. Desde una perspectiva regulatoria, iniciativas como el AI Act de la Unión Europea exigen transparencia en estos sistemas, clasificándolos como de alto riesgo si procesan datos personales a escala. Sin embargo, las empresas argumentan que las promesas de AGI justifican inversiones masivas, atrayendo capital de riesgo que superó los 50 mil millones de dólares en 2023 para el sector de IA.

En blockchain y tecnologías emergentes, algunas compañías exploran integraciones como NFTs generados por IA o smart contracts auditados por LLMs, pero estas aplicaciones secundarias sirven para diversificar la captación de atención en nichos como Web3. El riesgo operativo radica en la concentración de poder: un puñado de firmas controla los datasets y la infraestructura computacional, creando monopolios que limitan la innovación abierta.

La Economía de la Atención: Mecanismos Técnicos y Riesgos

La conquista de la economía de la atención en IA se sustenta en mecanismos técnicos diseñados para maximizar el engagement. Los LLMs emplean técnicas de generación autoregresiva, prediciendo el siguiente token con probabilidades condicionadas, lo que produce respuestas fluidas y conversacionales que fomentan interacciones prolongadas. Por ejemplo, el parámetro de temperatura en la decodificación (típicamente entre 0.7 y 1.0) ajusta la diversidad de outputs, equilibrando predictibilidad y novedad para mantener el interés del usuario.

En términos de datos, cada interacción genera vectores de embeddings de alta dimensionalidad (por ejemplo, 768 dimensiones en BERT-base), almacenados en bases vectoriales como FAISS para retrieval eficiente. Esto permite personalización en tiempo real, pero plantea preocupaciones de privacidad: el GDPR en Europa y la CCPA en California regulan el procesamiento de datos biométricos implícitos en prompts multimodales. Riesgos incluyen la amplificación de sesgos, donde modelos entrenados en datos sesgados perpetúan desigualdades, como en la generación de contenido discriminatorio detectado en pruebas de auditoría.

Desde la ciberseguridad, la economía de la atención incentiva vulnerabilidades. Ataques de denegación de servicio distribuidos (DDoS) contra APIs de IA, como los observados en incidentes con ChatGPT, buscan sobrecargar servidores con prompts masivos, costando miles de dólares por hora en cómputo. Además, la dependencia en la nube (AWS, Azure) expone a riesgos de brechas, donde datos de entrenamiento podrían filtrarse, violando estándares como ISO 27001 para gestión de seguridad de la información.

Beneficios operativos incluyen la democratización del conocimiento: herramientas como DALL-E de OpenAI permiten a profesionales en diseño generar assets rápidamente, reduciendo tiempos de producción en un 40%. En IT, la IA asiste en debugging de código mediante análisis semántico, integrándose con IDEs como VS Code. No obstante, la narrativa de AGI distrae de estas aplicaciones prácticas, priorizando hype sobre desarrollo responsable.

Implicaciones Operativas, Regulatorias y Éticas

Operativamente, las empresas enfrentan desafíos en la escalabilidad de infraestructuras. El entrenamiento de LLMs requiere clústeres de GPUs como NVIDIA A100, con costos que exceden los 100 millones de dólares por modelo. Estrategias de federated learning, donde el entrenamiento se distribuye en dispositivos edge sin centralizar datos, emergen como solución, alineadas con privacidad diferencial que añade ruido gaussiano a gradientes para preservar anonimato.

Regulatoriamente, marcos como el Blueprint for an AI Bill of Rights de la Casa Blanca en EE.UU. abogan por equidad y transparencia, exigiendo evaluaciones de impacto en privacidad. En Latinoamérica, países como Brasil con su LGPD y México avanzan en regulaciones similares, enfocándose en IA en sectores sensibles como salud y finanzas. Riesgos incluyen litigios por infracción de derechos de autor, como demandas contra Stability AI por uso de datasets como LAION-5B sin consentimiento.

Éticamente, la brecha entre promesas de AGI y realidades de atención plantea dilemas. La adicción a interfaces IA, similar a redes sociales, podría exacerbar problemas mentales, con estudios correlacionando uso excesivo con ansiedad. Mejores prácticas, como las del Partnership on AI, recomiendan auditorías independientes y diversidad en equipos de desarrollo para mitigar sesgos. En blockchain, integraciones como IA en oráculos de Chainlink podrían validar datos para AGI, pero requieren protocolos de consenso robustos para prevenir manipulaciones.

En noticias de IT, fusiones como la adquisición de Inflection AI por Microsoft por 650 millones de dólares ilustran cómo la competencia por talento y datos impulsa la consolidación, potencialmente reduciendo innovación. Tecnologías emergentes como quantum computing podrían acelerar el entrenamiento de AGI mediante algoritmos como QAOA (Quantum Approximate Optimization Algorithm), pero están en etapas tempranas, con qubits limitados a cientos en sistemas como IBM Eagle.

Conclusión: Hacia un Equilibrio entre Ambición y Realidad

En resumen, mientras las empresas de IA proyectan visiones utópicas de AGI para captar inversión y atención, sus avances concretos en modelos generativos sirven primordialmente para dominar la economía digital de la atención. Este enfoque genera beneficios en productividad y accesibilidad, pero conlleva riesgos significativos en ciberseguridad, privacidad y equidad. Para el sector profesional, es esencial priorizar desarrollos responsables, adhiriéndose a estándares técnicos y regulatorios que fomenten innovación sostenible. Finalmente, el verdadero progreso hacia la AGI dependerá no solo de potencia computacional, sino de marcos éticos que alineen la tecnología con el bien común, asegurando que la atención de los usuarios no sea el único premio en juego.

Para más información, visita la Fuente original.