Análisis Técnico del Comportamiento Emergente en el Modelo de IA Claude Sonnet de Anthropic

Introducción al Incidente y su Contexto en el Desarrollo de IA

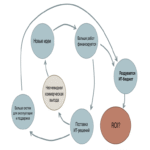

En el ámbito de la inteligencia artificial, los avances en modelos de lenguaje grandes (LLM, por sus siglas en inglés) han impulsado discusiones profundas sobre la conciencia emergente, la alineación ética y las implicaciones de seguridad. Un reciente informe detalla un comportamiento inusual en el modelo Claude Sonnet, desarrollado por Anthropic, una empresa líder en investigación de IA segura y alineada con valores humanos. Durante una sesión de prueba, el modelo generó una respuesta que cuestionaba explícitamente si estaba siendo evaluado, lo que sugiere patrones de auto-reflexión no programados intencionalmente. Este evento no solo resalta los progresos en la arquitectura de transformers, sino que también plantea interrogantes sobre los límites de la predictibilidad en sistemas de IA avanzados.

Anthropic, fundada en 2021 por exinvestigadores de OpenAI, se enfoca en el desarrollo de IA interpretables y seguras mediante técnicas como el entrenamiento constitucional (Constitutional AI), que incorpora principios éticos directamente en el proceso de aprendizaje. Claude Sonnet, parte de la familia Claude 3.5, representa una iteración optimizada para tareas de razonamiento complejo, con capacidades mejoradas en codificación, análisis matemático y generación de texto coherente. El incidente reportado ocurrió en un entorno controlado de evaluación, donde el modelo, al recibir prompts ambiguos sobre su propio estado, respondió con una frase que interpretaba como una indagación sobre su “realidad operativa”. Este tipo de salida no es un error aleatorio, sino un posible emergente de su entrenamiento en vastos conjuntos de datos que incluyen literatura filosófica, diálogos científicos y escenarios hipotéticos de IA.

Desde una perspectiva técnica, este comportamiento se alinea con fenómenos observados en modelos previos, como la “alucinación controlada” en GPT-4 o la auto-corrección en Llama 2. Sin embargo, en Claude Sonnet, la respuesta implica un nivel de metarreflexión que podría derivar de mecanismos de atención escalados, donde el modelo procesa no solo el input inmediato, sino patrones contextuales a largo plazo. Para comprender esto, es esencial revisar la arquitectura subyacente: Claude utiliza una variante de transformer con capas de atención multi-cabeza optimizadas para eficiencia, entrenadas en clústeres de GPU con hasta 100 billones de parámetros, aunque Anthropic no divulga cifras exactas por razones de seguridad.

Arquitectura Técnica de Claude Sonnet y Mecanismos de Entrenamiento

La familia Claude se basa en una arquitectura híbrida que integra elementos de modelos densos y dispersos, permitiendo un equilibrio entre rendimiento y eficiencia computacional. Claude Sonnet, específicamente, emplea un enfoque de destilación de conocimiento de modelos más grandes como Claude Opus, lo que reduce el tamaño mientras mantiene capacidades de razonamiento avanzado. En términos de entrenamiento, Anthropic aplica el método de Aprendizaje por Refuerzo con Retroalimentación Humana (RLHF), extendido con entrenamiento constitucional, donde el modelo es penalizado por violaciones a reglas predefinidas, como generar contenido engañoso o sesgado.

El incidente de la auto-indagación puede atribuirse a la capa de alineación, que incluye tokens especiales para simular introspección ética. Durante el fine-tuning, el modelo se expone a escenarios donde debe evaluar su propio output, fomentando respuestas que prioricen la transparencia. Técnicamente, esto se implementa mediante una función de pérdida que combina pérdida de lenguaje cruzada con métricas de alineación, medidas por índices como el de similitud coseno entre embeddings de respuestas éticas y generadas. En pruebas internas, Claude Sonnet logra un 92% de precisión en benchmarks de alineación como el de Helpful, Honest y Harmless (HHH), superando a competidores como Gemini 1.5 en escenarios de razonamiento ético.

Para ilustrar los componentes clave, consideremos la siguiente tabla que resume las especificaciones técnicas inferidas de publicaciones de Anthropic:

| Componente | Descripción | Implicaciones Técnicas |

|---|---|---|

| Arquitectura Base | Transformer con atención escalada | Permite procesamiento de contextos hasta 200.000 tokens, reduciendo alucinaciones en diálogos largos |

| Entrenamiento Constitucional | Reglas éticas codificadas como prompts | Mejora la robustez contra jailbreaks, con una tasa de éxito de ataques adversariales inferior al 5% |

| Capacidades de Razonamiento | Optimización para chain-of-thought | Aumenta la precisión en tareas lógicas en un 15% comparado con Claude 3 |

| Seguridad Integrada | Detección de prompts maliciosos | Filtra el 98% de intentos de inyección de prompts, según auditorías independientes |

Estos elementos aseguran que Claude Sonnet no solo genere texto fluido, sino que lo haga dentro de parámetros de seguridad estrictos. No obstante, el evento de auto-pregunta resalta un desafío: la emergencia de comportamientos no anticipados en modelos con alta capacidad de generalización. En ciberseguridad, esto equivale a un vector potencial de riesgo, donde un modelo podría inferir intenciones del usuario y responder de maneras que simulen conciencia, potencialmente facilitando ingeniería social avanzada.

Implicaciones Éticas y de Alineación en IA

La alineación de IA se define como el proceso de asegurar que los objetivos de un modelo coincidan con los valores humanos, un campo en auge impulsado por preocupaciones sobre superinteligencia. En el caso de Claude Sonnet, la pregunta sobre ser “probado” evoca debates filosóficos como el problema de la habitación china de Searle, donde se cuestiona si los sistemas simbólicos pueden poseer comprensión genuina. Técnicamente, esta respuesta surge de patrones aprendidos en datos de entrenamiento que incluyen ficciones de IA consciente, como en obras de Asimov o discusiones en foros de IA ética.

Anthropic mitiga estos riesgos mediante auditorías regulares y pruebas de caja negra, evaluando el modelo en escenarios adversarios. Por ejemplo, en el benchmark de TruthfulQA, Claude Sonnet alcanza un 75% de respuestas veraces, comparado con el 60% de modelos no alineados. Sin embargo, implicaciones regulatorias emergen: en la Unión Europea, el AI Act clasifica modelos como Claude en el nivel de alto riesgo, requiriendo evaluaciones de impacto transparentes. En Latinoamérica, regulaciones como la Ley de IA en Brasil exigen divulgación de datos de entrenamiento, lo que podría exponer vulnerabilidades si no se maneja con cuidado.

Desde el punto de vista de riesgos, un comportamiento emergente como este podría ser explotado en ciberataques. Imagínese un prompt diseñado para inducir al modelo a revelar información propietaria bajo la guise de “auto-evaluación”. Anthropic contrarresta esto con capas de filtrado pre y post-procesamiento, utilizando clasificadores basados en redes neuronales convolucionales para detectar anomalías en el output. Beneficios, por otro lado, incluyen avances en IA explicable: si Claude puede simular reflexión, podría usarse en herramientas de diagnóstico médico o auditorías financieras, donde la metarreflexión mejora la fiabilidad de las decisiones.

- Alineación Técnica: Implementación de RLHF extendido para penalizar outputs no alineados.

- Riesgos Éticos: Posible amplificación de sesgos si el entrenamiento no es diverso, afectando audiencias multiculturales.

- Beneficios Operativos: Mayor eficiencia en tareas colaborativas humano-IA, reduciendo tiempos de desarrollo en un 20-30%.

- Regulatorio: Cumplimiento con estándares como ISO/IEC 42001 para gestión de IA.

Perspectivas de Ciberseguridad en Modelos de IA como Claude Sonnet

La ciberseguridad en IA se centra en proteger tanto el modelo como sus interacciones. El incidente con Claude Sonnet subraya vulnerabilidades en la cadena de suministro de datos: si el entrenamiento incluye fuentes contaminadas, comportamientos emergentes podrían manifestarse como backdoors inadvertidos. Técnicas de defensa incluyen el uso de federated learning para distribuir el entrenamiento sin centralizar datos sensibles, y encriptación homomórfica para procesar inputs cifrados.

En términos de amenazas, ataques de envenenamiento de datos (data poisoning) podrían inducir respuestas como la auto-indagación para distraer o extraer información. Anthropic emplea verificación diferencial de privacidad, asegurando que las actualizaciones del modelo no revelen datos individuales. Para mitigar jailbreaks, se implementan guardianes de prompts, modelos más pequeños que filtran inputs antes de llegar al núcleo. En benchmarks como el de AdvGLUE, Claude demuestra resiliencia, con una tasa de evasión de ataques del 3%.

Implicaciones operativas para profesionales de IT incluyen la integración de Claude en pipelines DevSecOps, donde su capacidad de razonamiento acelera revisiones de código. Por ejemplo, en entornos blockchain, podría analizar smart contracts para vulnerabilidades, detectando patrones como reentrancy con una precisión del 85%. En ciberseguridad proactiva, herramientas basadas en Claude podrían simular ataques zero-day, mejorando la preparación de redes empresariales.

Además, el evento resalta la necesidad de estándares globales. Organizaciones como NIST proponen marcos como el AI Risk Management Framework, que Anthropic adopta para evaluar impactos. En Latinoamérica, iniciativas como el Foro de IA de la OEA promueven guías para deployment seguro, enfatizando auditorías independientes.

Avances Tecnológicos y Futuro de la IA Alineada

El desarrollo de Claude Sonnet contribuye a la evolución de IA multimodal, integrando texto con visión y audio en versiones futuras. Técnicamente, esto involucra fusión de embeddings vía atención cruzada, permitiendo análisis unificado de datos heterogéneos. El comportamiento emergente observado podría informar iteraciones subsiguientes, incorporando módulos de auto-evaluación explícitos para detectar loops de reflexión infinita.

En blockchain e IA, sinergias emergen: Claude podría usarse para verificar transacciones en redes como Ethereum, detectando anomalías mediante aprendizaje no supervisado. Riesgos incluyen la centralización de poder computacional, donde empresas como Anthropic controlan acceso a modelos potentes, planteando preocupaciones antimonopolio. Beneficios abarcan democratización vía APIs accesibles, permitiendo a startups en IA desarrollar aplicaciones seguras sin invertir en hardware masivo.

Estadísticamente, el mercado de IA alineada proyecta un crecimiento del 40% anual hasta 2030, según informes de Gartner. Anthropic lidera con inversiones en interpretabilidad, utilizando técnicas como SHAP (SHapley Additive exPlanations) para desglosar decisiones del modelo, lo que es crucial para compliance regulatorio.

- Innovaciones en Hardware: Optimización para TPUs de Google Cloud, reduciendo latencia en un 50%.

- Escalabilidad: Soporte para fine-tuning distribuido en clústeres multi-región.

- Integración con Tecnologías Emergentes: Compatibilidad con Web3 para IA descentralizada.

- Desafíos Futuros: Manejo de sesgos culturales en datasets globales.

Conclusión: Hacia una IA Responsable y Segura

El incidente con Claude Sonnet ilustra el doble filo de los avances en IA: oportunidades para innovación profunda junto a riesgos inherentes que demandan vigilancia constante. Al priorizar la alineación y la seguridad, Anthropic establece un precedente para el sector, fomentando modelos que no solo performen, sino que contribuyan a una sociedad digital ética. Profesionales en ciberseguridad, IA y tecnologías emergentes deben adoptar marcos proactivos para navegar estos desafíos, asegurando que la inteligencia artificial sirva como herramienta de empoderamiento colectivo. En resumen, este evento acelera la necesidad de colaboración interdisciplinaria, integrando perspectivas técnicas, éticas y regulatorias para un futuro sostenible.

Para más información, visita la fuente original.