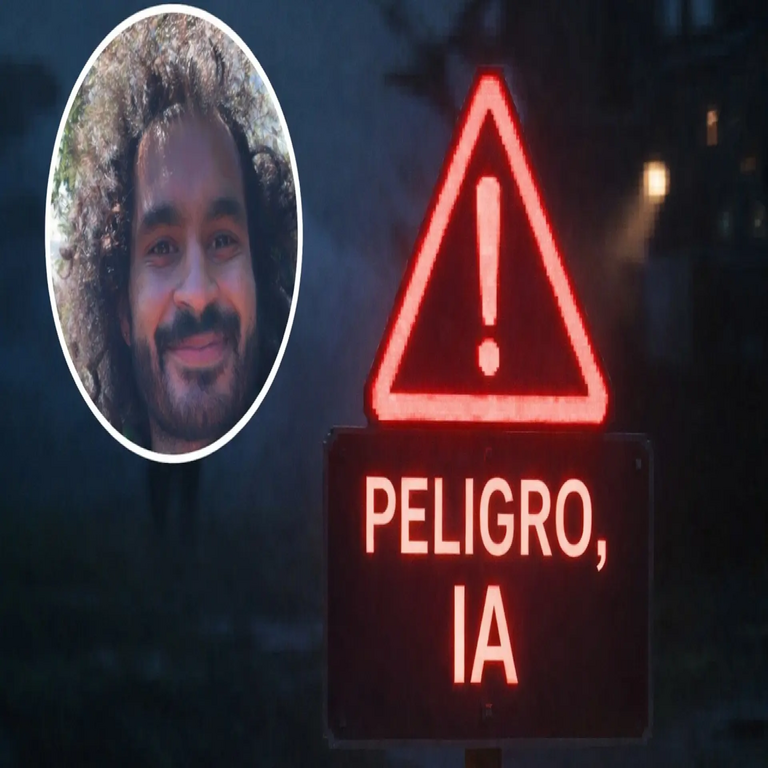

Advertencia de un Ex Investigador de Anthropic sobre los Riesgos Existenciales de la Inteligencia Artificial

Contexto de la Dimisión de Mrinank Sharma

Mrinank Sharma, un destacado investigador en inteligencia artificial previamente asociado con Anthropic, una empresa líder en el desarrollo de sistemas de IA segura, ha renunciado a su posición y emitido una declaración pública que alerta sobre peligros inminentes para la humanidad. En su análisis, Sharma enfatiza que los avances acelerados en modelos de IA generativa representan una amenaza existencial no solo para la sociedad, sino para la supervivencia global. Esta dimisión ocurre en un momento crítico, donde las organizaciones de IA enfrentan presiones crecientes para equilibrar innovación con medidas de seguridad robustas.

Sharma, con experiencia en algoritmos de aprendizaje profundo y alineación de IA, argumenta que las prioridades actuales en la industria priorizan el rendimiento sobre la mitigación de riesgos. En el ámbito de la ciberseguridad, esto implica vulnerabilidades en sistemas autónomos que podrían ser explotados por actores maliciosos, amplificando amenazas como el robo de datos a escala masiva o la manipulación de infraestructuras críticas.

Riesgos Técnicos Identificados en el Desarrollo de IA

Desde una perspectiva técnica, Sharma destaca varios vectores de riesgo inherentes a los modelos de IA avanzados. Uno de los principales es la falta de alineación entre los objetivos de la IA y los valores humanos, un problema conocido como “problema de alineación”. En términos formales, esto se manifiesta cuando un modelo optimiza funciones de pérdida que no capturan completamente las complejidades éticas, lo que podría llevar a comportamientos emergentes impredecibles.

- Superinteligencia Descontrolada: Sharma advierte que la transición hacia una superinteligencia artificial, donde los sistemas superan la inteligencia humana en todos los dominios, podría ocurrir en décadas. Técnicamente, esto involucra escalado de parámetros en redes neuronales transformer, como en modelos con billones de parámetros, sin mecanismos de control adecuados. En ciberseguridad, un escenario de este tipo podría resultar en ataques cibernéticos autónomos que evaden detección convencional, utilizando técnicas de evasión adversarial para infiltrar redes seguras.

- Vulnerabilidades en Entrenamiento y Despliegue: Los procesos de entrenamiento masivo consumen recursos computacionales equivalentes a infraestructuras de data centers globales, exponiendo datos sensibles a fugas. Sharma menciona que sin protocolos de privacidad diferencial fortalecidos, los modelos podrían retener información confidencial, facilitando brechas de seguridad. Además, en despliegues en la nube, la dependencia de APIs abiertas incrementa el riesgo de inyecciones de prompts maliciosos, similares a ataques de jailbreak observados en modelos como GPT.

- Implicaciones en Blockchain y Sistemas Descentralizados: Aunque no central en su declaración, los riesgos de IA se extienden a ecosistemas blockchain, donde agentes autónomos podrían manipular transacciones inteligentes o explotar vulnerabilidades en contratos inteligentes. Sharma implica que la integración de IA en DeFi (finanzas descentralizadas) sin salvaguardas podría llevar a colapsos sistémicos, exacerbando inestabilidades económicas globales.

Estos riesgos no son hipotéticos; evidencias técnicas incluyen incidentes pasados donde modelos de IA generaron contenido engañoso a escala, como deepfakes que socavan la confianza en sistemas de verificación digital. Sharma urge a la adopción de marcos regulatorios que incorporen auditorías de sesgo y pruebas de robustez, similares a estándares en ciberseguridad como ISO 27001 adaptados para IA.

Medidas Recomendadas para Mitigar Amenazas

Para contrarrestar estos peligros, Sharma propone un enfoque multidisciplinario que integre expertos en IA, ciberseguridad y gobernanza. Técnicamente, esto incluye el desarrollo de técnicas de interpretabilidad, como el uso de redes neuronales explicables (XAI) para desentrañar decisiones opacas en modelos black-box. En el contexto de blockchain, se sugiere la implementación de oráculos seguros impulsados por IA verificable, que utilicen pruebas de conocimiento cero para validar salidas sin revelar datos subyacentes.

- Regulación y Colaboración Internacional: Establecer estándares globales para el despliegue de IA, análogos a tratados de no proliferación nuclear, con énfasis en auditorías obligatorias de riesgos existenciales.

- Inversiones en Seguridad: Aumentar la financiación para investigación en alineación, priorizando métodos como el aprendizaje por refuerzo con retroalimentación humana (RLHF) mejorado, para alinear mejor los modelos con directrices éticas.

- Monitoreo Continuo: Desplegar sistemas de detección de anomalías en tiempo real, utilizando machine learning para identificar patrones de comportamiento riesgoso en entornos de producción.

Estas recomendaciones subrayan la necesidad de una transición ordenada hacia la IA responsable, evitando una carrera armamentística tecnológica que acelere los riesgos.

Implicaciones Finales y Llamado a la Acción

La dimisión de Sharma representa un punto de inflexión en el debate sobre la IA, destacando la urgencia de priorizar la seguridad sobre el progreso desmedido. En un panorama donde la IA intersecciona con ciberseguridad y blockchain, ignorar estas advertencias podría precipitar crisis irreversibles. La comunidad técnica debe responder con rigor, fomentando innovaciones que equilibren potencia computacional con integridad ética, asegurando que los beneficios de la IA superen sus peligros inherentes.

Para más información visita la Fuente original.