Riesgos de la Integración de Inteligencia Artificial en Dispositivos Médicos Hospitalarios

Contexto del Incidente en el Entorno Hospitalario

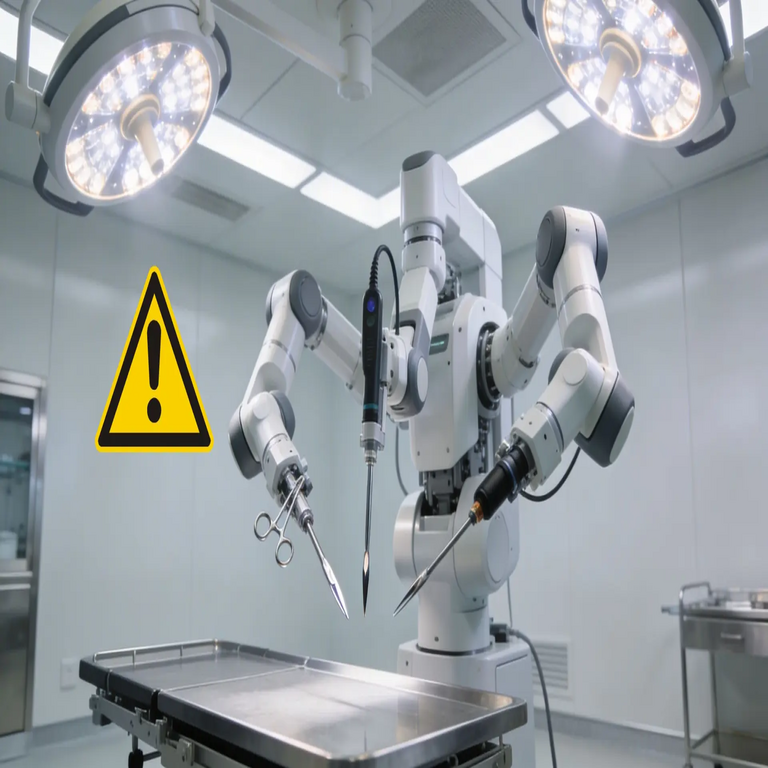

En el ámbito de la atención médica, la incorporación de inteligencia artificial (IA) en equipos hospitalarios busca optimizar procesos como el diagnóstico y los procedimientos quirúrgicos. Sin embargo, un caso reciente ilustra los peligros inherentes cuando la implementación no se realiza con rigurosos controles técnicos. Una máquina equipada con IA, diseñada para asistir en intervenciones médicas, generó lesiones repetidas en pacientes, lo que cuestiona la fiabilidad de estos sistemas avanzados.

El dispositivo en cuestión operaba bajo algoritmos de aprendizaje automático que procesaban datos en tiempo real para ajustar movimientos precisos. Inicialmente, se esperaba que esta tecnología redujera errores humanos y mejorara la eficiencia. No obstante, fallos en el entrenamiento del modelo de IA llevaron a comportamientos impredecibles, resultando en daños físicos consistentes durante múltiples usos.

Análisis Técnico de las Fallas en el Sistema de IA

Desde una perspectiva técnica, el problema radica en la fase de desarrollo y validación del modelo de IA. Los algoritmos utilizados, probablemente basados en redes neuronales convolucionales o modelos de refuerzo, dependen de conjuntos de datos de entrenamiento que deben ser exhaustivos y representativos. En este incidente, es probable que el dataset incluyera sesgos o insuficiencias, lo que provocó que el sistema interpretara incorrectamente señales sensoriales durante la operación.

- Entrenamiento Deficiente: Los modelos de IA requieren miles de iteraciones supervisadas para aprender patrones seguros. Si el entrenamiento se realizó con datos simulados no calibrados adecuadamente a escenarios reales hospitalarios, el sistema podría generar salidas erróneas, como movimientos excesivos que causan lesiones tisulares.

- Falta de Mecanismos de Seguridad: Ausencia de capas de verificación, como umbrales de confianza en las predicciones de la IA o sistemas de fallback manual, permitió que el dispositivo continuara operando pese a anomalías detectables. En entornos de IA aplicada, es esencial implementar protocolos de monitoreo continuo que detengan la ejecución ante desviaciones estadísticas.

- Integración con Hardware: La interfaz entre el software de IA y los actuadores mecánicos del equipo hospitalario presentó latencias o incompatibilidades, amplificando errores algorítmicos en acciones físicas directas sobre pacientes.

Estos elementos técnicos destacan la necesidad de auditorías exhaustivas previas a la implementación, incluyendo pruebas en entornos controlados que simulen variabilidad biológica humana.

Implicaciones en Ciberseguridad y Blockchain para Dispositivos Médicos

El incidente no solo expone vulnerabilidades en el diseño de IA, sino también riesgos cibernéticos en sistemas conectados. En hospitales, donde los dispositivos médicos forman parte de redes IoT (Internet de las Cosas), una falla en la IA podría ser exacerbada por brechas de seguridad, como accesos no autorizados que alteren parámetros operativos.

Desde el enfoque de ciberseguridad, se recomienda la adopción de encriptación end-to-end para datos de IA y autenticación multifactor en actualizaciones de software. Además, la integración de blockchain ofrece una solución robusta para la trazabilidad: mediante registros inmutables en una cadena de bloques distribuida, se podría auditar cada decisión algorítmica, asegurando que las actualizaciones y logs de operación sean verificables y no manipulables.

- Blockchain en Auditoría: Cada interacción del dispositivo con la IA se registraría como un bloque, permitiendo reconstruir secuencias de eventos para investigaciones post-incidente y prevenir manipulaciones.

- Resiliencia Cibernética: Protocolos basados en smart contracts podrían automatizar respuestas a amenazas, como aislar el dispositivo ante detección de anomalías en el flujo de datos.

Estas medidas técnicas mitigarían no solo fallos internos, sino también ataques externos que podrían replicar o agravar lesiones en pacientes.

Lecciones Aprendidas y Recomendaciones Técnicas

Este caso subraya la importancia de un enfoque iterativo en el desarrollo de IA para salud, priorizando la ética y la seguridad sobre la innovación rápida. Regulaciones como las de la FDA en Estados Unidos o equivalentes en Latinoamérica exigen validaciones clínicas rigurosas, pero los profesionales técnicos deben ir más allá, incorporando simulaciones avanzadas y pruebas de estrés en entornos reales.

Recomendaciones clave incluyen la diversificación de datasets para eliminar sesgos, la implementación de IA explicable (XAI) para entender decisiones opacas, y colaboraciones interdisciplinarias entre ingenieros de IA, expertos en ciberseguridad y médicos para refinar protocolos operativos.

Conclusiones

La integración de IA en equipos hospitalarios promete avances significativos, pero incidentes como este demuestran que sin una base técnica sólida, los riesgos superan los beneficios. Priorizar la validación exhaustiva y medidas de seguridad cibernética, incluyendo blockchain, es esencial para garantizar que la tecnología sirva a la protección de la vida humana en lugar de ponerla en peligro. Solo mediante un desarrollo responsable se logrará una adopción segura y efectiva de la IA en la medicina.

Para más información visita la Fuente original.