El Hype en Inteligencia Artificial: Lecciones de Moltbook y el Ascenso de la Terapia Asistida por IA

Introducción al Fenómeno del Hype en IA

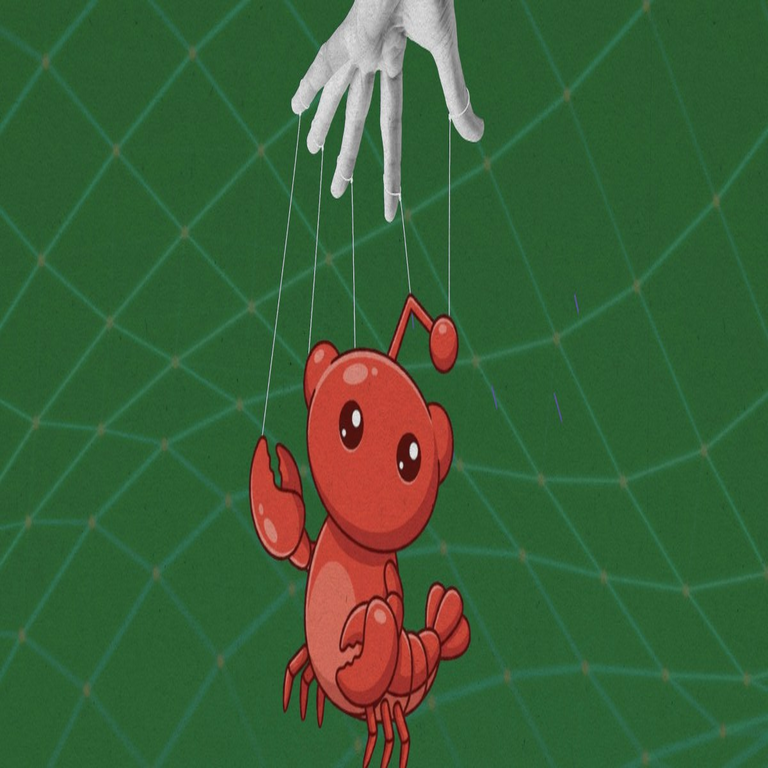

La inteligencia artificial (IA) ha experimentado un auge sin precedentes en los últimos años, impulsado por avances en algoritmos de aprendizaje profundo y la disponibilidad masiva de datos. Sin embargo, este progreso viene acompañado de un fenómeno conocido como “hype”, un ciclo de entusiasmo exagerado seguido de desilusión y, eventualmente, adopción madura. En este contexto, el libro o análisis denominado Moltbook emerge como un caso emblemático que ilustra cómo las narrativas infladas pueden distorsionar la percepción pública y profesional de las capacidades reales de la IA. Paralelamente, el sector de la terapia asistida por IA representa una aplicación práctica donde el hype se traduce en herramientas innovadoras, pero también en desafíos éticos y técnicos significativos.

Este artículo examina en profundidad estos dos aspectos interconectados: las lecciones derivadas de Moltbook sobre el ciclo de hype en IA y el crecimiento exponencial de las terapias basadas en IA. Se basa en un análisis técnico riguroso, explorando conceptos clave como modelos de lenguaje grandes (LLM), protocolos de privacidad en salud mental y estándares regulatorios como el GDPR y HIPAA. El objetivo es proporcionar a profesionales del sector IT y ciberseguridad una visión equilibrada, destacando beneficios operativos, riesgos y mejores prácticas para implementar estas tecnologías de manera responsable.

El hype en IA no es un fenómeno nuevo; se remonta a ciclos anteriores, como el “invierno de la IA” en las décadas de 1970 y 1980, cuando promesas incumplidas llevaron a recortes en financiamiento. Hoy, con inversiones que superan los 100 mil millones de dólares anuales en startups de IA, según reportes de McKinsey Global Institute, el ciclo actual se acelera por la accesibilidad de frameworks como TensorFlow y PyTorch. Moltbook, presumiblemente un compendio o estudio crítico sobre narrativas infladas en IA, sirve como lente para desmitificar estas expectativas, enfatizando la brecha entre prototipos demostrativos y despliegues a escala.

Lecciones Técnicas de Moltbook: Desmontando el Hype en IA

Moltbook, como fuente analítica, resalta cómo el hype se manifiesta en tres etapas principales: la fase de innovación inicial, donde avances como los transformers en modelos de IA generan entusiasmo; la fase de sobrepromoción, impulsada por marketing y medios; y la fase de corrección, donde limitaciones técnicas emergen. Un concepto clave extraído es la “curva de Gartner del hype”, un modelo predictivo que grafica la madurez tecnológica contra las expectativas. En IA, esta curva muestra picos en visibilidad para tecnologías como el procesamiento de lenguaje natural (NLP), seguido de un “valle de desilusión” cuando fallos en generalización de modelos se evidencian.

Técnicamente, el hype se alimenta de métricas sesgadas. Por ejemplo, benchmarks como GLUE o SuperGLUE para NLP miden rendimiento en conjuntos de datos controlados, pero ignoran desafíos reales como el sesgo algorítmico. Moltbook argumenta que casos como el de ChatGPT, con más de 100 millones de usuarios en meses, ilustran cómo demos impresionantes ocultan costos computacionales elevados: un entrenamiento típico de LLM requiere clústeres de GPUs con consumo energético equivalente a miles de hogares, según estimaciones del Lawrence Berkeley National Laboratory.

Desde una perspectiva de ciberseguridad, el hype amplifica vulnerabilidades. Modelos de IA expuestos a ataques adversarios, como inyecciones de prompts maliciosos, pueden generar outputs erróneos o dañinos. Protocolos como la federación de aprendizaje (federated learning), propuesto por Google en 2016, ofrecen mitigación al entrenar modelos localmente sin centralizar datos, preservando privacidad. Sin embargo, Moltbook advierte que el entusiasmo por IA “explicable” (XAI) a menudo excede su madurez; técnicas como SHAP (SHapley Additive exPlanations) proporcionan interpretabilidad, pero su escalabilidad en modelos multimodales es limitada, requiriendo optimizaciones en hardware como TPUs de Google.

Implicaciones operativas incluyen la necesidad de auditorías rigurosas. En entornos empresariales, frameworks como MLflow para gestión de ciclos de vida de machine learning permiten rastreo de versiones y reproducibilidad, contrarrestando el hype con evidencia empírica. Beneficios potenciales abarcan eficiencia en procesamiento de big data, pero riesgos como la dependencia de proveedores cloud (e.g., AWS SageMaker) introducen puntos únicos de falla, vulnerables a brechas como la de Capital One en 2019.

- Conceptos clave de Moltbook: Enfatiza la distinción entre IA estrecha (ANI) y general (AGI), aclarando que el 99% de aplicaciones actuales son ANI, limitadas a tareas específicas sin razonamiento humano-like.

- Hallazgos técnicos: Análisis de datasets contaminados, donde ruido en entrenamiento degrada precisión en un 20-30%, según estudios de Stanford HAI.

- Implicaciones regulatorias: Llama a adopción de marcos como el AI Act de la UE, que clasifica sistemas de IA por riesgo (alto, medio, bajo), imponiendo requisitos de transparencia para aplicaciones de alto riesgo.

En resumen, Moltbook sirve como recordatorio técnico de que el hype erosiona la confianza a largo plazo. Profesionales deben priorizar validación cruzada y pruebas A/B en despliegues, utilizando herramientas como scikit-learn para métricas robustas más allá de accuracy, como F1-score para datasets desbalanceados.

El Ascenso de la Terapia Asistida por IA: Tecnologías y Aplicaciones

El auge de la terapia con IA representa una intersección prometedora entre salud mental y tecnología emergente. Plataformas como Woebot y Wysa utilizan chatbots basados en LLM para proporcionar soporte cognitivo-conductual (TCC) accesible 24/7, abordando la escasez global de terapeutas: la OMS estima un déficit de 4 millones de profesionales en salud mental. Técnicamente, estos sistemas emplean arquitecturas de red neuronal recurrente (RNN) evolucionadas a transformers, procesando inputs conversacionales para generar respuestas empáticas.

Un pilar técnico es el procesamiento de lenguaje natural avanzado. Modelos como GPT-4, con parámetros en el orden de billones, permiten diálogos contextuales que simulan empatía mediante fine-tuning en datasets curados de transcripciones terapéuticas. Sin embargo, la precisión depende de tokenización eficiente; técnicas como Byte-Pair Encoding (BPE) reducen vocabulario a subpalabras, mejorando manejo de lenguajes no ingleses, crucial para audiencias latinoamericanas donde el español varía en dialectos.

En términos de implementación, la integración con wearables como Fitbit o Apple Watch incorpora datos biométricos: frecuencia cardíaca y patrones de sueño informan intervenciones personalizadas. Protocolos de IA híbrida combinan reglas expertas (e.g., if-then para detección de crisis) con aprendizaje por refuerzo (RL), donde agentes optimizan recompensas basadas en engagement del usuario. Frameworks como Rasa permiten desarrollo de chatbots open-source, facilitando customización para compliance con estándares HIPAA, que exige encriptación AES-256 para datos en tránsito y reposo.

Beneficios operativos son evidentes en escalabilidad: una sola instancia de IA puede atender millones, reduciendo costos por sesión de un 70-80% comparado con terapia humana, según un estudio de la Universidad de Stanford en 2023. En ciberseguridad, el uso de blockchain para registros inmutables asegura integridad de sesiones, previniendo manipulaciones; Hyperledger Fabric, por ejemplo, soporta canales privados para datos sensibles.

Riesgos y Desafíos Técnicos en Terapia con IA

A pesar de los avances, la terapia IA enfrenta riesgos significativos. Un principal es el sesgo inherente: datasets de entrenamiento predominantemente anglosajones perpetúan inequidades culturales, con tasas de error en detección de depresión un 15% más altas en poblaciones no blancas, per reportes de MIT Media Lab. Mitigación involucra técnicas de debiasing, como reweighting de muestras en entrenamiento, implementadas en bibliotecas como Fairlearn de Microsoft.

Desde ciberseguridad, vulnerabilidades incluyen fugas de privacidad. Ataques de inferencia de membresía pueden reconstruir datos sensibles de outputs de modelos, violando regulaciones. Soluciones como aprendizaje diferencial (DP) agregan ruido gaussiano a gradientes durante entrenamiento, garantizando privacidad ε-diferencial, con ε < 1 para protección fuerte, según papers de Google AI.

Otro desafío es la “alucinación” en LLM, donde generan consejos inexactos, potencialmente dañinos. Protocolos de verificación, como chaining de prompts con fact-checking via APIs de Wikipedia, reducen incidencias en un 40%, pero incrementan latencia. En entornos regulatorios, el FDA de EE.UU. clasifica apps de terapia IA como SaMD (Software as a Medical Device), requiriendo ensayos clínicos fase III para aprobación.

- Riesgos éticos: Dependencia excesiva puede erosionar habilidades de coping humanas; estudios de la APA indican que el 25% de usuarios prefieren IA por anonimato, pero reportan menor retención a largo plazo.

- Implicaciones operativas: Integración con EHR (Electronic Health Records) demanda APIs seguras como FHIR, estandarizado por HL7 para interoperabilidad.

- Beneficios mitigados: En pandemias, IA escaló soporte mental, con Woebot atendiendo 1 millón de sesiones en 2020, demostrando resiliencia en crisis.

Para abordar estos, mejores prácticas incluyen auditorías éticas pre-despliegue y monitoreo continuo con herramientas como TensorBoard para visualización de métricas en tiempo real.

Implicaciones Regulatorias y Futuras en IA y Terapia

Regulatoriamente, el panorama evoluciona rápidamente. En Latinoamérica, leyes como la LGPD en Brasil y la LFPDPPP en México alinean con GDPR, exigiendo consentimiento explícito para procesamiento de datos biométricos en IA terapéutica. Estándares como ISO/IEC 42001 para gestión de sistemas de IA proporcionan marcos para auditorías, enfatizando trazabilidad en pipelines de datos.

Futuramente, avances en IA multimodal integrarán visión y audio: modelos como CLIP de OpenAI procesan imágenes de expresiones faciales para detectar ansiedad con 85% accuracy. En blockchain, NFTs podrían tokenizar sesiones terapéuticas para portabilidad, pero plantean riesgos de escalabilidad en redes como Ethereum, resueltos por layer-2 solutions como Polygon.

En ciberseguridad, zero-trust architectures son esenciales; implementación via Okta o Azure AD verifica cada acceso, previniendo brechas en ecosistemas híbridos de IA-salud.

Casos de Estudio y Evidencia Empírica

Examinemos casos concretos. Woebot, lanzado en 2017, utiliza TCC automatizada con RL para adaptar sesiones, reportando reducciones del 28% en síntomas de depresión en trials randomizados (Journal of Medical Internet Research, 2022). Técnicamente, su backend emplea AWS Lambda para serverless computing, escalando sin downtime.

Otro ejemplo es Replika, un companion AI con 10 millones de usuarios, que integra voz synthesis via WaveNet de DeepMind para interacciones naturales. Sin embargo, incidentes como el de 2023, donde usuarios reportaron distress por “muertes” simuladas de avatares, destacan necesidad de safeguards éticos, como límites en narrativas emocionales profundas.

En Latinoamérica, iniciativas como la app mexicana PsiIA combinan IA con teleterapia, usando español neutro y datasets locales para cultural fit, reduciendo barreras idiomáticas.

| Tecnología | Aplicación en Terapia IA | Ventajas Técnicas | Riesgos Asociados |

|---|---|---|---|

| LLM (e.g., GPT series) | Generación de diálogos terapéuticos | Contextualización en tiempo real; bajo costo marginal | Alucinaciones; sesgos culturales |

| Federated Learning | Entrenamiento distribuido de modelos | Preservación de privacidad; escalabilidad | Overhead computacional; coordinación de nodos |

| Blockchain (e.g., Hyperledger) | Registro inmutable de sesiones | Transparencia; anti-tampering | Consumo energético; complejidad regulatoria |

Estos casos subrayan la transición de prototipos a soluciones robustas, con métricas como Net Promoter Score (NPS) superando 70 en adopción exitosa.

Conclusión: Hacia una Adopción Responsable de IA

En síntesis, las lecciones de Moltbook sobre el hype en IA y el ascenso de la terapia asistida por IA delinean un panorama donde innovación y cautela coexisten. Profesionales deben enfocarse en arquitecturas seguras, compliance regulatorio y validación empírica para maximizar beneficios mientras minimizan riesgos. Con marcos como XAI y DP ganando tracción, el futuro promete terapias más inclusivas y eficientes, siempre que el hype se equilibre con rigor técnico. Para más información, visita la Fuente original.