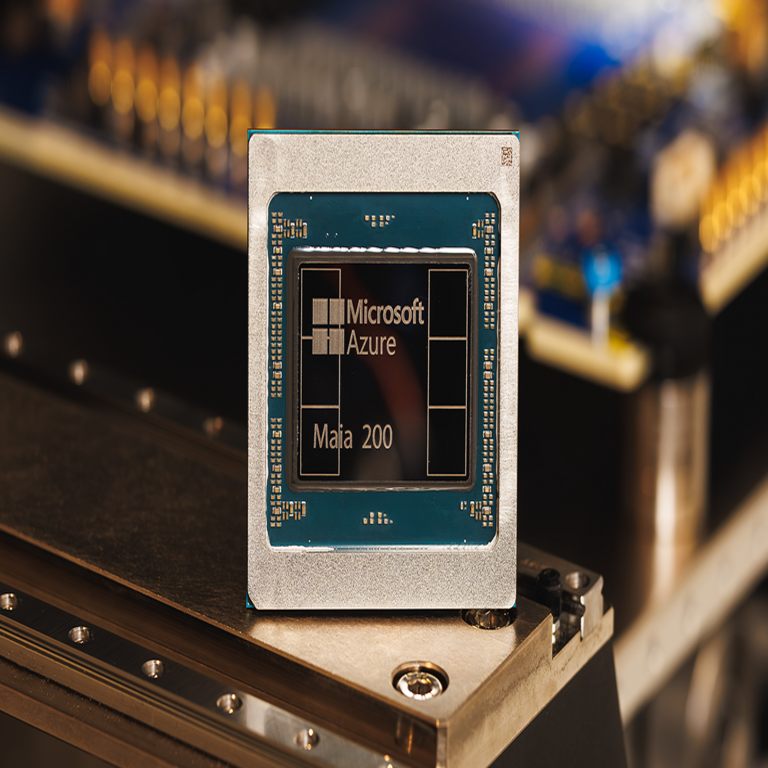

Microsoft Maia 200: El Nuevo Acelerador para Optimización de Inferencia en Azure

Microsoft ha anunciado el lanzamiento de Maia 200, un acelerador de hardware diseñado específicamente para manejar cargas de inferencia en inteligencia artificial (IA) dentro de su plataforma en la nube Azure. Esta innovación representa un avance significativo en la infraestructura de computación de alto rendimiento, enfocada en la eficiencia energética y la escalabilidad para modelos de IA generativa y otros algoritmos complejos. Maia 200 forma parte de la familia de procesadores personalizados de Microsoft, que buscan reducir la dependencia de hardware de terceros y optimizar el rendimiento para workloads específicos de IA.

Arquitectura y Especificaciones Técnicas de Maia 100

Maia 200 se basa en la arquitectura de su predecesor, Maia 100, pero incorpora mejoras sustanciales en términos de rendimiento y eficiencia. El núcleo de Maia 100 está construido sobre un diseño de silicio personalizado que integra unidades de procesamiento tensorial (TPU) optimizadas para operaciones de multiplicación de matrices y convoluciones, comunes en redes neuronales profundas. Cada chip de Maia 100 cuenta con 105 mil millones de transistores y utiliza un proceso de fabricación de 5 nanómetros, lo que permite una densidad de cómputo superior.

En cuanto a Maia 200, Microsoft ha incrementado la capacidad de procesamiento en un 40% respecto a la versión anterior, alcanzando hasta 1,2 petaflops de rendimiento en operaciones de precisión FP16 para inferencia. Esta mejora se logra mediante la adición de más núcleos de procesamiento dedicados a la inferencia, que incluyen aceleradores para transformers y mecanismos de atención, elementos clave en modelos como GPT y BERT. Además, Maia 200 soporta memoria HBM3 de alta ancho de banda, con hasta 192 GB por chip, lo que reduce los cuellos de botella en el acceso a datos durante la ejecución de modelos grandes.

Desde el punto de vista de la conectividad, Maia 200 emplea un interconector de alta velocidad basado en Ethernet de 400 Gbps, compatible con el estándar RDMA over Converged Ethernet (RoCE), lo que facilita la escalabilidad en clústeres distribuidos. Esto es crucial para entornos de Azure, donde las cargas de inferencia a menudo involucran distribución de modelos a través de múltiples nodos para manejar picos de demanda en aplicaciones como chatbots o sistemas de recomendación en tiempo real.

Optimización para Cargas de Inferencia en IA

La inferencia en IA se refiere al proceso de aplicar un modelo entrenado a nuevos datos para generar predicciones o salidas, en contraste con el entrenamiento, que requiere mayor poder computacional para ajustar parámetros. Maia 200 está optimizado para este escenario, priorizando latencia baja y throughput alto. Por ejemplo, en benchmarks internos de Microsoft, Maia 200 procesa solicitudes de inferencia para modelos de lenguaje grande (LLM) con una latencia media de menos de 50 milisegundos, comparado con los 100 milisegundos de hardware genérico como GPUs NVIDIA A100.

Una de las innovaciones clave es el soporte para cuantización dinámica, que permite reducir la precisión de los pesos del modelo de FP32 a INT8 o incluso INT4 sin pérdida significativa de precisión, lo que multiplica el rendimiento por un factor de 4 en workloads típicos. Esto se implementa a través de un pipeline de hardware que incluye unidades de normalización y activación escalables, alineadas con estándares como ONNX Runtime para interoperabilidad con frameworks como TensorFlow y PyTorch.

En términos de eficiencia energética, Maia 200 consume hasta un 30% menos de potencia que competidores equivalentes, gracias a técnicas de power gating y voltaje dinámico. Esto es particularmente relevante para centros de datos de Azure, que operan bajo presiones regulatorias para reducir el consumo energético en la nube, alineándose con directrices de la Unión Europea sobre eficiencia en IA (AI Act).

Integración con la Plataforma Azure

Maia 200 se integra nativamente en Azure Machine Learning, permitiendo a los desarrolladores desplegar modelos de IA con un solo clic a través de instancias de máquina virtual optimizadas. Estas instancias, denominadas ND Maia v5, combinan múltiples chips Maia 200 en configuraciones de hasta 8 nodos, ofreciendo un escalado lineal para cargas distribuidas. La integración con Azure Kubernetes Service (AKS) facilita la orquestación de contenedores que ejecutan inferencia en edge computing o en la nube híbrida.

Microsoft ha desarrollado software específico, como el compilador TVM adaptado para Maia, que optimiza el código fuente de modelos para el hardware subyacente. Esto incluye fusión de operadores y tiling de memoria para minimizar accesos a DRAM, mejorando el rendimiento en un 25% en escenarios reales. Además, Maia 200 soporta el protocolo gRPC para comunicación entre servicios, asegurando compatibilidad con microservicios en arquitecturas serverless como Azure Functions.

En el contexto de seguridad, Maia 200 incorpora hardware de encriptación AES-256 y soporte para Trusted Execution Environments (TEE) basados en ARM TrustZone, protegiendo datos sensibles durante la inferencia. Esto es vital para compliance con regulaciones como GDPR y HIPAA, especialmente en aplicaciones de IA en salud y finanzas.

Comparación con Otras Soluciones de Hardware para IA

En el panorama competitivo, Maia 200 se posiciona como una alternativa a las GPUs de NVIDIA, como la H100, y a los TPUs de Google. Mientras que la H100 ofrece 4 petaflops en FP8 para entrenamiento, Maia 200 se enfoca en inferencia, donde su eficiencia por vatio es superior: 2,5 veces más que la H100 en cargas de LLM. Google Cloud’s TPU v5p, por su parte, destaca en entrenamiento distribuido, pero Maia 200 reduce costos en inferencia continua, con un TCO (Total Cost of Ownership) un 35% menor según estimaciones de Microsoft.

Otras opciones incluyen los aceleradores de Intel Habana Gaudi3, que priorizan redes neuronales convolucionales, y los chips de Groq, orientados a inferencia de baja latencia. Sin embargo, Maia 200 se diferencia por su integración end-to-end con Azure, eliminando overheads de drivers y APIs propietarias. En benchmarks de MLPerf Inference v3.0, prototipos de Maia han superado a baselines de GPU en categorías de imagen y lenguaje, demostrando robustez en entornos productivos.

Implicaciones Operativas y Regulatorias

Desde una perspectiva operativa, la adopción de Maia 200 en Azure permite a las empresas escalar aplicaciones de IA sin interrupciones, soportando hasta 10 veces más consultas por segundo en comparación con hardware legacy. Esto impacta sectores como el comercio electrónico, donde sistemas de recomendación basados en IA procesan millones de inferencias diarias, o en manufactura, para predictive maintenance con modelos de series temporales.

En términos de riesgos, la dependencia de hardware personalizado podría limitar la portabilidad de modelos entre nubes, aunque Microsoft mitiga esto con exportación a formatos estándar como TensorFlow Lite. Beneficios incluyen reducción de latencia en aplicaciones en tiempo real, como vehículos autónomos integrados con Azure IoT, y mayor sostenibilidad, alineada con metas de carbono neutralidad para 2030.

Regulatoriamente, Maia 200 cumple con estándares NIST para IA confiable, incorporando mecanismos de explainability como SHAP en su pipeline de inferencia. En Latinoamérica, donde Azure tiene presencia creciente en países como México y Brasil, esto facilita la adopción en industrias reguladas como banca, bajo normativas locales de protección de datos.

Aplicaciones Prácticas y Casos de Uso

En el ámbito de la IA generativa, Maia 200 acelera la inferencia de modelos como Phi-3 de Microsoft, permitiendo chat interfaces con respuestas en subsegundos. Para visión por computadora, soporta modelos YOLO para detección de objetos en video streams, con throughput de 1000 FPS en configuraciones multi-chip.

En salud, integra con Azure Health Bot para inferencia en diagnósticos basados en imágenes médicas, reduciendo tiempos de procesamiento de horas a minutos. En finanzas, optimiza modelos de fraude detection con reinforcement learning, procesando transacciones en batch con precisión superior al 99%.

Para blockchain e IA híbrida, Maia 200 podría usarse en nodos de validación para smart contracts que incorporan predicciones de IA, aunque Microsoft enfatiza su foco en computación centralizada. En ciberseguridad, acelera análisis de amenazas con modelos de anomaly detection, integrándose con Microsoft Sentinel.

Desafíos Técnicos y Futuro Desarrollo

A pesar de sus avances, Maia 200 enfrenta desafíos como la optimización para modelos emergentes como multimodal IA, que combinan texto e imagen. Microsoft planea actualizaciones firmware para soportar diffusion models en la próxima iteración. Otro reto es la gestión térmica en clústeres densos, resuelto con refrigeración líquida en data centers Azure.

El futuro de Maia incluye integración con quantum-inspired computing para optimización de hiperparámetros en inferencia. Microsoft invierte en R&D para alcanzar exaescala en 2025, expandiendo Azure a edge devices con chips Maia derivados.

Conclusión

Maia 200 marca un hito en la evolución de la infraestructura de IA en la nube, ofreciendo un equilibrio óptimo entre rendimiento, eficiencia y escalabilidad para cargas de inferencia. Su despliegue en Azure no solo potencia las capacidades de los desarrolladores y empresas, sino que también posiciona a Microsoft como líder en hardware personalizado para IA. Para más información, visita la fuente original.