Samsung Inicia la Producción de Memoria HBM4 para Romper el Monopolio en el Mercado de IA

Introducción a la Evolución de las Memorias de Alto Ancho de Banda

Las memorias de alto ancho de banda (HBM) representan un pilar fundamental en el desarrollo de tecnologías de inteligencia artificial (IA) y computación de alto rendimiento. Desde su introducción inicial con HBM1 en 2013, estas memorias han evolucionado para satisfacer las demandas crecientes de procesamiento paralelo en aplicaciones como el entrenamiento de modelos de aprendizaje profundo y la inferencia en tiempo real. HBM4, la próxima generación, promete avances significativos en densidad, velocidad y eficiencia energética, posicionándose como un componente clave para superar las limitaciones actuales en el ecosistema de IA.

En el contexto de la ciberseguridad y las tecnologías emergentes, la disponibilidad y accesibilidad de estas memorias influyen directamente en la capacidad de las organizaciones para implementar sistemas de IA robustos. Por ejemplo, en entornos de detección de amenazas cibernéticas, donde se procesan grandes volúmenes de datos en paralelo, una memoria eficiente reduce la latencia y mejora la precisión de los algoritmos. Samsung, uno de los principales fabricantes globales de semiconductores, anuncia su entrada en la producción masiva de HBM4 a partir de febrero, con el objetivo explícito de desafiar el dominio de SK Hynix en este segmento crítico.

Esta movida no solo altera el panorama competitivo en el hardware para IA, sino que también tiene implicaciones en la cadena de suministro global, potencialmente reduciendo riesgos de monopolio que podrían afectar la innovación en blockchain y ciberseguridad. A lo largo de este artículo, exploraremos los aspectos técnicos de HBM4, el contexto del mercado actual y las proyecciones futuras basadas en esta iniciativa de Samsung.

Características Técnicas de la Memoria HBM4

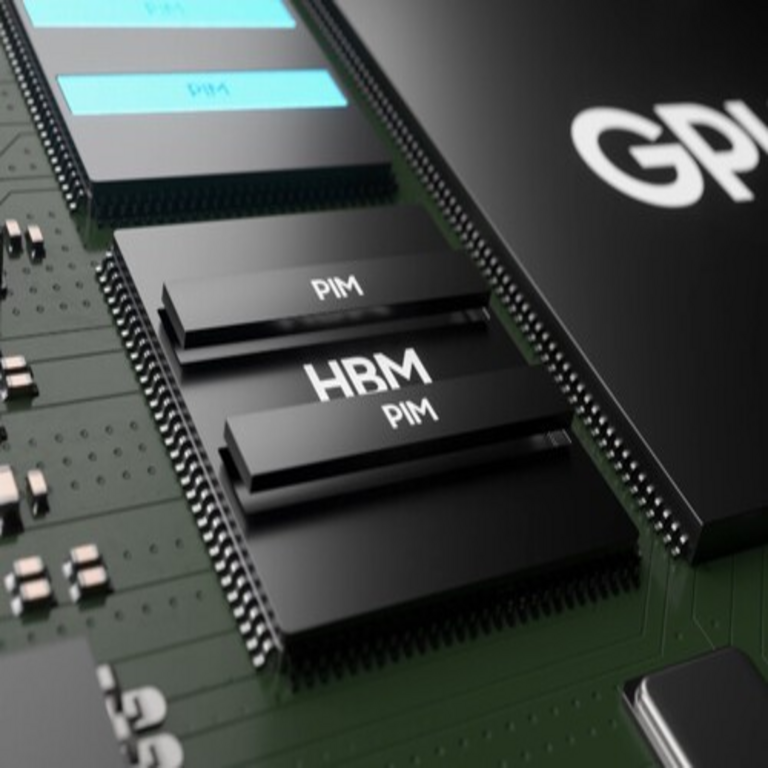

La memoria HBM4 introduce mejoras sustanciales en comparación con sus predecesoras, como HBM3 y HBM3E. Una de las innovaciones clave es el aumento en la densidad de almacenamiento, alcanzando hasta 16 gigabits por chip, lo que permite stacks de memoria más altos y capacidades totales superiores a 141 GB en configuraciones apiladas. Esta densidad es esencial para manejar los modelos de IA masivos, como los grandes modelos de lenguaje (LLM) que requieren terabytes de datos durante el entrenamiento.

En términos de ancho de banda, HBM4 ofrece velocidades de interfaz de hasta 1.280 GB/s por stack, un incremento del 50% respecto a HBM3E. Esta capacidad se logra mediante una arquitectura de interconexión 3D con through-silicon vias (TSV) avanzadas, que minimizan la latencia y maximizan el flujo de datos. Para aplicaciones de IA, esto significa un procesamiento más rápido de operaciones matriciales, fundamentales en redes neuronales convolucionales (CNN) y transformadores.

Desde la perspectiva de la eficiencia energética, HBM4 reduce el consumo por bit en un 20%, gracias a procesos de fabricación en nodos de 1α nm o inferiores. En ciberseguridad, donde los sistemas de IA operan en entornos de edge computing con recursos limitados, esta eficiencia es crucial para desplegar modelos de detección de intrusiones sin comprometer la batería o el rendimiento. Además, la integración con tecnologías como el blockchain para la verificación de datos en IA distribuida se beneficia de estas mejoras, permitiendo nodos más escalables en redes descentralizadas.

- Densidad mejorada: Hasta 16 Gb por chip, facilitando stacks de 12 o más capas.

- Ancho de banda elevado: 1.280 GB/s, ideal para GPUs de próxima generación como las de NVIDIA Blackwell.

- Eficiencia energética: Reducción del 20% en consumo, alineada con estándares de sostenibilidad en data centers.

- Compatibilidad: Diseñada para integrarse con interfaces JEDEC actualizadas, asegurando retrocompatibilidad.

Estas especificaciones posicionan a HBM4 como un habilitador para avances en IA generativa y computación cuántica híbrida, donde la memoria rápida es un cuello de botella recurrente.

El Monopolio Actual de SK Hynix en el Mercado de HBM

SK Hynix ha consolidado su posición dominante en el mercado de memorias HBM, capturando más del 70% de la cuota global en 2023. Esta supremacía se debe a su temprana inversión en HBM3 y alianzas estratégicas con proveedores de GPUs como NVIDIA y AMD. Por instancia, SK Hynix suministra la mayoría de las memorias para las tarjetas H100 y H200 de NVIDIA, esenciales para el entrenamiento de modelos de IA a escala empresarial.

El monopolio genera preocupaciones en el ámbito de la ciberseguridad, ya que una dependencia excesiva de un solo proveedor puede crear vulnerabilidades en la cadena de suministro. En escenarios de blockchain, donde la integridad de los datos es paramount, interrupciones en el suministro de HBM podrían afectar la minería y validación de transacciones en redes como Ethereum 2.0. Además, precios elevados debido a la falta de competencia han encarecido el despliegue de infraestructuras de IA, limitando el acceso a pymes en regiones emergentes de Latinoamérica.

Samsung, con su experiencia en DRAM y NAND, busca revertir esta dinámica. Históricamente, la compañía ha liderado en innovación de semiconductores, como en la producción de chips de 3 nm para procesadores de IA. Su entrada en HBM4 no es solo una respuesta competitiva, sino una estrategia para diversificar el mercado y fomentar la resiliencia en tecnologías emergentes.

En el contexto latinoamericano, donde la adopción de IA está en auge para aplicaciones como la agricultura inteligente y la vigilancia cibernética, esta competencia podría reducir costos y acelerar la innovación local. Países como México y Brasil, con crecientes data centers, se beneficiarán de opciones más accesibles.

Estrategia de Samsung para la Producción de HBM4

Samsung planea iniciar la fabricación masiva de HBM4 en febrero de 2025, utilizando su planta en Hwaseong, Corea del Sur. Esta línea de producción incorporará procesos EUV (Extreme Ultraviolet) de última generación para lograr rendimientos superiores al 80%. La compañía ha invertido más de 10 billones de wones (aproximadamente 7.500 millones de dólares) en I+D para HBM, enfocándose en la integración con paquetes 2.5D y 3D para GPUs y aceleradores de IA.

Una ventaja clave de Samsung es su ecosistema integrado, que incluye foundry services para clientes como Qualcomm y TSMC. Esto permite pruebas exhaustivas de HBM4 en entornos reales de IA, asegurando compatibilidad con frameworks como TensorFlow y PyTorch. En ciberseguridad, esta integración facilita el desarrollo de chips especializados para encriptación homomórfica, donde la memoria de alto rendimiento acelera cálculos en datos cifrados.

La misión de romper el monopolio de SK Hynix se materializa mediante alianzas potenciales con NVIDIA y AMD, que buscan diversificar proveedores para mitigar riesgos geopolíticos, como las tensiones en la cadena de suministro de semiconductores. Samsung también explora aplicaciones en blockchain, como memorias optimizadas para nodos de validación en proof-of-stake, reduciendo el consumo energético en un 30% comparado con soluciones actuales.

- Inversión en I+D: Enfoque en EUV y TSV para escalabilidad.

- Alianzas estratégicas: Colaboraciones con líderes en GPUs para validación temprana.

- Expansión geográfica: Planes para fábricas en EE.UU. y Vietnam, diversificando riesgos.

- Enfoque en sostenibilidad: Uso de materiales reciclados en empaques para alinear con regulaciones globales.

Esta estrategia no solo fortalece la posición de Samsung en IA, sino que promueve un mercado más equilibrado, beneficiando a desarrolladores en tecnologías emergentes.

Implicaciones para la Inteligencia Artificial y Ciberseguridad

La llegada de HBM4 de Samsung acelera el ciclo de innovación en IA, permitiendo modelos más complejos con miles de millones de parámetros. En ciberseguridad, esto se traduce en sistemas de IA más avanzados para análisis de malware y detección de anomalías en redes. Por ejemplo, algoritmos de aprendizaje profundo que procesan petabytes de logs de tráfico pueden ejecutarse con menor latencia, mejorando la respuesta a amenazas zero-day.

En el ámbito del blockchain, HBM4 habilita smart contracts más eficientes en plataformas como Solana o Polkadot, donde el procesamiento paralelo de transacciones requiere memorias de alta velocidad. La competencia entre Samsung y SK Hynix podría bajar precios en un 15-20% en los próximos dos años, democratizando el acceso a hardware de IA en Latinoamérica, donde iniciativas como el Plan Nacional de IA en Chile podrían beneficiarse directamente.

Sin embargo, surgen desafíos: la transición a HBM4 exige actualizaciones en software y hardware, potencialmente creando brechas de seguridad durante la migración. Organizaciones deben implementar protocolos de verificación para asegurar que las nuevas memorias no introduzcan vulnerabilidades en chips de IA, como side-channel attacks en entornos de machine learning.

Además, desde una perspectiva global, esta competencia fomenta la resiliencia contra interrupciones, como las vistas en la escasez de chips post-pandemia. En regiones como América Latina, donde la ciberseguridad es un pilar para la digitalización económica, HBM4 podría impulsar centros de datos soberanos, reduciendo dependencia de proveedores extranjeros.

Desafíos y Oportunidades en el Mercado Global

El mercado de HBM se proyecta crecer a una tasa anual compuesta del 45% hasta 2030, impulsado por la demanda de IA en sectores como la salud y las finanzas. Samsung enfrenta desafíos como la validación de rendimiento en entornos reales y la competencia de Micron, que también avanza en HBM4. No obstante, su escala de producción le permite capturar hasta un 40% de cuota en 2026.

En ciberseguridad, oportunidades emergen en la integración de HBM4 con hardware seguro, como chips con enclaves confiables (TEE) para procesar datos sensibles en IA. Para blockchain, esto significa validadores más rápidos y eficientes, potenciando DeFi y NFTs en economías emergentes.

Latinoamérica, con su creciente ecosistema de startups en IA, podría ver un boom en adopción gracias a precios más accesibles. Iniciativas como el Mercado Común del Sur (MERCOSUR) podrían fomentar colaboraciones regionales para fabricar componentes derivados de HBM.

- Crecimiento proyectado: Mercado de HBM superará los 20 mil millones de dólares en 2027.

- Desafíos regulatorios: Cumplimiento con exportaciones controladas en EE.UU. y China.

- Oportunidades en IA ética: Memorias eficientes para modelos transparentes y auditables.

- Impacto en sostenibilidad: Reducción de huella de carbono en data centers mediante eficiencia energética.

Estos elementos subrayan el rol transformador de HBM4 en el panorama tecnológico.

Consideraciones Finales sobre el Futuro de las Memorias en Tecnologías Emergentes

La iniciativa de Samsung en HBM4 marca un punto de inflexión en la competencia por el dominio en memorias para IA, con repercusiones profundas en ciberseguridad y blockchain. Al romper el monopolio de SK Hynix, se promueve un ecosistema más innovador y accesible, esencial para el avance equitativo en regiones como Latinoamérica. Futuras iteraciones de HBM integrarán avances en fotónica y computación neuromórfica, expandiendo sus aplicaciones más allá de la IA convencional.

En resumen, esta producción no solo eleva el rendimiento técnico, sino que fortalece la resiliencia global contra riesgos cibernéticos y monopolísticos, pavimentando el camino para una era de tecnologías emergentes inclusivas y seguras.

Para más información visita la Fuente original.