Tesla Revive el Proyecto Dojo: Hacia una Independencia Estratégica en el Entrenamiento de Inteligencia Artificial

El Contexto de la Dependencia de Nvidia en la Industria de la IA

En el panorama actual de la inteligencia artificial, la dominancia de Nvidia se ha consolidado como un pilar fundamental para el desarrollo de modelos avanzados. Sus unidades de procesamiento gráfico (GPU) han sido el estándar de facto para el entrenamiento de redes neuronales profundas, gracias a su arquitectura optimizada para operaciones paralelas y su ecosistema de software como CUDA. Empresas líderes en IA, incluyendo Tesla, han invertido miles de millones en clústeres de servidores equipados con estas GPU para procesar volúmenes masivos de datos. Sin embargo, esta dependencia genera vulnerabilidades estratégicas, tales como cuellos de botella en la cadena de suministro, costos elevados y limitaciones en la personalización para aplicaciones específicas.

Elon Musk, CEO de Tesla, ha expresado públicamente su frustración con esta situación. En declaraciones recientes, Musk ha destacado cómo la escasez global de chips Nvidia ha impactado el cronograma de desarrollo de vehículos autónomos en Tesla. La compañía, que procesa terabytes de datos de video generados por su flota de vehículos, requiere una capacidad computacional escalable y eficiente que no siempre se alinea con las ofertas estandarizadas de Nvidia. Esta dependencia no solo afecta la velocidad de innovación, sino que también expone a Tesla a riesgos geopolíticos, como las restricciones en exportaciones de tecnología estadounidense a ciertos mercados.

La filosofía subyacente en la estrategia de Nvidia se centra en una arquitectura generalista, diseñada para servir a una amplia gama de aplicaciones en IA, desde el procesamiento de lenguaje natural hasta la visión por computadora. Aunque efectiva, esta aproximación no optimiza completamente para cargas de trabajo específicas, como el análisis en tiempo real de datos de sensores en entornos dinámicos. Tesla, con su enfoque en la conducción autónoma, necesita hardware que priorice el procesamiento de video de alta resolución y la inferencia en bordes distribuidos, lo que ha impulsado la búsqueda de alternativas internas.

El Renacimiento del Proyecto Dojo: Arquitectura y Objetivos Principales

El proyecto Dojo, anunciado inicialmente por Tesla en 2021, representa un esfuerzo ambicioso por desarrollar un supercomputador personalizado para el entrenamiento de IA. Tras un período de desarrollo pausado, Tesla ha decidido resucitar esta iniciativa, invirtiendo recursos significativos para superar las limitaciones de las soluciones externas. Dojo se diseña como un sistema de computación exaescala, capaz de alcanzar exaflops de rendimiento en operaciones de punto flotante de precisión media, específicamente adaptado para el entrenamiento de modelos de visión por computadora a partir de datos de video.

A diferencia de las GPU de Nvidia, que utilizan una arquitectura basada en núcleos de procesamiento gráfico masivamente paralelos, Dojo emplea una filosofía radicalmente distinta: un enfoque en el procesamiento de datos a escala de sistema. El corazón del proyecto es el chip D1, fabricado en un proceso de 7 nanómetros por TSMC, que integra 50 mil millones de transistores en un die de 645 mm². Este chip no es una GPU tradicional, sino un acelerador de IA dedicado que procesa datos en formato de video crudo directamente, minimizando la latencia y el overhead de conversión de datos.

La arquitectura de Dojo se organiza en una jerarquía de componentes interconectados. En el nivel más bajo, los tiles D1 se agrupan en syslets, que a su vez forman training tiles y exapods. Cada exapod consta de miles de chips D1 interconectados mediante una red de alta velocidad basada en Ethernet de 400 Gbps, optimizada para el flujo de datos masivos. Esta configuración permite un ancho de banda de memoria efectivo superior a 36 TB/s por exapod, superando las limitaciones de las interconexiones NVLink de Nvidia en escenarios de entrenamiento distribuido.

Uno de los pilares de Dojo es su compilador personalizado, que transforma modelos de IA en instrucciones optimizadas para el hardware. Basado en el framework de Tesla, este compilador aprovecha técnicas de fusión de operaciones y tiling de datos para reducir el movimiento de datos, un factor crítico en el entrenamiento de modelos grandes como el utilizado en Full Self-Driving (FSD). El objetivo es lograr una eficiencia energética hasta 5 veces mayor que las alternativas basadas en GPU, lo que no solo reduce costos operativos, sino que también alinea con los compromisos de sostenibilidad de Tesla.

Implicaciones Técnicas en el Entrenamiento de Modelos para Vehículos Autónomos

El entrenamiento de IA para vehículos autónomos presenta desafíos únicos, derivados de la naturaleza multimodal y temporal de los datos. Tesla recopila diariamente petabytes de video de su flota global, que incluyen escenarios variados como tráfico urbano, condiciones meteorológicas adversas y comportamientos impredecibles de peatones. Procesar estos datos requiere no solo potencia computacional bruta, sino también algoritmos que manejen la secuencialidad y la causalidad inherente en las secuencias de video.

Dojo aborda estos retos mediante una integración profunda de hardware y software. Por ejemplo, el chip D1 incorpora unidades de procesamiento vectorial especializadas para operaciones de convolución 3D, esenciales en redes neuronales convolucionales (CNN) para análisis temporal. Además, soporta formatos de datos de precisión mixta, como BF16 y FP8, que permiten entrenamientos más rápidos sin sacrificar la precisión del modelo final. En pruebas iniciales, Dojo ha demostrado un rendimiento de hasta 1.3 exaflops en entrenamiento de IA, posicionándolo entre los supercomputadores más potentes del mundo.

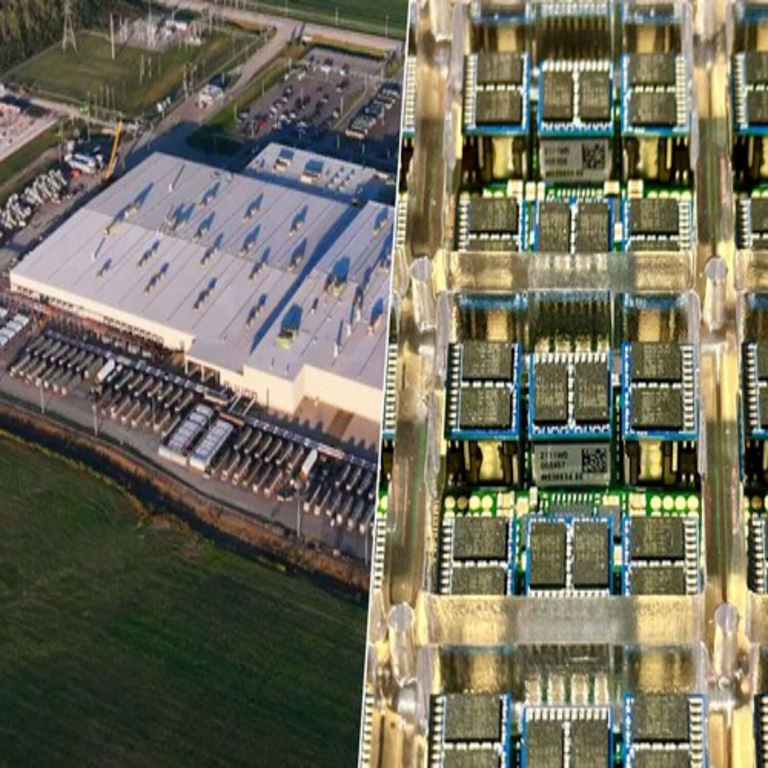

Desde una perspectiva de escalabilidad, Dojo está diseñado para crecer modularmente. Tesla planea desplegar múltiples exapods en su centro de datos en Austin, Texas, con expansiones futuras en instalaciones globales. Esta arquitectura distribuida facilita el paralelismo de datos y modelos, reduciendo el tiempo de convergencia en el entrenamiento de redes con miles de millones de parámetros. Comparado con clústeres de Nvidia A100 o H100, Dojo ofrece una latencia de comunicación inferior en un 40%, crucial para sincronizar gradientes en entrenamiento distribuido.

En términos de seguridad, Dojo incorpora medidas de ciberseguridad integradas, como encriptación de datos en tránsito y en reposo, y mecanismos de aislamiento de hardware para prevenir fugas de información sensible. Dado que Tesla maneja datos propietarios de usuarios, esta capa de seguridad es vital para cumplir con regulaciones como GDPR y CCPA, mitigando riesgos de brechas en entornos de computación de alto rendimiento.

Desafíos y Limitaciones en la Implementación de Dojo

A pesar de sus ventajas, el proyecto Dojo enfrenta obstáculos significativos. El desarrollo de hardware personalizado implica altos costos iniciales de diseño y fabricación, estimados en cientos de millones de dólares. Tesla ha colaborado con socios como TSMC para la producción, pero las disrupciones en la cadena de suministro global, exacerbadas por tensiones geopolíticas, podrían retrasar el rollout. Además, la optimización de software para Dojo requiere un ecosistema de desarrollo maduro, similar a CUDA, lo que demanda tiempo y talento especializado.

Otro desafío radica en la interoperabilidad. Aunque Dojo se enfoca en entrenamiento, Tesla aún depende de GPU de Nvidia para inferencia en vehículos y simulaciones. La transición completa requeriría una unificación de stacks de software, potencialmente integrando elementos de PyTorch o TensorFlow con el compilador de Dojo. Pruebas de rendimiento indican que, mientras Dojo excelsa en cargas de video específicas, podría ser menos eficiente en tareas generales de IA, limitando su aplicabilidad más allá de la conducción autónoma.

En el ámbito de la inteligencia artificial ética, Dojo plantea preguntas sobre la transparencia de modelos entrenados en datos reales de usuarios. Tesla debe asegurar que los algoritmos incorporen sesgos mitigados y explicabilidad, especialmente en decisiones críticas de seguridad. La resurrección de Dojo podría acelerar avances en IA, pero también intensificar debates sobre el control corporativo de infraestructuras computacionales clave.

Impacto Estratégico en la Industria de la IA y Más Allá

La iniciativa de Tesla con Dojo no solo busca independencia operativa, sino que también redefine el panorama competitivo en hardware de IA. Al demostrar la viabilidad de arquitecturas personalizadas, Tesla inspira a otras compañías a diversificar sus proveedores, potencialmente erosionando el monopolio de Nvidia. Empresas como Google con TPUs y Amazon con Inferentia ya exploran caminos similares, pero el enfoque de Dojo en datos de video lo posiciona como un referente para aplicaciones en robótica y edge computing.

En el contexto de tecnologías emergentes, Dojo podría intersectar con blockchain para aplicaciones de verificación distribuida de datos de entrenamiento, asegurando integridad en flotas descentralizadas. Aunque Tesla no ha anunciado integraciones directas, la capacidad de Dojo para procesar datos en tiempo real podría habilitar redes de IA seguras y auditables, relevantes en ciberseguridad para detección de anomalías en sistemas autónomos.

Desde una visión global, el proyecto subraya la importancia de la soberanía tecnológica. Países y empresas que dependen de proveedores extranjeros enfrentan riesgos en innovación, y Dojo ejemplifica cómo la inversión en R&D interno puede mitigar estos. Para Tesla, el éxito de Dojo aceleraría el despliegue de Robotaxi y Optimus, sus robots humanoides, expandiendo el ecosistema de IA más allá de los automóviles.

En resumen, la resurrección de Dojo marca un punto de inflexión en la estrategia de Tesla, priorizando la autonomía en un ecosistema dominado por gigantes del hardware. Esta evolución no solo optimiza el entrenamiento de IA para movilidad autónoma, sino que también contribuye a un futuro más diversificado y resiliente en tecnologías emergentes.

Para más información visita la Fuente original.