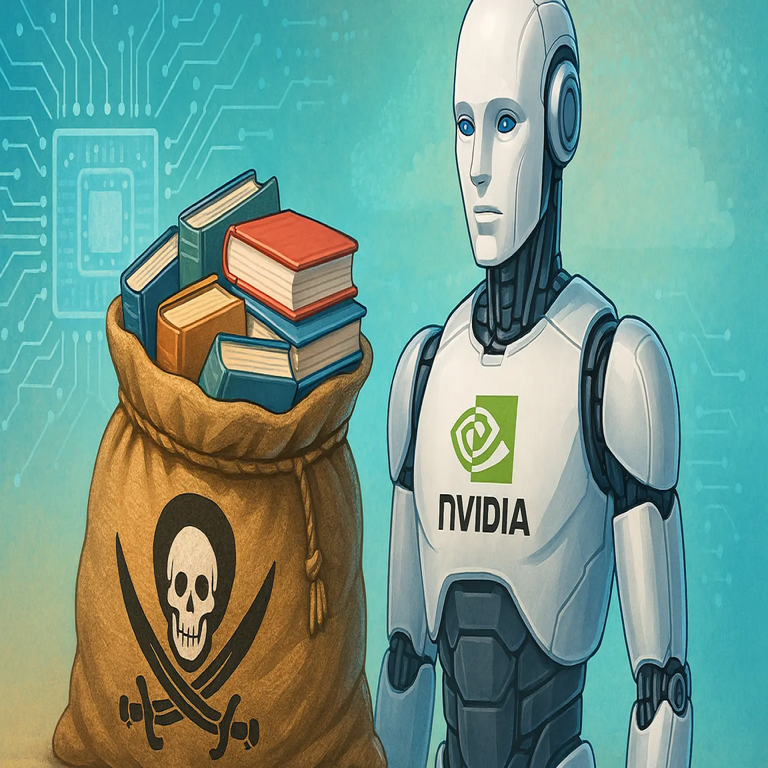

Acusaciones contra Nvidia por el uso de libros pirateados en el entrenamiento de inteligencia artificial

Antecedentes de la controversia

La empresa Nvidia enfrenta serias acusaciones por presuntamente haber utilizado millones de libros pirateados para entrenar sus modelos de inteligencia artificial. Esta denuncia surge de un análisis detallado realizado por investigadores y autores, quienes han identificado que el dataset conocido como “The Pile” incluye una colección significativa de obras literarias protegidas por derechos de autor sin autorización de los creadores. The Pile, un conjunto de datos de código abierto compilado por EleutherAI, se ha convertido en una herramienta clave para el desarrollo de modelos de lenguaje grandes (LLM), y Nvidia lo ha empleado en el entrenamiento de sus sistemas de IA generativa.

Específicamente, el subconjunto Books3 de The Pile contiene aproximadamente 196.640 libros completos, extraídos de sitios web de piratería como Library Genesis y Z-Library. Estos recursos digitales no autorizados albergan obras de autores reconocidos, incluyendo novelas, ensayos y textos académicos, que fueron escaneados y distribuidos ilegalmente. La inclusión de este material en datasets de entrenamiento plantea interrogantes éticos y legales sobre la propiedad intelectual en el ecosistema de la IA.

Detalles técnicos del dataset y su integración en modelos de IA

Desde un punto de vista técnico, The Pile es un corpus masivo de texto con más de 800 gigabytes de datos, diseñado para replicar la diversidad de información disponible en internet. Su estructura se basa en una concatenación de subconjuntos temáticos, donde Books3 representa alrededor del 4% del total, pero con un impacto desproporcionado debido a su calidad literaria y densidad semántica. Los modelos de IA, como los basados en arquitecturas Transformer, requieren volúmenes masivos de datos para aprender patrones lingüísticos, y datasets como este permiten la optimización de parámetros mediante técnicas de aprendizaje supervisado y no supervisado.

En el proceso de entrenamiento, los textos de Books3 se tokenizan y se integran en el flujo de datos de entrenamiento, donde algoritmos como el preentrenamiento autoregresivo extraen representaciones vectoriales de las palabras y contextos. Nvidia, líder en hardware para cómputo de alto rendimiento con sus GPUs, ha utilizado estas configuraciones para acelerar el entrenamiento de modelos como NeMo, su plataforma de IA generativa. La acusación radica en que, al no filtrar o licenciar el contenido, Nvidia ha beneficiado indirectamente de la piratería, violando potencialmente leyes como la DMCA (Digital Millennium Copyright Act) en Estados Unidos o equivalentes en jurisdicciones internacionales.

- Composición de Books3: Incluye obras de autores como Stephen King, J.K. Rowling y otros, con un total estimado de más de 100 millones de palabras procesadas.

- Métodos de extracción: Los datos se obtuvieron mediante web scraping de repositorios piratas, lo que implica riesgos de ciberseguridad como exposición a malware o datos manipulados.

- Impacto en el rendimiento: La inclusión de literatura de alta calidad mejora la coherencia narrativa y el vocabulario de los modelos, pero a costa de reproducir sesgos o infracciones inherentes al material fuente.

Implicaciones éticas y legales en ciberseguridad y IA

Esta controversia resalta vulnerabilidades en la cadena de suministro de datos para IA, un área crítica en ciberseguridad. La dependencia de datasets no verificados expone a las empresas a riesgos legales, como demandas colectivas por infracción de copyright, y a amenazas operativas, incluyendo la propagación de datos falsos o contaminados. En el contexto de Blockchain, tecnologías como NFTs y contratos inteligentes podrían ofrecer soluciones para rastrear y licenciar contenidos de manera descentralizada, asegurando que solo datos autorizados se utilicen en entrenamientos.

Legalmente, casos precedentes como el de OpenAI y Microsoft, donde autores demandaron por el uso similar de Books3, establecen un precedente. Nvidia podría enfrentar multas sustanciales o requerimientos para desentrenar modelos, un proceso costoso que involucra técnicas de “machine unlearning” para eliminar influencias específicas de subconjuntos de datos. Desde la perspectiva de ciberseguridad, esto subraya la necesidad de auditorías de datasets, implementando hash verificables y firmas digitales para validar la procedencia de la información.

Perspectivas futuras y recomendaciones técnicas

Para mitigar estos riesgos, las empresas de IA deben adoptar marcos de gobernanza de datos que incluyan licencias explícitas y herramientas de filtrado automatizado, como clasificadores basados en metadatos de copyright. En el ámbito de la IA ética, iniciativas como el desarrollo de datasets sintéticos generados por modelos controlados podrían reducir la dependencia de fuentes externas no autorizadas. Nvidia, como pionera en aceleración de IA, tiene la oportunidad de liderar en la adopción de estándares transparentes, integrando protocolos de Blockchain para auditar el linaje de datos en sus pipelines de entrenamiento.

En resumen, esta acusación no solo cuestiona las prácticas de Nvidia, sino que impulsa un debate global sobre la sostenibilidad del entrenamiento de IA en un ecosistema digital plagado de piratería.

Para más información visita la Fuente original.