La Generación de Imágenes por Inteligencia Artificial y los Desafíos de Verificación en la Era Digital

Introducción a las Imágenes Generadas por IA

La inteligencia artificial (IA) ha transformado radicalmente la forma en que se crean y consumen contenidos visuales en internet. Modelos avanzados como DALL-E, Midjourney y Stable Diffusion permiten generar imágenes hiperrealistas a partir de descripciones textuales simples. Estas herramientas utilizan redes neuronales profundas, específicamente arquitecturas de difusión y generativas antagónicas (GAN), para sintetizar visuales que imitan la fotografía real con un nivel de detalle impresionante. En el contexto de ciberseguridad, esta capacidad plantea interrogantes fundamentales sobre la autenticidad de las imágenes que circulan en línea, ya que facilitan la propagación de desinformación y manipulaciones visuales.

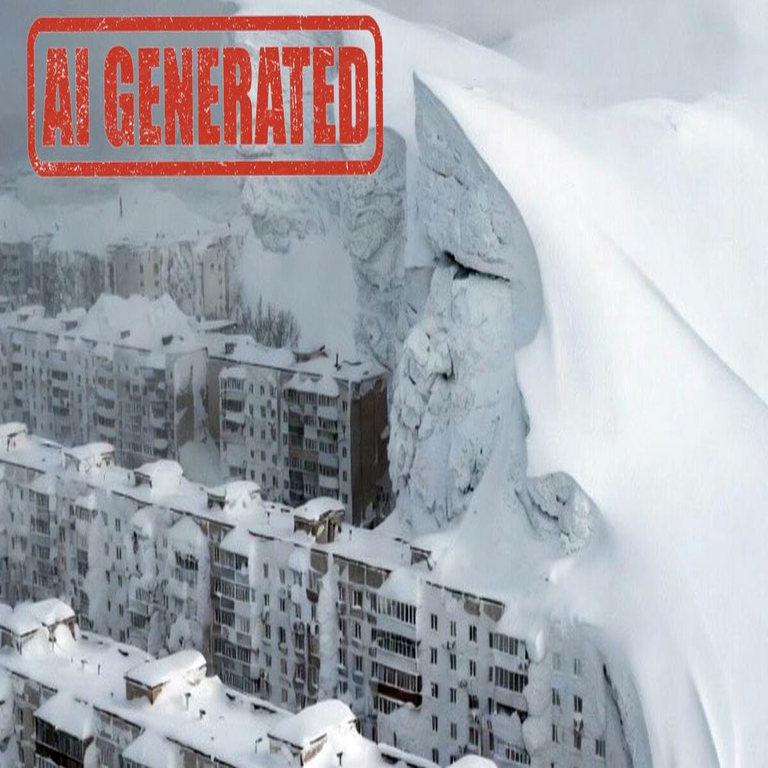

Por ejemplo, una imagen que representa una nevada inusual en la península de Kamchatka, en Rusia, generada por IA, puede parecer un registro fotográfico genuino de un evento climático. Sin embargo, al analizar su origen, se revela como un producto sintético diseñado para ilustrar los límites de la confianza en contenidos visuales. Este tipo de creaciones no solo desafía la percepción humana, sino que también amplifica vulnerabilidades en sistemas de información, donde la verificación manual es insuficiente frente a la escala masiva de datos digitales.

Desde una perspectiva técnica, los modelos de IA generativa operan mediante procesos iterativos que refinan ruido aleatorio hasta formar patrones coherentes. En el caso de imágenes de paisajes nevados, el algoritmo integra datos de entrenamiento masivos, incluyendo fotografías reales de entornos árticos, para replicar texturas como la nieve acumulada, el brillo del hielo y la niebla atmosférica. Esta fidelidad visual complica la detección de falsificaciones, obligando a los expertos en ciberseguridad a adoptar enfoques más sofisticados para validar la procedencia de los medios.

Implicaciones en Ciberseguridad: Deepfakes y Manipulación Visual

En el ámbito de la ciberseguridad, las imágenes generadas por IA representan una extensión de las amenazas conocidas como deepfakes, que originalmente se centraban en videos y audio. Ahora, las manipulaciones estáticas pueden usarse para respaldar narrativas falsas, como eventos climáticos inexistentes o escenarios de crisis fabricados. La nevada en Kamchatka, aunque ficticia, ejemplifica cómo una sola imagen puede viralizarse en redes sociales, influyendo en opiniones públicas o incluso en decisiones políticas sin verificación adecuada.

Los riesgos incluyen la desinformación masiva, donde actores maliciosos emplean estas herramientas para campañas de propaganda. Técnicamente, la detección de deepfakes visuales involucra análisis forense digital, como el examen de artefactos en píxeles o inconsistencias en la iluminación. Herramientas como Forensically o Adobe Content Authenticity Initiative (CAI) escanean metadatos y patrones de compresión para identificar manipulaciones. Sin embargo, los avances en IA contrarrestan estos métodos; por instancia, modelos como Grok-1 de xAI incorporan técnicas de “invisibilidad” que evaden detectores convencionales al simular variaciones naturales en el ruido de imagen.

Además, en entornos corporativos, estas imágenes falsas pueden integrarse en phishing avanzado. Un correo electrónico con una “fotografía” de un desastre natural podría inducir a clics en enlaces maliciosos, comprometiendo sistemas. La ciberseguridad moderna exige protocolos de verificación multifactor, como la integración de firmas digitales basadas en blockchain para certificar la autenticidad de imágenes. Plataformas como Truepic o Veriff utilizan hashes criptográficos para rastrear la cadena de custodia de archivos visuales, asegurando que cualquier alteración sea detectable.

Desde el punto de vista de la privacidad, las IA generativas entrenadas en datasets públicos pueden inadvertidamente reproducir datos sensibles, como rostros de individuos sin consentimiento. Regulaciones como el GDPR en Europa y leyes emergentes en Latinoamérica, como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares en México, exigen transparencia en el uso de IA, pero su aplicación a contenidos generados permanece en evolución.

Tecnologías Emergentes para la Verificación de Contenidos Visuales

Para contrarrestar los desafíos planteados por imágenes como la nevada en Kamchatka, se están desarrollando tecnologías emergentes centradas en la trazabilidad y la autenticidad. El blockchain emerge como una solución clave en este ecosistema, permitiendo la creación de registros inmutables para medios digitales. Por ejemplo, el estándar C2PA (Content Provenance and Authenticity) integra metadatos encriptados en las imágenes, que se almacenan en cadenas de bloques distribuidas, facilitando la verificación en tiempo real.

En términos técnicos, un hash SHA-256 de la imagen original se genera al momento de su captura o creación, y se vincula a un NFT (Non-Fungible Token) en plataformas como Ethereum o Solana. Cualquier modificación posterior altera el hash, alertando a los verificadores. Empresas como KodakOne han implementado sistemas similares para proteger derechos de autor, extendiendo su utilidad a la ciberseguridad al prevenir la difusión de falsificaciones en redes sociales.

- Blockchain para Trazabilidad: Registros distribuidos aseguran que la historia de una imagen sea inalterable, ideal para periodismo y análisis de inteligencia.

- IA Detectiva: Modelos contrarios, como los de Microsoft Video Authenticator, analizan inconsistencias en sombras, reflejos y patrones de ruido para clasificar imágenes como sintéticas con una precisión superior al 90%.

- Metadatos Embebidos: Herramientas como IPTC Photo Metadata utilizan esquemas estandarizados para incrustar información de origen, compatible con editores como Photoshop.

Otras innovaciones incluyen el watermarking invisible, donde patrones imperceptibles se incrustan en la imagen mediante algoritmos de esteganografía. Estos watermarks resisten compresiones y ediciones, permitiendo la extracción mediante software especializado. En Latinoamérica, iniciativas como el proyecto de verificación de imágenes en Brasil, impulsado por el Instituto de Tecnologia e Sociedade do Rio (ITS Rio), exploran estas técnicas para combatir la desinformación electoral.

Sin embargo, no todo es optimista; la carrera armamentística entre generadores y detectores de IA continúa. Modelos como Stable Diffusion 3.0 incorporan mecanismos de auto-censura, pero vulnerabilidades persisten, como el “prompt injection” que fuerza la creación de contenidos prohibidos. En ciberseguridad, esto implica la necesidad de actualizaciones continuas en firewalls y sistemas de monitoreo, integrando APIs de detección de IA en navegadores y apps.

Aplicaciones en Tecnologías Emergentes y Casos de Estudio

Más allá de la detección, las imágenes generadas por IA tienen aplicaciones legítimas en ciberseguridad, como la simulación de escenarios de amenazas. En entrenamiento de analistas, se usan visuales sintéticos para recrear ataques cibernéticos visuales, como mapas de redes comprometidas o interfaces de malware. La nevada en Kamchatka podría servir como caso de estudio para ilustrar cómo un evento climático falso podría enmascarar una operación de ciberespionaje, distra yendo atención pública.

En blockchain, la integración de IA generativa acelera el desarrollo de smart contracts visuales, donde imágenes verificadas activan transacciones automáticas. Por ejemplo, en supply chain management, fotos de productos generadas por IA se validan contra registros en cadena para prevenir fraudes. Plataformas como VeChain utilizan esta combinación para rastrear bienes físicos, extendiendo su utilidad a la validación de evidencias digitales en investigaciones forenses.

Casos reales destacan estos desafíos: durante las elecciones de 2024 en varios países latinoamericanos, imágenes deepfake de candidatos circularon ampliamente, influyendo en el voto. En México, la Comisión Federal de Competencia Económica (COFECE) ha alertado sobre el uso de IA en campañas publicitarias engañosas. Otro ejemplo es el incidente de 2023 en Ucrania, donde imágenes generadas de “ataques rusos ficticios” se usaron en propaganda, subrayando la urgencia de marcos regulatorios globales.

Técnicamente, la computación cuántica promete acelerar tanto la generación como la detección. Algoritmos cuánticos podrían romper encriptaciones actuales de blockchain, pero también habilitar verificaciones ultra-rápidas. Investigaciones en laboratorios como el de IBM exploran qubits para procesar patrones visuales complejos, potencialmente revolucionando la ciberseguridad visual en la próxima década.

Desafíos Éticos y Regulatorios en la Adopción de IA Generativa

Los aspectos éticos de las imágenes generadas por IA demandan un escrutinio profundo. La accesibilidad de herramientas como Bing Image Creator democratiza la creación, pero también amplifica sesgos inherentes en datasets de entrenamiento, como representaciones estereotipadas de regiones como Kamchatka. En ciberseguridad, esto puede llevar a discriminación algorítmica en sistemas de vigilancia facial, donde imágenes sintéticas sesgadas entrenan modelos defectuosos.

Regulatoriamente, la Unión Europea avanza con la AI Act, clasificando generadores de deepfakes como de “alto riesgo”, exigiendo auditorías y etiquetado obligatorio. En Latinoamérica, países como Argentina y Chile han propuesto leyes similares, enfocadas en la protección contra desinformación. Organismos como la OEA promueven guías para el uso ético de IA en periodismo, enfatizando la verificación cruzada con fuentes múltiples.

Desde una óptica técnica, implementar estos marcos requiere estándares interoperables. Protocolos como el de la World Wide Web Consortium (W3C) para metadatos de IA buscan estandarizar la divulgación de contenidos generados, permitiendo que navegadores como Chrome muestren alertas automáticas. No obstante, la enforcement global enfrenta barreras, como la jurisdicción transfronteriza y la evolución rápida de la tecnología.

Estrategias Prácticas para Usuarios y Organizaciones

Para mitigar riesgos, usuarios individuales deben adoptar hábitos de verificación: consultar fuentes primarias, usar reverse image search en herramientas como Google Lens o TinEye, y examinar inconsistencias contextuales, como sombras imposibles en una nevada generada. En organizaciones, se recomiendan políticas de zero-trust para contenidos visuales, integrando escáneres de IA en workflows de aprobación.

- Educación Continua: Capacitación en reconocimiento de deepfakes, utilizando simuladores como los de Deepfake Detection Challenge.

- Herramientas Integradas: Extensiones de navegador como NewsGuard para calificar la fiabilidad de imágenes en sitios web.

- Colaboración Intersectorial: Alianzas entre tech companies, gobiernos y ONGs para bases de datos compartidas de imágenes verificadas.

En el sector blockchain, wallets como MetaMask podrían evolucionar para incluir verificación visual, escaneando QR codes embebidos en imágenes para validar autenticidad. Estas estrategias no solo protegen contra manipulaciones, sino que fomentan un ecosistema digital más resiliente.

Cierre: Hacia un Futuro de Contenidos Verificables

La proliferación de imágenes generadas por IA, ilustrada por creaciones como la nevada en Kamchatka, subraya la necesidad imperativa de robustos mecanismos de verificación en ciberseguridad. Al integrar avances en IA detectiva, blockchain y regulaciones éticas, la comunidad tecnológica puede restaurar la confianza en los medios visuales digitales. Este enfoque holístico no solo mitiga riesgos actuales, sino que prepara el terreno para innovaciones futuras, asegurando que la era de la IA sea sinónimo de transparencia y seguridad.

Para más información visita la Fuente original.