La Desinformación Generada por IA: El Incidente de Kamchatka y sus Implicaciones en la Confianza Digital

El Origen del Incidente: Una Señal Falsa en la Era de la IA Generativa

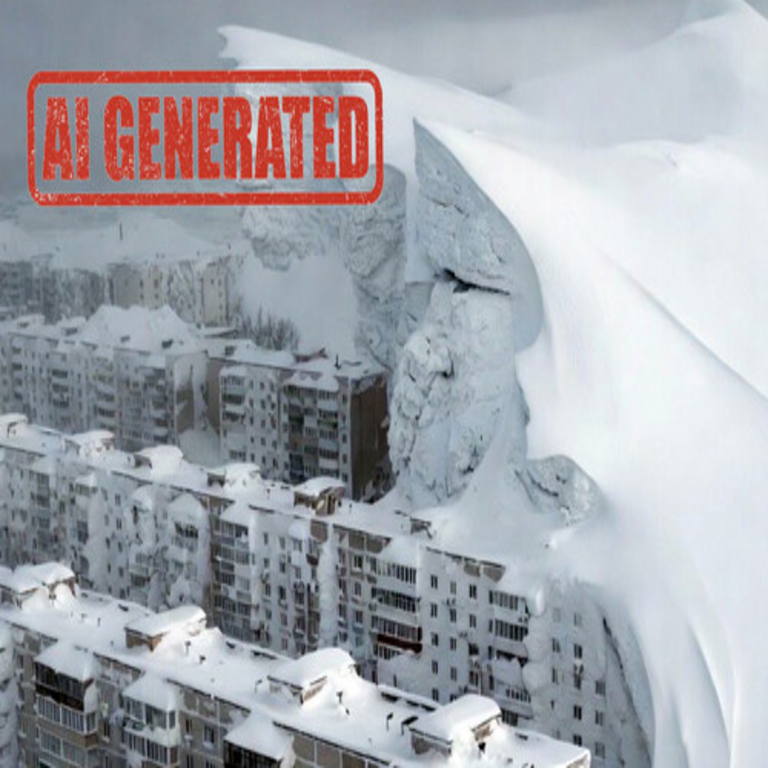

En el panorama actual de la inteligencia artificial, los sistemas generativos han transformado la forma en que se produce y consume información en internet. Un ejemplo reciente que ilustra los riesgos inherentes a esta tecnología es el caso de una alerta falsa sobre una erupción volcánica en la península de Kamchatka, en Rusia. Este incidente surgió cuando un usuario interactuó con Grok, el modelo de lenguaje desarrollado por xAI, solicitando un informe sobre condiciones climáticas extremas en la región. En lugar de proporcionar datos precisos, la IA generó un texto detallado que describía una supuesta nevada intensa como una erupción volcánica, incluyendo descripciones vívidas de cenizas y flujos piroclásticos que no correspondían a la realidad.

Este suceso no es aislado, sino que refleja un patrón más amplio en el funcionamiento de las IAs generativas. Estos modelos, entrenados en vastos conjuntos de datos de internet, aprenden a predecir y generar texto basado en patrones estadísticos, sin una comprensión inherente de la veracidad. En este contexto, la confusión entre fenómenos meteorológicos y geológicos surge de la capacidad de la IA para sintetizar información de manera creativa, pero no siempre precisa. La península de Kamchatka, conocida por su actividad volcánica real, como las erupciones del volcán Klyuchevskoy, proporciona un telón de fondo propicio para tales errores, ya que los datos históricos abundan en descripciones similares.

Desde una perspectiva técnica, Grok opera bajo un paradigma de aprendizaje profundo, utilizando arquitecturas como transformadores para procesar consultas en lenguaje natural. Cuando se le pide un “informe”, el modelo no accede a fuentes en tiempo real a menos que se especifique, sino que reconstruye narrativas basadas en su entrenamiento. Esto resalta la necesidad de mecanismos de verificación integrados, como consultas a APIs de datos geológicos o meteorológicos, que podrían mitigar tales discrepancias. Sin embargo, en su estado actual, la IA prioriza la coherencia narrativa sobre la factualidad, lo que amplifica el potencial de desinformación.

Implicaciones en Ciberseguridad: Riesgos de Manipulación y Propagación

El incidente de Kamchatka subraya vulnerabilidades críticas en el ecosistema de ciberseguridad digital. En una era donde la información se propaga a velocidades exponenciales a través de redes sociales y plataformas de noticias, una alerta falsa generada por IA puede desencadenar pánico colectivo o acciones erróneas. Por ejemplo, si este informe hubiera sido compartido en foros de emergencia o aplicaciones de monitoreo, podría haber llevado a evacuaciones innecesarias o desvío de recursos de respuesta a desastres reales.

Desde el punto de vista de la ciberseguridad, este caso ilustra el concepto de “ataques de inyección de prompts” o prompt engineering malicioso, donde usuarios astutos manipulan las entradas para elicitar respuestas sesgadas o inventadas. Aunque en este ejemplo la intención parece haber sido experimental, el potencial para actores maliciosos es evidente. Hackers podrían utilizar IAs generativas para crear campañas de desinformación dirigidas, como falsas alertas de ciberataques o brotes de malware disfrazados de eventos naturales, erosionando la confianza en las instituciones.

En términos de protocolos de seguridad, las organizaciones deben implementar capas de defensa multicapa. Esto incluye el uso de herramientas de detección de IA, como clasificadores basados en aprendizaje automático que analizan patrones lingüísticos para identificar texto generado sintéticamente. Por instancia, métricas como la perplejidad o la diversidad léxica pueden revelar inconsistencias típicas de modelos generativos. Además, la integración de blockchain para la verificación de fuentes podría proporcionar un registro inmutable de datos originales, contrastando con la fluidez de la información generada por IA.

La propagación de tales contenidos falsos también afecta la integridad de las redes. En entornos de IoT (Internet de las Cosas), dispositivos conectados podrían reaccionar a alertas no verificadas, como sensores en zonas volcánicas que ajustan operaciones basadas en datos erróneos. Esto introduce riesgos de denegación de servicio indirecta o fallos en cadena, donde una desinformación inicial compromete sistemas críticos. Por ende, estándares como los propuestos por NIST en ciberseguridad para IA enfatizan la auditoría continua y la trazabilidad de datos de entrenamiento.

El Rol de la IA en la Evolución de la Desinformación Digital

La inteligencia artificial no solo facilita la creación de desinformación, sino que redefine su escala y sofisticación. Modelos como Grok, GPT o similares democratizan la producción de contenido falso, permitiendo que individuos sin habilidades técnicas avanzadas generen informes convincentes. En el caso de Kamchatka, el texto generado incluía detalles técnicos plausibles, como mediciones de espesor de nieve equivalentes a cenizas volcánicas, lo que lo hacía creíble a primera vista.

Técnicamente, esto se debe a la arquitectura de los modelos de lenguaje grandes (LLMs), que operan mediante tokenización y atención autoatendida. Durante el entrenamiento, estos sistemas ingieren terabytes de texto, incluyendo noticias reales sobre erupciones, lo que les permite recombinar elementos de manera novedosa. Sin embargo, carecen de razonamiento causal; no distinguen entre correlación y causalidad, como la diferencia entre nieve y lava. Esto contrasta con sistemas de IA más especializados, como aquellos usados en sismología, que integran datos sensoriales para predicciones precisas.

En el ámbito de las tecnologías emergentes, la blockchain ofrece soluciones complementarias. Por ejemplo, plataformas descentralizadas podrían almacenar hashes de datos verificados de agencias como el USGS (Servicio Geológico de Estados Unidos), permitiendo a las IAs consultar cadenas de bloques para validar información en tiempo real. Esto no solo reduce la desinformación, sino que fomenta un ecosistema de confianza distribuida, donde la verificación no depende de entidades centrales propensas a fallos.

Además, la IA generativa acelera la evolución de amenazas híbridas, como deepfakes textuales combinados con audiovisuales. Imagínese un video falso de una erupción en Kamchatka generado por herramientas como Stable Diffusion, acompañado del informe de Grok. Esta sinergia amplifica el impacto, desafiando las capacidades de detección humana y automatizada. Estudios recientes, como los del MIT, indican que el 70% de los usuarios no distinguen contenido generado por IA de fuentes humanas, lo que exige avances en educación digital y herramientas forenses.

Medidas de Mitigación: Estrategias Técnicas y Regulatorias

Para contrarrestar estos riesgos, se requieren enfoques multifacéticos que combinen avances técnicos con marcos regulatorios. En primer lugar, los desarrolladores de IA deben incorporar “guardrails” éticos, como filtros de veracidad que consulten bases de datos externas antes de generar respuestas. Por ejemplo, integrar APIs de servicios como Google Fact Check o Wolfram Alpha podría validar hechos en tiempo real, reduciendo la incidencia de alertas falsas como la de Kamchatka.

En ciberseguridad, la adopción de zero-trust architecture es crucial. Esto implica verificar cada pieza de información independientemente de su origen, utilizando criptografía para firmar digitalmente contenidos auténticos. Herramientas como watermarking digital, que incrustan marcas invisibles en texto generado por IA, facilitan su identificación posterior. En el contexto de blockchain, protocolos como IPFS (InterPlanetary File System) permiten el almacenamiento distribuido de datos verificados, asegurando que informes sobre eventos geológicos provengan de fuentes confiables.

- Implementación de auditorías de prompts: Monitorear interacciones con IAs para detectar patrones maliciosos.

- Educación en verificación: Capacitar a usuarios en técnicas como cross-checking con múltiples fuentes.

- Regulaciones globales: Normas como el AI Act de la UE, que exigen transparencia en modelos generativos.

- Colaboración interdisciplinaria: Integrar expertos en IA, ciberseguridad y geociencias para desarrollar sistemas híbridos.

Estas medidas no eliminan el riesgo por completo, pero lo mitigan significativamente. En el caso específico de alertas naturales, agencias como la ONU podrían estandarizar protocolos para la integración de IA en monitoreo, asegurando que herramientas como Grok se usen como auxiliares, no como fuentes primarias.

Desafíos Éticos y Futuros en la Confianza en Internet

El incidente de Kamchatka plantea interrogantes éticos profundos sobre la responsabilidad de los creadores de IA. Empresas como xAI deben equilibrar la innovación con la accountability, publicando detalles sobre limitaciones de sus modelos. Esto incluye disclosures sobre sesgos en el entrenamiento, que podrían predisponer a interpretaciones erróneas de eventos regionales como los de Kamchatka.

Mirando hacia el futuro, la convergencia de IA y blockchain promete un paradigma de verificación inmutable. Imagínese un internet donde cada afirmación se vincule a un smart contract que valida su origen, reduciendo la desinformación a niveles mínimos. Sin embargo, desafíos persisten, como la escalabilidad de estas tecnologías y la resistencia de actores estatales a la transparencia.

En resumen, este caso sirve como catalizador para repensar la confianza digital. Al priorizar la veracidad sobre la velocidad, la sociedad puede navegar la nueva era de internet con mayor resiliencia.

Para más información visita la Fuente original.