Inteligencia Artificial Generativa en Ciberseguridad: Amenazas y Oportunidades

Introducción a la Inteligencia Artificial Generativa

La inteligencia artificial generativa (IA generativa) representa un avance significativo en el campo de la inteligencia artificial, donde los modelos aprenden patrones de datos para crear contenido nuevo y realista, como texto, imágenes, audio o incluso código. Tecnologías como los modelos de lenguaje grandes (LLM, por sus siglas en inglés), tales como GPT, y generadores de imágenes como DALL-E, han transformado diversas industrias. En el contexto de la ciberseguridad, esta tecnología introduce tanto herramientas innovadoras para la defensa como vectores potenciales de ataque que los profesionales deben considerar.

En América Latina, donde la adopción de tecnologías digitales crece rápidamente, la integración de IA generativa en sistemas de seguridad cibernética es un tema de creciente relevancia. Según informes de organizaciones como el Banco Interamericano de Desarrollo (BID), el 70% de las empresas en la región enfrentan amenazas cibernéticas avanzadas, y la IA podría mitigar o exacerbar estos riesgos. Este artículo explora las amenazas que plantea la IA generativa en ciberseguridad y las oportunidades que ofrece para fortalecer las defensas, basándose en análisis técnicos y casos prácticos.

Amenazas Principales Derivadas de la IA Generativa

La IA generativa, al ser capaz de producir contenido indistinguible del humano, facilita ataques sofisticados que evaden detecciones tradicionales. Una de las amenazas más prominentes es el phishing impulsado por IA, donde los atacantes generan correos electrónicos o mensajes personalizados que imitan estilos de comunicación auténticos. Por ejemplo, un modelo entrenado en datos de un empleado podría crear un email que replica su tono y vocabulario, aumentando la tasa de éxito en un 30-50%, según estudios de firmas como Proofpoint.

Otra preocupación es la generación de deepfakes, que involucran videos o audios falsos de alta calidad. En ciberseguridad, estos se utilizan para ingeniería social, como suplantar a ejecutivos en llamadas de voz para autorizar transacciones fraudulentas. En Latinoamérica, incidentes reportados en países como México y Brasil muestran cómo deepfakes han sido empleados en estafas bancarias, con pérdidas estimadas en millones de dólares anuales. La detección de estos requiere algoritmos de análisis forense que identifiquen anomalías en patrones de habla o expresiones faciales, pero la evolución rápida de la IA generativa complica esta tarea.

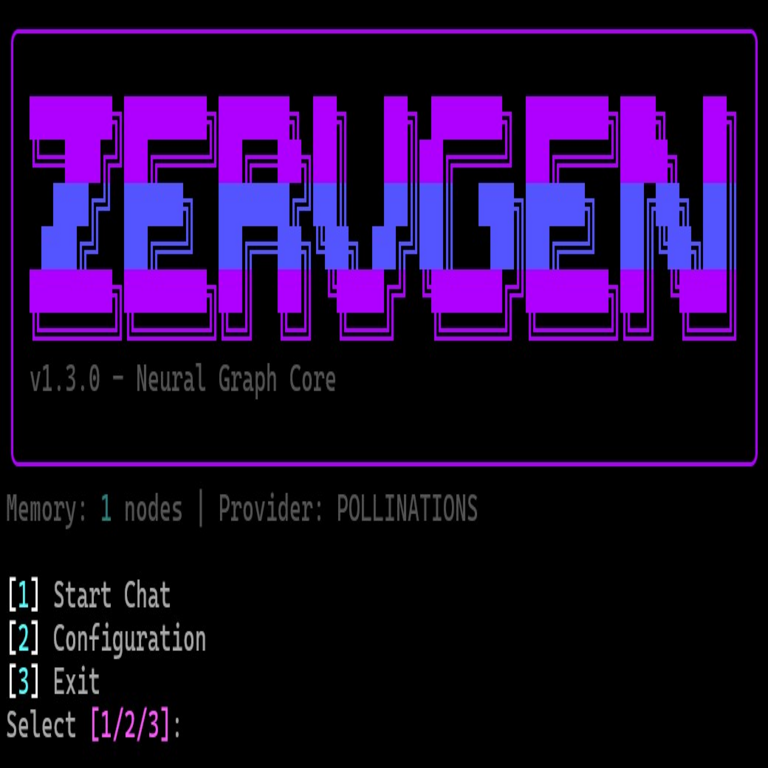

Además, la IA generativa acelera la creación de malware. Herramientas como WormGPT, versiones no reguladas de modelos de lenguaje, permiten a ciberdelincuentes generar código malicioso personalizado sin necesidad de expertise profundo en programación. Esto democratiza el acceso a amenazas avanzadas, como ransomware o exploits zero-day. Un informe de la Agencia de Ciberseguridad de la Unión Europea (ENISA) indica que el 40% de los ataques en 2023 involucraron elementos generados por IA, un incremento del 25% respecto al año anterior.

- Phishing avanzado: Mensajes hiperpersonalizados que superan filtros basados en reglas.

- Deepfakes: Contenido multimedia falso para manipulación social.

- Generación de malware: Código automatizado que adapta ataques a entornos específicos.

- Ataques a la cadena de suministro: Inyección de vulnerabilidades en software generado por IA.

En el ámbito latinoamericano, la brecha en regulaciones agrava estas amenazas. Países como Argentina y Colombia carecen de marcos legales específicos para IA, lo que permite la proliferación de herramientas generativas maliciosas en mercados informales.

Oportunidades para Fortalecer la Ciberseguridad con IA Generativa

A pesar de los riesgos, la IA generativa ofrece oportunidades valiosas para mejorar las capacidades defensivas en ciberseguridad. Una aplicación clave es la simulación de ataques, donde modelos generativos crean escenarios hipotéticos para entrenar sistemas de detección. Por instancia, herramientas como GAN (Generative Adversarial Networks) generan datos sintéticos de intrusiones, permitiendo a las organizaciones probar sus firewalls y SIEM (Security Information and Event Management) sin exponerse a riesgos reales.

En la detección de anomalías, la IA generativa analiza patrones de tráfico de red para identificar comportamientos inusuales. Un ejemplo es el uso de modelos autoregresivos para predecir secuencias normales de datos y alertar sobre desviaciones, reduciendo falsos positivos en un 60%, según investigaciones de MITRE. En Latinoamérica, empresas como Nubank en Brasil han implementado estas tecnologías para monitorear transacciones en tiempo real, previniendo fraudes con mayor precisión.

Otra oportunidad radica en la automatización de respuestas a incidentes. La IA generativa puede generar playbooks personalizados para mitigar amenazas, como scripts para aislar redes infectadas o informes automáticos para equipos de respuesta. Esto es particularmente útil en regiones con escasez de talento cibernético, donde el 80% de las firmas en Centroamérica reportan dificultades para reclutar expertos, de acuerdo con datos de Kaspersky.

- Simulación de amenazas: Entrenamiento con datos sintéticos para mejorar resiliencia.

- Detección proactiva: Análisis predictivo de vulnerabilidades emergentes.

- Automatización de respuestas: Generación de estrategias de mitigación en tiempo real.

- Análisis forense: Reconstrucción de incidentes mediante narrativas generadas.

La integración de blockchain con IA generativa añade una capa de seguridad, asegurando la integridad de los modelos mediante registros inmutables de entrenamiento y despliegue, lo que previene manipulaciones en entornos distribuidos.

Desafíos Éticos y Regulatorios en la Implementación

La adopción de IA generativa en ciberseguridad plantea desafíos éticos, como el sesgo en los modelos entrenados con datos no representativos, que podría llevar a discriminaciones en la detección de amenazas. En Latinoamérica, donde los datasets a menudo reflejan desigualdades socioeconómicas, es crucial auditar algoritmos para garantizar equidad. Además, la privacidad de datos es un concern, ya que el entrenamiento de modelos requiere grandes volúmenes de información sensible, potencialmente violando regulaciones como la LGPD en Brasil o la Ley de Protección de Datos en México.

Desde el punto de vista regulatorio, la falta de estándares globales complica la implementación. Iniciativas como el AI Act de la Unión Europea podrían servir de modelo, pero en la región, esfuerzos como el Marco de IA de Chile representan pasos iniciales. Las organizaciones deben adoptar prácticas de gobernanza, incluyendo revisiones éticas y transparencia en el uso de IA.

Para mitigar estos desafíos, se recomienda el uso de técnicas de federated learning, donde los modelos se entrenan de manera descentralizada sin compartir datos crudos, preservando la privacidad mientras se aprovechan beneficios colectivos.

Casos de Estudio en Latinoamérica

En Brasil, el Banco Central ha explorado IA generativa para simular ciberataques a infraestructuras financieras, mejorando la preparación nacional contra amenazas como el DDoS generado por bots impulsados por IA. Un caso específico involucró la generación de 10,000 variantes de payloads maliciosos para entrenar sistemas de defensa, resultando en una reducción del 45% en tiempos de respuesta.

En México, la empresa de telecomunicaciones Telcel utilizó modelos generativos para analizar logs de red y predecir brechas de seguridad. Este enfoque permitió identificar patrones de insider threats que métodos tradicionales pasaban por alto, salvando potenciales pérdidas de 50 millones de pesos en un incidente de 2023.

Colombia presenta un ejemplo de colaboración regional: el Centro Nacional de Ciberseguridad integró IA generativa en su plataforma de monitoreo, generando reportes automáticos sobre tendencias de phishing en español y portugués, adaptados a dialectos locales. Esto ha elevado la efectividad de campañas de concienciación en un 35%.

Estos casos ilustran cómo la IA generativa, cuando se implementa con precaución, puede adaptarse a contextos locales, considerando factores como la diversidad lingüística y las infraestructuras variables en la región.

Mejores Prácticas para la Integración Segura

Para maximizar las oportunidades y minimizar amenazas, las organizaciones deben seguir mejores prácticas. Primero, realizar evaluaciones de riesgo exhaustivas antes de desplegar modelos generativos, identificando vulnerabilidades en el pipeline de entrenamiento. Segundo, implementar controles de acceso estrictos, como autenticación multifactor para APIs de IA, previniendo abusos.

Tercero, invertir en educación continua para equipos de ciberseguridad, cubriendo temas como prompt engineering para defensas y reconocimiento de contenido generado. En Latinoamérica, programas como los ofrecidos por la OEA (Organización de Estados Americanos) pueden apoyar esta capacitación.

Cuarto, colaborar con ecosistemas abiertos para compartir inteligencia de amenazas generadas por IA, utilizando plataformas seguras como ISACs (Information Sharing and Analysis Centers). Finalmente, monitorear continuamente el rendimiento de los modelos, actualizándolos contra evoluciones adversarias.

- Evaluación inicial: Análisis de impacto en privacidad y seguridad.

- Controles técnicos: Encriptación de datos y auditorías regulares.

- Capacitación: Programas adaptados a contextos regionales.

- Monitoreo: Métricas de precisión y falsos positivos.

Perspectivas Futuras y Recomendaciones

El futuro de la IA generativa en ciberseguridad apunta hacia híbridos con tecnologías como quantum computing para encriptación post-cuántica y blockchain para verificación de integridad. En Latinoamérica, se espera un crecimiento del 25% anual en adopción de IA para seguridad, impulsado por inversiones en innovación digital.

Recomendaciones clave incluyen la adopción de marcos éticos regionales y la inversión en investigación local para datasets inclusivos. Las empresas deben priorizar la resiliencia, integrando IA generativa como un pilar estratégico en sus arquitecturas de ciberseguridad.

En resumen, aunque la IA generativa introduce complejidades, su potencial para transformar la ciberseguridad es innegable. Con enfoques equilibrados, puede convertirse en un aliado poderoso contra amenazas emergentes, fomentando un ecosistema digital más seguro en la región.

Para más información visita la Fuente original.