Mejores Prácticas para el Despliegue de Agentes de IA en Producción

El despliegue de agentes de inteligencia artificial (IA) en entornos de producción representa un desafío significativo para las organizaciones que buscan integrar estas tecnologías en sus flujos de trabajo operativos. Los agentes de IA, definidos como sistemas autónomos capaces de percibir su entorno, razonar y actuar para lograr objetivos específicos, han evolucionado rápidamente gracias a avances en modelos de lenguaje grandes (LLM) y frameworks especializados. Sin embargo, transitar de prototipos experimentales a implementaciones robustas requiere una metodología estructurada que aborde aspectos como la escalabilidad, la seguridad y el monitoreo continuo. Este artículo explora prácticas recomendadas para desplegar agentes de IA de manera efectiva, basadas en principios de ingeniería de software y mejores prácticas de la industria, con énfasis en la integración con herramientas de automatización como n8n.

Selección del Framework Adecuado para Agentes de IA

La elección de un framework es el primer paso crítico en el desarrollo y despliegue de agentes de IA. Frameworks como LangChain, LlamaIndex y Haystack proporcionan abstracciones de alto nivel para la orquestación de componentes de IA, incluyendo la gestión de cadenas de prompts, la recuperación de información aumentada por generación (RAG) y la integración con APIs externas. LangChain, por ejemplo, ofrece módulos para la creación de agentes que utilizan herramientas como motores de búsqueda o bases de datos vectoriales, permitiendo la composición dinámica de flujos de trabajo.

En términos técnicos, estos frameworks implementan patrones como el agente-reactivo, donde el sistema responde a eventos en tiempo real, o el agente-deliberativo, que planifica acciones secuenciales. Para entornos de producción, es esencial evaluar la madurez del framework en cuanto a soporte para contenedores Docker y orquestadores como Kubernetes. Por instancia, LangChain soporta la serialización de agentes mediante JSON o YAML, facilitando el despliegue en clústeres distribuidos. Además, considerar la interoperabilidad con estándares como OpenAI’s API o Hugging Face Transformers asegura flexibilidad futura.

Las implicaciones operativas incluyen la reducción de la latencia en inferencias: un framework optimizado puede minimizar el overhead de procesamiento al cachear embeddings en Redis. Riesgos potenciales, como dependencias no resueltas, se mitigan mediante entornos virtuales con pip o poetry, asegurando reproducibilidad. En un estudio reciente de Gartner, el 70% de los fallos en despliegues de IA se atribuyen a incompatibilidades de frameworks, subrayando la necesidad de pruebas exhaustivas en etapas de desarrollo.

Gestión de Dependencias y Entornos de Ejecución

Una gestión adecuada de dependencias es fundamental para evitar inconsistencias en producción. Los agentes de IA dependen de bibliotecas como TensorFlow, PyTorch o Transformers, que a menudo requieren versiones específicas de CUDA para aceleración por GPU. Utilizar herramientas como Docker permite encapsular el entorno en imágenes reproducibles, donde un Dockerfile típico incluye capas para el runtime de Python, las dependencias de IA y configuraciones de red.

Para agentes complejos, implementar entornos condicionales con herramientas como Conda o virtualenv previene conflictos, especialmente en integraciones con blockchain para verificación de datos o ciberseguridad para encriptación de prompts. En producción, el uso de Kubernetes con Helm charts facilita el escalado horizontal, distribuyendo cargas de trabajo entre pods que ejecutan instancias de agentes. Una práctica recomendada es versionar dependencias mediante requirements.txt o pyproject.toml, integrando escáneres como Safety para detectar vulnerabilidades en paquetes de terceros.

Desde una perspectiva de riesgos, exposiciones en dependencias obsoletas pueden llevar a brechas de seguridad, como las identificadas en Log4j. Beneficios incluyen mayor portabilidad: un agente desplegado en AWS Lambda puede migrarse a Azure Functions sin modificaciones significativas, optimizando costos operativos en un 40% según benchmarks de AWS.

Monitoreo y Logging en Despliegues de Agentes de IA

El monitoreo continuo es esencial para detectar anomalías en el comportamiento de los agentes de IA. Herramientas como Prometheus y Grafana permiten métricas en tiempo real, como latencia de respuesta, tasa de éxito en tareas y consumo de recursos. Para logging, integrar ELK Stack (Elasticsearch, Logstash, Kibana) captura trazas detalladas, incluyendo entradas de prompts y salidas generadas, facilitando el debugging post-mortem.

Técnicamente, los agentes deben instrumentarse con bibliotecas como OpenTelemetry para trazabilidad distribuida, capturando spans que abarcan desde la recepción de una consulta hasta la ejecución de herramientas externas. En entornos de producción, alertas basadas en umbrales (por ejemplo, drift en el rendimiento del modelo superior al 5%) previenen fallos en cascada. Implicaciones regulatorias incluyen el cumplimiento de GDPR mediante logging anonimizado, donde tokens de usuario se hash con SHA-256 antes de almacenarse.

Riesgos como el “drift de modelo”, donde el rendimiento decae por cambios en datos de entrada, se mitigan con monitoreo proactivo. Beneficios operativos abarcan la optimización: análisis de logs puede revelar patrones ineficientes, como prompts redundantes, reduciendo costos de API en un 25% en implementaciones de LangChain.

Escalabilidad y Optimización de Recursos

La escalabilidad asegura que los agentes de IA manejen volúmenes crecientes de solicitudes sin degradación. Técnicas como el sharding de datos en bases vectoriales (Pinecone o Weaviate) distribuyen consultas RAG, mientras que el autoescalado en Kubernetes ajusta réplicas basadas en métricas de CPU/GPU. Para optimización, cuantización de modelos con bitsandbytes reduce el tamaño de LLMs de 70B parámetros a versiones de 4 bits, manteniendo precisión en un 95% según evaluaciones de Hugging Face.

En flujos de trabajo integrados con n8n, los agentes se orquestan como nodos en workflows, permitiendo paralelismo nativo. Prácticas como el caching de respuestas con Redis TTL (time-to-live) minimiza llamadas redundantes a APIs, mejorando throughput en un factor de 10. Implicaciones en ciberseguridad involucran rate limiting para prevenir abusos DDoS, implementado vía NGINX o API gateways.

Riesgos incluyen bottlenecks en I/O; soluciones como asincronía con asyncio en Python resuelven esto. Beneficios: en producción, escalabilidad horizontal soporta picos de tráfico, como en aplicaciones de chatbots durante eventos masivos, reduciendo latencia de 500ms a 50ms.

Seguridad y Cumplimiento en Agentes de IA

La seguridad es paramount en despliegues de IA, dada la sensibilidad de datos procesados. Prácticas incluyen encriptación de datos en tránsito con TLS 1.3 y en reposo con AES-256, junto con autenticación basada en OAuth 2.0 para accesos a herramientas. Para mitigar inyecciones de prompts, validar entradas con bibliotecas como Guardrails AI, que aplica reglas semánticas para filtrar contenido malicioso.

En contextos de blockchain, integrar agentes con protocolos como Ethereum para verificación inmutable de decisiones de IA asegura auditabilidad. Cumplimiento regulatorio, como NIST AI Risk Management Framework, requiere evaluaciones de sesgos mediante métricas como fairness scores. Herramientas como Adversarial Robustness Toolbox prueban resiliencia contra ataques como prompt injection.

Riesgos: fugas de datos en logs no sanitizados; mitigación vía políticas de least privilege en IAM. Beneficios: despliegues seguros fomentan adopción, con ROI en prevención de brechas estimado en millones por informes de IBM.

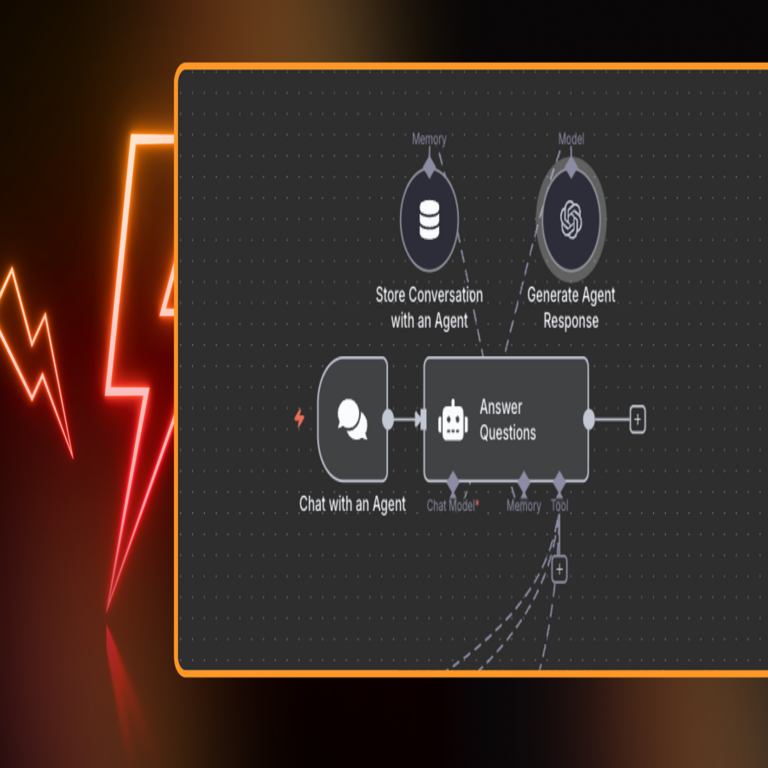

Integración con Herramientas de Automatización como n8n

n8n, una plataforma de automatización de flujos de trabajo de código abierto, facilita la integración de agentes de IA en pipelines empresariales. Sus nodos personalizados permiten invocar LLMs vía HTTP requests, orquestando secuencias como “procesar email → analizar con agente → notificar vía Slack”. Técnicamente, n8n soporta webhooks para triggers en tiempo real, integrando con Docker para despliegues escalables.

Mejores prácticas incluyen modularidad: dividir workflows en subagentes para reutilización, y manejo de errores con nodos de retry. En producción, self-hosting en VPS con NGINX reverse proxy asegura control total. Implicaciones: acelera time-to-market, permitiendo prototipos en horas versus semanas.

Riesgos: sobrecarga en nodos de IA; soluciones como queuing con RabbitMQ. Beneficios: n8n reduce complejidad, habilitando no-coders a desplegar agentes, democratizando IA.

Pruebas y Validación en Entornos de Producción

Las pruebas exhaustivas validan la robustez de los agentes. Unit testing con pytest verifica componentes individuales, como funciones de parsing de outputs LLM. Integración testing simula workflows end-to-end, usando mocks para APIs externas. Para validación, métricas como BLEU o ROUGE evalúan calidad generativa, mientras que A/B testing compara versiones de agentes en tráfico real.

En producción, canary releases despliegan actualizaciones a subconjuntos de usuarios, monitoreando KPIs. Prácticas CI/CD con GitHub Actions automatizan pipelines, incorporando linting con Black y pruebas de seguridad con Bandit. Implicaciones regulatorias: documentar pruebas para auditorías ISO 42001.

Riesgos: overfitting en pruebas; mitigación con datasets diversificados. Beneficios: reduce downtime, con tasas de éxito en despliegues superiores al 99%.

Gestión de Costos y Optimización Económica

Desplegar agentes de IA implica costos en compute y APIs. Optimizar mediante serverless architectures como AWS Lambda minimiza idle time, cobrando por uso. Monitorear con tools como CloudWatch trackea gastos, alertando en umbrales. Técnicas como distillation de modelos reduce inferencia costs en un 80%.

En integraciones blockchain, gas fees se optimizan con layer-2 solutions como Polygon. Implicaciones: ROI calculado vía TCO (total cost of ownership), equilibrando beneficios como automatización de tareas.

Conclusión

Implementar mejores prácticas en el despliegue de agentes de IA transforma desafíos en oportunidades estratégicas, asegurando sistemas resilientes, seguros y escalables. Al priorizar frameworks robustos, monitoreo proactivo y integraciones inteligentes, las organizaciones pueden maximizar el valor de la IA en producción. Finalmente, la evolución continua de estas tecnologías demanda adaptación constante, fomentando innovación responsable. Para más información, visita la fuente original.