Transformando la conciencia de riesgos en IA hacia una gobernanza robusta

La evolución de los riesgos en inteligencia artificial

La inteligencia artificial (IA) ha experimentado un crecimiento exponencial en los últimos años, integrándose en diversos sectores como la ciberseguridad, la salud y las finanzas. Sin embargo, este avance conlleva riesgos significativos que van desde sesgos algorítmicos hasta vulnerabilidades en la cadena de suministro de datos. La conciencia de estos riesgos es el primer paso esencial, pero para mitigarlos efectivamente, las organizaciones deben evolucionar hacia marcos de gobernanza robustos. En el contexto de la ciberseguridad, la IA no solo representa una herramienta defensiva, sino también un vector potencial de amenazas si no se gestiona adecuadamente.

Los riesgos asociados con la IA incluyen la exposición a ataques adversarios, donde los modelos de machine learning se manipulan mediante entradas maliciosas para generar salidas erróneas. Además, la dependencia de datos no auditados puede perpetuar discriminaciones inherentes, afectando la equidad en decisiones automatizadas. Según análisis recientes, el 70% de las empresas que implementan IA enfrentan desafíos en la identificación temprana de estos riesgos, lo que subraya la necesidad de transitar de una mera conciencia reactiva a una gobernanza proactiva.

Componentes clave de una gobernanza efectiva de IA

Una gobernanza robusta de IA se basa en pilares fundamentales que integran políticas, procesos y tecnologías para supervisar el ciclo de vida completo de los sistemas de IA. En primer lugar, se requiere la definición de políticas claras que alineen el uso de IA con los objetivos estratégicos de la organización, asegurando el cumplimiento de regulaciones como el Reglamento General de Protección de Datos (RGPD) en Europa o normativas locales en América Latina.

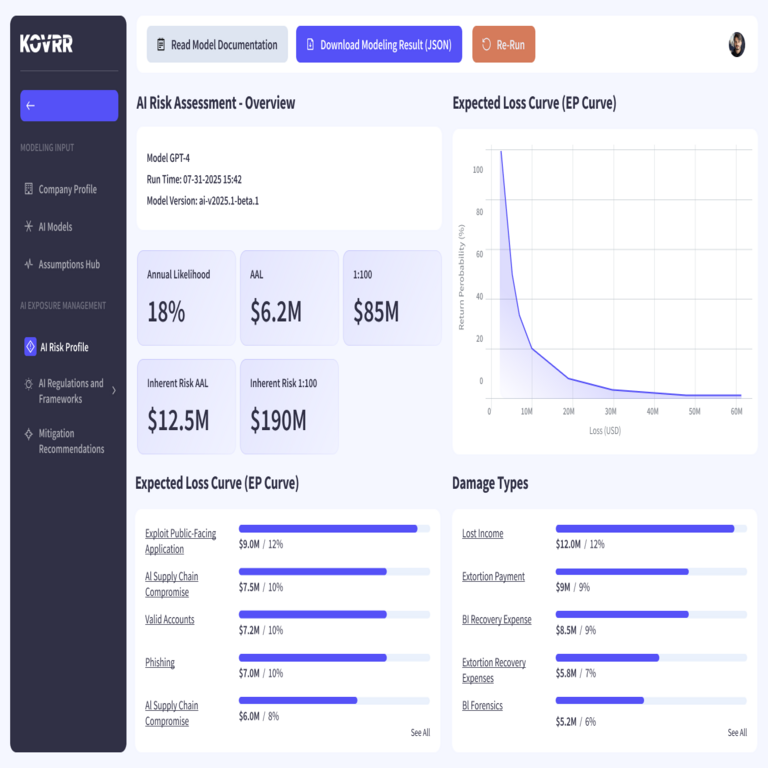

- Evaluación de riesgos continua: Implementar herramientas de modelado de riesgos que cuantifiquen impactos potenciales, como la pérdida financiera por brechas de seguridad o daños reputacionales.

- Transparencia y explicabilidad: Adoptar técnicas como el aprendizaje explicable (XAI) para que los modelos de IA sean auditables, permitiendo rastrear decisiones y detectar anomalías en tiempo real.

- Gestión de la cadena de suministro: Verificar la integridad de los datos y algoritmos de terceros, minimizando riesgos de inyección de código malicioso o datos envenenados.

En el ámbito de la ciberseguridad, estas componentes se fortalecen mediante la integración de IA con sistemas de detección de intrusiones basados en aprendizaje profundo, que analizan patrones de tráfico de red para identificar amenazas emergentes. La gobernanza debe incluir protocolos de respuesta a incidentes específicos para IA, como la cuarentena automática de modelos comprometidos.

Desafíos en la implementación de marcos de gobernanza

A pesar de los beneficios evidentes, la adopción de una gobernanza robusta enfrenta obstáculos significativos. Uno de los principales es la falta de talento especializado; muchas organizaciones en América Latina carecen de expertos en ética de IA y ciberseguridad integrada, lo que retrasa la madurez de sus programas. Otro desafío radica en la complejidad técnica de los modelos de IA, donde la opacidad inherente complica la auditoría y el cumplimiento normativo.

Además, las consideraciones éticas agregan capas de complejidad, ya que la IA debe equilibrar eficiencia con responsabilidad social. Por ejemplo, en aplicaciones de vigilancia, el uso de IA para reconocimiento facial plantea dilemas sobre privacidad y sesgos raciales, requiriendo marcos que incorporen revisiones éticas multidisciplinarias. Para superar estos retos, se recomienda la colaboración con entidades reguladoras y el uso de estándares internacionales como los propuestos por el NIST (Instituto Nacional de Estándares y Tecnología) adaptados al contexto local.

Estrategias prácticas para fortalecer la gobernanza de IA

Para transformar la conciencia de riesgos en acciones concretas, las organizaciones pueden adoptar estrategias escalables. Inicialmente, realizar auditorías iniciales de madurez en IA que evalúen el estado actual de los sistemas y identifiquen brechas críticas. Posteriormente, implementar plataformas de gobernanza automatizadas que monitoreen métricas clave, como la precisión de los modelos y la tasa de falsos positivos en detección de amenazas cibernéticas.

- Entrenamiento y capacitación: Desarrollar programas internos para capacitar a equipos en riesgos de IA, enfatizando escenarios reales como ataques de envenenamiento de datos.

- Integración con blockchain: Utilizar tecnologías de blockchain para asegurar la trazabilidad de datos en IA, creando registros inmutables que faciliten auditorías y verifiquen la integridad de los modelos.

- Medición de ROI en gobernanza: Cuantificar el retorno de inversión mediante simulaciones de riesgos que demuestren reducciones en pérdidas potenciales, incentivando la adopción ejecutiva.

En el panorama de la ciberseguridad, estas estrategias permiten una defensa proactiva, donde la IA no solo detecta amenazas, sino que también se autogobierna para prevenir vulnerabilidades internas. Ejemplos incluyen el despliegue de federated learning, que entrena modelos sin compartir datos sensibles, reduciendo riesgos de exposición.

Perspectivas futuras y recomendaciones

El panorama de la IA evoluciona rápidamente, con avances en IA generativa que amplifican tanto oportunidades como riesgos. Hacia el futuro, se espera una mayor estandarización global en gobernanza, impulsada por marcos como el AI Act de la Unión Europea, que influenciarán prácticas en América Latina. Las organizaciones deben priorizar la resiliencia, invirtiendo en herramientas que integren IA con ciberseguridad cuántica para anticipar amenazas emergentes.

En resumen, la transición de la conciencia de riesgos a una gobernanza robusta requiere un enfoque holístico que combine tecnología, políticas y cultura organizacional. Al implementar estas medidas, las entidades no solo mitigan peligros, sino que también capitalizan el potencial transformador de la IA de manera sostenible.

Para más información visita la Fuente original.