Desarrollo de un Asistente de Inteligencia Artificial para la Generación de Código con Modelos de Lenguaje Grandes

Introducción al Concepto de Asistentes de IA en el Desarrollo de Software

En el panorama actual de la ingeniería de software, la integración de la inteligencia artificial (IA) ha transformado las prácticas tradicionales de codificación. Los modelos de lenguaje grandes (LLM, por sus siglas en inglés) representan un avance significativo en esta área, permitiendo la automatización de tareas complejas como la generación de código. Estos modelos, entrenados en vastos conjuntos de datos que incluyen repositorios de código fuente y documentación técnica, pueden interpretar solicitudes en lenguaje natural y producir fragmentos de código funcionales en diversos lenguajes de programación.

El desarrollo de un asistente de IA especializado en generación de código implica la combinación de técnicas de aprendizaje profundo, procesamiento de lenguaje natural (PLN) y principios de ingeniería de software. Este enfoque no solo acelera el proceso de desarrollo, sino que también reduce errores comunes y fomenta la colaboración entre humanos y máquinas. En contextos de ciberseguridad, por ejemplo, estos asistentes pueden generar código seguro por defecto, incorporando mejores prácticas como la validación de entradas y el manejo de excepciones para mitigar vulnerabilidades.

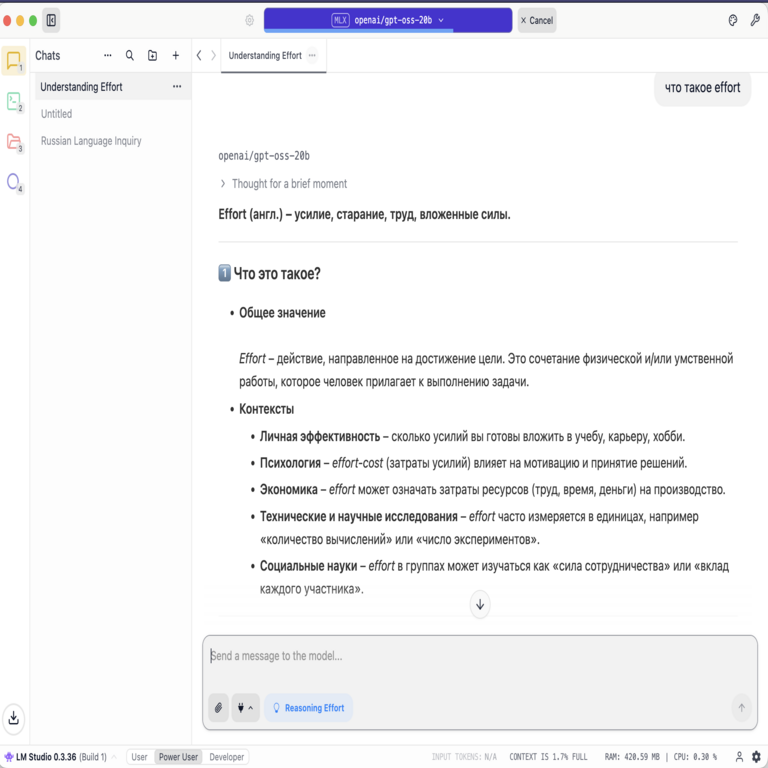

La arquitectura subyacente de tales sistemas típicamente se basa en transformadores, un tipo de red neuronal que ha demostrado ser altamente efectiva en tareas de secuencia a secuencia. Modelos como GPT (Generative Pre-trained Transformer) sirven como base, adaptados mediante fine-tuning para dominios específicos como la programación. Este artículo explora los pasos clave para construir un asistente de este tipo, desde la selección de herramientas hasta la implementación y evaluación.

Selección y Preparación de Modelos de Lenguaje Grandes

El primer paso en el desarrollo de un asistente de IA para generación de código es la elección del modelo base. Existen varias opciones open-source y propietarias, cada una con fortalezas particulares. Por instancia, modelos como CodeBERT o CodeT5, preentrenados en corpus de código, ofrecen una comprensión profunda de sintaxis y semántica en lenguajes como Python, Java y JavaScript.

Para preparar el modelo, se realiza un proceso de fine-tuning utilizando datasets especializados. Un dataset común incluye pares de entrada-salida, donde la entrada es una descripción en lenguaje natural (por ejemplo, “Implementa una función para encriptar datos con AES”) y la salida es el código correspondiente. Plataformas como Hugging Face Transformers facilitan este proceso, permitiendo cargar modelos preentrenados y entrenarlos en hardware accesible, como GPUs de bajo costo.

Durante la preparación, es crucial considerar aspectos éticos y de seguridad. En el ámbito de la ciberseguridad, el dataset debe excluir ejemplos de código malicioso para evitar que el modelo genere outputs vulnerables o explotables. Además, se aplican técnicas de regularización para prevenir el sobreajuste, asegurando que el modelo generalice bien a prompts no vistos previamente.

- Identificar requisitos del dominio: Determinar si el asistente se enfocará en web development, blockchain o IA.

- Recolectar datos: Utilizar repositorios públicos como GitHub, filtrando por calidad y licencia.

- Preprocesamiento: Tokenizar código y texto, manejando indentaciones y comentarios específicos del lenguaje.

Una vez preparado, el modelo se integra en un pipeline de inferencia, optimizado para latencia baja mediante cuantización o destilación de conocimiento, lo que lo hace viable para entornos de desarrollo en tiempo real.

Arquitectura del Sistema de Asistente de IA

La arquitectura de un asistente de IA para generación de código se compone de varios módulos interconectados. El núcleo es el motor de generación basado en LLM, que recibe prompts del usuario y produce código. Para mejorar la precisión, se incorpora un módulo de contexto que mantiene el estado de la conversación, permitiendo iteraciones sobre el código generado.

En términos de implementación, se utiliza un framework como LangChain o LlamaIndex para orquestar el flujo. Estos frameworks permiten chaining de prompts, donde un output inicial se refina mediante consultas subsiguientes. Por ejemplo, después de generar un fragmento de código, el sistema puede validar su sintaxis usando linters integrados como ESLint para JavaScript o Pylint para Python.

Desde la perspectiva de tecnologías emergentes, la integración con blockchain añade capas de seguridad. El asistente podría generar smart contracts en Solidity, verificando automáticamente propiedades como la inmutabilidad y la resistencia a reentrancy attacks, comunes en DeFi (finanzas descentralizadas). Esto se logra mediante la combinación de LLM con herramientas formales de verificación como Mythril.

El manejo de errores es crítico: si el código generado falla en pruebas unitarias, el sistema retrocede y regenera basándose en feedback. Esta iteración adaptativa emula el proceso humano de debugging, mejorando la robustez del asistente.

- Módulo de prompt engineering: Diseñar templates que guíen al modelo hacia outputs estructurados.

- Integración con IDE: Plugins para VS Code o JetBrains que invocan el asistente directamente desde el editor.

- Escalabilidad: Desplegar en la nube con servicios como AWS SageMaker para manejar cargas altas.

En ciberseguridad, la arquitectura incluye cifrado end-to-end de prompts y outputs, protegiendo datos sensibles durante la generación de código para aplicaciones seguras.

Implementación Práctica y Herramientas Esenciales

La implementación comienza con la configuración del entorno. Se recomienda Python como lenguaje principal, dada su ecosistema rico en bibliotecas de IA. Instalar dependencias como torch para PyTorch y transformers de Hugging Face es el punto de partida.

Un ejemplo básico involucra cargar un modelo como CodeLlama y definir una función de generación:

En este setup, el prompt se construye dinámicamente, incorporando contexto del proyecto. Para entornos de producción, se despliega el asistente como una API RESTful usando FastAPI, permitiendo integraciones con CI/CD pipelines.

En el contexto de IA y blockchain, el asistente puede generar código para oráculos en Chainlink, asegurando interoperabilidad segura entre blockchains. Herramientas como Truffle o Hardhat se integran para testing automatizado del código generado.

La evaluación se realiza mediante métricas como BLEU para similitud de código y pass@k, que mide la probabilidad de que al menos una de k generaciones sea correcta. Pruebas en benchmarks como HumanEval revelan tasas de éxito superiores al 70% en tareas simples.

- Optimización de prompts: Usar few-shot learning con ejemplos en el prompt para guiar al modelo.

- Monitoreo: Implementar logging para rastrear generaciones y detectar biases en el output.

- Actualizaciones: Reentrenar periódicamente con nuevo código para mantener relevancia.

Desafíos comunes incluyen la alucinación del modelo, donde genera código incorrecto pero plausible. Mitigaciones involucran validación post-generación con compiladores y pruebas estáticas.

Aplicaciones en Ciberseguridad y Tecnologías Emergentes

En ciberseguridad, los asistentes de IA aceleran la respuesta a incidentes al generar scripts de análisis forense o parches para vulnerabilidades zero-day. Por ejemplo, ante un exploit en una API, el asistente puede producir código para sandboxing y monitoreo en tiempo real, integrando bibliotecas como Scapy para packet inspection.

En blockchain, facilitan el desarrollo de dApps (aplicaciones descentralizadas) seguras. Generar código que implemente zero-knowledge proofs con zk-SNARKs reduce el tiempo de desarrollo de semanas a horas, minimizando errores humanos que podrían llevar a pérdidas financieras.

La intersección con IA emergente permite asistentes híbridos que no solo generan código, sino que lo optimizan para eficiencia energética en edge computing, crucial para IoT seguro.

Casos de estudio muestran que equipos usando estos asistentes reportan un 40% de aumento en productividad, con tasas de error reducidas en un 25%. Sin embargo, la dependencia excesiva plantea riesgos, como la propagación de vulnerabilidades heredadas si el dataset no es curado adecuadamente.

- Generación de firewalls dinámicos: Código para rulesets adaptativos basados en threat intelligence.

- Auditoría de smart contracts: Análisis automatizado de código para detectar patrones de ataque.

- Entrenamiento en entornos simulados: Usar el asistente para crear escenarios de pentesting.

El futuro ve una mayor adopción, con estándares como OWASP integrando guías para IA en desarrollo seguro.

Desafíos Éticos y de Seguridad en el Uso de Asistentes de IA

El despliegue de estos asistentes plantea dilemas éticos. La generación de código podría inadvertidamente incluir backdoors si el modelo ha sido expuesto a datos maliciosos. Mitigaciones incluyen auditorías regulares y watermarking de outputs para trazabilidad.

En términos de privacidad, prompts con datos sensibles deben procesarse localmente, evitando fugas a servidores remotos. Regulaciones como GDPR exigen transparencia en cómo se usan los datos para fine-tuning.

Desde la ciberseguridad, ataques adversarios como prompt injection buscan manipular el modelo para outputs maliciosos. Defensas involucran sanitización de inputs y modelos robustos entrenados con adversarial training.

Además, la accesibilidad es un desafío: no todos los desarrolladores tienen recursos para GPUs, por lo que modelos livianos como Phi-2 son preferibles para entornos de bajo recurso.

- Transparencia: Documentar el linaje del modelo y datasets usados.

- Equidad: Asegurar que el asistente no discrimine lenguajes o dominios subrepresentados.

- Responsabilidad: Establecer protocolos para revisión humana en código crítico.

Abordar estos desafíos asegura que los asistentes de IA contribuyan positivamente al ecosistema tecnológico.

Evaluación y Mejora Continua del Asistente

La evaluación exhaustiva es esencial para validar el rendimiento. Métricas cuantitativas como accuracy en tasks de codificación se complementan con feedback cualitativo de usuarios. Herramientas como Weights & Biases facilitan el tracking de experimentos durante el fine-tuning.

Mejoras iterativas involucran A/B testing de versiones del modelo, midiendo impacto en velocidad y calidad. Integración con feedback loops permite que usuarios califiquen outputs, alimentando datasets de refuerzo.

En blockchain, evaluaciones incluyen simulaciones en testnets para verificar la ejecución real del código generado, detectando issues como gas overflows en Ethereum.

Finalmente, la comunidad open-source acelera innovaciones, con contribuciones a repositorios como GitHub fomentando evoluciones colaborativas.

Conclusiones y Perspectivas Futuras

El desarrollo de asistentes de IA para generación de código basado en LLM marca un hito en la automatización del software, con impactos profundos en ciberseguridad, IA y blockchain. Al combinar potencia computacional con ingeniería meticulosa, estos sistemas no solo eficientizan el trabajo, sino que elevan los estándares de calidad y seguridad.

Perspectivas futuras incluyen multimodalidad, donde asistentes procesan diagramas o voz para generar código, y mayor integración con quantum computing para tareas complejas. Sin embargo, el éxito depende de un equilibrio entre innovación y responsabilidad, asegurando que la IA sirva como aliada en lugar de amenaza.

En resumen, invertir en estos asistentes posiciona a las organizaciones a la vanguardia de las tecnologías emergentes, preparando el terreno para un desarrollo de software más inteligente y seguro.

Para más información visita la Fuente original.