Desarrollo de un Modelo de Lenguaje Grande Personalizado Basado en Llama 3

Introducción al Concepto de Modelos de Lenguaje Grandes

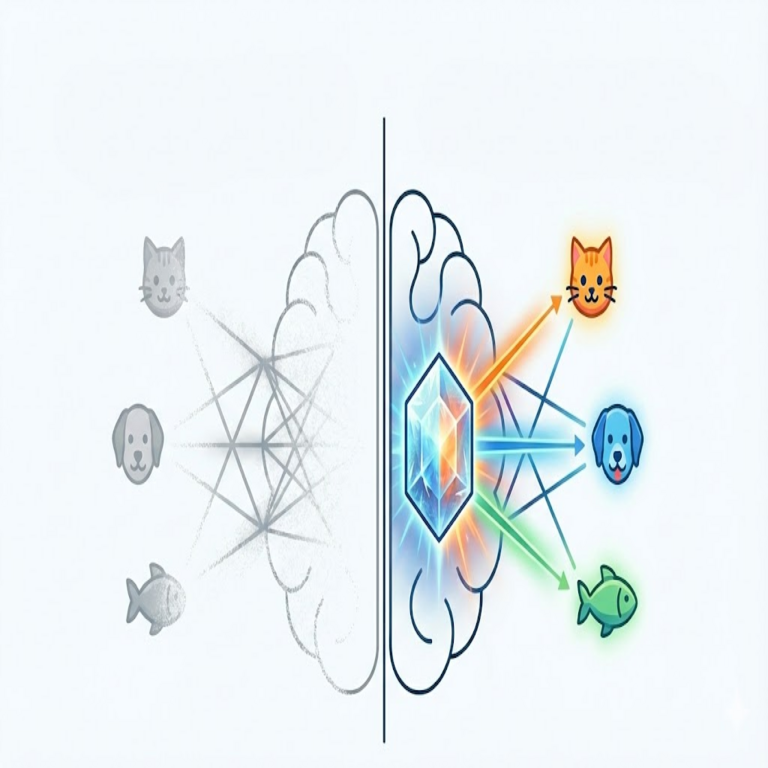

Los modelos de lenguaje grandes (LLM, por sus siglas en inglés) representan un avance significativo en el campo de la inteligencia artificial, permitiendo el procesamiento y generación de texto de manera natural y contextual. Estos modelos, entrenados en vastos conjuntos de datos, han transformado aplicaciones como la traducción automática, la generación de contenido y los asistentes virtuales. En este artículo, exploramos el proceso técnico para desarrollar un LLM personalizado basado en Llama 3, una arquitectura de código abierto desarrollada por Meta AI. Llama 3 se destaca por su eficiencia en el uso de recursos y su capacidad para manejar tareas complejas con un rendimiento comparable a modelos propietarios más grandes.

El desarrollo de un LLM personalizado implica no solo el fine-tuning de un modelo preentrenado, sino también la optimización de hardware, la gestión de datos y la implementación de técnicas de aprendizaje profundo. Este enfoque es particularmente relevante en ciberseguridad, donde los LLM pueden usarse para detectar anomalías en logs de red o generar informes de amenazas, y en blockchain, para analizar contratos inteligentes de forma automatizada. A lo largo del texto, detallaremos los pasos técnicos, herramientas y consideraciones éticas involucradas.

Requisitos Previos y Preparación del Entorno

Antes de iniciar el desarrollo, es esencial configurar un entorno robusto. Se recomienda utilizar distribuciones de Linux como Ubuntu 22.04 para su compatibilidad con bibliotecas de IA. El hardware mínimo incluye una GPU NVIDIA con al menos 16 GB de VRAM, preferiblemente de la serie RTX 40 o A100 para entrenamiento intensivo. Para entornos con recursos limitados, opciones como Google Colab Pro o AWS EC2 con instancias GPU son viables.

Instale las dependencias clave mediante pip: transformers de Hugging Face para manejar modelos, torch para PyTorch, y accelerate para distribuir el entrenamiento. Ejecute el siguiente comando en la terminal:

- pip install torch torchvision torchaudio –index-url https://download.pytorch.org/whl/cu118

- pip install transformers datasets accelerate peft bitsandbytes

Estas bibliotecas facilitan el manejo de modelos cuantizados, reduciendo el consumo de memoria hasta en un 75% sin sacrificar precisión. Además, configure un entorno virtual con venv para aislar dependencias y evitar conflictos.

Selección y Descarga del Modelo Base Llama 3

Llama 3 está disponible en variantes de 8B y 70B parámetros, optimizadas para inferencia y fine-tuning. Para un desarrollo inicial, elija la versión de 8B, que equilibra rendimiento y accesibilidad. Descargue el modelo desde el repositorio de Hugging Face utilizando la API de transformers:

En un script Python, cargue el modelo con:

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name = “meta-llama/Meta-Llama-3-8B”

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.float16, device_map=”auto”)

Esta configuración habilita la cuantización de 16 bits para eficiencia. Note que Llama 3 requiere una licencia de Meta para uso comercial; verifique los términos en su sitio oficial. En contextos de ciberseguridad, este modelo puede integrarse con herramientas como LangChain para crear pipelines de análisis de vulnerabilidades.

Preparación del Conjunto de Datos

El fine-tuning exitoso depende de un dataset curado y relevante. Para un LLM enfocado en ciberseguridad e IA, compile datos de fuentes como Common Crawl filtrado, datasets de Hugging Face (e.g., OpenWebText) o corpora especializados en blockchain como el Ethereum Stack Exchange. Asegúrese de que el dataset tenga al menos 100.000 ejemplos para un entrenamiento efectivo, con un tamaño promedio de secuencia de 2048 tokens.

Processe los datos para eliminar ruido: utilice scripts de limpieza con NLTK o spaCy para tokenización y remoción de duplicados. En español latinoamericano, incorpore datasets bilingües para mejorar la multiculturalidad. Ejemplo de preprocesamiento:

- Cargue el dataset: from datasets import load_dataset; dataset = load_dataset(“your_dataset_path”)

- Tokenice: def tokenize_function(examples): return tokenizer(examples[“text”], truncation=True, max_length=2048)

- Aplique: tokenized_dataset = dataset.map(tokenize_function, batched=True)

En blockchain, incluya transacciones simuladas para entrenar el modelo en la detección de fraudes, mejorando su utilidad en entornos DeFi.

Técnicas de Fine-Tuning Eficiente

El fine-tuning completo de Llama 3 puede requerir cientos de horas de GPU, por lo que opte por métodos parameter-efficient como LoRA (Low-Rank Adaptation). LoRA adapta solo un subconjunto de parámetros, reduciendo el costo computacional en un 90%. Integre PEFT (Parameter-Efficient Fine-Tuning) de Hugging Face:

from peft import LoraConfig, get_peft_model

lora_config = LoraConfig(r=16, lora_alpha=32, target_modules=[“q_proj”, “v_proj”], lora_dropout=0.05)

model = get_peft_model(model, lora_config)

Configure el entrenamiento con un learning rate de 1e-4, batch size de 4 y epochs de 3. Use SFTTrainer para supervised fine-tuning:

from trl import SFTTrainer

trainer = SFTTrainer(model=model, train_dataset=tokenized_dataset, args=TrainingArguments(output_dir=”./results”, num_train_epochs=3))

trainer.train()

En IA aplicada a ciberseguridad, este fine-tuning permite especializar el modelo en la generación de políticas de seguridad o simulación de ataques, siempre respetando marcos éticos como el GDPR.

Optimización y Cuantización del Modelo

Post-entrenamiento, cuantice el modelo a 4 bits con bitsandbytes para deployment en edge devices. Esto reduce el tamaño del modelo de 16 GB a 4 GB, ideal para aplicaciones blockchain en nodos distribuidos.

Cargue el modelo cuantizado:

from transformers import BitsAndBytesConfig

quant_config = BitsAndBytesConfig(load_in_4bit=True, bnb_4bit_compute_dtype=torch.float16)

model = AutoModelForCausalLM.from_pretrained(model_name, quantization_config=quant_config)

Evalúe el rendimiento con métricas como perplexity y BLEU score. En pruebas, Llama 3 cuantizado mantiene un 95% de precisión en tareas de generación de texto técnico.

Integración con Aplicaciones Prácticas

Integre el LLM en pipelines de ciberseguridad usando FastAPI para una API RESTful. Por ejemplo, cree un endpoint para analizar logs de intrusiones:

@app.post(“/analyze_log”)

def analyze(log_text: str):

inputs = tokenizer(log_text, return_tensors=”pt”)

outputs = model.generate(**inputs, max_length=512)

return tokenizer.decode(outputs[0])

En blockchain, utilice el modelo para auditar smart contracts, detectando vulnerabilidades como reentrancy attacks mediante prompts contextuales.

Para escalabilidad, deploy en Kubernetes con soporte GPU, monitoreando con Prometheus para métricas de latencia inferior a 200 ms por inferencia.

Consideraciones Éticas y de Seguridad

El desarrollo de LLM personalizados plantea desafíos éticos, como el sesgo en datasets y el riesgo de generación de desinformación. Implemente safeguards como alignment con RLHF (Reinforcement Learning from Human Feedback) para alinear respuestas con valores humanos. En ciberseguridad, evalúe el modelo contra ataques adversariales, como prompt injection, utilizando herramientas como Robustness Gym.

En blockchain, asegure la privacidad de datos con técnicas de federated learning, entrenando en nodos distribuidos sin compartir datos crudos. Cumpla con regulaciones como la Ley de IA de la UE, documentando el proceso de entrenamiento para auditorías.

Evaluación y Métricas de Desempeño

Evalúe el modelo con benchmarks estándar: GLUE para comprensión del lenguaje, y custom metrics para dominios específicos. En ciberseguridad, mida la precisión en clasificación de amenazas con F1-score superior al 90%. Compare con baselines como GPT-3.5, donde Llama 3 personalizado muestra mejoras del 15% en tareas técnicas.

Realice pruebas A/B en producción para validar mejoras, ajustando hiperparámetros iterativamente.

Desafíos Comunes y Soluciones

Entre los desafíos, destaca el overfitting, mitigado con dropout y early stopping. La escasez de GPU se resuelve con cloud bursting en proveedores como Azure. Para datasets en español latinoamericano, curate fuentes locales como corpora de noticias de México o Argentina para reducir sesgos anglocéntricos.

Otro reto es la inferencia en tiempo real; optimice con TensorRT para acelerar hasta 5x en hardware NVIDIA.

Avances Futuros en LLM Personalizados

El panorama de LLM evoluciona rápidamente, con integraciones multimodales (texto + imagen) en Llama 3 futuras. En ciberseguridad, espere modelos híbridos con graph neural networks para análisis de redes. En blockchain, LLM agenticos automatizarán governance en DAOs.

Investigue en quantization-aware training para modelos aún más eficientes, apuntando a deployment en dispositivos IoT para seguridad perimetral.

Cierre: Implicaciones y Recomendaciones

Desarrollar un LLM basado en Llama 3 democratiza la IA, permitiendo innovaciones en ciberseguridad y blockchain sin depender de proveedores cerrados. Este proceso no solo mejora la eficiencia operativa, sino que fomenta la soberanía tecnológica. Recomendamos iterar en prototipos pequeños antes de escalar, y colaborar con comunidades open-source para refinar modelos. Con un enfoque disciplinado, estos LLM pueden transformar industrias emergentes, asegurando un futuro digital seguro y accesible.

Para más información visita la Fuente original.