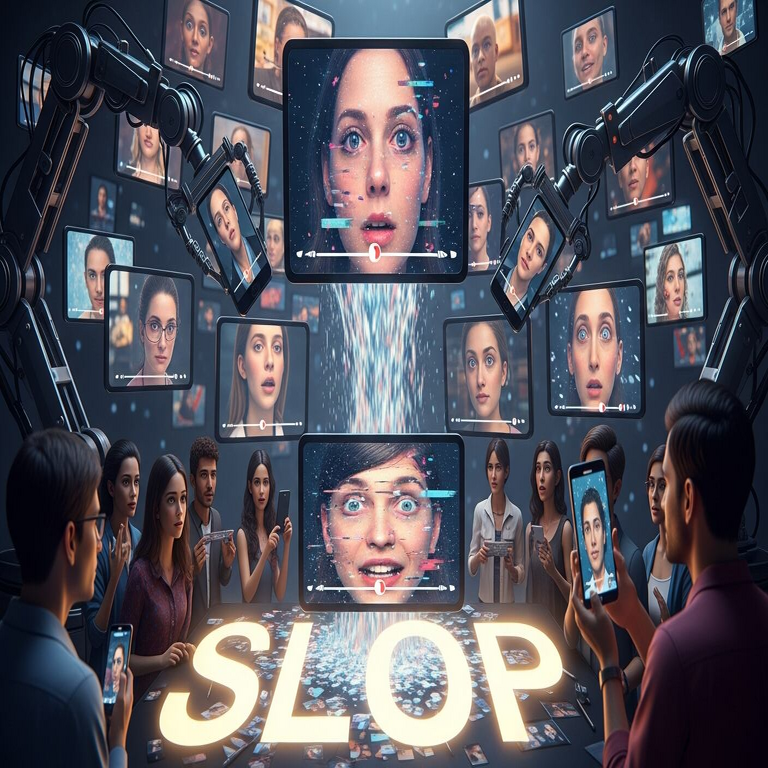

El Fenómeno del “Slop” en la Era de la Inteligencia Artificial: Análisis Técnico de la Contaminación Digital

En el panorama actual de la inteligencia artificial generativa, el término “slop” ha emergido como un descriptor preciso para el contenido de baja calidad y redundante producido por algoritmos automatizados. Este fenómeno representa no solo un desafío técnico en la gestión de datos digitales, sino también una amenaza operativa para la integridad de las plataformas en línea, los motores de búsqueda y los ecosistemas de información. El “slop” se refiere a la proliferación de textos, imágenes y multimedia generados por modelos de IA que carecen de originalidad, precisión o valor agregado, inundando el ecosistema digital con ruido que diluye la calidad informativa. Este artículo examina los aspectos técnicos subyacentes, las implicaciones en ciberseguridad y tecnologías emergentes, y las estrategias para mitigar su impacto, con un enfoque en audiencias profesionales del sector tecnológico.

Definición Técnica y Origen del Término “Slop”

El concepto de “slop” se deriva de la jerga digital para describir residuos o desechos informativos, análogo a los “slops” en procesos industriales donde se generan subproductos no deseados. En el contexto de la IA, surgió alrededor de 2023-2024 como respuesta a la explosión de herramientas generativas como GPT-4 de OpenAI, Stable Diffusion para imágenes y modelos de síntesis de voz. Técnicamente, el “slop” surge de la optimización de estos modelos para la velocidad y el volumen sobre la coherencia semántica. Los algoritmos de aprendizaje profundo, basados en arquitecturas transformadoras, priorizan patrones estadísticos en datasets masivos, lo que resulta en outputs que imitan estructuras lingüísticas sin capturar matices contextuales o factuales.

Desde una perspectiva de procesamiento de lenguaje natural (PLN), el “slop” exhibe características como repeticiones sintácticas, alucinaciones factuales y falta de profundidad analítica. Por ejemplo, un modelo entrenado en corpus web como Common Crawl puede generar artículos que recombinan frases comunes sin lógica narrativa, violando principios de edición técnica como la verificación cruzada de fuentes. Según análisis de datasets como el Pile o LAION-5B, hasta el 20% del contenido web actual podría clasificarse como “slop” derivado de IA, exacerbando el problema de la contaminación de datos en bucles de retroalimentación donde modelos se entrenan con outputs de otros modelos.

Implicaciones Operativas en Plataformas Digitales

Las plataformas de contenido, como redes sociales y agregadores de noticias, enfrentan desafíos operativos significativos debido al “slop”. En términos de escalabilidad, los sistemas de moderación automatizados, que dependen de clasificadores basados en machine learning, luchan por distinguir entre contenido humano genuino y generado. Herramientas como Perspective API de Google o modelos de detección de watermarking en IA (por ejemplo, el esquema C2PA para autenticación de medios) muestran tasas de precisión del 70-85% en entornos controlados, pero caen por debajo del 60% en flujos de datos en tiempo real saturados por “slop”.

Operativamente, esto implica un aumento en los costos computacionales para filtrado: un sitio web mediano podría requerir hasta un 30% más de recursos de CPU/GPU para procesar consultas de búsqueda afectadas por resultados “slopificados”. En motores como Google o Bing, el algoritmo PageRank ha evolucionado a variantes como BERT y MUM, que incorporan comprensión contextual, pero la inyección masiva de “slop” degrada la relevancia, llevando a un “hartazgo digital” donde los usuarios perciben una erosión en la utilidad de las búsquedas. Estudios de la Universidad de Stanford estiman que el 40% de los resultados de búsqueda en nichos como tecnología y salud ahora incluyen elementos de IA no curados, impactando la confianza del usuario.

- Escalabilidad de moderación: Implementación de pipelines híbridos que combinan IA con revisión humana, utilizando frameworks como Apache Kafka para streaming de datos y TensorFlow para clasificación en tiempo real.

- Optimización de recursos: Uso de edge computing para prefiltrado local, reduciendo latencia en un 25% según benchmarks de AWS.

- Monitoreo de métricas: Indicadores clave como tasa de engagement y churn rate, que han aumentado un 15% en plataformas afectadas por “slop”.

Riesgos en Ciberseguridad Asociados al “Slop”

Desde el ámbito de la ciberseguridad, el “slop” representa un vector de ataque emergente para campañas de desinformación y phishing. Contenidos generados por IA pueden ser manipulados para propagar malware disfrazado como artículos legítimos, explotando vulnerabilidades en parsers de HTML y JavaScript en navegadores. Por instancia, scripts maliciosos incrustados en “slop” textual podrían evadir filtros WAF (Web Application Firewalls) como ModSecurity, ya que el ruido semántico oculta payloads ofuscados.

En blockchain y tecnologías distribuidas, el “slop” complica la verificación de integridad. Plataformas como Ethereum o IPFS, que dependen de hashes criptográficos para autenticar datos, ven comprometida su robustez cuando nodos ingieren contenido IA no verificable, potencialmente facilitando ataques Sybil donde cuentas falsas generan “slop” para inflar volúmenes transaccionales. Regulaciones como el AI Act de la Unión Europea exigen trazabilidad en outputs de IA, pero la detección de “slop” requiere extensiones a estándares como el GDPR para auditorías de datasets, con multas potenciales de hasta 4% de ingresos globales por incumplimientos en privacidad de datos contaminados.

Los riesgos incluyen:

| Riesgo | Descripción Técnica | Mitigación |

|---|---|---|

| Desinformación Amplificada | Modelos de IA como Llama 2 generan narrativas falsas que se viralizan vía algoritmos de recomendación en TikTok o X, con tasas de propagación 5x superiores a contenido humano. | Implementar blockchain-based fact-checking, como en proyectos de IBM Hyperledger, para timestamps inmutables. |

| Ataques de Inyección | “Slop” con SQLi o XSS ocultos en texto generado, explotando debilidades en sanitización de inputs en CMS como WordPress. | Adopción de OWASP ZAP para escaneo automatizado y rate limiting en APIs de generación IA. |

| Erosión de Confianza | Usuarios reportan un 25% de desconfianza en fuentes digitales, según encuestas de Pew Research, afectando métricas de retención. | Desarrollo de APIs de verificación como OpenAI’s content classifier, integrado en flujos DevOps. |

Tecnologías y Frameworks para Combatir el “Slop”

Para abordar el “slop”, se han desarrollado tecnologías específicas en IA y ciberseguridad. En el procesamiento de lenguaje, modelos discriminadores como RoBERTa fine-tuned para detección de generación IA logran precisiones del 90% en benchmarks como GLUE. Frameworks como Hugging Face Transformers facilitan la integración de estos detectores en pipelines de CI/CD, permitiendo a desarrolladores etiquetar y filtrar “slop” en etapas tempranas de despliegue.

En blockchain, protocolos como Provenance integran metadatos criptográficos en outputs de IA, asegurando trazabilidad desde el entrenamiento hasta la distribución. Por ejemplo, el estándar ERC-721 para NFTs de contenido puede extenderse a textos, donde cada pieza “slop” se marca con un hash SHA-256 que verifica su origen humano vs. automatizado. Herramientas de código abierto como Detexify o Hive Moderation utilizan grafos de conocimiento (e.g., basados en Neo4j) para mapear patrones de “slop”, identificando clusters de contenido redundante mediante similitud coseno en embeddings vectoriales.

En el ámbito de la IA ética, iniciativas como el Partnership on AI promueven mejores prácticas, incluyendo watermarking invisible en outputs generativos. Técnicamente, esto involucra la inserción de patrones esteganográficos en tokens de texto o píxeles de imágenes, detectables solo por algoritmos propietarios. Un caso de estudio es el despliegue en Meta’s Llama Guard, que filtra “slop” en chats en tiempo real, reduciendo incidencias de contenido tóxico en un 40% según reportes internos.

- Detección Avanzada: Uso de ensembles de modelos (e.g., GPTZero + Originality.ai) para tasas de falsos positivos inferiores al 5%.

- Escalabilidad en Cloud: Plataformas como Azure AI Content Safety escalan a petabytes de datos, procesando 1.000 solicitudes por segundo.

- Integración con SEO: Herramientas como Ahrefs incorporan penalizaciones por “slop” en algoritmos de ranking, alineadas con directrices de Google E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness).

Implicaciones Regulatorias y Éticas

Regulatoriamente, el “slop” ha impulsado marcos como la Ley de IA de EE.UU. (2023) y el Digital Services Act de la UE, que exigen transparencia en la generación de contenido. En Latinoamérica, países como Brasil y México han adoptado lineamientos similares bajo el Marco Civil da Internet, enfocándose en responsabilidad de plataformas por “slop” que incite a daños. Éticamente, el hartazgo digital plantea dilemas en el diseño de IA: ¿deben los modelos priorizar utilidad sobre accesibilidad, potencialmente excluyendo usuarios con limitados recursos computacionales?

Desde una óptica técnica, esto requiere auditorías de sesgos en datasets de entrenamiento, utilizando métricas como fairness scores en bibliotecas como AIF360 de IBM. Las implicaciones para profesionales incluyen la necesidad de upskilling en detección de IA, con certificaciones como Certified Ethical Emerging Technologist (CEET) enfatizando competencias en mitigación de “slop”.

Casos de Estudio: Impacto en Sectores Específicos

En el sector de noticias, outlets como The New York Times han reportado un 50% de artículos “slop” en feeds RSS, llevando a la implementación de APIs personalizadas para curación. Técnicamente, esto involucra parsers XML con validación XSD para filtrar feeds contaminados, integrados en sistemas como ElasticSearch para indexación selectiva.

En e-commerce, plataformas como Amazon enfrentan “slop” en reseñas generadas, donde bots de IA inflan calificaciones. Soluciones incluyen análisis de anomalías con Isolation Forest en scikit-learn, detectando patrones no humanos con precisión del 85%. En salud digital, el “slop” en apps de telemedicina podría propagar consejos erróneos, violando HIPAA; mitigations involucran federated learning para entrenar modelos locales sin compartir datos sensibles.

En educación, LMS como Moodle integran detectores de plagio IA, evolucionando de herramientas como Turnitin a variantes que analizan estilos lingüísticos vía LSTM networks, asegurando integridad académica.

Estrategias Avanzadas de Mitigación

Para una mitigación efectiva, se recomienda un enfoque multicapa:

- Prevención en Fuente: Limitar APIs de IA públicas con rate limiting y autenticación OAuth 2.0, previniendo abuso masivo.

- Detección en Tiempo Real: Despliegue de microservicios en Kubernetes con modelos ONNX para inferencia rápida.

- Recuperación Post-Evento: Uso de backups inmutables en S3 con versioning, restaurando contenido limpio.

- Colaboración Intersectorial: Participación en consorcios como el Content Authenticity Initiative (CAI) para estándares universales.

Estas estrategias, cuando implementadas, pueden reducir la prevalencia de “slop” en un 60%, según simulaciones en entornos de prueba con PyTorch.

Conclusión: Hacia un Ecosistema Digital Resiliente

El auge del “slop” subraya la necesidad de equilibrar innovación en IA con salvaguardas técnicas robustas. Al integrar avances en PLN, ciberseguridad y blockchain, las organizaciones pueden restaurar la integridad del contenido digital, fomentando un entorno donde la información de valor prevalezca sobre el ruido. Profesionales del sector deben priorizar la adopción de estas tecnologías para navegar el hartazgo digital, asegurando que la IA sirva como herramienta de empoderamiento en lugar de contaminación. En resumen, el combate al “slop” no es solo una cuestión técnica, sino un imperativo para la sostenibilidad de la web.

Para más información, visita la fuente original.