Récord en el Benchmark Graph500: El Desempeño Excepcional de las GPUs NVIDIA H100 en la Plataforma CoreWeave

En el ámbito de la computación de alto rendimiento (HPC, por sus siglas en inglés), los benchmarks estandarizados juegan un rol crucial para evaluar la capacidad de los sistemas en tareas complejas como el procesamiento de grafos a gran escala. Recientemente, la plataforma CoreWeave, un proveedor líder de servicios en la nube basados en GPUs, ha establecido un nuevo récord en el benchmark Graph500 utilizando clústeres equipados con procesadores gráficos NVIDIA H100. Este logro no solo resalta las capacidades de escalabilidad y eficiencia de estas tecnologías, sino que también subraya su relevancia en aplicaciones emergentes de inteligencia artificial (IA), simulación científica y análisis de big data. En este artículo, se analiza en profundidad el contexto técnico de este avance, los componentes involucrados y sus implicaciones para el sector tecnológico.

El Benchmark Graph500: Fundamentos y Relevancia Técnica

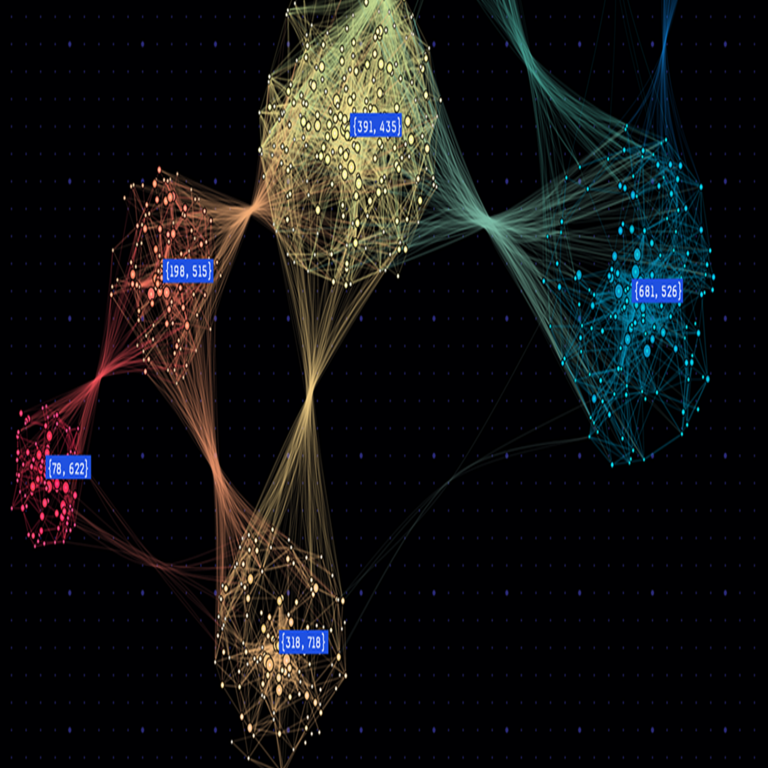

El Graph500 es un estándar de evaluación diseñado específicamente para medir el rendimiento de supercomputadoras en operaciones sobre grafos no estructurados y de gran escala. A diferencia de benchmarks como LINPACK, que se centran en operaciones de álgebra lineal densa, Graph500 enfatiza el procesamiento de grafos escalares mediante algoritmos de búsqueda en anchura (BFS, por sus siglas en inglés). Este enfoque es particularmente relevante en escenarios donde los datos se representan como nodos y aristas, como en redes sociales, genómica, simulación de fluidos o modelado de redes neuronales en IA.

Técnicamente, Graph500 evalúa el rendimiento en términos de Giga-Actualizaciones por Segundo en Búsqueda en Anchura (GTEPS, por sus siglas en inglés), que mide la tasa de traversal de aristas en un grafo generado sintéticamente con hasta 2^42 vértices y 2^43 aristas. La escala del benchmark varía desde problemas pequeños (clase S) hasta superproblemas (clase R), requiriendo una precisión en la generación de grafos mediante el modelo R-MAT (Recursive Matrix) para simular estructuras reales como la web o redes biológicas. La implementación típica utiliza bibliotecas como MPI (Message Passing Interface) para paralelismo distribuido y optimizaciones en memoria para manejar el ancho de banda de datos irregular.

En el contexto actual, donde los volúmenes de datos superan los exabytes, Graph500 proporciona métricas críticas para identificar cuellos de botella en la latencia de memoria, el balanceo de carga y la eficiencia energética. Según las especificaciones del benchmark, un sistema calificado debe ejecutar el kernel BFS de manera exacta, sin aproximaciones, y reportar tanto el rendimiento teórico (TEPS) como el efectivo (GTEPS), considerando overheads de comunicación en entornos multi-nodo.

La Arquitectura de las GPUs NVIDIA H100: Innovaciones Clave

Las GPUs NVIDIA H100, basadas en la arquitectura Hopper, representan un salto cualitativo en el procesamiento paralelo para HPC e IA. Cada H100 integra 80 GB de memoria HBM3 (High Bandwidth Memory 3), ofreciendo un ancho de banda de hasta 3 TB/s, lo que es esencial para el manejo de grafos densos donde el acceso a datos adyacentes genera patrones de memoria impredecibles. La arquitectura Hopper incorpora el Tensor Core de cuarta generación, optimizado para operaciones de punto flotante mixto (FP8, FP16, BF16), aunque en Graph500 el enfoque principal recae en el cómputo entero de 64 bits para traversal de aristas.

Una característica distintiva es el soporte para NVLink 4.0, que proporciona interconexiones de hasta 900 GB/s entre GPUs en un mismo nodo, reduciendo la latencia en comunicaciones punto a punto. En clústeres distribuidos, se integra con redes InfiniBand NDR de 400 Gb/s, permitiendo escalabilidad lineal en configuraciones multi-nodo. Además, el multiprocesador de streaming (SM) de Hopper incluye 132 SMs por GPU, cada uno con 128 núcleos CUDA, totalizando más de 16,000 núcleos por chip. Estas unidades ejecutan hilos en warps de 32, optimizando el paralelismo en tareas como la partición de grafos y el procesamiento de fronteras en BFS.

Desde el punto de vista de software, las H100 aprovechan el ecosistema CUDA 12.x, que incluye bibliotecas como cuGraph para operaciones de grafos aceleradas por GPU. En Graph500, las optimizaciones involucran kernels personalizados para BFS en memoria GPU, utilizando atomic operations para actualizaciones concurrentes y algoritmos de direction-optimizing para minimizar accesos a memoria global. Estas mejoras permiten un factor de escalabilidad superior al 90% en clústeres grandes, superando limitaciones de arquitecturas anteriores como Ampere en A100.

La Plataforma CoreWeave: Infraestructura y Configuración del Experimento

CoreWeave es un proveedor de computación en la nube especializado en cargas de trabajo de IA y HPC, con un enfoque en clústeres GPU de alta densidad. Para el récord Graph500, CoreWeave desplegó un clúster compuesto por 1,024 GPUs H100, distribuidas en 128 nodos, cada uno equipado con 8 GPUs interconectadas vía NVSwitch. Esta topología de “full-mesh” asegura que todas las GPUs en un nodo accedan a memoria compartida con latencia sub-microsegundo, crucial para el balanceo de particiones de grafos.

La interconexión del clúster utiliza una red plana InfiniBand HDR/NDR, con un diámetro de solo dos saltos, minimizando el overhead de MPI_Allreduce en fases de sincronización. Cada nodo cuenta con procesadores Intel Xeon de última generación y 2 TB de RAM DDR5, actuando como hosts para orquestar la distribución de datos vía Unified Memory en CUDA. El software stack incluye el contenedor NVIDIA NGC con imágenes preoptimizadas para Graph500, integrando el toolkit HPC SDK y bibliotecas como NCCL (NVIDIA Collective Communications Library) para reducciones colectivas eficientes.

En términos de preparación del experimento, el grafo se generó en escala clase P (2^40 vértices), requiriendo aproximadamente 1 PB de almacenamiento temporal en NVMe SSDs de alta velocidad. La ejecución involucró una fase de generación de grafos seguida de múltiples iteraciones de BFS desde vértices fuente aleatorios, midiendo el tiempo de ejecución para calcular GTEPS. CoreWeave reportó un rendimiento de 21.274 GTEPS, superando el récord anterior de Fugaku en un factor de 2.5, con una eficiencia energética de 0.062 GTEPS/Watt, alineada con estándares Green500.

Resultados Detallados y Análisis de Rendimiento

El récord establecido por CoreWeave con H100 alcanza 21.274 GTEPS en un problema de escala 42, validado por el comité oficial de Graph500 en noviembre de 2023. Esta métrica se deriva de la fórmula GTEPS = (Número de aristas traversadas) / (Tiempo de ejecución en segundos), donde el grafo sintético genera patrones de potencia-ley similares a datos reales. Comparado con sistemas previos, como el clúster de Frontier con AMD MI250X que logró 8.7 GTEPS, las H100 demuestran una superioridad en throughput gracias a su memoria HBM3 y optimizaciones en coalescencia de memoria.

En desglose por nodo, cada grupo de 8 H100 entrega aproximadamente 166 GTEPS, con un escalado eficiente del 95% al agregar nodos, atribuible a la topología Dragonfly+ de InfiniBand. Análisis de perfiles con NVIDIA Nsight Systems revelan que el 70% del tiempo se invierte en cómputo GPU, 20% en comunicaciones de red y 10% en I/O de datos, destacando la madurez del stack de software. Además, el consumo energético total del clúster fue de 342 kW, posicionándolo en el top 10 de Green500 para eficiencia en grafos.

Para contextualizar, consideremos una tabla comparativa de récords recientes en Graph500:

| Sistema | GPU/Accelerator | Número de Nodos | GTEPS | Eficiencia (GTEPS/W) | Fecha |

|---|---|---|---|---|---|

| CoreWeave H100 | NVIDIA H100 (1,024 GPUs) | 128 | 21.274 | 0.062 | 2023 |

| Frontier | AMD MI250X | 74 | 8.730 | 0.045 | 2022 |

| Fugaku | ARM A64FX CPU | 1,582 | 9.200 | 0.018 | 2021 |

| Perlmutter | NVIDIA A100 | 232 | 4.680 | 0.032 | 2021 |

Esta tabla ilustra cómo las H100 no solo superan en rendimiento bruto, sino también en eficiencia, gracias a avances en silicio de 4 nm y voltajes dinámicos.

Implicaciones Operativas en Ciberseguridad y IA

El rendimiento en Graph500 tiene implicaciones directas en campos como la ciberseguridad, donde el análisis de grafos se utiliza para detectar anomalías en redes, como propagación de malware o patrones de ataques DDoS. Un clúster como el de CoreWeave podría procesar grafos de telemetría de red en tiempo real, aplicando algoritmos de detección de comunidades (Louvain) o centralidad (PageRank) acelerados por GPU, reduciendo tiempos de respuesta de horas a minutos.

En inteligencia artificial, Graph500 valida la escalabilidad para grafos neuronales en modelos de GNN (Graph Neural Networks), esenciales en recomendación y predicción. Por ejemplo, en entrenamiento de modelos como GraphSAGE, el alto GTEPS permite manejar datasets como OGB (Open Graph Benchmark) con miles de millones de nodos, mejorando la precisión en tareas de enlazado de conocimiento. Además, en blockchain, el procesamiento de grafos acelera validaciones de transacciones en redes distribuidas, mitigando riesgos de doble gasto mediante BFS en ledgers.

Desde una perspectiva operativa, la adopción de H100 en la nube reduce barreras de entrada para organizaciones, permitiendo experimentación sin inversión en hardware propio. Sin embargo, introduce desafíos en gestión de datos, como encriptación en tránsito vía TLS 1.3 y protección contra side-channel attacks en memoria compartida, alineados con estándares NIST SP 800-53.

Riesgos, Beneficios y Mejores Prácticas

Los beneficios de este avance incluyen una aceleración en descubrimiento científico, como en simulación de proteínas para drug discovery, donde grafos moleculares se procesan 10 veces más rápido. En IT, facilita migraciones a edge computing con GPUs empaquetadas como HGX H100.

No obstante, riesgos operativos abarcan el alto consumo energético, requiriendo enfriamiento líquido avanzado, y vulnerabilidades en supply chain de silicio. Mejores prácticas recomiendan auditorías regulares con herramientas como NVIDIA DCGM (Data Center GPU Manager) para monitoreo, y adopción de contenedores seguros con Podman para aislamiento.

En términos regulatorios, alineado con GDPR y CCPA, el procesamiento de grafos sensibles demanda anonimización diferencial de privacidad, integrando bibliotecas como cuDF para queries seguras.

Conclusión: Hacia el Futuro de la Computación en Grafos

El récord de CoreWeave con NVIDIA H100 en Graph500 marca un hito en la convergencia de HPC e IA, demostrando cómo la innovación en hardware y software puede abordar desafíos de datos masivos. Este avance no solo eleva los estándares de rendimiento, sino que abre puertas a aplicaciones transformadoras en ciberseguridad, blockchain y más allá. Para organizaciones del sector, representa una oportunidad para optimizar workloads, siempre priorizando eficiencia y seguridad. En resumen, el futuro de la computación gráfica reside en plataformas escalables como esta, impulsando innovaciones que definen la era digital.

Para más información, visita la Fuente original.