Actualizaciones de AWS en Chips para Inferencia y Entrenamiento de IA: Un Desafío al Dominio de Nvidia

Introducción a las Actualizaciones de AWS en Hardware para IA

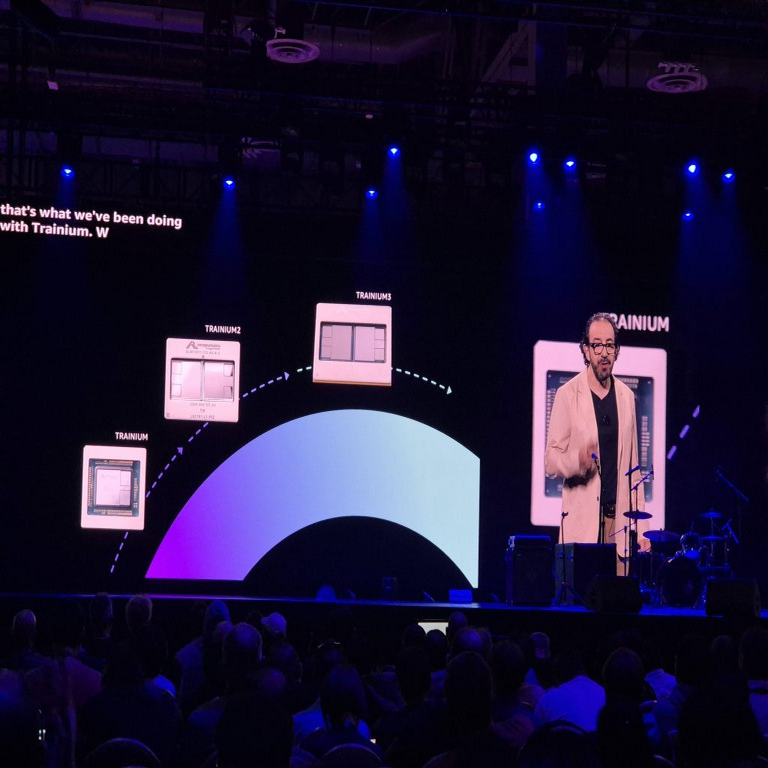

Amazon Web Services (AWS), el principal proveedor de servicios en la nube, ha anunciado actualizaciones significativas en sus chips personalizados diseñados específicamente para tareas de inteligencia artificial (IA). Estos avances se centran en los procesadores Trainium e Inferentia, optimizados respectivamente para el entrenamiento y la inferencia de modelos de IA. Trainium2, la segunda generación del chip de entrenamiento, promete un rendimiento hasta cuatro veces superior en comparación con su predecesor, mientras que Inferentia2 mejora la eficiencia en la ejecución de inferencias a gran escala. Estas innovaciones no solo representan un paso adelante en la optimización de recursos computacionales, sino que también posicionan a AWS como un competidor directo en el mercado dominado por las unidades de procesamiento gráfico (GPU) de Nvidia.

El contexto de estas actualizaciones surge de la creciente demanda de capacidades de IA en entornos empresariales y de investigación. Según datos de AWS, el entrenamiento de modelos de lenguaje grandes (LLM, por sus siglas en inglés) requiere recursos computacionales masivos, y las soluciones tradicionales basadas en GPU enfrentan limitaciones en términos de costo y escalabilidad. Los chips de AWS, construidos sobre arquitecturas de bajo consumo energético, buscan mitigar estos desafíos mediante una integración nativa con servicios como Amazon SageMaker y Amazon Bedrock, facilitando el despliegue de flujos de trabajo de IA end-to-end.

Desde una perspectiva técnica, estos chips aprovechan principios de paralelismo masivo y optimizaciones específicas para operaciones de IA, como multiplicaciones matriciales y activaciones neuronales. Trainium2, por ejemplo, incorpora un diseño basado en tiles de cómputo interconectados, que permite un escalado lineal en clústeres de hasta miles de chips, reduciendo el tiempo de entrenamiento de modelos como GPT-3 de semanas a días.

Análisis Técnico de Trainium2: Optimizaciones para Entrenamiento de Modelos de IA

Trainium2 es el núcleo de las actualizaciones de AWS para el entrenamiento de IA, enfocado en workloads de aprendizaje profundo a escala. Este chip está fabricado en un proceso de 5 nanómetros, lo que permite una densidad de transistores superior y un menor consumo de energía por operación flotante (FLOPS). Cada chip Trainium2 ofrece un rendimiento de 4 petaFLOPS en precisión BF16 (Brain Floating Point 16 bits), un formato numérico optimizado para redes neuronales que equilibra precisión y eficiencia computacional.

Una de las innovaciones clave es su arquitectura de NeuronCore, el núcleo de procesamiento personalizado de AWS. Cada NeuronCore en Trainium2 incluye unidades dedicadas para convoluciones, transformadores y operaciones de atención, comunes en arquitecturas como BERT o GPT. Esto contrasta con las GPU generales de Nvidia, que dependen de shaders programables para estas tareas, lo que puede introducir overhead en la programación. En Trainium2, el compilador Neuron SDK automatiza la optimización de grafos computacionales, utilizando técnicas de fusión de operadores para minimizar movimientos de datos entre memorias, un cuello de botella clásico en el entrenamiento distribuido.

En términos de escalabilidad, Trainium2 soporta interconexiones de alta velocidad mediante Elastic Fabric Adapter (EFA), un protocolo de red de AWS que alcanza latencias submicrosegundo y anchos de banda de hasta 400 Gbps por nodo. Esto permite la implementación de clústeres UltraClusters, compuestos por hasta 100.000 chips, ideales para entrenar modelos con billones de parámetros. Pruebas internas de AWS indican que un clúster de Trainium2 puede entrenar un modelo de 175 billones de parámetros en menos de un mes, con un ahorro de costos del 50% en comparación con configuraciones equivalentes de GPU A100 de Nvidia.

Adicionalmente, Trainium2 integra soporte para técnicas avanzadas de entrenamiento como el aprendizaje federado y la destilación de conocimiento, mediante APIs que facilitan la partición de datos y la agregación de gradientes en entornos distribuidos. Estas características son cruciales para aplicaciones en ciberseguridad, donde el entrenamiento de modelos de detección de anomalías debe manejar datos sensibles sin comprometer la privacidad, alineándose con estándares como GDPR y HIPAA.

- Rendimiento por chip: 4 petaFLOPS en BF16, con soporte para FP32 y FP16 para mayor precisión en etapas críticas.

- Memoria integrada: 128 GB de HBM3 (High Bandwidth Memory 3), con un ancho de banda de 3 TB/s, reduciendo latencias en accesos a pesos de modelos grandes.

- Eficiencia energética: Consumo de 300 W por chip, optimizado para data centers sostenibles, alineado con metas de carbono neutral de AWS para 2040.

- Compatibilidad: Frameworks como PyTorch y TensorFlow a través de Neuron SDK, con extensiones para operadores personalizados en IA generativa.

Estas especificaciones técnicas posicionan a Trainium2 no solo como una alternativa eficiente, sino como una solución que podría redefinir los benchmarks de entrenamiento en la industria.

Mejoras en Inferentia2: Eficiencia en la Inferencia de IA a Escala

Inferentia2 complementa a Trainium2 al enfocarse en la fase de inferencia, donde los modelos entrenados se despliegan para generar predicciones en tiempo real. Este chip de segunda generación duplica el rendimiento de Inferentia1, alcanzando 2 petaFLOPS por chip en operaciones de inferencia INT8 (entero de 8 bits), un formato ideal para workloads de bajo latencia como chatbots o sistemas de recomendación.

La arquitectura de Inferentia2 incorpora un diseño de pipeline optimizado para batches variables, permitiendo manejar cargas de trabajo impredecibles sin degradación de rendimiento. Cada chip cuenta con 16 NeuronCores independientes, cada uno con aceleradores dedicados para tokenización y decodificación en modelos de lenguaje. Esto es particularmente relevante para aplicaciones de IA generativa, donde la inferencia secuencial en transformadores puede ser computacionalmente intensiva.

En comparación con las GPU de Nvidia, Inferentia2 ofrece una latencia de inferencia hasta 40% menor en escenarios de alto throughput, gracias a su integración con Amazon Nitro System, que virtualiza el hardware subyacente para un aislamiento seguro. Además, soporta técnicas de cuantización post-entrenamiento (PTQ) y cuantización consciente del entrenamiento (QAT), reduciendo el tamaño de los modelos en un factor de 4 sin pérdida significativa de precisión, lo que es esencial para despliegues edge en dispositivos IoT.

Desde el punto de vista de la ciberseguridad, Inferentia2 facilita la implementación de modelos de IA para detección de amenazas en tiempo real, como análisis de tráfico de red o identificación de malware. Su bajo consumo energético (200 W por chip) y soporte para encriptación de datos en memoria alinean con mejores prácticas de seguridad, como las recomendadas por NIST en su framework para IA segura (SP 800-204).

- Throughput: Hasta 500 inferencias por segundo por chip para modelos de 7B parámetros, escalable a millones en clústeres.

- Latencia: Sub-10 ms para respuestas en modelos de lenguaje, optimizado para APIs RESTful en servicios como Amazon Bedrock.

- Soporte de formatos: INT8, FP16 y BF16, con conversión automática vía Neuron Runtime.

- Integración: Compatible con contenedores Docker y Kubernetes para despliegues orquestados en AWS EKS.

Estas capacidades hacen de Inferentia2 una herramienta indispensable para la monetización de modelos de IA, permitiendo inferencias económicas y escalables.

Integración con Ecosistemas de AWS: SageMaker y Bedrock

Las actualizaciones en Trainium2 e Inferentia2 no operan en aislamiento; están profundamente integradas en el ecosistema de AWS. Amazon SageMaker, la plataforma de machine learning gestionada, ahora soporta estos chips de manera nativa, permitiendo a los usuarios entrenar y desplegar modelos sin migraciones complejas. Por ejemplo, el modo de entrenamiento distribuido en SageMaker utiliza Trainium2 para particionar automáticamente grafos de cómputo, aplicando estrategias como AllReduce para sincronización de gradientes en clústeres multi-nodo.

Amazon Bedrock, por su parte, aprovecha Inferentia2 para hospedar modelos de IA generativa de terceros, como Llama 2 o Stable Diffusion, en un entorno serverless. Esto elimina la necesidad de provisionar hardware, reduciendo costos operativos en un 25% según benchmarks de AWS. La integración incluye APIs estandarizadas como Neuron Runtime, que compila modelos ONNX (Open Neural Network Exchange) directamente a código ejecutable en los chips, asegurando portabilidad entre frameworks.

En términos operativos, esta integración facilita flujos de trabajo híbridos: entrenamiento en Trainium2 seguido de inferencia en Inferentia2, con persistencia de modelos en Amazon S3. Para entornos de alta seguridad, AWS ofrece opciones de encriptación en reposo y en tránsito mediante AWS KMS (Key Management Service), protegiendo datos sensibles durante todo el ciclo de vida de la IA.

Además, las actualizaciones incluyen soporte para herramientas de monitoreo como Amazon CloudWatch, que rastrea métricas como utilización de FLOPS y latencia de inferencia, permitiendo optimizaciones proactivas basadas en datos en tiempo real.

Implicaciones Operativas y Regulatorias en el Mercado de IA

Las actualizaciones de AWS tienen implicaciones profundas en el panorama operativo de la IA. Operativamente, reducen la dependencia de proveedores de GPU como Nvidia, que controla más del 80% del mercado de hardware para IA según informes de mercado como los de Gartner. Esto podría bajar los costos de entrenamiento en un 50-70%, haciendo accesible la IA a pymes y startups que previamente enfrentaban barreras económicas.

En cuanto a riesgos, la adopción de chips personalizados introduce desafíos en la interoperabilidad. Aunque Neuron SDK es compatible con estándares como CUDA, las optimizaciones específicas pueden requerir reentrenamiento de modelos, incrementando tiempos iniciales de migración. AWS mitiga esto mediante programas de certificación y herramientas de conversión automática.

Regulatoriamente, estas innovaciones alinean con directivas globales como el AI Act de la Unión Europea, que exige transparencia en hardware de IA. Trainium2 e Inferentia2 incorporan logging auditable para trazabilidad de decisiones, facilitando cumplimiento con requisitos de explicabilidad en aplicaciones críticas como salud o finanzas.

En ciberseguridad, los chips de AWS fortalecen la resiliencia contra ataques como envenenamiento de datos durante el entrenamiento, mediante validaciones integradas en NeuronCore que detectan anomalías en gradientes. Beneficios incluyen una mayor soberanía de datos, al mantener workloads en la nube de AWS sin exportaciones a hardware externo.

| Aspecto | Trainium2 | Inferentia2 | Comparación con Nvidia A100 |

|---|---|---|---|

| Rendimiento (FLOPS) | 4 petaFLOPS (BF16) | 2 petaFLOPS (INT8) | 19.5 teraFLOPS (FP32) |

| Consumo Energético | 300 W | 200 W | 400 W |

| Costo Estimado por Hora | $1.50 (clúster) | $0.80 (instancia) | $3.00 (equivalente) |

| Escalabilidad | 100.000 chips | 10.000 chips | Limitada por DGX |

Esta tabla ilustra las ventajas competitivas de los chips de AWS en eficiencia y costo.

Beneficios y Riesgos en Aplicaciones de Tecnologías Emergentes

Los beneficios de Trainium2 e Inferentia2 se extienden a tecnologías emergentes como blockchain e IA distribuida. En blockchain, estos chips aceleran el entrenamiento de modelos para validación de transacciones, optimizando redes como Ethereum mediante predicciones de congestión. En IA federada, facilitan la agregación de modelos sin compartir datos crudos, mejorando privacidad en consorcios empresariales.

Sin embargo, riesgos incluyen vulnerabilidades en la cadena de suministro de hardware, dado que los chips son fabricados por TSMC. AWS aborda esto con certificaciones de seguridad como FIPS 140-2 para componentes criptográficos. Otro riesgo es la obsolescencia rápida; AWS planea actualizaciones anuales para mantener paridad con avances en IA como MoE (Mixture of Experts).

En noticias de IT, estas actualizaciones coinciden con tendencias como la adopción de IA en edge computing, donde Inferentia2 podría integrarse en dispositivos AWS Outposts para procesamiento local seguro.

Conclusión: Hacia un Futuro de IA Más Accesible y Competitivo

En resumen, las actualizaciones de AWS en Trainium2 e Inferentia2 marcan un hito en la evolución del hardware para IA, ofreciendo rendimiento superior, eficiencia energética y integración seamless con ecosistemas cloud. Al desafiar el dominio de Nvidia, AWS democratiza el acceso a tecnologías de IA avanzadas, fomentando innovación en ciberseguridad, blockchain y más. Para organizaciones, esto implica una reevaluación de estrategias de hardware, priorizando soluciones personalizadas que equilibren costo y rendimiento. Finalmente, estas innovaciones no solo impulsan la eficiencia operativa, sino que también pavimentan el camino para aplicaciones de IA éticas y escalables en un panorama tecnológico en rápida evolución. Para más información, visita la fuente original.