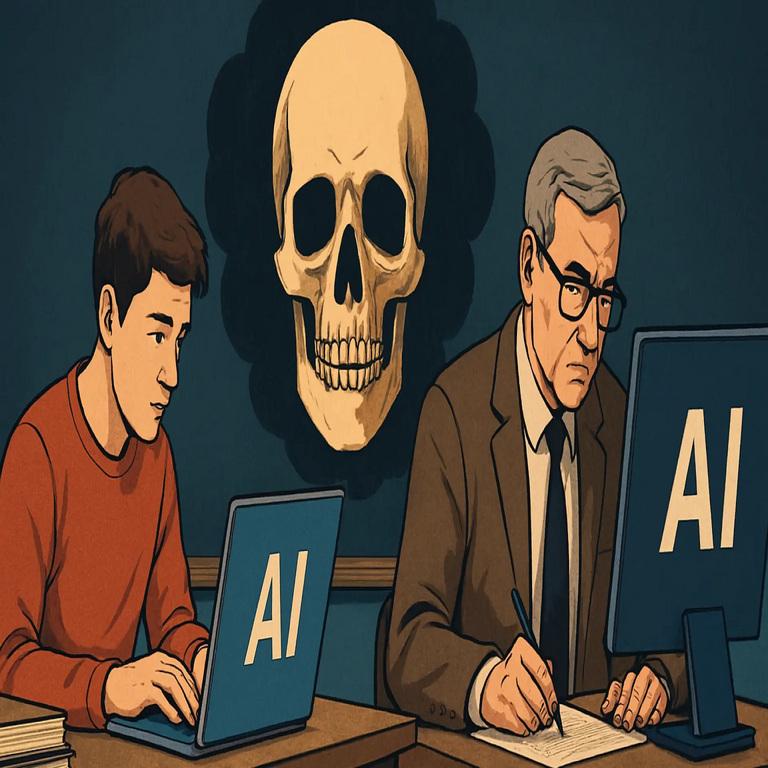

El Impacto de la Inteligencia Artificial en la Educación Superior: Análisis Técnico y Perspectivas Futuras

Introducción al Debate sobre la IA en la Universidad

La integración de la inteligencia artificial (IA) en el ámbito educativo ha transformado radicalmente las dinámicas de enseñanza y aprendizaje en las instituciones de educación superior. En un contexto donde herramientas como los modelos de lenguaje grandes (LLM, por sus siglas en inglés) permiten generar textos coherentes y complejos, surge una interrogante fundamental: ¿está la IA contribuyendo a la obsolescencia de los métodos tradicionales universitarios? Este artículo examina el fenómeno desde una perspectiva técnica, explorando cómo los estudiantes utilizan IA para la redacción de trabajos académicos y cómo los profesores la emplean para la evaluación, basándose en las observaciones de expertos como Ronald Purser, académico y escritor que ha alertado sobre la posible “muerte de la universidad”.

Desde un punto de vista técnico, la IA generativa, impulsada por arquitecturas como los transformadores (transformers), ha democratizado el acceso a la producción de contenido sofisticado. Modelos como GPT-4, desarrollados por OpenAI, operan mediante el procesamiento de secuencias de tokens en un espacio vectorial de alta dimensión, prediciendo la probabilidad de la siguiente palabra o frase con base en patrones aprendidos de vastos corpus de datos. Esta capacidad no solo acelera la creación de ensayos, sino que también plantea desafíos en la autenticidad del conocimiento y la integridad académica. En este análisis, se profundizará en los mecanismos subyacentes, las implicaciones operativas y las estrategias de mitigación, manteniendo un enfoque en estándares éticos y mejores prácticas en IA educativa.

Uso de la IA por Parte de los Estudiantes: Mecanismos Técnicos y Riesgos Asociados

Los estudiantes han adoptado rápidamente la IA como una herramienta auxiliar en la elaboración de trabajos académicos. Técnicamente, esto implica la interacción con interfaces de usuario intuitivas que permiten prompts detallados para generar contenido. Por ejemplo, un estudiante podría ingresar un prompt como: “Redacta un ensayo de 2000 palabras sobre el impacto del cambio climático en la economía global, citando fuentes académicas recientes”. El modelo de IA procesa esta solicitud mediante un proceso de inferencia que involucra capas de atención autoatendida (self-attention), donde cada token se pondera en relación con el contexto global, produciendo un output que simula razonamiento humano.

Sin embargo, este uso conlleva riesgos significativos. Uno de los principales es el plagio inadvertido o intencional, ya que los outputs de IA pueden reproducir patrones de textos existentes sin atribución adecuada. Desde la perspectiva de la ciberseguridad, la dependencia de plataformas en la nube como ChatGPT introduce vulnerabilidades: los datos ingresados en estos sistemas podrían ser almacenados y utilizados para entrenar modelos futuros, violando regulaciones como el Reglamento General de Protección de Datos (RGPD) en Europa o la Ley Federal de Protección de Datos Personales en Posesión de los Particulares (LFPDPPP) en México. Además, la detección de contenido generado por IA se complica por técnicas de “humanización” que los usuarios aplican, como la edición manual o el uso de herramientas para parafrasear, lo que evade detectores basados en métricas como la perplejidad (perplexity) o la diversidad léxica.

En términos operativos, las instituciones educativas enfrentan un dilema: el 70% de los estudiantes universitarios en Estados Unidos reportan haber utilizado IA para tareas académicas, según encuestas de la Universidad de Stanford en 2023. Esto no solo erosiona la evaluación de competencias cognitivas superiores, como el análisis crítico, sino que también amplifica desigualdades, ya que el acceso a herramientas premium de IA depende de suscripciones pagadas, excluyendo a estudiantes de bajos recursos. Técnicamente, para mitigar esto, se recomiendan protocolos como la integración de blockchain para verificar la autoría de documentos, donde hashes criptográficos de borradores intermedios se registran en una cadena distribuida, asegurando trazabilidad inmutable conforme a estándares como el de la Ethereum Foundation.

El Rol de la IA en la Evaluación Académica: Herramientas para Profesores y Sus Limitaciones

Paralelamente, los profesores han incorporado IA en procesos de calificación, utilizando algoritmos para analizar similitudes textuales y detectar anomalías. Herramientas como Turnitin con integración de IA o detectores independientes como GPTZero emplean modelos de machine learning entrenados en datasets contrastados de textos humanos versus generados por IA. Estos sistemas calculan scores basados en características como la explosividad de bursts (burstiness), que mide variaciones en la complejidad sintáctica, o la predictibilidad de n-gramas, donde un texto de IA tiende a mostrar patrones más uniformes debido a su entrenamiento en datos probabilísticos.

No obstante, estas herramientas no son infalibles. Falsos positivos ocurren en un 15-20% de los casos, según estudios de la Universidad de California, Berkeley, afectando a estudiantes cuya escritura natural se asemeja a outputs de IA. Desde un ángulo técnico, los detectores operan bajo marcos de aprendizaje supervisado, utilizando métricas como la precisión (precision) y el recall, pero fallan ante adversarios que fine-tunnean modelos de IA para emular estilos individuales. En ciberseguridad, esto plantea riesgos de sesgo algorítmico: si los datasets de entrenamiento son predominantemente en inglés, los detectores discriminan contra no hablantes nativos, violando principios de equidad en IA definidos por la IEEE Ethics in Autonomous and Intelligent Systems.

Adicionalmente, el uso de IA por profesores acelera la retroalimentación, pero reduce la interacción humana esencial para el mentorship. Plataformas como Gradescope, que incorporan visión por computadora para calificar exámenes escritos a mano, procesan imágenes mediante redes neuronales convolucionales (CNN) para reconocer patrones, logrando una eficiencia del 90% en tareas estandarizadas. Sin embargo, en ensayos cualitativos, la IA lucha con la evaluación de argumentos originales, limitándose a chequeos superficiales de gramática y coherencia, lo que podría perpetuar un ciclo de automatización que deshumaniza la educación.

Implicaciones Éticas, Regulatorias y Técnicas en el Ecosistema Educativo

Las implicaciones éticas de esta dualidad IA-estudiante-profesor son profundas. La autenticidad del aprendizaje se ve comprometida cuando la IA suplanta el esfuerzo cognitivo, alineándose con debates en filosofía de la educación sobre el constructivismo, donde el conocimiento se construye activamente. Técnicamente, esto requiere marcos regulatorios como las directrices de la UNESCO sobre Ética de la IA (2021), que enfatizan la transparencia en el uso de herramientas automatizadas y la responsabilidad compartida entre instituciones y usuarios.

En el plano regulatorio, países como la Unión Europea han propuesto enmiendas a la Directiva de Derechos de Autor para incluir cláusulas sobre IA en educación, exigiendo disclosure de uso de generadores de contenido. En América Latina, iniciativas como la Estrategia Nacional de IA en Chile (2021) abordan la integración educativa, promoviendo auditorías de algoritmos para detectar sesgos. Riesgos operativos incluyen brechas de privacidad: al subir trabajos a plataformas de IA, se exponen datos sensibles, potencialmente explotables en ciberataques como phishing académico o ransomware en sistemas universitarios.

Desde la ciberseguridad, se deben implementar mejores prácticas como el cifrado end-to-end en herramientas educativas (siguiendo estándares AES-256) y autenticación multifactor para accesos a plataformas de IA. Beneficios potenciales incluyen la personalización del aprendizaje: sistemas de tutoría inteligente, basados en reinforcement learning from human feedback (RLHF), adaptan contenidos a ritmos individuales, mejorando tasas de retención en un 25%, según meta-análisis de la Universidad de Harvard.

- Beneficios técnicos: Escalabilidad en la evaluación masiva, reducción de carga administrativa mediante procesamiento paralelo en GPUs.

- Riesgos técnicos: Dependencia de APIs externas, vulnerable a downtime o cambios en políticas de uso, como los términos de servicio de OpenAI que prohíben ciertos usos educativos sin licencia.

- Implicaciones para blockchain: Integración de NFTs educativos para certificar logros auténticos, utilizando smart contracts en plataformas como Polygon para verificar integridad sin intermediarios.

Estrategias de Mitigación y el Futuro de la Educación con IA

Para contrarrestar estos desafíos, las universidades deben adoptar enfoques híbridos que integren IA como complemento, no sustituto. Una estrategia técnica involucra el diseño de evaluaciones resistentes a IA, como portafolios digitales con timestamps blockchain o exámenes orales asistidos por reconocimiento de voz con análisis de estrés vocal para detectar autenticidad. Herramientas como Moodle con plugins de IA permiten prompts colaborativos, donde estudiantes y profesores co-crean contenidos, fomentando habilidades metacognitivas.

En el horizonte, la IA multimodal —que combina texto, imagen y audio, como en modelos de Google DeepMind— podría revolucionar la educación al simular entornos virtuales inmersivos para simulaciones prácticas en campos como la ingeniería o la medicina. Sin embargo, esto exige inversión en infraestructura: centros de datos con capacidad de entrenamiento distribuido para modelos locales, evitando fugas de datos a la nube. Estudios prospectivos, como el Informe de Futuros de la OCDE (2023), predicen que para 2030, el 60% de las evaluaciones universitarias incorporarán IA ética, con énfasis en la alfabetización digital para discernir outputs generados.

Además, la colaboración interdisciplinaria entre expertos en IA, pedagogos y policymakers es crucial. Frameworks como el de la Association for Computing Machinery (ACM) para IA responsable guían el desarrollo de políticas institucionales, asegurando que la innovación no socave los pilares de la educación superior: rigor, integridad y equidad.

Conclusión: Hacia una Reinvensión Sostenible de la Universidad

En resumen, el uso bidireccional de la IA en la universidad representa un punto de inflexión que, si se gestiona adecuadamente, puede enriquecer la educación en lugar de erosionarla. Al equilibrar avances técnicos con salvaguardas éticas y regulatorias, las instituciones pueden transitar hacia un modelo resiliente que potencie el potencial humano. Finalmente, la visión de Ronald Purser sobre la “muerte de la universidad” sirve como catalizador para la innovación, recordándonos que la tecnología debe servir al aprendizaje, no reemplazarlo. Para más información, visita la Fuente original.